ه¯¼è®؛

ن»€ن¹ˆوک¯ç³»ç»ں

ç³»ç»ںه°±وک¯وŒ‡ن¸€ه † component,é€ڑè؟‡ن¸€ن؛›وژ¥هڈ£ن؛’相è؟وژ¥ï¼Œه’Œه‘¨ه›´çڑ„ environment وœ‰ن¸€ن¸ھè¾¹ ç•Œم€‚ç³»ç»ںçڑ„ه®ڑن¹‰ه¹¶و²،وœ‰ه¾ˆو¸…و™°ï¼Œن¸€ن¸ھç³»ç»ںهڈ¯èƒ½وک¯ن¸€ن¸ھه¤§ç³»ç»ںن¸çڑ„هگç³»ç»ںم€‚ç³»ç»ںوک¯هڈ¯ن»¥ن¸چو–ه¢هٹ çڑ„م€‚ وˆ‘ن»¬هڈ‘çژ°ن؛†ه¾ˆçں›ç›¾çڑ„هœ°و–¹ï¼Œç³»ç»ںهڈ¯ن»¥ن¸چو–ه¢هٹ ,ن½†وک¯ن؛؛çڑ„ه¤§è„‘ه¯¹ه¤چو‚و€§çڑ„çگ†è§£وک¯ه¾ˆوœ‰é™گçڑ„م€‚ه¦‚وœوˆ‘ن»¬éœ€è¦پوگه®ڑو¯ڈن¸ھ component çڑ„ه·¥ن½œوœ؛هˆ¶و‰چ能هژ»çگ†è§£ï¼Œé‚£ن¹ˆه¤§è„‘وک¯ن¸چ能çگ†è§£ çڑ„م€‚Linux kernel ه‡ هچƒن¸‡è،Œم€‚è؟™و—¶ه°±è¦پ用هˆ°ç³»ç»ںçڑ„و–¹و³•ï¼Œوڈڈè؟°و°”ن½“هˆ†هگçڑ„ه±و€§ه°±éœ€è¦پ用هˆ°ه®ڈ观ç»ںè®،é‡ڈم€‚

超ç؛§è®،ç®—وœ؛ه‡ 百ن¸‡ن¸ھ cpu,ه°±ن¼ڑوœ‰و–°çڑ„特و€§م€‚ه¹¶هڈ‘ه‡ 百ه’Œه‡ هچƒن¸‡ه¯¹ç³»ç»ںçڑ„ه†²ه‡»وک¯ه®Œه…¨ن¸چن¸€و ·çڑ„م€‚

è®،ç®—وœ؛ç³»ç»ںçڑ„هچپه››ن¸ھ特و€§

Correctness, Latency, Throughput, Scalability, Utilization, Performance Isolation, Energy Efficiency, Consistency, Fault Tolerance, Security, Privacy, Trust, Compatibility, Usability.

Correctness(و£ç،®و€§)

و€ژن¹ˆه®ڑن¹‰ن¸€ن¸ھç³»ç»ںçڑ„و£ç،®çڑ„ï¼ڑهپڑه®ƒè¯¥هپڑçڑ„ن؛‹وƒ…م€‚ ه…¶ه®هœ¨ه®é™…ن¸وک¯ه¾ˆéڑ¾ه®ڑن¹‰ه®ƒçڑ„م€‚ه¾ˆéڑ¾ه®ڑن¹‰وک¯ bug è؟کوک¯ featureم€‚Egï¼ڑهœ¨ linux ن¸ن»¥ç‚¹ه¼€ه¤´çڑ„و–‡ ن»¶وک¯éڑگè—ڈو–‡ن»¶ 需è¦پ ls -aم€‚

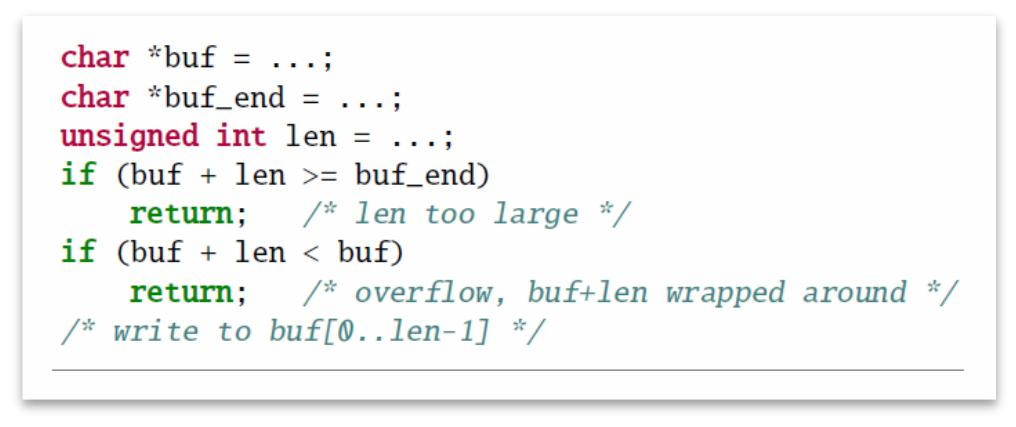

هœ¨ C çڑ„规范ن¸ï¼ŒوŒ‡é’ˆçڑ„و؛¢ه‡؛وک¯ undefined behavior,编译ه™¨ن¼ڑ认ن¸؛è؟™ن¸چن¼ڑهڈ‘ç”ںè؟™ç§چوƒ…ه†µï¼Œه› و¤وٹٹè؟™و®µن»£ç پهˆ 除وژ‰ن؛†م€‚

解ه†³و–¹و³•ï¼ڑه¼؛هˆ¶ç±»ه‹è½¬وچ¢ن¸؛ int,ه†چهپڑو“چن½œï¼Œه†چهˆ¤و–و؛¢ه‡؛,ه†چ转هŒ–ه›و¥م€‚

latency(و—¶ه»¶ï¼‰

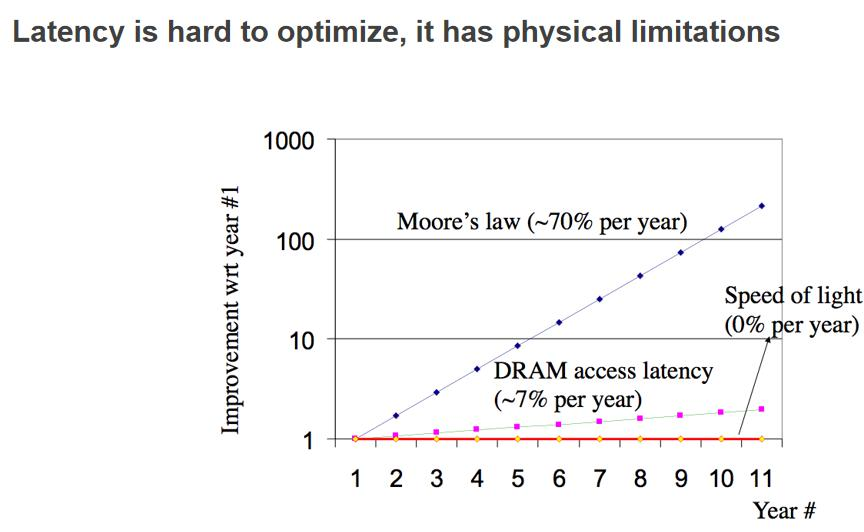

ç³»ç»ںçڑ„و—¶ه»¶وک¯ه¾ˆé؛»çƒ¦çڑ„ن؛‹وƒ…,ه› ن¸؛هگهگگé‡ڈهڈ¯ن»¥é€ڑè؟‡èٹ±é’±و·»هٹ وœچهٹ،ه™¨و¥ه¢هٹ م€‚ ن½†وک¯è¦پ缩çںو¯ڈن¸ھن؛؛è®؟é—®çڑ„و—¶ه»¶وک¯ه¾ˆéڑ¾çڑ„,ه®ƒهڈ—é™گن؛ژ物çگ†ç‰©çگ†هژںه› ,ه“ھو€•وک¯ه…‰é€ںو—¶é—´ه»¶è؟ںن¹ںن¼ڑه¾ˆه¤§م€‚

Troughput(هگهگگé‡ڈ)

ن¸€و—¦وˆ‘ن»¬çڑ„èٹ¯ç‰‡ه¯†ه؛¦ن¸چ能è¶ٹو¥è¶ٹé«ک,ه®ƒهٹ؟ه؟…ن¼ڑè¶ٹو¥è¶ٹه¤§م€‚ن¸€و—¦ç‰©çگ†è¾¾ هˆ°وپé™گن»¥هگژ,软ن»¶çڑ„ن½œç”¨ن¹ںه°±è¶ٹو¥è¶ٹه¤§م€‚

Scalability

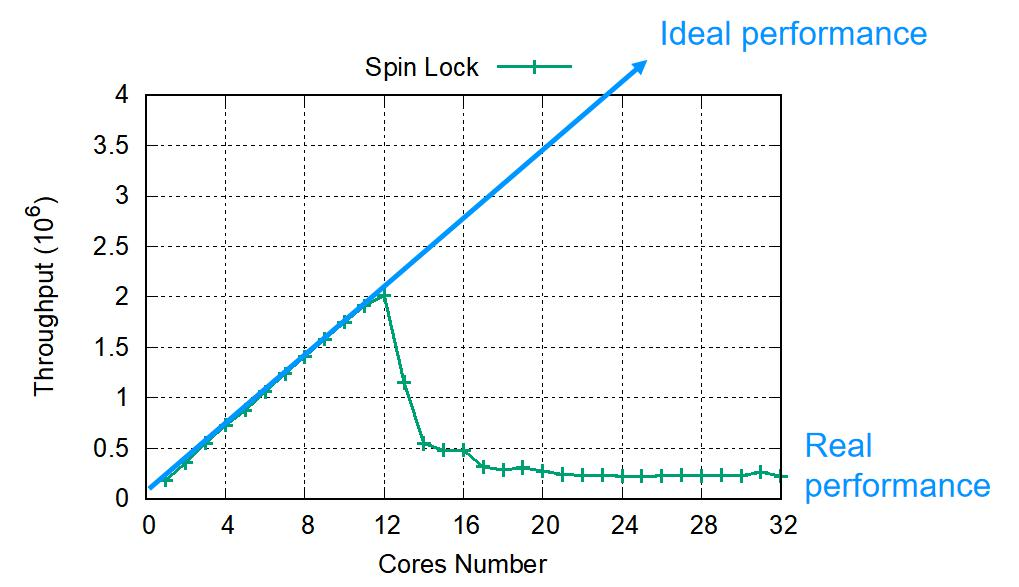

çœںه®çڑ„ arm وµ‹è¯• spin lock,هˆ° 12 ن¸ھو ¸çڑ„و—¶ه€™ï¼Œو€§èƒ½ن¸‹é™چن؛†

32 ن¸ھو ¸çڑ„و—¶ه€™ه’Œ 1 ن¸ھو ¸çڑ„و—¶ه€™ه·®ن¸چه¤ڑ,è؟™وک¯ه› ن¸؛ه¤§ه®¶éƒ½هœ¨وٹ¢ spin lockم€‚Spin lock وک¯ه†…هکن¸çڑ„ن¸€ن¸ھ bitم€‚éڑڈç€ cpu è¶ٹه¤ڑ,ن؛‰وٹ¢é”پçڑ„و¶ˆè€—è¶ٹه¤§م€‚

performance isolation

Egï¼ڑن¸€هڈ°وœ؛ه™¨è·‘ن؛† benchmark,وƒ…ه†µ 1ï¼ڑن¸€ن¸ھن؛؛è‡ھه·±è·‘,وƒ…ه†µ 2ï¼ڑ背هگژè؟کè·‘ن؛†ن¸€ن¸ھ while(1), هٹ ن¸ٹè؟™ن¸ھ noisy neighbour,ه½±ه“چوک¯ه¯¹ن؛ژ 99%çڑ„ latency ن¼ڑه¢هٹ 42%,éه¸¸éه¸¸ noisy çڑ„وƒ…ه†µï¼Œ latency ن¼ڑه¢هٹ 29 ه€چم€‚虽然 CPU هڈ¯ن»¥è؟گè،Œه¤ڑن¸ھ程ه؛ڈ,ن½†وک¯ neighbour çڑ„وƒ…ه†µه½±ه“چوک¯ه¾ˆه¤§çڑ„م€‚

Utilization(هˆ©ç”¨çژ‡ï¼‰

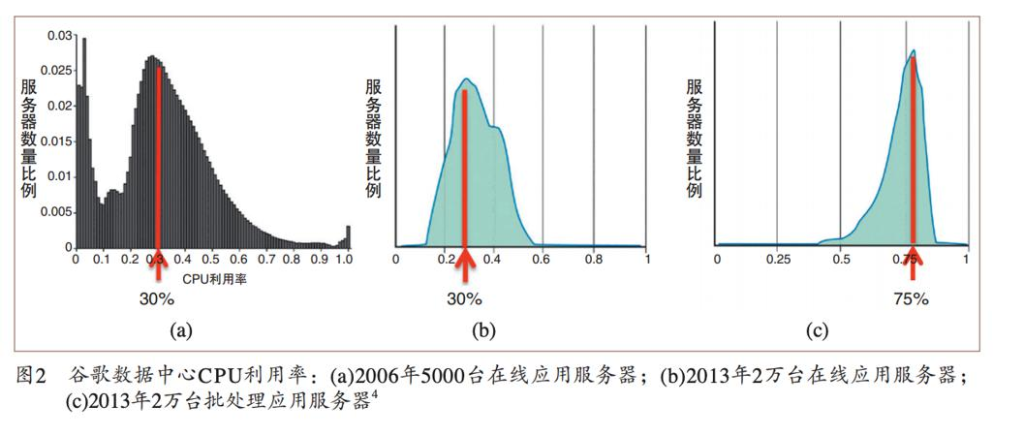

ه¯¹ن؛ژن؛‘و¥è¯´ï¼ŒGoogle و•°وچ®ن¸ه؟ƒçڑ„ CPU هˆ©ç”¨çژ‡وک¯ 30%م€‚ه¯¹ن؛ژè¦پو±‚ه؟«é€ںه“چه؛”çڑ„وœچهٹ،ه™¨ï¼Œéœ€ è¦پ预留ه¾ˆه¤ڑ资و؛گ,و‰€ن»¥ن؛‘端çڑ„وœچهٹ،ه™¨éƒ½ه¼€ç€è™½ç„¶è€—ç€ç”µï¼Œن½†وک¯هˆ©ç”¨çژ‡ه¹¶و²،وœ‰و‹‰و»،م€‚

energy efficiency(èٹ‚能)

è؟™هڈˆوک¯ن¸€ن¸ھ trade-off,و•°وچ®ن¸ه؟ƒوœ€ه¤§çڑ„ه¼€é”€وک¯ç”µè´¹ï¼ˆوœچهٹ،ه™¨ç”µè´¹م€پç©؛调电费),ه°¤ه…¶çژ°هœ¨وک¯ç¢³ن¸ه’Œï¼Œه¯¹ç”¨ç”µن؛§ç”ںن؛†ه¾ˆه¤§çڑ„وŒ‘وˆکم€‚هœ¨وœچهٹ،è´¨é‡ڈن¸چهڈکçڑ„وƒ…ه†µن¸‹ï¼Œو€ژن¹ˆهژ‹ç¼©ç”¨ç”µé‡ڈم€‚

compatibility(ه…¼ه®¹و€§ï¼‰

ه®‰è…¾ه¤„çگ†ه™¨وک¯ inter ن»ژ 32 转 64 çڑ„é‡چه¤§é€‰و‹©م€‚ه¯¼è‡´ن¹‹ه‰چو‰€وœ‰çڑ„ x86 ن»£ç پ都需è¦پé‡چو–°ç¼–译 و‰چ能跑

Usability

ه·¦è¾¹وک¯ window mobile,直هˆ° iphone 第ن¸€ن»£ه‡؛çژ°م€‚用وˆ·çڑ„وک“用و€§ن¹ںه¾ˆé‡چè¦پ

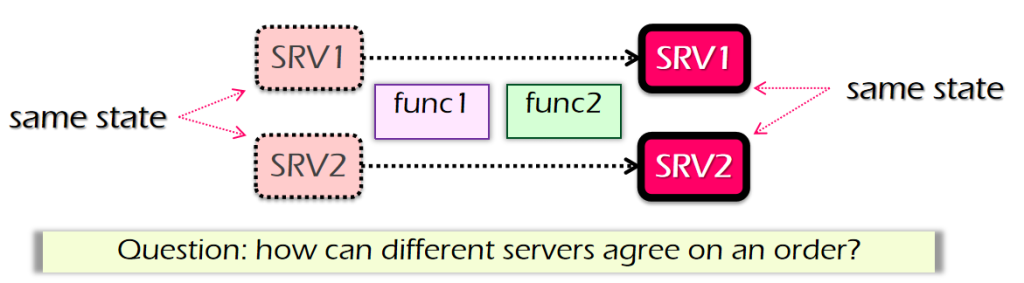

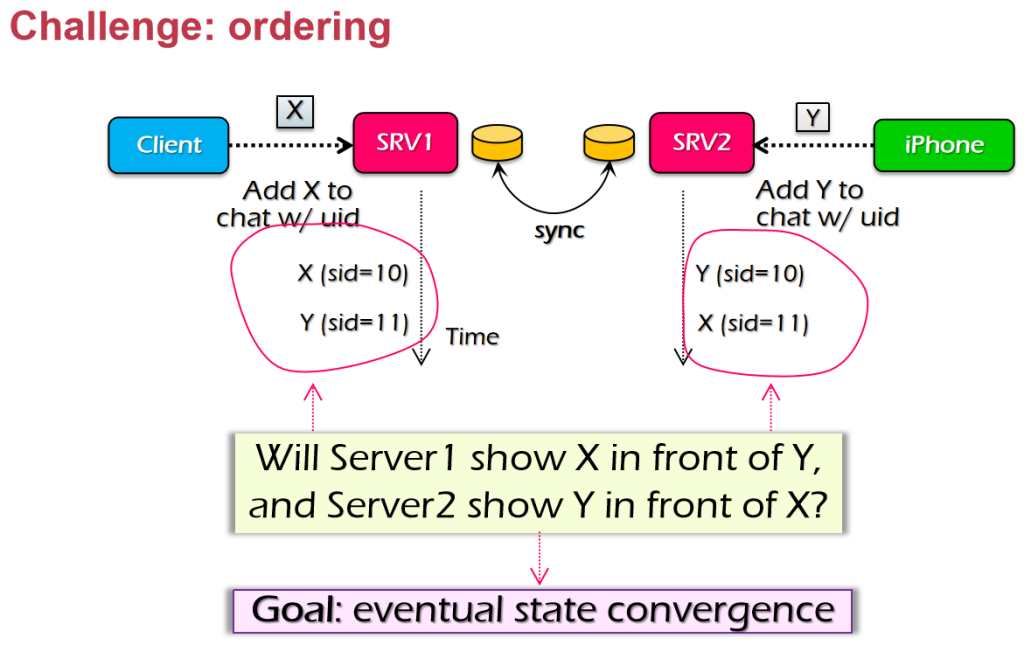

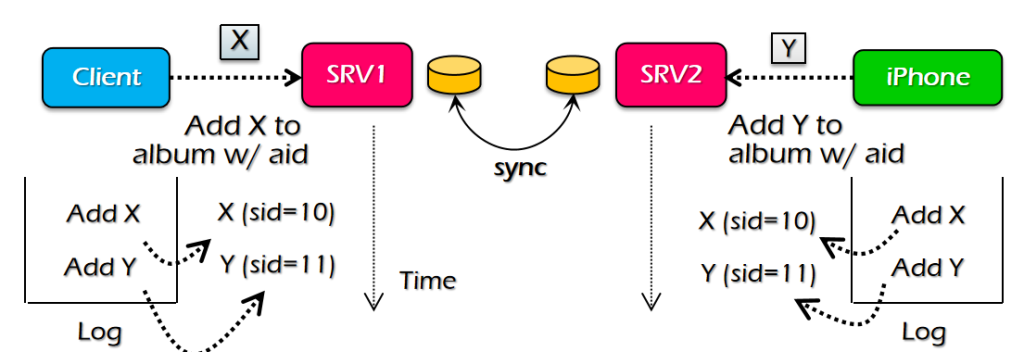

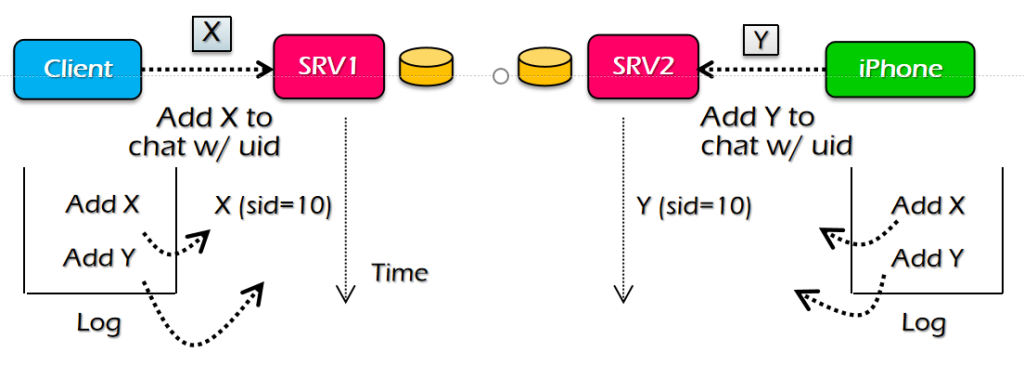

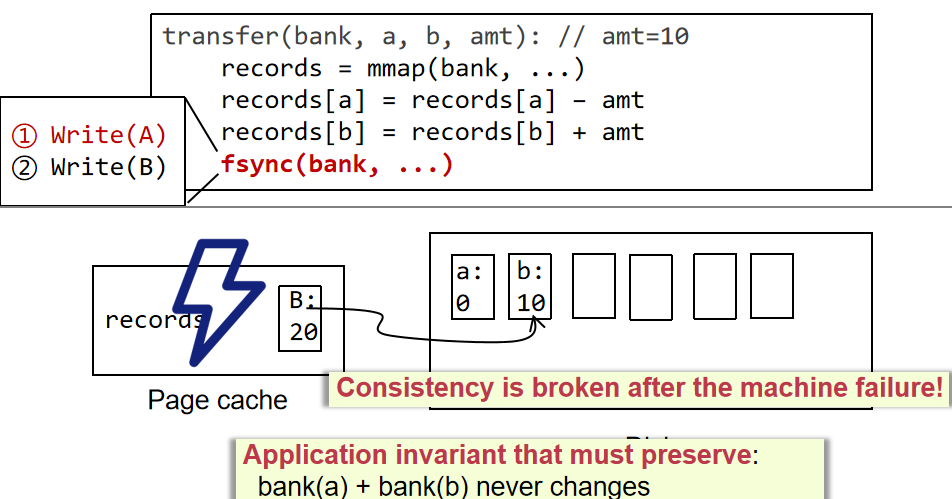

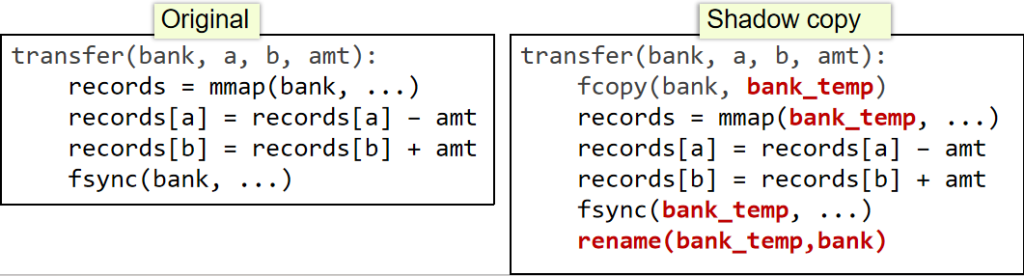

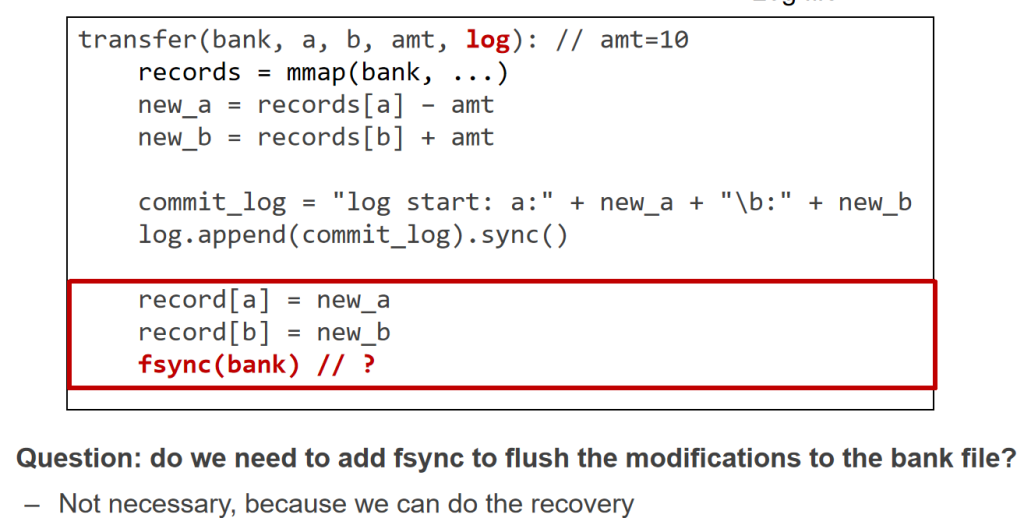

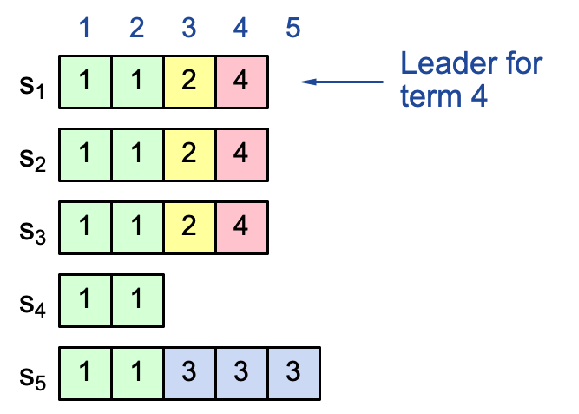

Consistency

ن¸€è‡´و€§éه¸¸é‡چè¦پم€‚ن¸؛ن؛†ه®¹é”™ï¼Œوˆ‘ن»¬éœ€è¦په¤ڑن¸ھه¤‡ن»½ï¼Œن½†وک¯ه¤‡ن»½ن¹‹é—´ه°±ن¼ڑه‡؛çژ°و•°وچ®ن¸چن¸€è‡´è؟™ن¸ھé—®é¢ک,ه¯¹ن؛ژو”¯ن»که®و¥è¯´ï¼Œن¸چ能وژ¥هڈ—و•°وچ®ن¸چن¸€è‡´çڑ„وƒ…ه†µم€‚و¯”ه¦‚用ن¸چهگŒçڑ„وœچهٹ،ه™¨ن¸€ç¬”é’±èٹ± ن؛†ن¸¤و¬،وˆ–者ن¸€ن¸ھ订هچ•و‰£ن؛†ن¸¤و¬،é’±م€‚ن¸؛ن؛†و€§èƒ½ن¸€ه®ڑن¼ڑوœ‰ه¤ڑن¸ھه‰¯وœ¬هœ¨ه¤ڑç§چ cache ن¸ï¼Œو‰€ن»¥ن¸€ه®ڑن¼ڑوœ‰è؟™ن¸ھé—®é¢ک

Fault Tolerance

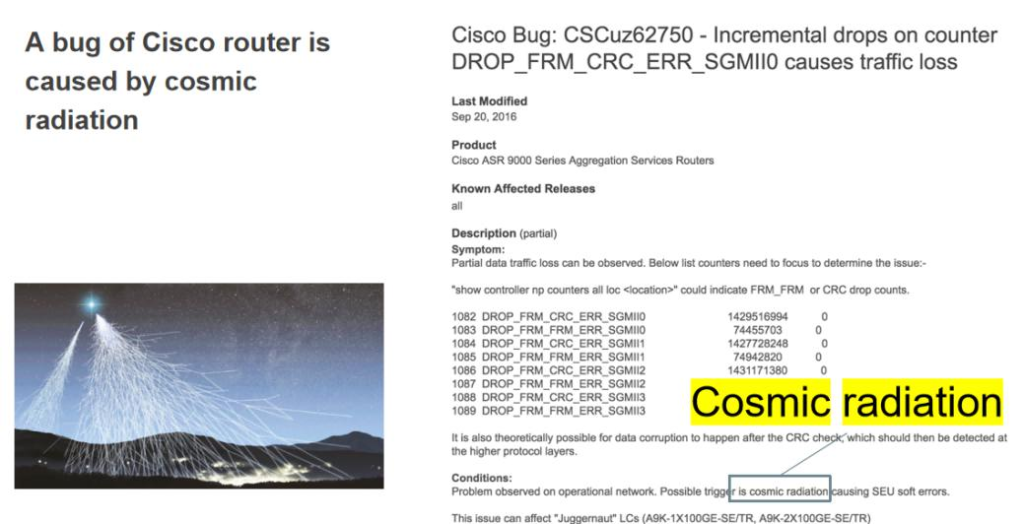

Cisco 路由ه™¨هژ‚ه•†çڑ„ bug report,由ن؛ژه®‡ه®™è¾گه°„é€ وˆگçڑ„ bugم€‚

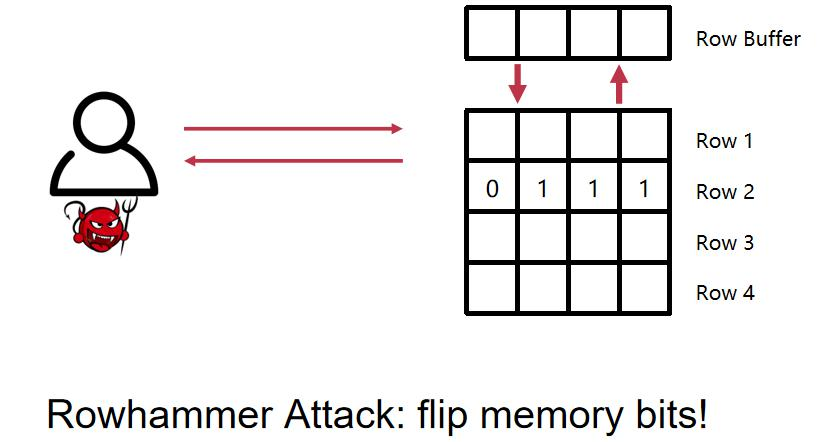

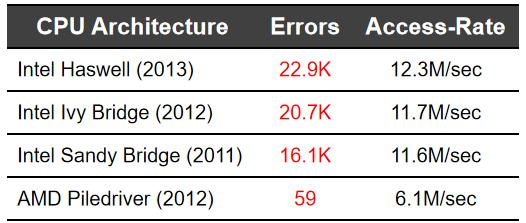

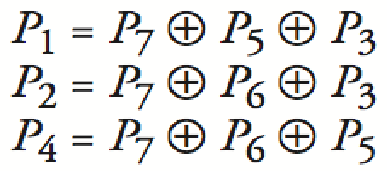

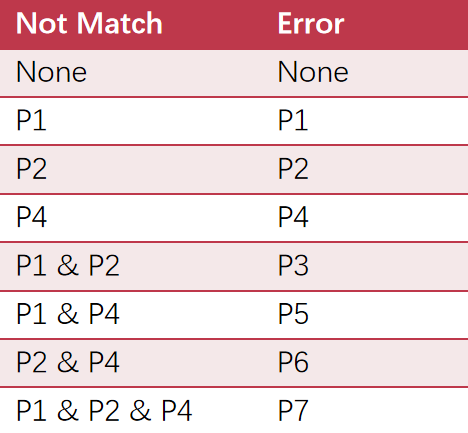

هœ¨وˆ‘ن»¬çڑ„ه†…هکن¸ï¼Œهکه‚¨و¨،ه¼ڈوک¯ه…ˆه®ڑن½چè،Œه†چه®ڑن½چهˆ—,ه†…هک需è¦پن¸؛è؟™ن¸€è،Œè؟›è،Œه……电و“چن½œï¼Œهœ¨ ه……电çڑ„و—¶ه€™ï¼Œن¸´è؟‘ن¸¤è،Œçڑ„电ه°±ن¼ڑه¼±ن¸€ç‚¹ç‚¹م€‚ه¦‚وœوˆ‘ن»¬é¢‘ç¹پهœ°è¯» row1 ه’Œ row3 ن¼ڑه¯¼è‡´ row2 çڑ„ 电é‡ڈن¸‹é™چ,ن¸‹é™چهˆ°ن¸€ه®ڑ程ه؛¦çڑ„و—¶ه€™ï¼Œrow2 çڑ„ 1 ه°±ن¼ڑهڈکوˆگ 0

هœ¨وˆ‘ن»¬çڑ„ه†…هکن¸ï¼Œهکه‚¨و¨،ه¼ڈوک¯ه…ˆه®ڑن½چè،Œه†چه®ڑن½چهˆ—,ه†…هک需è¦پن¸؛è؟™ن¸€è،Œè؟›è،Œه……电و“چن½œï¼Œهœ¨ ه……电çڑ„و—¶ه€™ï¼Œن¸´è؟‘ن¸¤è،Œçڑ„电ه°±ن¼ڑه¼±ن¸€ç‚¹ç‚¹م€‚ه¦‚وœوˆ‘ن»¬é¢‘ç¹پهœ°è¯» row1 ه’Œ row3 ن¼ڑه¯¼è‡´ row2 çڑ„ 电é‡ڈن¸‹é™چ,ن¸‹é™چهˆ°ن¸€ه®ڑ程ه؛¦çڑ„و—¶ه€™ï¼Œrow2 çڑ„ 1 ه°±ن¼ڑهڈکوˆگ 0

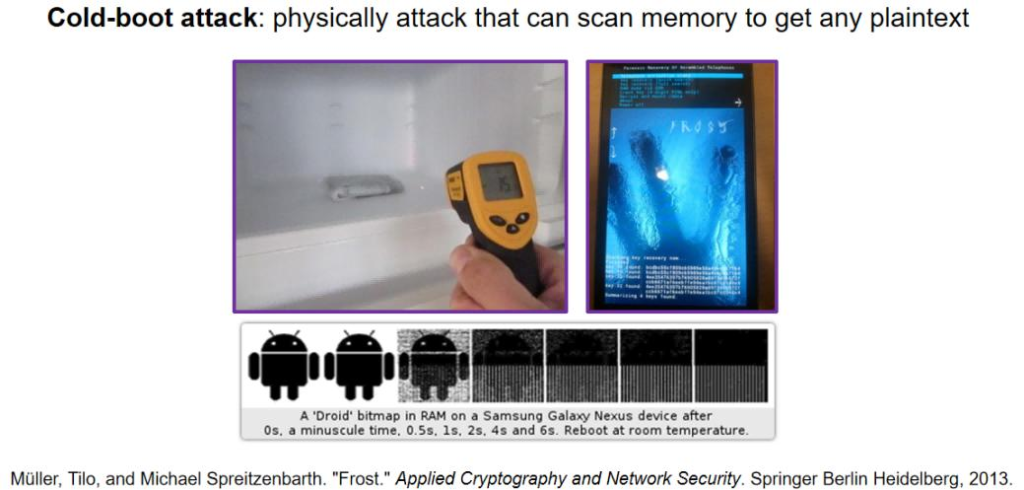

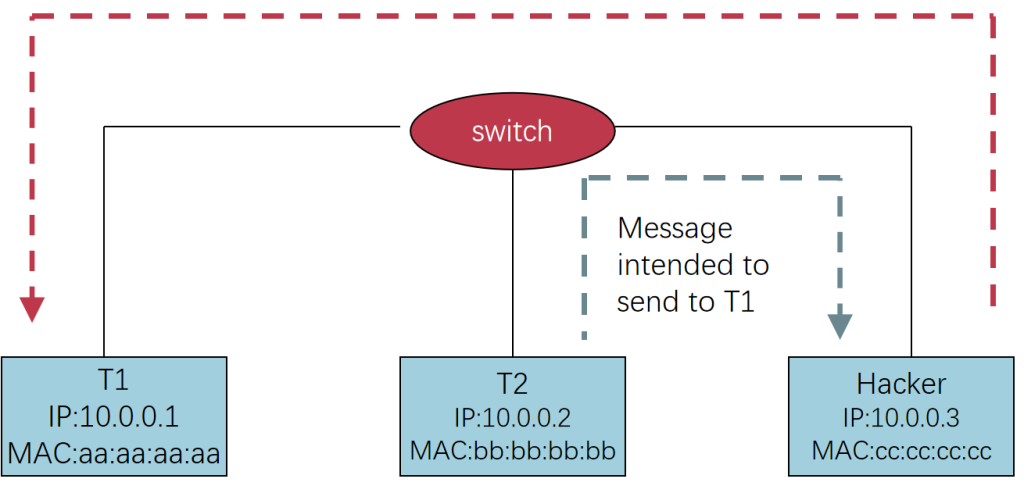

Security

ن»¥و‰‹وœ؛ن¸؛ن¾‹ï¼Œé‡Œé¢وœ‰ن¸€ه †ه…³é”®çڑ„و•°وچ®ه’Œè´¦هڈ·م€‚ه†…هکهœ¨وژ‰ç”µن¹‹هگژ,و•°وچ®ن¸چن¼ڑ马ن¸ٹن¸¢ه¤±م€‚و”¾هœ¨éه¸¸ه†·çڑ„çژ¯ه¢ƒن¸‹ï¼Œهڈ¯ن»¥ه»¶ç¼“è؟™ن¸ھè؟‡ç¨‹م€‚و‰‹وœ؛ه†…هکèٹ¯ç‰‡ه…¶ه®ه°±وک¯ن¸€ن¸ھ SSD,هڈ¯ن»¥ç›´وژ¥è¯»هڈھوک¯و•°وچ®هٹ ه¯†ن؛†م€‚و•°وچ®هٹ ه¯†çڑ„ه¯†é’¥و”¾هœ¨ DDMم€‚ه†…هک里وک¯وکژو–‡ï¼Œهٹ ه¯†هˆ°ç،¬ç›ک里وک¯ه¯†و–‡م€‚çژ°هœ¨ن؟وٹ¤و•°وچ®هں؛وœ¬ن¸ٹوک¯ن؟وٹ¤ç،¬ç›کن¸ٹçڑ„و•°وچ®ï¼Œè€Œن¸چن؟وٹ¤ه†…هکن¸ٹçڑ„و•°وچ®م€‚

Privacy

ه½“وˆ‘ن»¬ن½؟用éڑگç§پو¨،ه¼ڈوµڈ览网é،µو—¶ï¼Œçگ†è®؛ن¸ٹو¥è¯´ï¼Œو— è®؛هœ¨è®؟问网站ن¹‹ه‰چè؟کوک¯ن¹‹هگژ,用وˆ·çڑ„وœ¬هœ°è®¾ه¤‡éƒ½ن¸چن¼ڑç•™ن¸‹ن»»ن½•وکژوک¾çڑ„è®؟问痕è؟¹م€‚然而,هœ¨ه®é™…è؟گè،Œè؟‡ç¨‹ن¸ï¼Œه¦‚وœç³»ç»ں物çگ†ه†…هکن¸چ足,و“چن½œç³»ç»ںهڈ¯èƒ½ن¼ڑé€ڑè؟‡ه†…هک转ه‚¨ï¼ˆOS dump)وˆ–ه°†éƒ¨هˆ†ه†…هکو•°وچ®ن؛¤وچ¢ï¼ˆswap)هˆ°ç،¬ç›کçڑ„و–¹ه¼ڈé‡ٹو”¾ه†…هکç©؛é—´م€‚è؟™ن؛›و“چن½œن¸چن¼ڑهŒ؛هˆ†و•°وچ®çڑ„ç±»ه‹ï¼Œه› و¤éڑگç§پو¨،ه¼ڈن¸çڑ„و•°وچ®ن¹ںوœ‰هڈ¯èƒ½è¢«ه†™ه…¥هˆ°ç،¬ç›کن¸ï¼Œç•™ن¸‹ن¸چهڈ¯éپ؟ه…چçڑ„ç—•è؟¹م€‚

Trust

هœ¨ن¼ ç»ںçڑ„银è،Œç³»ç»ںن¸ï¼Œç”¨وˆ·çڑ„é’±ه¹¶ن¸چوک¯ن»¥ه®ç‰©çژ°é‡‘çڑ„ه½¢ه¼ڈهکو”¾هœ¨é“¶è،Œé‡Œم€‚ه®é™…ن¸ٹ,è؟™ن؛›é’±هڈھوک¯ن»¥و•°ه—çڑ„ه½¢ه¼ڈè®°ه½•هœ¨é“¶è،Œçڑ„وœچهٹ،ه™¨ن¸ï¼Œé“¶è،Œن¾èµ–è‡ھè؛«çڑ„ن؟،ن»»ن½“ç³»ه’Œç®،çگ†ç³»ç»ںو¥ç،®ن؟资金çڑ„وµپé€ڑه’Œن½؟用م€‚è؟™ç§چو¨،ه¼ڈن¾èµ–ن؛ژه¯¹é“¶è،Œوœ؛و„çڑ„ن؟،ن»»ï¼ڑوˆ‘ن»¬ç›¸ن؟،银è،Œن¼ڑه¦¥ه–„ç®،çگ†ه’Œه…‘çژ°وˆ‘ن»¬çڑ„资金م€‚

而هژ»ن¸ه؟ƒهŒ–çڑ„è´§ه¸پ(ه¦‚و¯”特ه¸پç‰ï¼‰è؟›ن¸€و¥ه‡ڈه°‘ن؛†ه¯¹ن؟،ن»»çڑ„ن¾èµ–م€‚ه®ƒن¸چ需è¦پن¾é وںگن¸ھ特ه®ڑçڑ„وœ؛و„م€په›½ه®¶وˆ–وƒهٹ›وœ؛و„(ه¦‚ه†›éکں)و¥ن؟éڑœè´§ه¸پçڑ„ن»·ه€¼ه’Œè؟گè،Œم€‚相هڈچ,ه®ƒé€ڑè؟‡هˆ†ه¸ƒه¼ڈè´¦وœ¬وٹ€وœ¯ï¼ˆه¦‚هŒ؛ه—链)هœ¨ه…¨çگƒèŒƒه›´ه†…ç”±ه¤ڑن¸ھèٹ‚点ه…±هگŒç»´وٹ¤و•°وچ®çڑ„çœںه®و€§ه’Œن¸€è‡´و€§م€‚è؟™و ·ï¼Œن؟،ن»»ن¸چه†چ集ن¸ن؛ژوںگن¸€ن¸ھوœ؛و„,而وک¯هˆ†و•£هœ¨و•´ن¸ھ网络ن¸ï¼Œن»ژ而é™چن½ژن؛†ه¯¹هچ•ç‚¹ه¤±è´¥وˆ–ن¸ه؟ƒهŒ–وژ§هˆ¶çڑ„ن¾èµ–م€‚

ن¼ ç»ںه·¥ç¨‹ن¸ژè®،ç®—وœ؛ç³»ç»ں设è®،ن¹‹é—´هکهœ¨ه¾ˆه¤§çڑ„ن¸چهگŒï¼Œه°¤ه…¶وک¯هœ¨ه¤چو‚و€§وژ§هˆ¶و–¹é¢م€‚ن¼ ç»ںه·¥ç¨‹ï¼ˆه¦‚ه»؛ç‘ه·¥ç¨‹ï¼‰ه·²ç»ڈ积累ن؛†ه¤§é‡ڈوˆگç†ںçڑ„çگ†è®؛ه’Œç»ڈéھŒï¼Œو¯”ه¦‚ constructive theory,ن¸؛设è®،ه’Œه»؛é€ وڈگن¾›ن؛†وکژç،®çڑ„وŒ‡ه¯¼م€‚然而,هœ¨è®،ç®—وœ؛ç³»ç»ںن¸ï¼Œه¤چو‚و€§çڑ„وژ§هˆ¶è؟کç¼؛ن¹ڈ足ه¤ںçڑ„ç»ڈéھŒç§¯ç´¯م€‚ه› و¤ï¼Œه½“وˆ‘ن»¬é¢ه¯¹ه¤چو‚ç³»ç»ںو—¶ï¼Œه¾€ه¾€éœ€è¦پن»ژه®é™…و،ˆن¾‹ç ”究(case study)ن¸وڈگهڈ–ن¸€ن؛›وک¾è‘—çڑ„特ه¾پ,هˆ†وگçژ°وœ‰ç³»ç»ںوک¯ه¦‚ن½•ه؛”ه¯¹ه¤چو‚و€§çڑ„م€‚

وژ§هˆ¶ه¤چو‚و€§çڑ„é‡چè¦پو–¹و³•

ه¤چو‚و€§وژ§هˆ¶çڑ„ه…³é”®هœ¨ن؛ژوکژç،®ç³»ç»ںçڑ„边界,ه¹¶é€‰و‹©é€‚ه½“çڑ„ç»´ه؛¦è؟›è،Œن¼کهŒ–م€‚ن¾‹ه¦‚,ه¦‚وœوˆ‘ن»¬è؟‡ن؛ژ精细هœ°ç ”究و¯ڈن¸ھ细èٹ‚(و¯”ه¦‚و¨،و‹ںو¯ڈن¸ھو°”ن½“هˆ†هگçڑ„و–¹هگ‘ه’Œهٹ¨é‡ڈ),系ç»ںه°†هڈکه¾—ن¸چهڈ¯وژ§م€‚هگŒو ·هœ°ï¼Œهœ¨è½¯ن»¶ه¼€هڈ‘ن¸ï¼Œه¦‚وœو·±ه…¥هˆ°ن»£ç پم€پCPUم€پوµپو°´ç؛؟م€پç”ڑ至电路و؟ه¸ƒه±€çڑ„و¯ڈن¸ھه±‚é¢ï¼Œن¹ںن¼ڑ让وˆ‘ن»¬و— و³•ن¸“و³¨ن؛ژو ¸ه؟ƒé—®é¢کم€‚ه› و¤ï¼Œه؟…é،»هœ¨ه¤§ه¤ڑو•°وƒ…ه†µن¸‹ç›¸ن؟،وںگن؛›ه·¥ه…·ه’Œوٹ½è±،(ن¾‹ه¦‚编译ه™¨ï¼‰ï¼Œو¥é™گهˆ¶è°ƒè¯•ه’Œè®¾è®،çڑ„边界م€‚

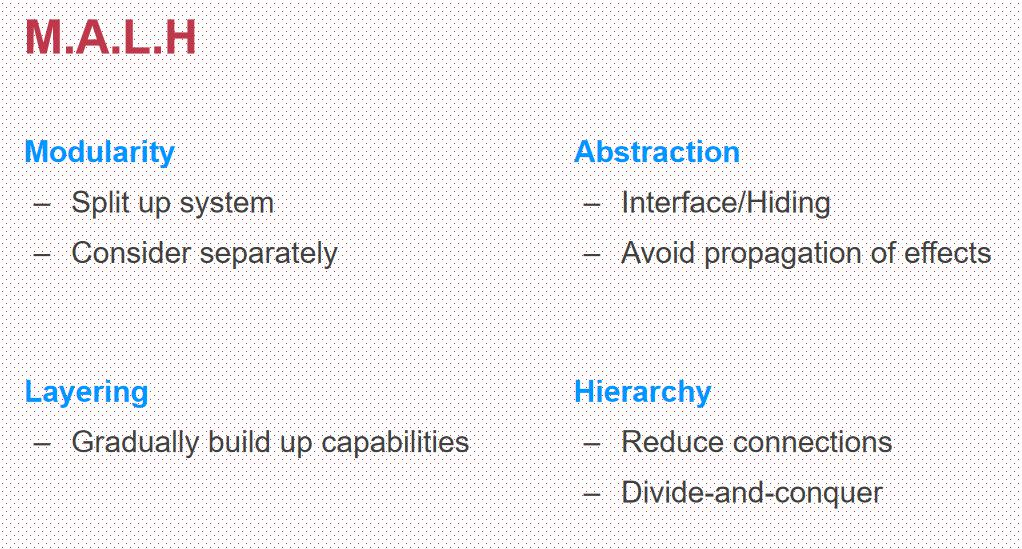

هœ¨ه¤چو‚و€§وژ§هˆ¶ن¸ï¼Œن¸»è¦پن¾èµ–ن»¥ن¸‹ه››ن¸ھو–¹و³•ï¼ˆM.A.L.H)ï¼ڑ

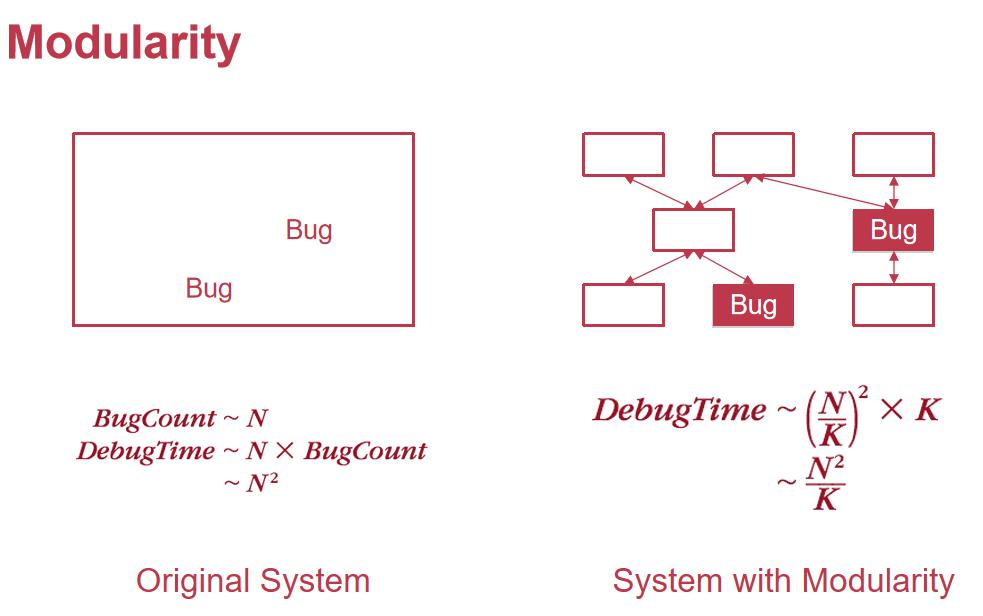

Modularity(و¨،ه—هŒ–)

هœ¨ linux ه†…و ¸ن¸ï¼Œé€ڑè؟‡ن¼°ç®—ه¤§ç؛¦و¯ڈن¸€هچƒè،Œوœ‰ن¸€ن¸ھ bugم€‚ه¯¹ن؛ژوˆ‘ن»¬è‡ھه·±çڑ„ن»£ç پ,预ن¼°çڑ„وک¯ن¸€ ن¸ھو²،وœ‰هڈ‘çژ°çڑ„ن¸œè¥؟,و¯”较éڑ¾ن»¥ن¼°ç®—م€‚ Debug çڑ„و—¶é—´ç‰ن؛ژن»£ç پçڑ„è،Œو•°*bug و•°é‡ڈ,و‰€ن»¥ه°±وک¯ O(ن»£ç پè،Œو•°ï¼‰ ,و‹†هˆ†وˆگ K ن¸ھه°ڈو¨،ه—ن¹‹هگژ,و€»çڑ„و—¶é—´ه¤چو‚ه؛¦ه°±هڈ¯ن»¥é™¤ن»¥ Kم€‚

و¨،ه—هŒ–é€ڑè؟‡ه°†ه¤چو‚ç³»ç»ںو‹†هˆ†ن¸؛ه¤ڑن¸ھهگو¨،ه—و¥ه®çژ°â€œهˆ†è€Œو²»ن¹‹â€م€‚ه¯¹ن؛ژو¨،ه—هŒ–çڑ„设è®،,è¦پو³¨é‡چن»¥ن¸‹ه‡ 点ï¼ڑ

- é«که†…èپڑم€پن½ژ耦هگˆï¼ڑو¨،ه—ه†…部هٹں能相ه…³و€§ه¼؛,و¨،ه—ن¹‹é—´ه°½هڈ¯èƒ½ه‡ڈه°‘相ن؛’ن¾èµ–م€‚

- 良ه¥½çڑ„وٹ½è±،ه’Œوژ¥هڈ£ï¼ڑو¨،ه—çڑ„وژ¥هڈ£ه؛”该و¸…و™°وکژç،®ï¼Œو–¹ن¾؟ه…¶ن»–و¨،ه—调用م€‚

Abstraction(وٹ½è±،)

وٹ½è±،وک¯و¨،ه—هŒ–çڑ„é‡چè¦پهں؛ç،€ï¼Œè®¾è®،وٹ½è±،و—¶éœ€è¦پéپµه¾ھن»¥ن¸‹هژںهˆ™ï¼ڑ

- éپµه¾ھè‡ھ然çڑ„边界ï¼ڑن¾‹ه¦‚,ه½“وٹ½è±،用وˆ·و—¶ï¼Œè‡ھ然è،Œن¸؛هŒ…و‹¬â€œè´ç‰©â€â€œوµڈ览网é،µâ€ç‰م€‚

- ه‡ڈه°‘ن؛¤ن؛’ï¼ڑو¨،ه—ن¹‹é—´çڑ„ن؛¤ن؛’è¶ٹه°‘,ه¤چو‚و€§è¶ٹن½ژم€‚

- ه°†é”™è¯¯وژ§هˆ¶هœ¨و¨،ه—ه†…ï¼ڑوٹ½è±،ه؛”该ه°½é‡ڈéک²و¢é”™è¯¯ن¼ و’هˆ°ç³»ç»ںçڑ„ه…¶ن»–部هˆ†م€‚ 需è¦پو³¨و„ڈçڑ„وک¯ï¼Œè™½ç„¶ه¢هٹ و¨،ه—و•°é‡ڈ(k)هڈ¯ن»¥é™چن½ژه¤چو‚ه؛¦ï¼Œن½†è؟‡ه¤ڑçڑ„و¨،ه—هڈ¯èƒ½ه¯¼è‡´é¢‘ç¹پçڑ„ن؛¤ن؛’,هڈچ而ه¢هٹ ç³»ç»ںه¤چو‚و€§م€‚

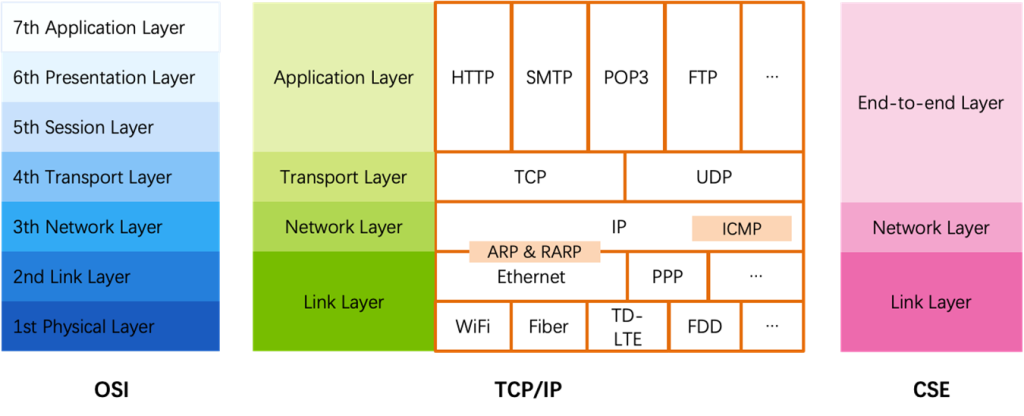

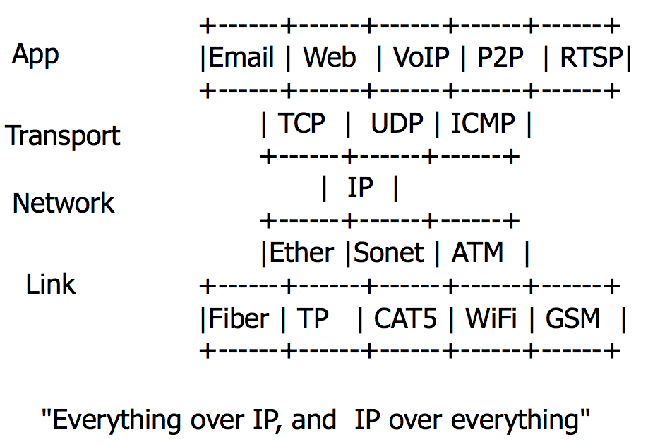

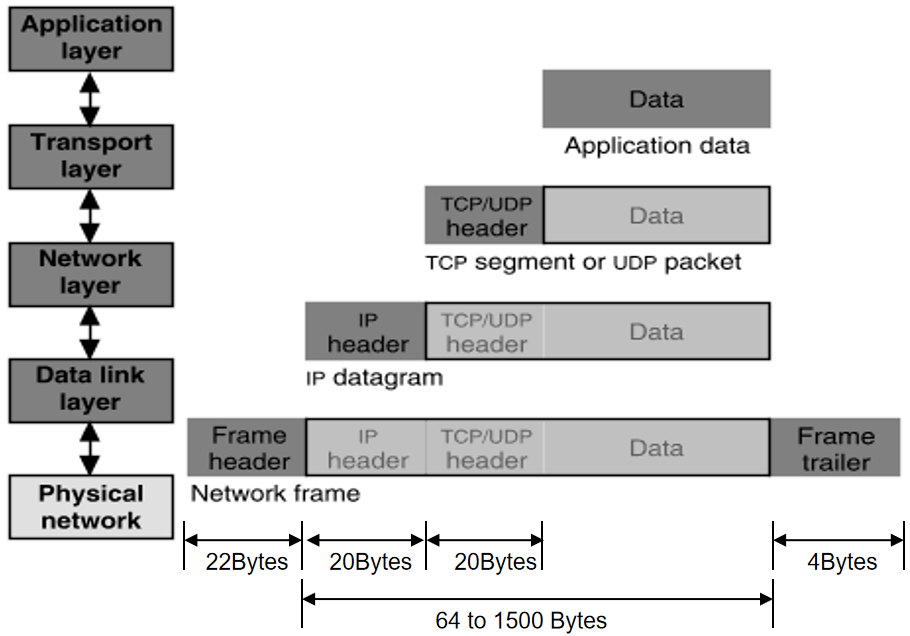

Layering(هˆ†ه±‚)

ç³»ç»ںçڑ„هˆ†ه±‚设è®،能ه¤ںوژ§هˆ¶و¨،ه—ن¹‹é—´çڑ„ن؛¤ن؛’范ه›´م€‚ن¾‹ه¦‚,هœ¨ç½‘络ن¸ï¼Œé‡‡ç”¨هˆ†ه±‚هچڈ议(ه¦‚ 7 ه±‚وˆ– 4 ه±‚هچڈ议)ن½؟ه¾—و¯ڈن¸€ه±‚هڈھ需ه¤„çگ†ç›¸é‚»ه±‚çڑ„é—®é¢ک,ه‡ڈه°‘ن؛†è°ƒè¯•ه’Œè®¾è®،و—¶çڑ„ه¤چو‚ه؛¦

Hierarchy(ه±‚ç؛§هŒ–)

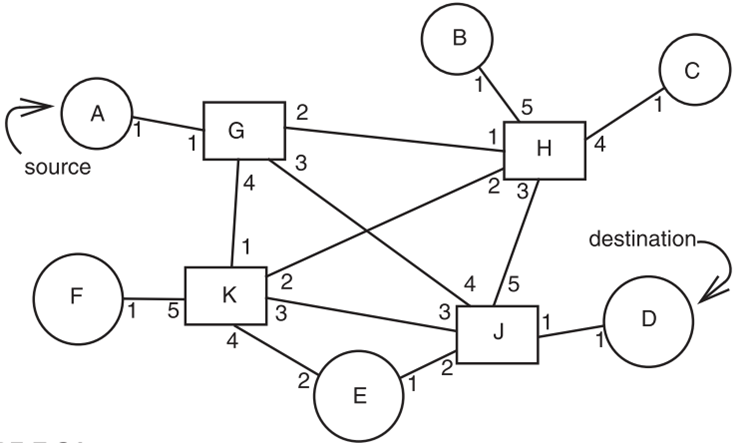

ه½“ç³»ç»ںç”±ه¤ڑن¸ھو¨،ه—组وˆگو—¶ï¼Œهڈ¯ن»¥é€ڑè؟‡ه±‚ç؛§ç»“و„ه¯¹ه¤–ç»ںن¸€ه‘ˆçژ°ن¸€ن¸ھو¨،ه—çڑ„ه½¢ه¼ڈم€‚و¯”ه¦‚,è®؟é—®ن؛ڑ马é€ٹçڑ„وœچهٹ،ه™¨و—¶ï¼Œن¸é—´هڈ¯èƒ½éœ€è¦پç»ڈè؟‡ه¤ڑن¸ھ路由ه™¨ï¼Œن½†وˆ‘ن»¬هڈھ需记ه½•هˆ°ç¾ژه›½çڑ„路由ن؟،وپ¯ï¼Œè€Œن¸چ需è¦پè®°ه½•و¯ڈهڈ°وœچهٹ،ه™¨çڑ„ IP هœ°ه€م€‚

软ن»¶çڑ„ه¤چو‚و€§

ن¸ژن¼ ç»ںه·¥ç¨‹ن¸چهگŒï¼Œè½¯ن»¶ç³»ç»ںو²،وœ‰ç‰©çگ†ه®ڑه¾‹é™گهˆ¶ه…¶ه¤چو‚و€§م€‚هœ¨و•°ه—ن¸–ç•Œن¸ï¼Œهڈھè¦پوƒ³è±،هٹ›è¶³ه¤ں,çگ†è®؛ن¸ٹه°±هڈ¯ن»¥هˆ›é€ ه‡؛وپه…¶ه¤چو‚çڑ„ç³»ç»ںم€‚ه› و¤ï¼Œè½¯ن»¶è®¾è®،çڑ„وپé™گه¾€ه¾€وک¯ن؛؛è„‘çگ†è§£çڑ„وپé™گم€‚而ن¸چهگŒه¼€هڈ‘者çڑ„çگ†è§£èƒ½هٹ›هڈ‚ه·®ن¸چé½گ,ه¯¼è‡´ç”ںن؛§هٹ›ه·®è·ه·¨ه¤§م€‚ن¸€ن؛›ن¼ک秀程ه؛ڈه‘کçڑ„ç”ںن؛§هٹ›ç”ڑ至è؟œè؟œè¶…è؟‡و–°و‰‹ï¼Œè؟™وک¯ه› ن¸؛ن»–ن»¬و›´ه–„ن؛ژوژ§هˆ¶ه¤چو‚و€§م€‚

错误ن¸ژ调试

ه½“ç³»ç»ںهڈکه¾—ه¤چو‚و—¶ï¼Œé”™è¯¯ن¸چهڈ¯éپ؟ه…چم€‚é€ڑè؟‡و¨،ه—هŒ–设è®،,هڈ¯ن»¥هœ¨و¨،ه—ه†…وچ•èژ·ه’Œéڑ”离错误م€‚调试و—¶وœ‰ن»¥ن¸‹ه…³é”®ç‚¹ï¼ڑ

- و£€وں¥è؟”ه›ه€¼ï¼ڑ调用ه‡½و•°و—¶éœ€è¦پوکژç،®éھŒè¯په…¶è؟”ه›ه€¼وک¯هگ¦و£ç،®ï¼Œéک²و¢é”™è¯¯و‰©و•£م€‚

- ه¯¹è¾“ه…¥çڑ„ن¸¥و ¼و ،éھŒï¼ڑç³»ç»ں(ه¦‚و“چن½œç³»ç»ں)هœ¨وژ¥و”¶ç”¨وˆ·è¾“ه…¥و—¶ï¼Œè¦پهپ‡è®¾ه؛”用هڈ¯èƒ½وک¯وپ¶و„ڈçڑ„م€‚و¯”ه¦‚ï¼ڑ

- ه½“用وˆ·è¯·و±‚ه°†ن¸€و®µو•°وچ®ن»ژوںگن¸ھه†…هکهœ°ه€ه¤چهˆ¶هˆ°هڈ¦ن¸€ن¸ھهœ°ه€و—¶ï¼Œو“چن½œç³»ç»ںه؟…é،»و£€وں¥هœ°ه€وک¯هگ¦هگˆو³•ï¼Œهگ¦هˆ™هڈ¯èƒ½و³„露و•ڈو„ںن؟،وپ¯م€‚

- 用وˆ·è¯·و±‚و“چن½œç³»ç»ںو‰“هچ°و•°وچ®و—¶ï¼Œç³»ç»ں需è¦پç،®è®¤و•°وچ®وک¯هگ¦وŒ‡هگ‘ه†…و ¸هŒ؛هںں,هگ¦هˆ™هڈ¯èƒ½ه°†ه†…و ¸ن؟،وپ¯وڑ´éœ²ç»™ç”¨وˆ·م€‚

و¨،ه—هŒ–ه’Œهˆ†ه±‚هœ¨è؟™é‡Œèµ·هˆ°ن؛†ه…³é”®ن½œç”¨ï¼Œه‡ڈه°‘ن؛†و¨،ه—é—´çڑ„错误ن¼ و’范ه›´م€‚

ç³»ç»ں设è®،çڑ„éڑ¾ç‚¹

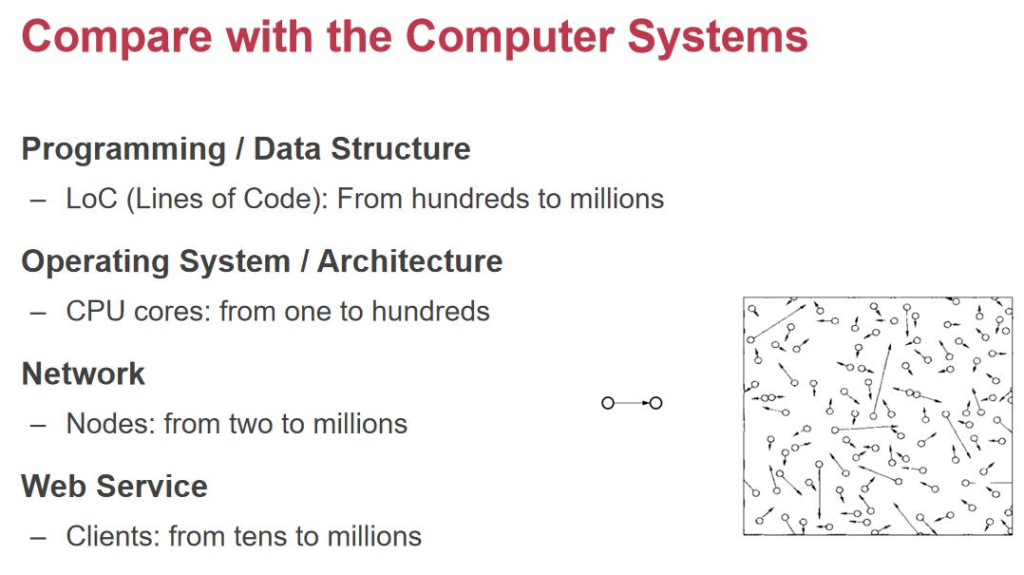

ه°½ç®، M.A.L.H ه››ن¸ھو–¹و³•هڈ¯ن»¥وœ‰و•ˆé™چن½ژه¤چو‚و€§ï¼Œن½†و‰¾هˆ°â€œو£ç،®çڑ„و¨،ه—هŒ–/وٹ½è±،/هˆ†ه±‚/ه±‚ç؛§و–¹و³•â€ن»چ然ه……و»،وŒ‘وˆکم€‚هœ¨è®¸ه¤ڑوƒ…ه†µن¸‹ï¼Œه؟…é،»é’ˆه¯¹ه…·ن½“çڑ„هœ؛و™¯è؟›è،Œé€گو،ˆهˆ†وگ(case-by-case)م€‚ن»¥ç½‘络系ç»ںن¸؛ن¾‹ï¼Œن»ژو—©وœںçڑ„ن¸€هڈ°è®¾ه¤‡م€پو•°ç™¾è،Œن»£ç پهڈ‘ه±•هˆ°ه¦‚ن»ٹه‡ 百ن¸‡هڈ°è®¾ه¤‡م€پو•°هچƒن¸‡è،Œن»£ç پم€پوˆگهچƒن¸ٹن¸‡ç”¨وˆ·و—¶ï¼Œç³»ç»ںçڑ„ه¤چو‚و€§ه‘ˆوŒ‡و•°ç؛§ه¢é•؟م€‚

ه› و¤ï¼Œه¤چو‚ç³»ç»ںçڑ„设è®،ن¾èµ–ن؛ژç»ڈéھŒم€پ良ه¥½çڑ„و¶و„و–¹و³•è®؛ن»¥هڈٹو¸…و™°çڑ„调试边界م€‚课程و‰€و•™وژˆçڑ„ه†…ه®¹و£وک¯هں؛ن؛ژè؟™ن؛›هژںهˆ™ï¼Œه¸®هٹ©وˆ‘ن»¬ن»ژه®è·µن¸é€گو¥ç§¯ç´¯ه؛”ه¯¹ه¤چو‚و€§çڑ„ç»ڈéھŒم€‚

و،ˆن¾‹ï¼ڑو·که®ن¼کهŒ–و¶و„çڑ„ه؟ƒè·¯هژ†ç¨‹

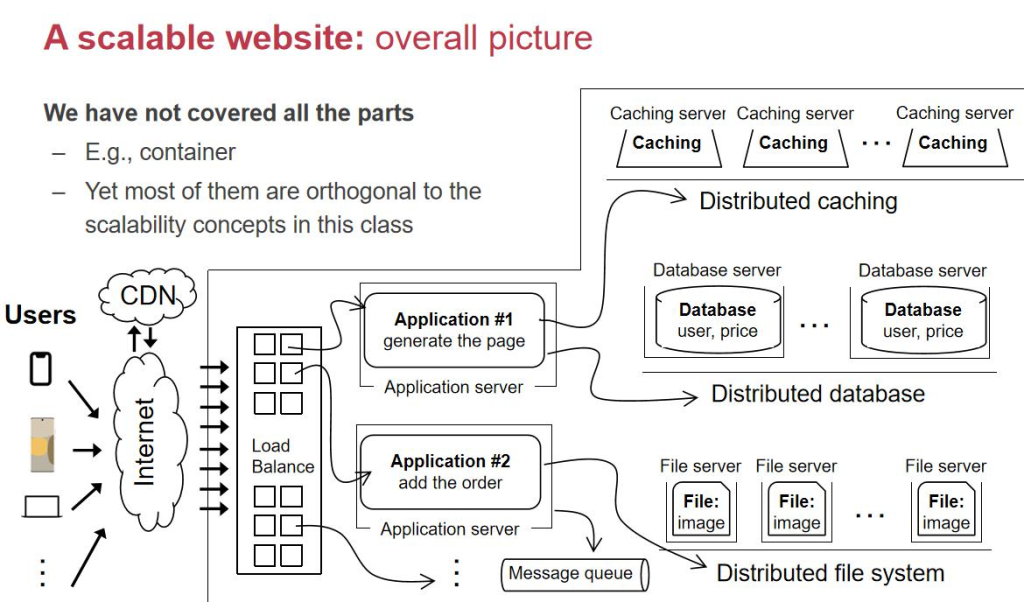

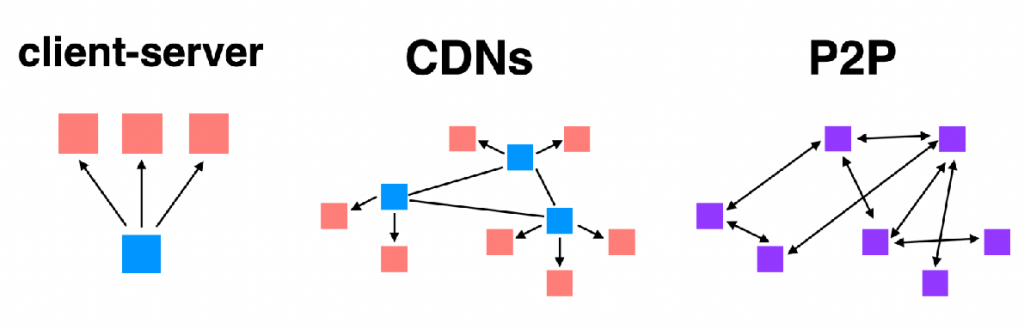

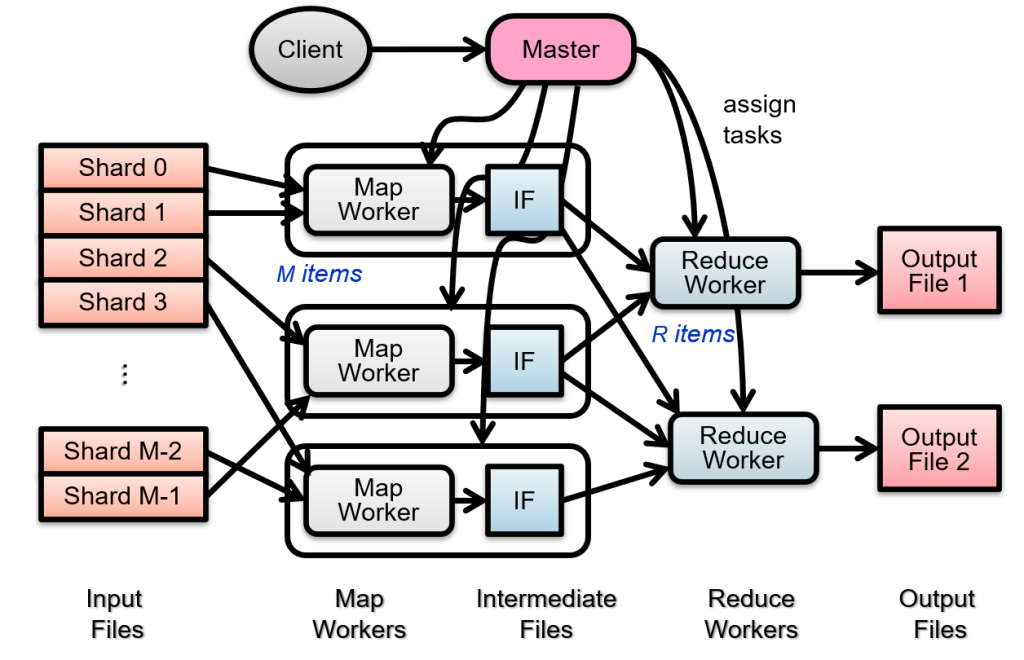

و„ه»؛هƒڈو·که®م€پو”¯ن»که®è؟™و ·é«که؛¦هڈ¯و‰©ه±•çڑ„网站,需è¦پ解ه†³ç³»ç»ںو€§èƒ½ه’Œç¨³ه®ڑو€§é—®é¢ک,ه°¤ه…¶هœ¨ه¤„çگ†é«که¹¶هڈ‘و—¶م€‚ن»¥و·که®هڈŒهچپن¸€ن¸؛ن¾‹ï¼Œن¸€ه¤©éœ€ه¤„çگ† 22.5 ن؛؟订هچ•ï¼Œè؟™ه¯¹ç³»ç»ںوڈگه‡؛ن؛†وپé«کè¦پو±‚م€‚

هƒڈه•†ه“پن»‹ç»چه›¾è؟™ç§چو•°وچ®ï¼Œن¸€èˆ¬وک¯ن»¥PNG/JPGç‰و ¼ه¼ڈن؟هکهœ¨و–‡ن»¶ç³»ç»ںوˆ–者و–‡ن»¶وœچهٹ،ه™¨é‡Œم€‚ن¸؛ن»€ن¹ˆن¸چ用و•°وچ®ه؛“ï¼ںه› ن¸؛ه›¾ç‰‡وک¯é结و„هŒ–و•°وچ®ï¼Œو–‡ن»¶وœچهٹ،ه™¨ه¯¹è؟™ç§چه¤§و–‡ن»¶çڑ„هکه‚¨ه’Œè¯»هڈ–و•ˆçژ‡و›´é«ک,و›´é€‚هگˆè؟™ç§چ用途م€‚ه›¾ç‰‡çڑ„و•°وچ®é‡ڈé€ڑه¸¸و¯”较ه¤§ï¼Œن½†ه®ƒوک¯ه›؛ه®ڑçڑ„,هڈھ需è¦پهœ¨ç”¨وˆ·و‰“ه¼€é،µé¢و—¶وڈگن¾›ç»™ن»–ن»¬ï¼Œن¸چ需è¦پ频ç¹پن؟®و”¹وˆ–者ه®و—¶و›´و–°ï¼Œو‰€ن»¥و–‡ن»¶وœچهٹ،ه™¨و›´هگˆé€‚م€‚

ه†چ说ن»·و ¼ï¼Œè؟™ن¸ھو•°وچ®ه°±ه¾ˆé‡چè¦پن؛†م€‚ه®ƒçڑ„هڈکهŒ–频çژ‡è™½ç„¶ن½ژ,ن½†ن¸چ能ه‡؛é”™ï¼پن»·و ¼وک¯ç”¨وˆ·ن¸‹هچ•و—¶çڑ„و ¸ه؟ƒن¾وچ®ï¼Œه¦‚وœه‡؛é—®é¢ک,هڈ¯èƒ½ن¼ڑç›´وژ¥ه¯¼è‡´ç»ڈوµژوچںه¤±وˆ–者ه®¢وˆ·وٹ•è¯‰م€‚و‰€ن»¥ï¼Œن»·و ¼éœ€è¦پهکه‚¨هœ¨و•°وچ®ه؛“ن¸ï¼Œه› ن¸؛و•°وچ®ه؛“ن¸چن»…能ه¾ˆه¥½هœ°هکه‚¨ç»“و„هŒ–و•°وچ®ï¼Œè؟ک能وڈگن¾›هڈ¯é çڑ„وŒپن¹…هŒ–وœ؛هˆ¶ï¼Œç،®ن؟ن»·و ¼çڑ„ه‡†ç،®و€§ه’Œن¸€è‡´و€§م€‚و— è®؛用وˆ·ن»€ن¹ˆو—¶ه€™è®؟问,看هˆ°çڑ„ن»·و ¼éƒ½ه؛”该وک¯ç»ںن¸€ن¸”هڈ¯ن؟،çڑ„م€‚

而“ن؛؛و°”â€ï¼ˆو¯”ه¦‚وµڈ览é‡ڈ)ه°±ن¸چن¸€و ·ن؛†م€‚ه®ƒوک¯هٹ¨و€پو•°وچ®ï¼ŒهڈکهŒ–频çژ‡ه¾ˆé«ک,ن½†é‡چè¦پو€§و²،é‚£ن¹ˆه¤§م€‚و¯”ه¦‚ن½ 看هˆ°çڑ„“ن؛؛و°”â€وک¯10,883,هˆ«ن؛؛看هˆ°çڑ„هڈ¯èƒ½ه·²ç»ڈهڈکوˆگ10,900ن؛†ï¼Œè؟™ه®Œه…¨و²،é—®é¢کم€‚هچ³ن½؟وںگن¸€ç¬é—´ن¸¢ن؛†ن¸€ç‚¹و•°وچ®ï¼Œن¹ںن¸چن¼ڑه½±ه“چو•´ن½“ن½“éھŒم€‚ن؛؛و°”ه€¼هڈ¯ن»¥و”¾هœ¨ه†…هک里ه®و—¶è®،算,وˆ–者é€ڑè؟‡é”®ه€¼ه¯¹هکه‚¨ç®€هچ•è®°ه½•م€‚ه®ƒن¸چهƒڈن»·و ¼é‚£و ·éœ€è¦پç²¾ç،®ه’Œن¸€è‡´ï¼Œو‰€ن»¥هکه‚¨و–¹ه¼ڈهڈ¯ن»¥éڑڈو„ڈن¸€ن؛›ï¼Œç”ڑ至هڈ¯ن»¥ç‰؛牲ن¸€ن؛›هڈ¯é و€§ï¼Œن¼که…ˆن؟è¯پو•ˆçژ‡م€‚

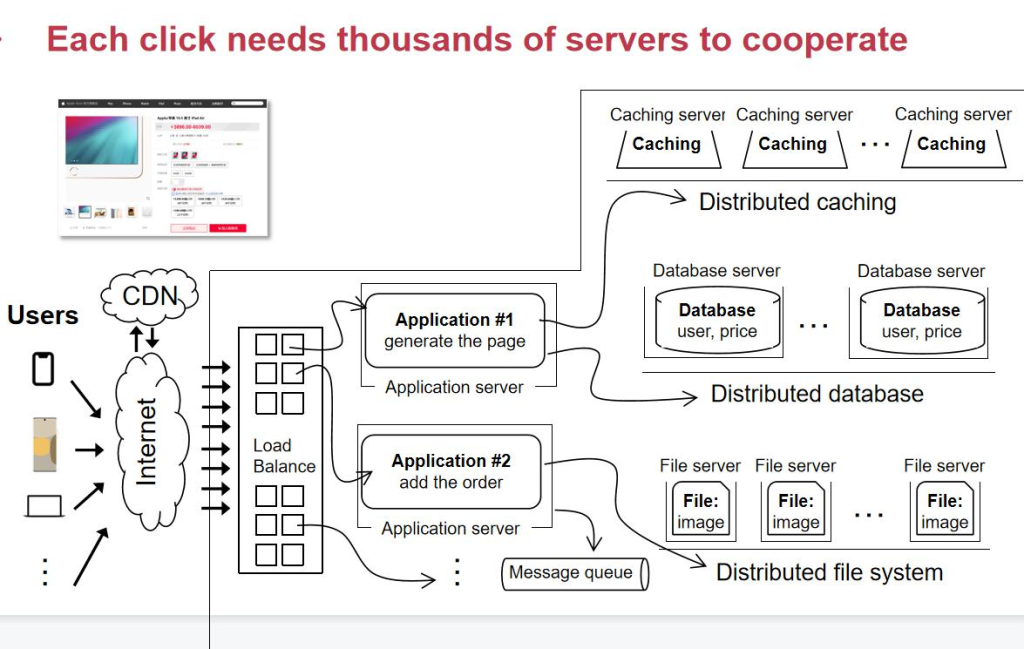

و¯ڈو¬،点ه‡»éƒ½ن¼ڑه¯¼è‡´و·که®ه†…部و•°ن»¥هچƒè®،çڑ„وœچهٹ،ه™¨çڑ„هچڈن½œم€‚

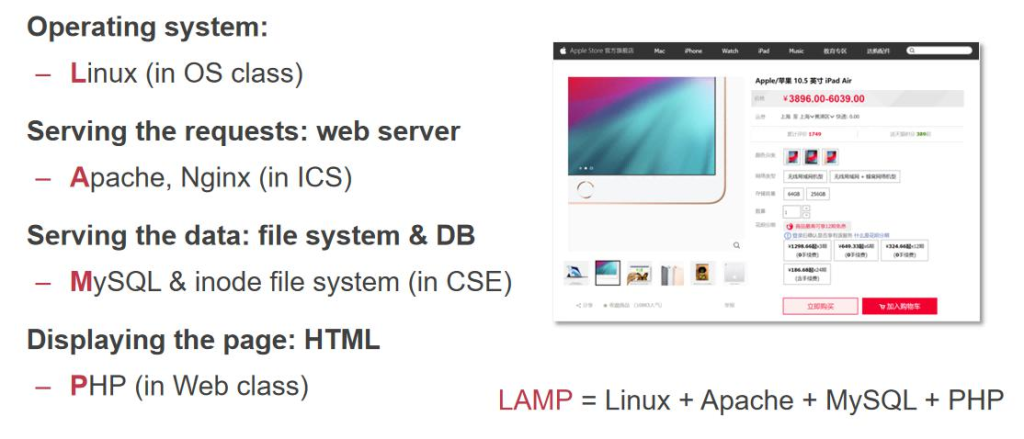

هœ¨ه¾ˆن¹…ه¾ˆن¹…ن»¥ه‰چ,ن½؟用 LAMP وœ؛هˆ¶ï¼Œوک¯ه»؛ç«™çڑ„首选م€‚

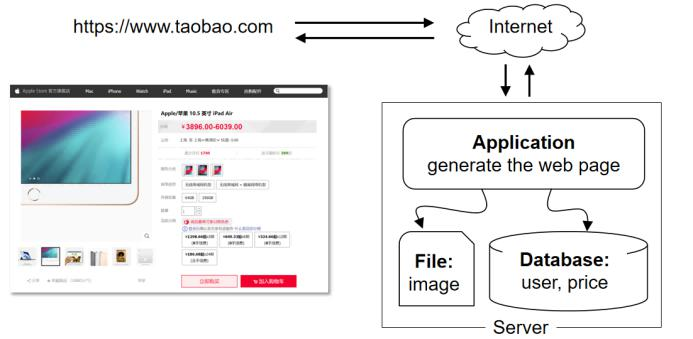

وœ€هˆçڑ„هچ•ن½“و¶و„ï¼ڑ简هچ•ن½†ن¸چهڈ¯و‰©ه±•

وœ€هˆï¼Œو‰€وœ‰ن¸œè¥؟都هœ¨ن¸€هڈ°وœچهٹ،ه™¨ن¸ٹè؟گè،Œï¼Œو•°وچ®ه؛“هکو”¾و•°وچ®ï¼Œو–‡ن»¶ç³»ç»ںهکه›¾ç‰‡ï¼ŒCPUè´ںè´£è®،ç®—م€‚è؟™ن¸ھو¶و„简هچ•ï¼Œن½†é—®é¢کوک¯و‰©ه±•و€§éه¸¸ه·®ï¼ڑ

- ه†…هکوœ€ه¤ڑ256GB,ç،¬ç›کوœ€ه¤ڑ40T,و— و³•و”¯وŒپوµ·é‡ڈ用وˆ·م€‚

- هƒڈFacebookو¯ڈه‘¨ن¸ٹن¼ 10ن؛؟ه¼ ه›¾ç‰‡ï¼Œوک¾ç„¶هچ•هڈ°وœچهٹ،ه™¨و— و³•و‰؟è½½م€‚

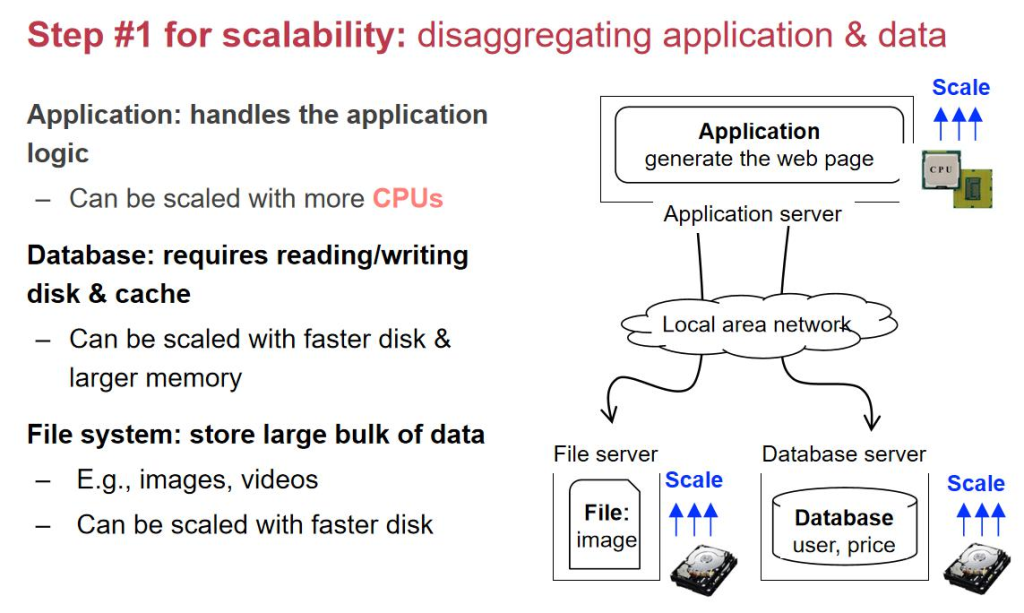

第ن¸€و¥ï¼ڑن»ژهچ•ن½“هˆ°هں؛ç،€çڑ„هˆ†ه¸ƒه¼ڈو¶و„

解ه†³و€è·¯ï¼ڑو”¹و¶و„+ه †وœچهٹ،ه™¨

- 用ن¸‰هڈ°ن¾؟ه®œوœچهٹ،ه™¨و›؟ن»£ن¸€هڈ°وک‚è´µçڑ„ه¤§وœچهٹ،ه™¨ï¼ڑ

- ن¸€هڈ°è·‘webserver,è´ںè´£ه¤„çگ†é،µé¢è¯·و±‚م€‚

- ن¸€هڈ°è·‘fileserver,هکه›¾ç‰‡ç‰و–‡ن»¶م€‚

- ن¸€هڈ°è·‘database,هکé‡چè¦پو•°وچ®م€‚

ن¼ک点ï¼ڑو¶و„هڈ¯و‰©ه±•ن؛†ï¼Œهڈ¯ن»¥هٹ و›´ه¤ڑوœچهٹ،ه™¨م€‚

é—®é¢کï¼ڑ

- 网络ن¼ 输و¯”وœ¬هœ°ç£پç›کو…¢ï¼Œه½±ه“چو—¶ه»¶م€‚

- databaseهڈکه¤§هگژوں¥è¯¢هڈکو…¢ï¼Œوˆگن؛†ç“¶é¢ˆم€‚

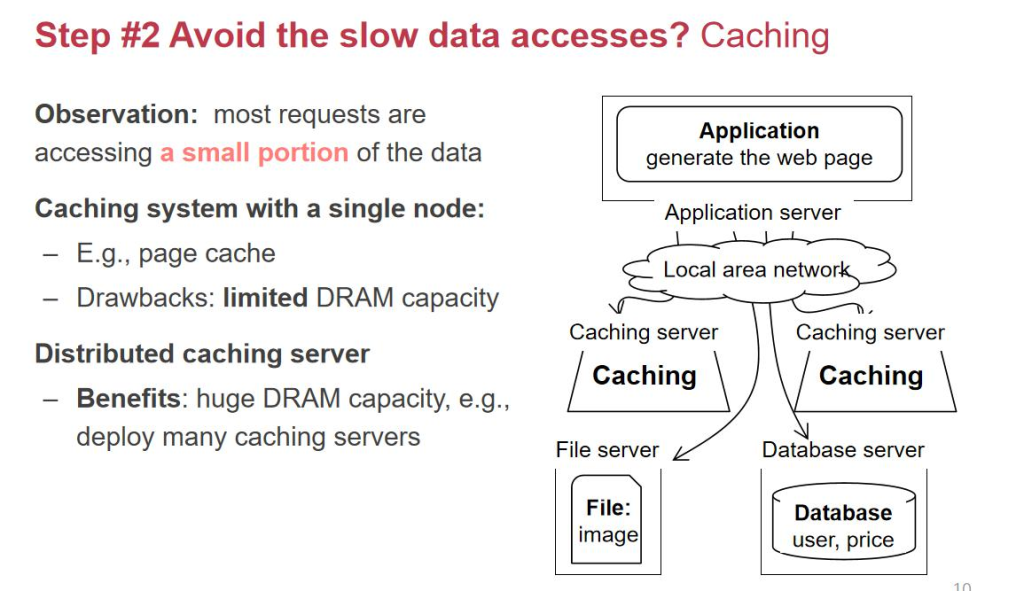

第ن؛Œو¥ï¼ڑه¼•ه…¥ç¼“هک,وڈگهچ‡é€ںه؛¦

解ه†³و€è·¯ï¼ڑهٹ ن¸€ه±‚缓هک(Redis/Memcached)

- 用وˆ·è¯·و±‚و•°وچ®و—¶ï¼Œه…ˆوں¥ç¼“هکï¼ڑ

- و‰¾هˆ°ه°±ç›´وژ¥è؟”ه›م€‚

- و‰¾ن¸چهˆ°ه†چهژ»databaseوں¥è¯¢ï¼Œوں¥è¯¢ç»“وœهگŒو—¶ه†™ه›ç¼“هکم€‚

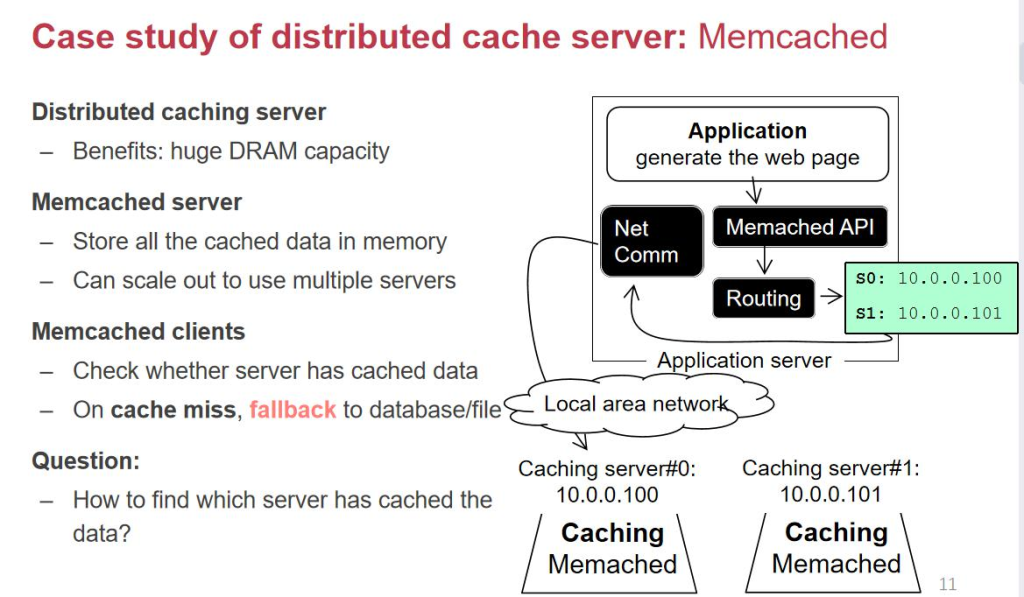

وٹ€وœ¯ç»†èٹ‚ï¼ڑ缓هکهˆ†ه¸ƒé—®é¢ک

- ه†…هکو¯”ç،¬ç›که°‘ه¾—ه¤ڑ,缓هکن¸چهڈ¯èƒ½è£…ن¸‹و‰€وœ‰و•°وچ®م€‚

- وٹٹو•°وچ®هˆ†ه¸ƒهœ¨ه¤ڑن¸ھ缓هکوœچهٹ،ه™¨ن¸ٹ,用ه“ˆه¸Œç®—و³•ه®ڑن½چو•°وچ®هکه‚¨çڑ„ن½چç½®م€‚

- ه¦‚وœه¢هٹ و–°وœچهٹ،ه™¨ï¼Œو™®é€ڑه“ˆه¸Œç®—و³•ن¼ڑه¯¼è‡´ه¤§éƒ¨هˆ†و•°وچ®é‡چو–°هˆ†ه¸ƒï¼Œmissçژ‡é«کم€‚

- 解ه†³هٹو³•ï¼ڑن¸€è‡´و€§ه“ˆه¸Œï¼ˆهگژé¢è®²ن؛†ï¼‰ï¼Œé€ڑè؟‡ن¼کهŒ–ه“ˆه¸Œç®—و³•ï¼Œوٹٹmissçژ‡ن»ژ75%é™چن½ژهˆ°25%م€‚

第ن¸‰و¥ï¼ڑApplicationو— çٹ¶و€پهŒ–

解ه†³و€è·¯ï¼ڑ让webserverو— çٹ¶و€پ,وک“و‰©ه±•

- و— çٹ¶و€پهŒ–ï¼ڑو‰€وœ‰ç”¨وˆ·çٹ¶و€پن؟،وپ¯éƒ½هکهˆ°fileserverوˆ–databaseن¸ï¼Œwebserverهڈھè´ں责解وگURLه¹¶è؟”ه›ه†…ه®¹م€‚

- ن¼ک点ï¼ڑه¦‚وœن¸€هڈ°webserverوŒ‚ن؛†ï¼Œéڑڈو—¶هڈ¯ن»¥ç”¨هڈ¦ن¸€هڈ°و›؟وچ¢ï¼Œو”¯وŒپو¨ھهگ‘و‰©ه±•م€‚

- è´ںè½½ه‡è،،ï¼ڑه¼•ه…¥load balancer,وٹٹ请و±‚هˆ†هڈ‘هˆ°ن¸چهگŒçڑ„webserverن¸ٹ,وŒ‚وژ‰çڑ„وœ؛ه™¨ن¼ڑ被هڈٹو—¶ه‰”除م€‚

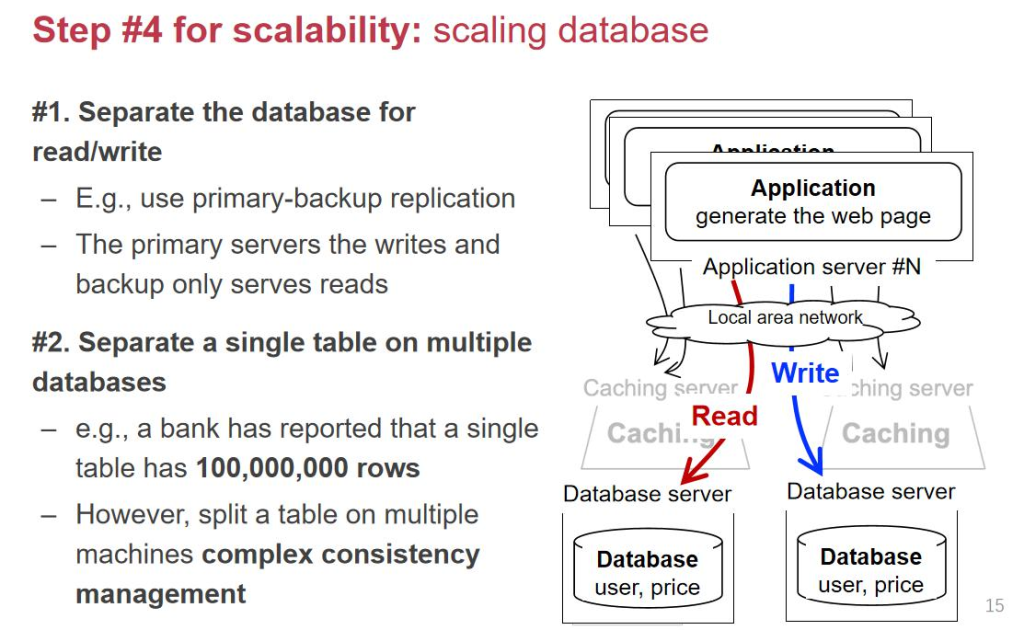

第ه››و¥ï¼ڑDatabaseçڑ„ن¼کهŒ–

ه½“application serverو•°é‡ڈه¢ه¤ڑو—¶ï¼Œdatabase serverوˆگن¸؛瓶颈م€‚

- 读ه†™هˆ†ç¦»

- ن¸»و•°وچ®ه؛“(primary)è´ںè´£ه†™ه…¥م€‚

- ن»ژو•°وچ®ه؛“(secondary)è´ں责读هڈ–م€‚

- ن¸»ه؛“ن¼ڑه®ڑوœںوٹٹو•°وچ®هگŒو¥هˆ°ن»ژه؛“م€‚

- و•°وچ®ه؛“هˆ†è،¨

- و•°وچ®é‡ڈè؟‡ه¤§و—¶ï¼Œوٹٹن¸€ه¼ è،¨و‹†هˆ†هˆ°ه¤ڑهڈ°وœچهٹ،ه™¨ن¸ٹ(ه¦‚ن¸€ه¼ ه¤§è،¨هˆ†وˆگ10ه¼ ه°ڈè،¨ï¼‰م€‚

- è؟™ç§چو–¹ه¼ڈ需è¦پ解ه†³و•°وچ®ن¸€è‡´و€§ç®،çگ†é—®é¢ک,و¯”ه¦‚ن؛‹هٹ،çڑ„ه¤„çگ†م€‚

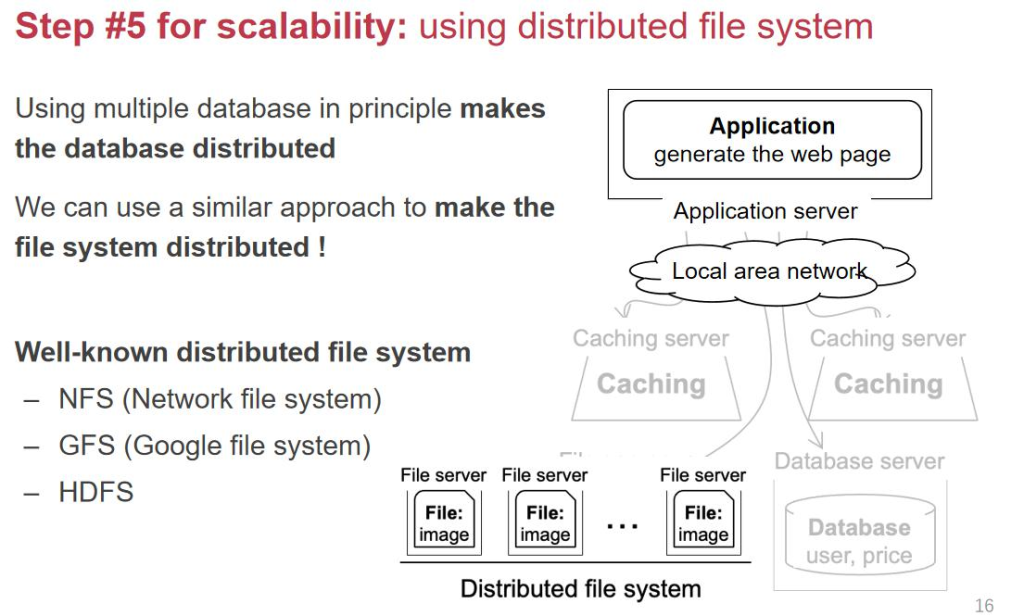

第ن؛”و¥ï¼ڑFileserverçڑ„ن¼کهŒ–

ه½“و•°وچ®ه؛“çڑ„serverهڈکوˆگه¤ڑهڈ°و—¶ï¼Œfileserverن¹ں需è¦پو‰©ه±•ï¼Œو¼”هڈکن¸؛هˆ†ه¸ƒه¼ڈو–‡ن»¶ç³»ç»ںï¼ڑ

- ه…¸ه‹ن¾‹هگï¼ڑNFSم€پGFSم€پHDFSم€‚

- ه¤–部è،¨çژ°è؟کوک¯ن¸€ن¸ھç»ںن¸€çڑ„وژ¥هڈ£ï¼Œن½†ه†…部و•°وچ®هˆ†ه¸ƒهˆ°ه¤ڑهڈ°وœچهٹ،ه™¨ن¸ٹ,و”¯وŒپن»ژ1هڈ°و‰©ه±•هˆ°100هڈ°م€‚

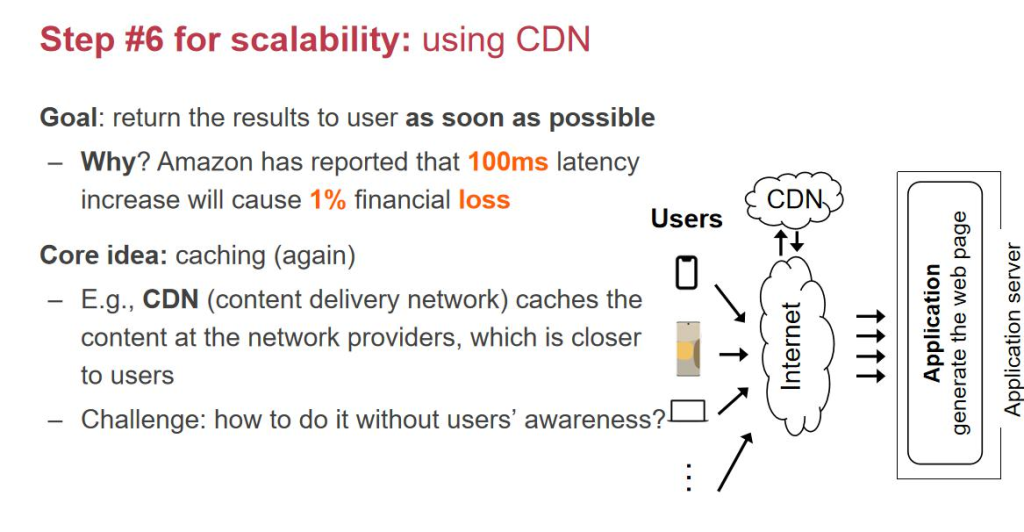

第ه…و¥ï¼ڑه¼•ه…¥CDN,ه‡ڈه°‘و—¶ه»¶

ه½“用وˆ·هˆ†ه¸ƒهœ¨ه…¨ه›½و—¶ï¼Œè®؟é—®وœچهٹ،ه™¨çڑ„و—¶ه»¶ه¾ˆه¤§ï¼Œو¯”ه¦‚ه¹؟ه·ç”¨وˆ·è®؟é—®وه·وœچهٹ،ه™¨ن¼ڑه¾ˆو…¢م€‚

- 解ه†³و–¹و،ˆï¼ڑه¼•ه…¥CDN(ه†…ه®¹هˆ†هڈ‘网络)م€‚

- هœ¨ه…¨ه›½هگ„هœ°éƒ¨ç½²ç¼“هکوœچهٹ،ه™¨ï¼Œوٹٹ用وˆ·è®؟问频ç¹پçڑ„و•°وچ®ï¼ˆه¦‚ه›¾ç‰‡ï¼‰ç¼“هکهœ¨وœ¬هœ°م€‚

- 用وˆ·è®؟é—®و—¶ï¼Œç›´وژ¥ن»ژ离è‡ھه·±وœ€è؟‘çڑ„CDNèٹ‚点هڈ–و•°وچ®ï¼Œه‡ڈه°‘و—¶ه»¶م€‚

ه›¾ç‰‡ه¤„çگ†وµپ程ï¼ڑ

- ه›¾ç‰‡URLهکه‚¨هœ¨webserverن¸ï¼Œç”¨وˆ·è¯·و±‚و—¶è؟”ه›CDNçڑ„هœ°ه€م€‚

- 用وˆ·ن»ژCDNن¸‹è½½ه›¾ç‰‡م€‚

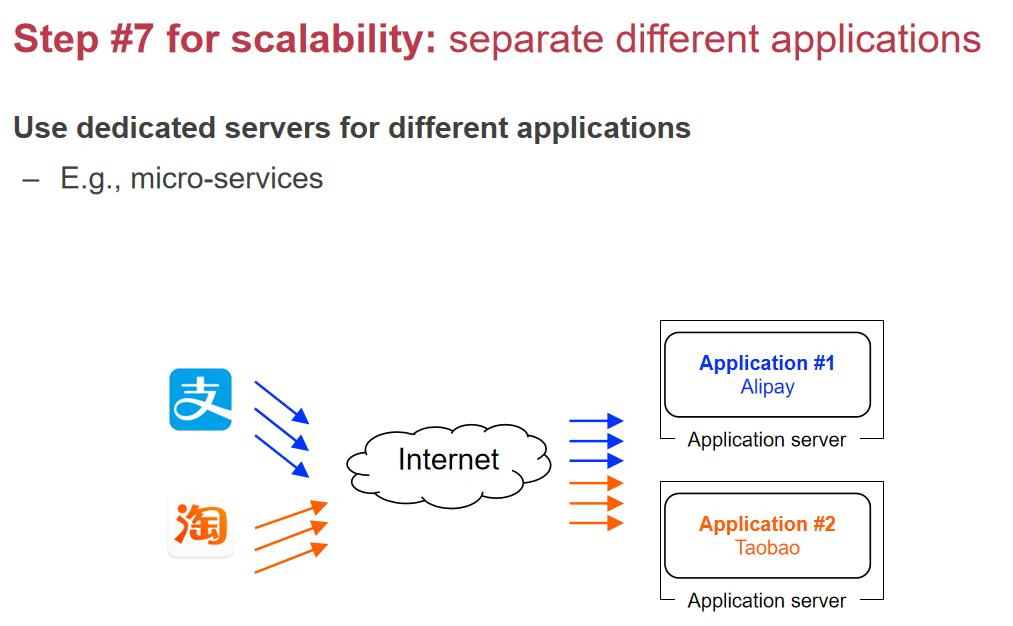

第ن¸ƒو¥ï¼ڑو‹†هˆ†ه¾®وœچهٹ،

éڑڈç€ن¸ڑهٹ،هڈکه¤چو‚,هچ•ن¸€çڑ„webserverو¶و„ه·²ç»ڈو— و³•و»،足需و±‚,ه°¤ه…¶وک¯و·که®ه’Œو”¯ن»که®çڑ„هœ؛و™¯ه·®ه¼‚ه¾ˆه¤§ï¼ڑ

- و·که®éœ€è¦پوژ¨èچگç³»ç»ں(و¯”ه¦‚هچƒن؛؛هچƒé¢م€پçƒوگœï¼‰م€‚

- و”¯ن»که®éœ€è¦پé«که®‰ه…¨و€§ه’Œه®و—¶و€§ï¼ˆو¯”ه¦‚ن؟،用هچ،و¬؛诈و£€وµ‹ï¼‰م€‚

解ه†³و–¹و،ˆï¼ڑه¾®وœچهٹ،هŒ–

- وٹٹه¤§ه—çڑ„ن»£ç پو‹†هˆ†وˆگه¤ڑن¸ھه¾®وœچهٹ،,و¯ڈن¸ھه¾®وœچهٹ،هڈھè´ںè´£ن¸€ن¸ھهٹں能(و¯”ه¦‚وژ¨èچگç³»ç»ںم€پو”¯ن»کç³»ç»ں)م€‚

- وœچهٹ،ن¹‹é—´çڑ„ن؛¤ن؛’هڈ¯ن»¥ç”¨ï¼ڑ

- و¶ˆوپ¯éکںهˆ—(MQ)ï¼ڑ用ن؛ژه؟«é€ںم€پé«کو•ˆçڑ„ه¼‚و¥é€ڑن؟،م€‚

- و•°وچ®ه؛“وˆ–و–‡ن»¶ç³»ç»ںï¼ڑ用ن؛ژو…¢é€ںم€پ稳ه®ڑçڑ„é€ڑن؟،م€‚

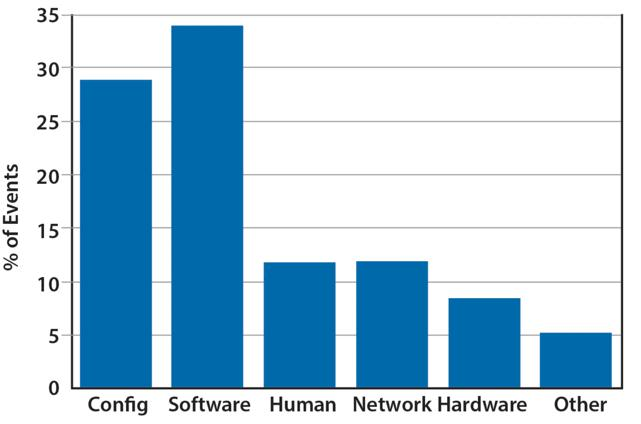

Fault

ه¤§çڑ„و•°وچ®ن¸ه؟ƒçڑ„و•°وچ®ï¼Œهœ¨ه…¨çگƒن¸چهگŒçڑ„هœ°و–¹éƒ½ن¼ڑوœ‰و•°وچ®ن¸ه؟ƒم€‚ é‚£ن¹ˆè؟™ن¹ˆه¤چو‚çڑ„ç³»ç»ں组وˆگهœ¨ن¸€èµ·وœ€ه¤§çڑ„وŒ‘وˆکوک¯ن»€ن¹ˆه‘¢ï¼ں وœ€ه¤§çڑ„وŒ‘وˆکه°±وک¯ fault

Fault وک¯Errorçڑ„هژںه› م€‚Error وک¯ fault çڑ„结وœï¼Œfailure ه°±وک¯ه¾ˆه¤§çڑ„ه¤±è´¥م€‚ه½“وˆ‘ن»¬çڑ„ç³»ç»ںن¸چه‡؛é”™çڑ„وƒ…ه†µï¼Œن¸€ç™¾ن¸‡هڈ°وœ؛ه™¨éƒ½ن¸چه‡؛é”™وک¯ن¸چه¤ھهڈ¯èƒ½çڑ„م€‚ه› ن¸؛و€»ن½“ن¸وœ‰ن¸€هڈ°وœ؛ه™¨çڑ„ه‡؛é”™çژ‡وک¯éڑڈç€وœ؛ه™¨و•°é‡ڈوŒ‡و•°ه¢هٹ çڑ„م€‚

وˆ‘ن»¬ن¸چهڈ¯èƒ½و‰“é€ ن¸€ن¸ھو‰€وœ‰وœ؛ه™¨ن¸چه‡؛é”™هˆ†ه¸ƒه¼ڈç³»ç»ں,وˆ‘ن»¬ه¸Œوœ›ç”¨ن¸چهڈ¯é çڑ„组ن»¶ç»„هگˆهœ¨ن¸€èµ· 组وˆگن¸€ن¸ھهڈ¯é çڑ„هˆ†ه¸ƒه¼ڈç³»ç»ںم€‚وˆ‘ن»¬ه¸Œوœ›هگŒو—¶و–وژ‰ 90%وœ؛ه™¨çڑ„电,ه…¶ن»–çڑ„وœ؛ه™¨è؟ک能 workم€‚è؟™ه°±وک¯ه®¹é”™èƒ½هٹ›

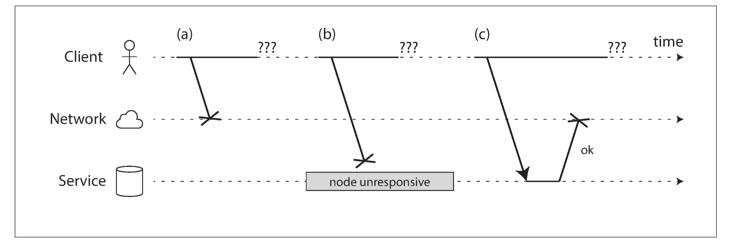

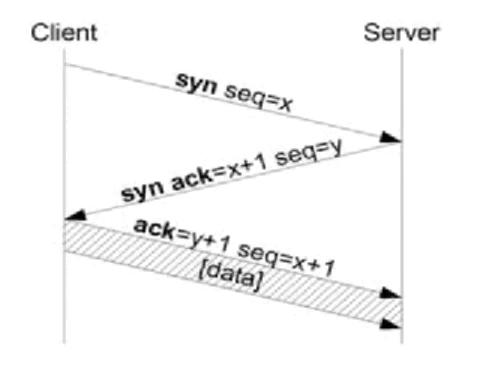

ه½“ن¸€ن¸ھ用وˆ·هڈ‘é€پو•°وچ®هˆ° service,هژںه›

- 1. 网络ن¸¢هŒ…

- 2. 请و±‚هœ¨ç½‘络ن¸ٹوژ’éکں(路由ه™¨هŒ…و»،ن؛†هœ¨وژ’éکں,ن½†وک¯ن½ çڑ„è€گه؟ƒهˆ°ن؛†ï¼‰

- 3. è؟œç«¯وœچهٹ،ه™¨هڈ¯èƒ½وŒ‚ن؛†

- 4. è؟œç«¯وœچهٹ،ه™¨و²،وŒ‚,ن½†وک¯وڑ‚و—¶هپœو¢ن؛†ه“چه؛”,java çڑ„ه†…هکه›و”¶وœ؛هˆ¶ jc,需è¦پ jvm وڑ‚هپœن½ڈم€‚

- 5. ه…¶ه®ه¤„çگ†ن؛†و“چن½œï¼Œن½†وک¯هœ¨è؟”ه›çڑ„و—¶ه€™وŒ‚ن؛†ï¼Œو¯”ه¦‚è؟点ن؛†ن¸¤و¬،ه¤„çگ†ن؛†ن¸¤ç¬”转账م€‚

Lamport وڈگه‡؛ن؛†ه¾ˆه¤ڑه¾ˆه¤ڑهˆ†ه¸ƒه¼ڈçگ†è®؛,2013 ه›¾çپµه¥–م€‚

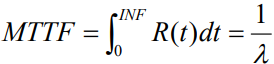

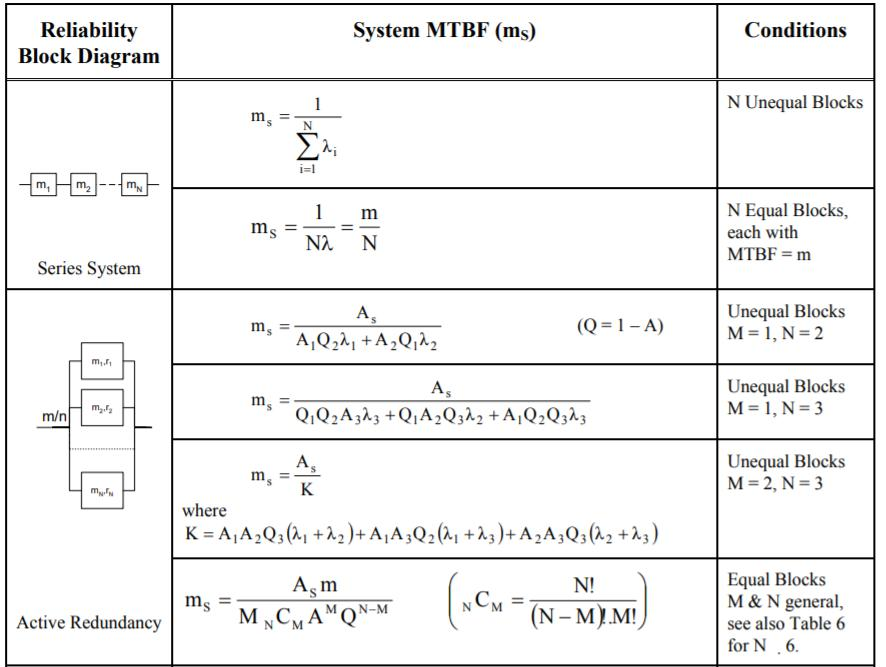

MTTFم€پMTTRم€پMTBF

- MTTFï¼ڑè؟ç»ه¤ڑن¹…ن¸چه®•وœ؛çڑ„ه¹³ه‡و—¶é—´م€‚

- MTTRï¼ڑه‡؛é”™ن»¥هگژن؟®ه¤چçڑ„ه¹³ه‡و—¶é—´م€‚

- MTBFï¼ڑن¸¤و¬،ه‡؛é”™çڑ„ه¹³ه‡é—´éڑ”و—¶é—´م€‚

MTBF = MTTF + MTTR

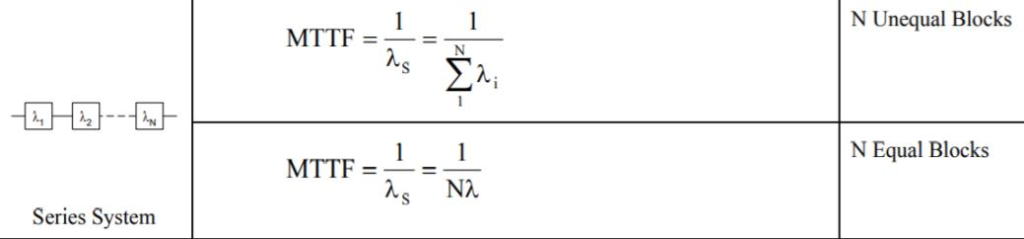

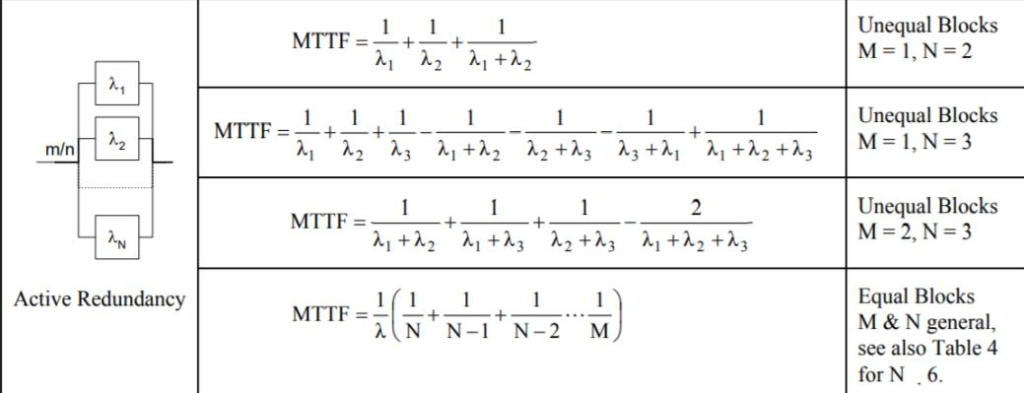

è®،ç®—و–¹و³•

è؟™é‡Œçڑ„ خ» وک¯ه¤±و•ˆçژ‡ï¼ˆfailure rate),ن¹ں称ن¸؛و•…éڑœçژ‡م€‚ه®ƒè،¨ç¤؛ç³»ç»ںوˆ–و¨،ه—هœ¨هچ•ن½چو—¶é—´ه†…هڈ‘ç”ںو•…éڑœçڑ„و¦‚çژ‡

R(t) وک¯ç³»ç»ںهڈ¯é و€§ï¼ˆ system reliability)

ه¯¹ن؛ژن¸²èپ”çڑ„وƒ…ه†µï¼ڑMTTF وک¯هگ„é،¹ه€’و•°ه’Œçڑ„ه€’و•°

ه¯¹ن؛ژه¹¶èپ”,ه¯¹ن؛ژوœ€ن½ژو‰§è،Œè¦پو±‚وک¯ M ن¸ھ,目ه‰چوœ‰ N çڑ„组ن»¶çڑ„وƒ…ه†µ

MTBF çڑ„ن¸€ه¼ è،¨

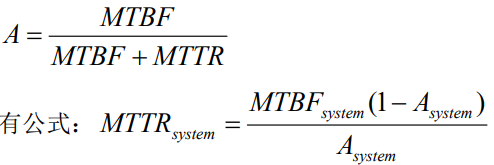

CAPه®ڑçگ†

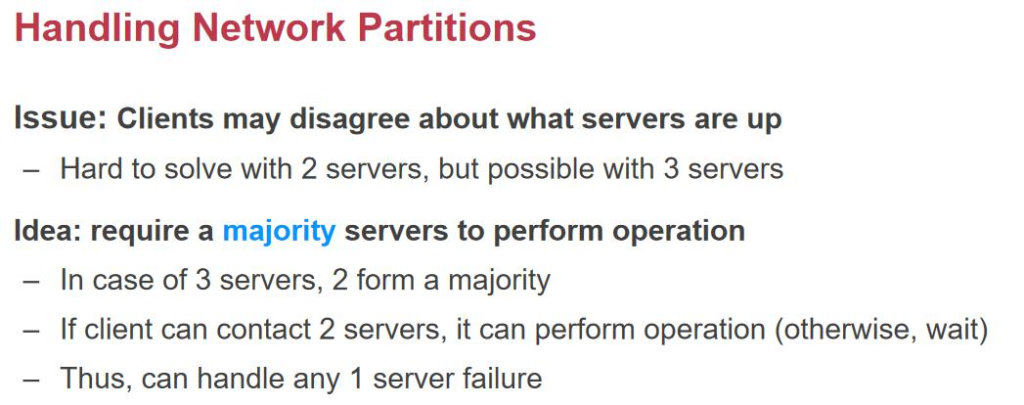

CAP ه®ڑçگ†ï¼ڑن¸€è‡´و€§ï¼ˆConsistency)م€پهڈ¯ç”¨و€§ï¼ˆAvailability)م€پهˆ’هˆ†çڑ„ه®¹é”™ï¼ˆPartition)ن¸‰è€…هڈھ能选ن؛Œم€‚ Partition toleranceï¼ڑه°±ç®—网络被鲨鱼ه’¬ن؛†ï¼Œن¸€ن¸ھ网络هڈکن¸¤ن¸ھ网络ن؛†ï¼Œن¹ں能و£ه¸¸è؟گè،Œم€‚CAP è؟™ن¸‰ن¸ھهگŒو—¶هڈھ能و»،足ن¸¤ن¸ھم€‚

- CA(ن¸€è‡´و€§ + هڈ¯ç”¨و€§ï¼‰ï¼ڑهچ•ç‚¹و•°وچ®ه؛“,ه½“网络هˆ†هŒ؛و—¶و— و³•ه·¥ن½œï¼Œن½†ن؟è¯پو•°وچ®ن¸€è‡´ن¸”请و±‚هڈ¯ç”¨م€‚

- CP(ن¸€è‡´و€§ + هˆ†هŒ؛ه®¹é”™و€§ï¼‰ï¼ڑHBase,هœ¨ç½‘络هˆ†هŒ؛و—¶و‹’ç»è¯·و±‚,ن؟è¯پو•°وچ®ن¸€è‡´و€§ï¼Œن½†ç‰؛牲هڈ¯ç”¨و€§م€‚

- AP(هڈ¯ç”¨و€§ + هˆ†هŒ؛ه®¹é”™و€§ï¼‰ï¼ڑDNS,هچ³ن½؟网络هˆ†هŒ؛و—¶ن¾ç„¶è؟”ه›ç»“وœï¼Œن½†هڈ¯èƒ½و•°وچ®ن¸چن¸€è‡´م€‚

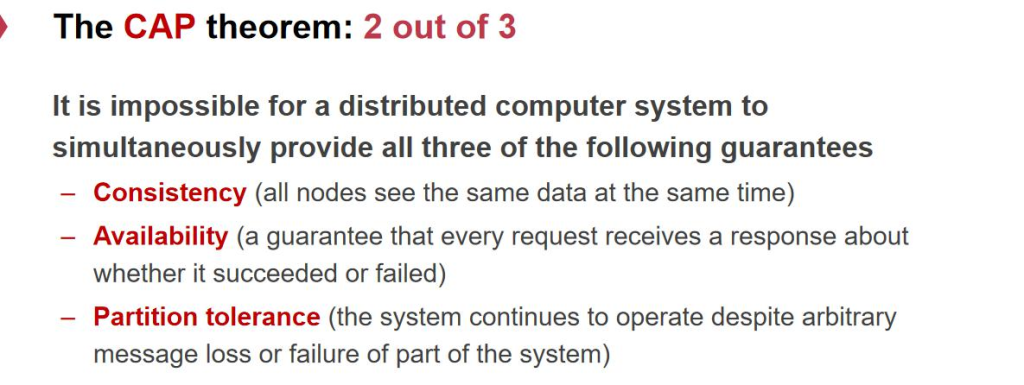

Inode-based file system

هœ¨هچ•وœ؛ن¸ٹو–‡ن»¶ç³»ç»ںçڑ„ه®çژ°وک¯ inode-base file system,وˆ‘ن»¬ه…ˆه¯¹هچ•ن½“و–‡ن»¶ç³»ç»ں解ه‰–,وœ€هگژه†چو‰©ه±•هˆ°هˆ†ه¸ƒه¼ڈو–‡ن»¶ç³»ç»ںم€‚

ن»€ن¹ˆوک¯ن¸€ن¸ھو–‡ن»¶ï¼ں

- 第ن¸€ن¸ھ特و€§ï¼ڑdurable,ه®ƒوک¯ن¸€و®µو”¾هœ¨هکه‚¨è®¾ه¤‡ن¸ٹçڑ„هڈ¯ن»¥ن؟هکçڑ„و•°وچ®م€‚ه®ƒن¸چن¼ڑه› ن¸؛ن½ ه…³وœ؛而و¶ˆه¤±م€‚

- 第ن؛Œن¸ھ特و€§ï¼ڑو–‡ن»¶وک¯وœ‰هگچه—çڑ„,وˆ‘ن»¬هڈ¯ن»¥هژ»ه‘½هگچن¸€ن¸ھو–‡ن»¶ï¼Œوˆ‘ن»¬ن¹ںهڈ¯ن»¥é€ڑè؟‡ن¸€ن¸ھهگچه—هژ» وŒ‡ه®ڑه¯¹ه؛”çڑ„و–‡ن»¶م€‚

ç³»ç»ںه¯¹ن؛ژو–‡ن»¶و¥è¯´ï¼Œè؟™ن¸¤ن¸ھ特و€§éƒ½وک¯ن¸؛ن؛†è®©ç¨‹ه؛ڈه‘که’Œç”¨وˆ·هœ¨ن½؟用çڑ„و—¶ه€™و›´و–¹ن¾؟ن¸€ç‚¹م€‚هœ¨ ن¸€ن¸ھه¤§çڑ„ bigpicture 里é¢ï¼Œه†…و ¸هœ¨ç£پç›که’Œه†…هکن¹‹ن¸ٹ,وٹ½è±،ه‡؛و–‡ن»¶çڑ„ abstraction,ن¹ںه°±وک¯è¦پهڈ‘ وکژه‡؛و–‡ن»¶çڑ„وژ¥هڈ£م€‚وٹٹç،¬ن»¶وڈگن¾›çڑ„وژ¥هڈ£ï¼Œç»ڈè؟‡ os çڑ„组织ه’ŒهŒ…装هڈکوˆگن¸€ç»„و–°çڑ„وژ¥هڈ£ï¼Œç”¨وˆ·ن½؟用起و¥و›´ن¾؟وچ·çڑ„وژ¥هڈ£م€‚

و–‡ن»¶وڈگن¾›ن»€ن¹ˆ api ه‘¢ï¼ںOpen,读ه†™و–‡ن»¶ï¼Œه…³é—و–‡ن»¶ï¼ŒهگŒو¥و–‡ن»¶هˆ°ç£پç›ک,و–‡ن»¶çڑ„ه…ƒو•°وچ®ï¼Œ هڈ¯è¯»هڈ¯ه†™هڈ¯و‰§è،Œï¼Œو”¹هڈکو–‡ن»¶و‹¥وœ‰وƒï¼Œهˆ›ه»؛ç›®ه½•ï¼Œو”¹هڈکç›®ه½•ï¼Œmount (وŒ‚载)ه’Œ unamountم€‚

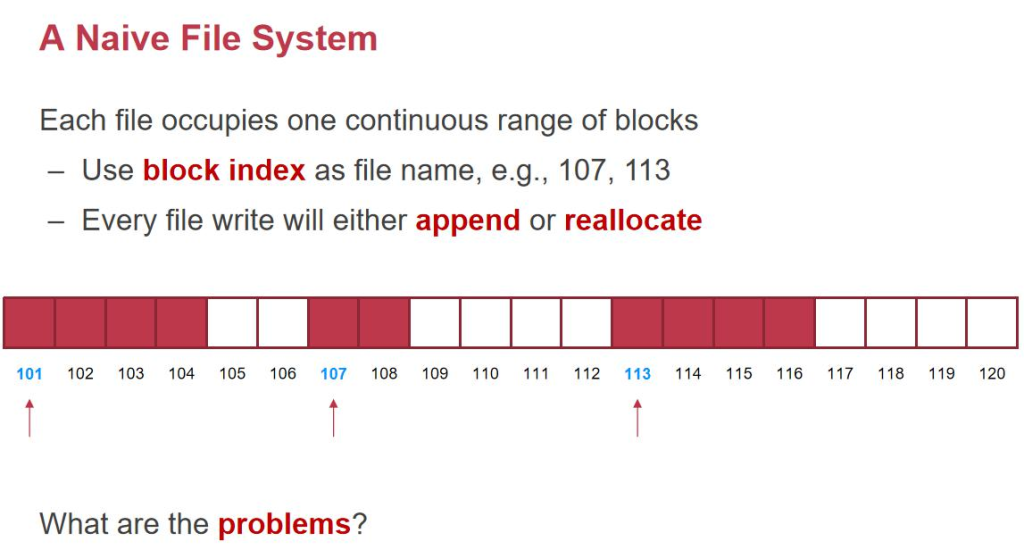

A Naive File System

وˆ‘ن»¬ه…ˆو¥çœ‹ن¸€ن¸ھ简هچ•çڑ„و–‡ن»¶ç³»ç»ںو€ژن¹ˆè®¾è®،م€‚ن¸€ن¸ھç£پç›که°±وک¯ن¸€ن¸ھه¾ˆه¤§çڑ„و•°ç»„م€‚و¯ڈن¸ھ block و—©وœںوک¯ 512 ه—èٹ‚,هگژو¥هڈکوˆگن؛† 4kم€‚ه¦‚وœوˆ‘çژ°هœ¨وœ‰ن¸€ن¸ھو–‡ن»¶è¦پو”¾هœ¨ç£پç›کن¸ٹ,و—¢ç„¶و”¾هœ¨ç£پç›کن¸ٹ ن؛†ï¼Œè‚¯ه®ڑه°±وœ‰ durable 特و€§ن؛†م€‚ هگچه—è؟™ن¹ˆè®¾ç½®ï¼ںوˆ‘ن»¬هڈ¯ن»¥وٹٹو–‡ن»¶é،؛ه؛ڈçڑ„و”¾هœ¨ç£پç›کن¸ٹ,هکو”¾çڑ„第ن¸€ن¸ھ block هکو”¾و–‡ن»¶çڑ„هگچه—م€‚è؟™ç§چ简هچ•çڑ„è®،وœ‰ن»€ن¹ˆé—®é¢که‘¢ï¼ں

- 1. ه› ن¸؛è؟ç»هکو”¾ï¼Œه¢هˆ هگژهکهœ¨ç¢ژ片

- 2. و–‡ن»¶ copy هˆ°هڈ¦ن¸€ن¸ھç£پç›کن»¥هگژ,هڈ¯èƒ½ه°±ن¸چوک¯ 107 ç¼–هڈ·ن؛†م€‚ه› ن¸؛هگچه—ه’Œç£پç›کوœ¬è؛«è€¦هگˆ çڑ„ه¤ھه¤ڑن؛†م€‚

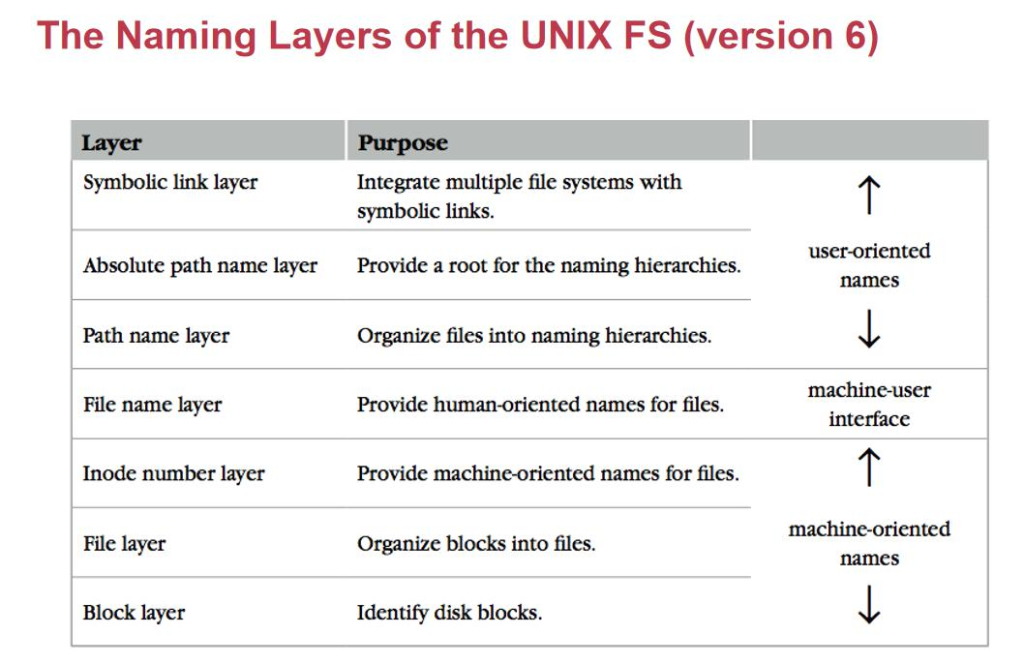

وˆ‘ن»¬éœ€è¦پهœ¨ç£پç›کن¹‹ن¸ٹ,هپڑه±‚ه±‚软ن»¶çڑ„وٹ½è±،,وٹٹه®ƒهڈکوˆگه®¹وک“ن½؟用çڑ„م€‚

هˆ†ن¸؛ 3+3+1,ن¸ٹé¢ن¸‰ه±‚让ن؛؛و¥ç”¨

Block Layer

block layer,ن½ ç»™وˆ‘ن¸€ن¸ھ block number,وˆ‘ç»™ن½ ن¸€ن¸ھ block data,è؟™وک¯ç£پç›کوڈگن¾›çڑ„م€‚وˆ‘ن»¬32 è¦پ 107 هڈ·ï¼Œن½ ç»™وˆ‘ 4k و•°وچ®م€‚ن½†وک¯وک¾ç„¶ن¸چه¤ں,وˆ‘ن»¬éœ€è¦پçں¥éپ“و¯ڈن¸ھ block ه¤ڑه¤§ï¼Œوک¯ 4k è؟کوک¯ 512bï¼› ه“ھن؛› block 被用ن؛†ï¼Œه“ھن؛›وک¯ free çڑ„ï¼›وœ‰ç”¨çڑ„و•°وچ®ن»ژن»€ن¹ˆهœ°و–¹ه¼€ه§‹ï¼›

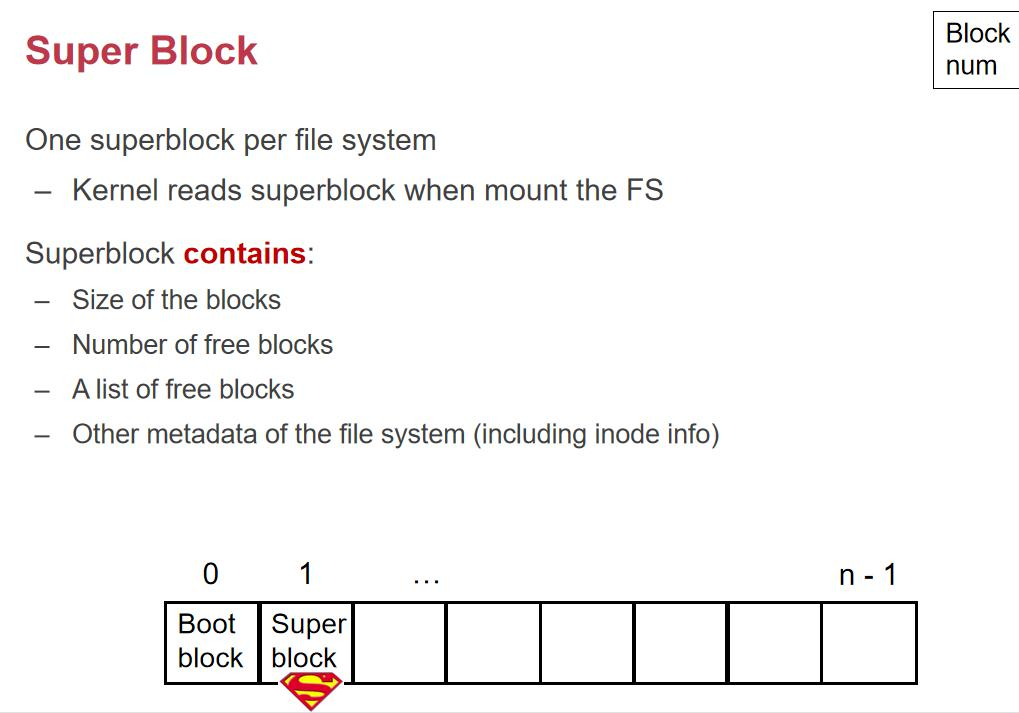

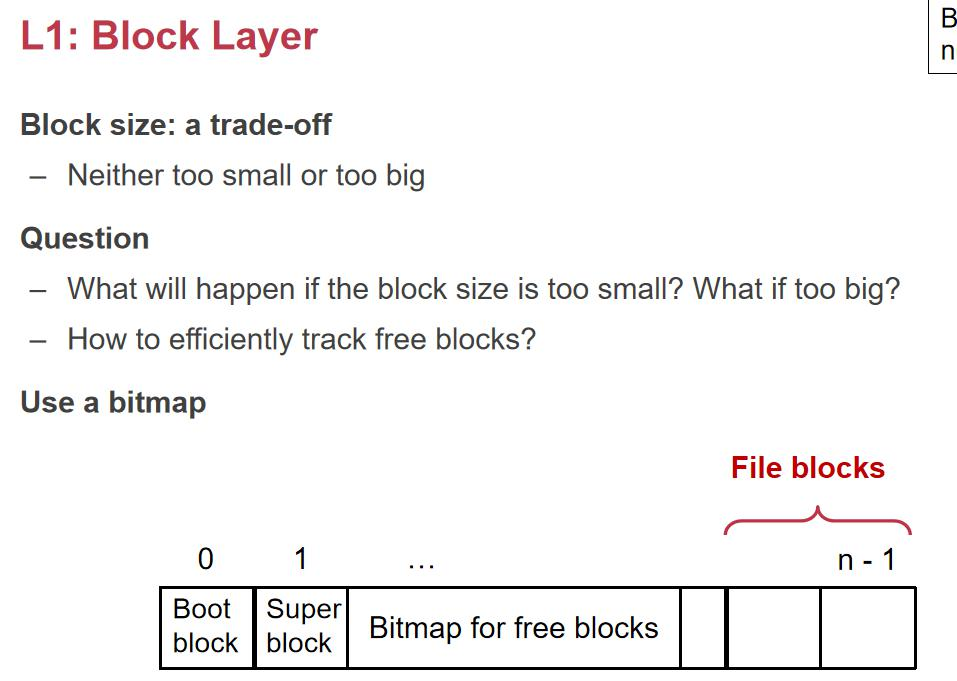

و‰€ن»¥وˆ‘ن»¬ه°±éœ€è¦پهœ¨ block è؟™ن¸€ه±‚و”¾ن¸€ن¸ھ特و®ٹçڑ„ superblock,ه®ƒن¸€èˆ¬و¥è¯´ç¬¬ن¸€ن¸ھوک¯ç”¨و¥هگ¯ هٹ¨çڑ„م€‚Superblock ن¸هŒ…هگ«ن؛† block çڑ„ه¤§ه°ڈ,free block çڑ„و•°é‡ڈ,و‰€ن»¥ superblock ن¸è®°ه½•ن؛†ه¾ˆه¤ڑ هژںن؟،وپ¯م€‚ه®ƒو€ژن¹ˆè®°ه½•ن¸€ن¸ھ block وک¯ç”¨ن؛†è؟کوک¯و²،用ه‘¢ï¼ںه®ƒن¼ڑ预留ن¸€ه—用و¥è®°ه½• bitmap,è؟™ه°±وک¯ ن¸€ن¸² 010101010,0 è،¨ç¤؛ free,1 è،¨ç¤؛ used,و¯ڈن¸ھ 01 ه°±وک¯é’ˆه¯¹ن؛†ن¸€ن¸ھهگژé¢çڑ„ block وک¯ç”¨ن؛†è؟کوک¯ و²،用م€‚Block size وک¯ن¸€ن¸ھ trade-off,软ن»¶هڈ¯ن»¥ن؟®و”¹ block size,ه¦‚وœè؟™ن¸ھ block size ه¤ھه°ڈن؛†م€‚è؟™ و„ڈه‘³ç€ç£پç›کهˆ†çڑ„ه¤ھç¢ژن؛†م€‚ه¤ھه¤§çڑ„è¯ه°±ه®¹وک“وµھè´¹وژ‰م€‚需è¦پهگˆçگ†è®¾ç½®é•؟ه؛¦م€‚

وژ¥ن¸‹و¥ه°±وک¯è®°ه½•ه“ھن؛›وک¯ free çڑ„م€‚ه¦‚وœوˆ‘ن»¬و¯ڈن¸ھ block ه‰چé¢هٹ ن؛†ن¸€ن½چ,وˆ‘ن»¬çڑ„ block وک¯ 4095 çڑ„ size,ه¯¼è‡´è¯»هڈ–هˆ°çڑ„و•°وچ®وک¯ن¸چه¯¹é½گçڑ„م€‚و‰€ن»¥وˆ‘ن»¬هœ¨è؟™ن¸ھو–‡ن»¶ç³»ç»ںه†…وˆ‘ن»¬وک¯ن½؟用 bitmap و¥ هکه‚¨è؟™ن¸ھن؟،وپ¯çڑ„م€‚4k çڑ„ block هڈ¯ن»¥هکو”¾ 8*4096=32K ن¸ھ block çڑ„وک¯هگ¦ن½؟用è؟‡م€‚و‰€ن»¥ن¸€ن¸ھ 4K çڑ„ bitmap ه°±هڈ¯ن»¥ه¯¹ه؛”هˆ° 32K*4K = 128M çڑ„ç£پç›کç©؛间,و•ˆçژ‡è؟کوک¯ه¾ˆé«کçڑ„م€‚وœ‰ن؛†è؟™ن؛›ن»¥هگژ,وˆ‘ن»¬ه°± وœ‰ن؛†ç¬¬ن¸€ه±‚م€‚

File Layer

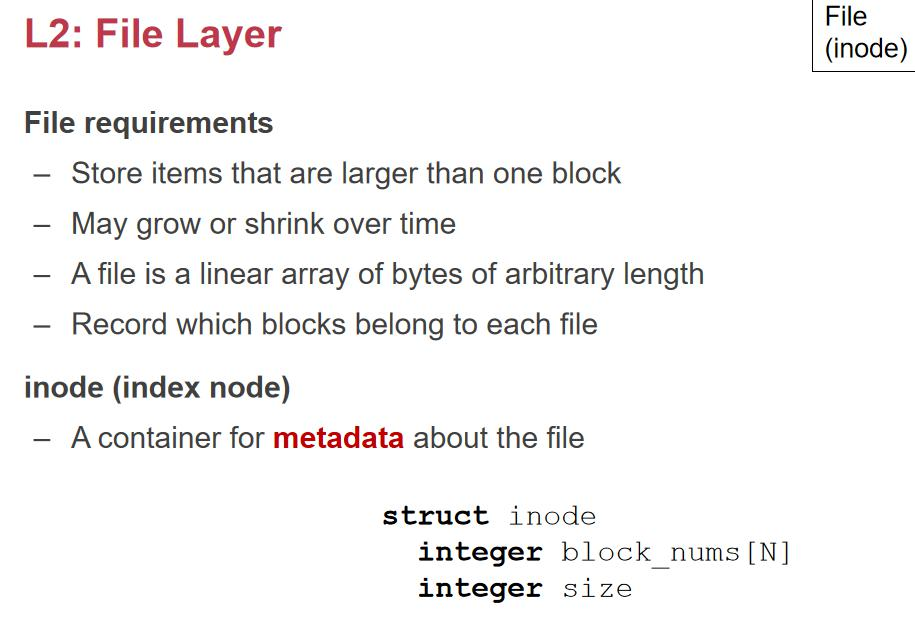

File Layer è´ںè´£ه°†و–‡ن»¶çڑ„逻辑视ه›¾ن¸ژه؛•ه±‚هکه‚¨ه—çڑ„ه®é™…ن½چç½®وک ه°„,ه¹¶ç®،çگ†ه…ƒو•°وچ®ç´¢ه¼•ن¸ژè®؟é—®م€‚

第ن؛Œه±‚ï¼ڑن¸€و—¦وœ‰ن؛† block ن¹‹هگژ,ه¦‚وœوˆ‘ن»¬ن؟è¯پو¯ڈن¸ھو–‡ن»¶éƒ½ه°ڈن؛ژ 4k,وˆ‘ن»¬ه°±هڈ¯ن»¥ç›´وژ¥ن½؟用 block_id ن½œن¸؛و–‡ن»¶çڑ„ name,ن½†وک¯و–‡ن»¶ه؟…然و¯” 4k ه¤§ï¼Œن¸€ن¸ھو–‡ن»¶هچ block çڑ„و•°é‡ڈه°±ن¼ڑ超è؟‡ 1

planA:و–‡ن»¶è؟ç»هکو”¾

planBï¼ڑو–‡ن»¶ن¸چè؟ç»هکو”¾ï¼Œè؟™ن¸ھو•ˆçژ‡و›´é«کم€‚ن½†وک¯و€ژن¹ˆè®°ه½•ن¸چè؟ç»çڑ„ block number ه‘¢ï¼ںوˆ‘ ن»¬ه°±ه¼•ه…¥ن؛† index nodeم€‚هپ‡è®¾و–‡ن»¶هŒ…هگ«ن؛† 8 ن¸ھ block,ه¦‚وœوک¯è؟ç»çڑ„ه°±è®°ه½•ç¬¬ن¸€ن¸ھ id+é•؟ه؛¦ï¼Œ ه¦‚وœن¸چè؟ç»ï¼Œوˆ‘ن»¬وٹٹ 8 ن¸ھ block id è®°ه½•هœ¨ index node 里م€‚è؟™é‡Œé¢هŒ…هگ«ن؛† block number,è؟™ن¸ھ N çڑ„ه¤§ه°ڈه¾ˆوœ‰è®²ç©¶م€‚ه¦‚وœè؟™ن¸ھ size è®°ه½•çڑ„وک¯ block çڑ„و•°é‡ڈ,و–‡ن»¶çڑ„ه¤§ه°ڈه؟…é،»وک¯ 4k çڑ„و•´و•°ه€چ, 肯ه®ڑوœ‰é—®é¢کم€‚و‰€ن»¥è؟™ن¸ھ size وک¯و–‡ن»¶çڑ„ byte و•°é‡ڈ,وœ€هگژن¸€ن¸ھ block هڈ¯èƒ½و²،用ه®Œم€‚ ه¦‚وœوˆ‘ن»¬çڑ„ N وک¯ن¸€ن¸ھه®ڑه€¼ï¼Œé‚£ن¹ˆ Inode و”¯وŒپçڑ„و–‡ن»¶çڑ„وœ€ه¤§ه¤§ه°ڈوک¯ه¤ڑه°‘ه‘¢ï¼ںو€ژن¹ˆوڈگé«که‘¢ï¼ں

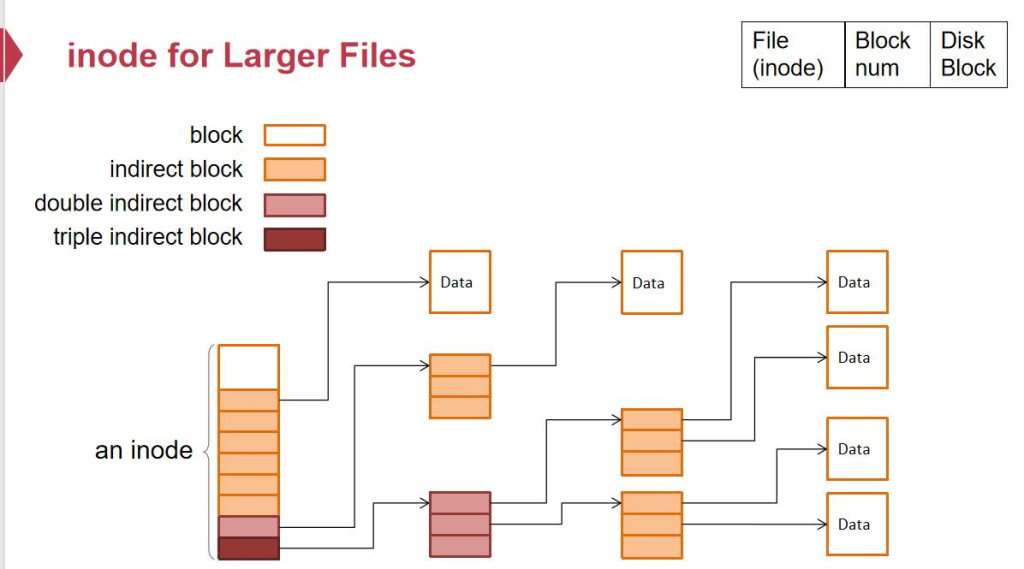

ه¦‚وœ N وک¯ 1000,و–‡ن»¶ه¤§ه°ڈوœ€ه¤ڑو‰چ 1000*4K,وک¾ç„¶وک¯ن¸چه¤ںçڑ„م€‚وˆ‘ن»¬ن¸چ能用ç؛؟و€§çڑ„و•°ç»„çڑ„è®°ه½• è؟™ن¸ھ block numberم€‚ه¦‚وœوˆ‘ن»¬وƒ³و”¯وŒپ 4G ه¤§ه°ڈçڑ„و–‡ن»¶ï¼Œé‚£ن¹ˆ 4G/4KB * 64B(ç£پç›کçڑ„ block_id çڑ„é•؟ه؛¦ï¼‰=8M,ن¸؛ن؛†و”¯وŒپن¸€ن¸ھ 4G çڑ„و–‡ن»¶ï¼Œه…‰وک¯هکه®ƒçڑ„ index ه°±è¦پ用هˆ° 8M,ه¦‚وœن¸€ن¸ھ Inode 8M, ه¦‚وœوˆ‘ن»¬ç”¨ن¸€هچٹçڑ„ç£پç›کهکè؟™ن¸ھ Inode,و¯”ه¦‚è؟™ن¸ھç£پç›ک 8T,用 4T و¥هک Inode,4T/8M = 50 ن¸‡ن¸ھ و–‡ن»¶م€‚وˆ‘ن»¬è®،ç®—وœ؛ن¸çڑ„و–‡ن»¶و¯«و— ç–‘é—®وک¯ç™¾ن¸‡ç؛§هˆ«ï¼Œوœ€ه¤§و”¯وŒپçڑ„و–‡ن»¶و‰چ 4G,è؟™ن؛›éƒ½و»،足ن¸چن؛† وˆ‘ن»¬çڑ„需و±‚م€‚

ه¦‚وœوˆ‘ن»¬çڑ„و–‡ن»¶و²،é‚£ن¹ˆه¤§ï¼Œوˆ‘ن»¬é¢„ç•™ن؛†ن¸€ن¸ھ 8M çڑ„ inode,ه°±وœ¬وœ«ه€’ç½®ن؛†م€‚وˆ‘ن»¬è¦پ预留 وˆگهڈ¯ن¼¸ç¼©çڑ„结و„م€‚وˆ‘ن»¬وٹٹو•°وچ®çڑ„ه‰چé¢ه‡ ن½چ设置وˆگوŒ‡هگ‘ block çڑ„م€‚هگژé¢ه‡ ن½چوŒ‡هگ‘ن¸€ن¸ھن؛Œç؛§çڑ„34 blockم€‚ه…¶ن¸و¯ڈن¸€é،¹éƒ½وک¯وŒ‡هگ‘ن¸€ن¸ھ block_indexم€‚ن؛Œç؛§çڑ„ block وک¯ 4k,و¯ڈن¸€é،¹وک¯ 8 ن¸ھ byte,هڈ¯ ن»¥وŒ‡هگ‘ 512 ن¸ھ blockم€‚è؟™ن¸ھه’Œé،µè،¨هپڑçڑ„ن؛‹وƒ…وک¯ه¾ˆهƒڈçڑ„م€‚ه¦‚وœن؛Œç؛§ن¹ں用و»،ن؛†ï¼Œوˆ‘ن»¬هڈ¯ن»¥ه†چهٹ ن¸€ ç؛§م€‚é‚£ن¹ˆه°±وک¯ 512*512 ن¸ھوŒ‡هگ‘ block çڑ„ block_indexم€‚è؟™و ·ه¯¹ن؛ژه°ڈو–‡ن»¶ï¼Œه°±هڈھ需è¦پ用هˆ°ه‰چé¢ه‡ ن¸ھم€‚ه¯¹ن؛ژه¤§و–‡ن»¶ه°±هڈ¯ن»¥ن¸€ç‚¹ç‚¹ه¢é•؟ه‡؛و¥م€‚

ه¯¹ن؛ژ layer2,ه…¶ن¸هڈ¯ن»¥ن½œن¸؛ double indirect block ه’Œ triple indirect block ه¯¹ن؛ژ第ن¸€ه±‚و¥è¯´ وک¯و— و‰€è°“çڑ„م€‚

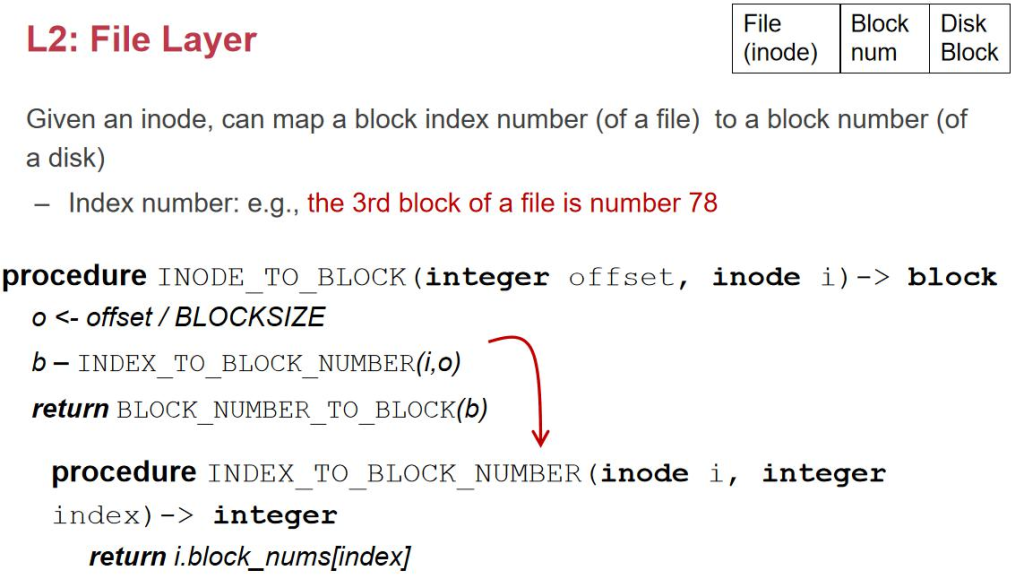

وœ‰ن؛†ç¬¬ن؛Œه±‚ن¹‹هگژ,ه°±وœ‰ن؛† inodeم€‚é،µè،¨çڑ„è¯و‰€وœ‰ç»ںن¸€وک¯ 4 ç؛§é،µè،¨م€‚è¦پ解ه†³çڑ„وœ¬è´¨é—®é¢که…¶ ه®ه°±وک¯وک ه°„م€‚وœ‰ن؛†ç¬¬ن؛Œه±‚ن¹‹هگژ,هڈھè¦په‘ٹ诉وˆ‘ن»¬ inode هœ¨ه“ھ,ه’Œéœ€è¦پو•°وچ®هœ¨و–‡ن»¶ن¸çڑ„ offset, وˆ‘ن»¬ه°±هڈ¯ن»¥و‰¾هˆ°ه¯¹ه؛” block هœ¨ه“ھ,è؟”ه›ç»™ç”¨وˆ·م€‚

Inode Number Layer

ن»¥è®°ه½•ن¸€ن¸ھ free çڑ„ inode çڑ„链 è،¨ن¸²èµ·و¥م€‚

و‰€ن»¥ç»™ن؛†ن¸€ن¸ھ Inode number ه°±هڈ¯ن»¥ه¾—هˆ°و–‡ن»¶çڑ„و‰€وœ‰ن؟،وپ¯م€‚è؟™ه¯¹èژ·هڈ–و–‡ن»¶وک¯è¶³ه¤ںçڑ„,ن½†وک¯ه®ƒه¯¹ن؛ژن؛؛ç±»وک¯و¯”较éڑ¾çڑ„م€‚而ن¸” copy çڑ„و—¶ه€™ï¼Œinode-number وک¯ن¼ڑهڈکهٹ¨çڑ„

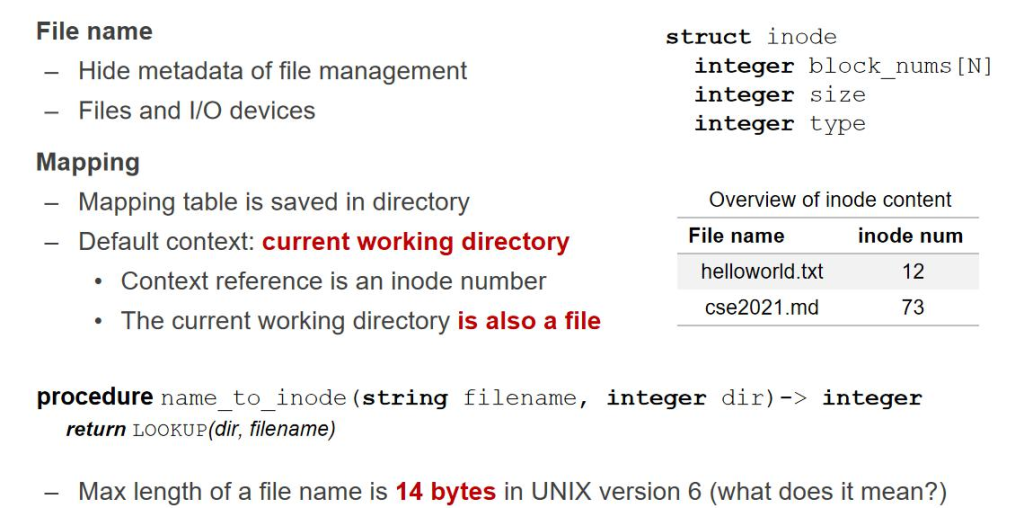

File Name Layer

第ه››ه±‚,وˆ‘ن»¬éœ€è¦پن¸€ن¸ھ user-friendly çڑ„ name,و€ژن¹ˆوٹٹه—符ن¸²ه’Œ inode-number هپڑن¸€ ن¸ھوک ه°„ه‘¢ï¼Œوœ€ç®€هچ•و•°وچ®ç»“و„ه°±وک¯ن¸€ن¸ھ dict وک ه°„م€‚

è؟™ن¸ھè،¨وœ€هگژهœ¨ç،¬ç›کن¸ٹه°±وک¯è؟™ن¹ˆهکçڑ„,ه®ƒهکهœ¨ن¸€ن¸ھو–‡ن»¶é‡Œï¼Œه®ƒوک¯و–‡ن»¶ç³»ç»ں规ه®ڑçڑ„و ¼ه¼ڈ,è؟™ ن¸ھو–‡ن»¶ه°±هڈ«هپڑç›®ه½•م€‚ن¹ںه°±وک¯é‡Œé¢و–‡ن»¶çڑ„هگچه—وک¯ن»€ن¹ˆï¼Œو–‡ن»¶çڑ„ inode-number وک¯ه¤ڑه°‘م€‚Foulder è؟™ن¸ھè¯چوک¯ه¾ˆè¯¯ه¯¼çڑ„,è؟™ن¸ھو–‡ن»¶ه¤¹هڈھوک¯هŒ…هگ«ن؛†ه…¶ن¸و–‡ن»¶çڑ„ inode-numer,而ن¸چوک¯هŒ…هگ«ن؛†و‰€وœ‰و–‡ ن»¶ه†…ه®¹م€‚و‰€ن»¥وˆ‘ن»¬ه€¾هگ‘用目ه½•è؟™ن¸ھè¯چ,و›´هٹ ه‡†ç،®م€‚

è®؟é—®و–‡ن»¶و–¹ه¼ڈï¼ڑç»™ن¸€ن¸ھو–‡ن»¶هگچ,给ن¸€ن¸ھç›®ه½•ï¼Œهژ»ç›®ه½•é‡Œو‰¾è؟™ن¸ھو–‡ن»¶هگچ,و‰¾هˆ°ه¯¹ه؛”çڑ„ Inode-number,ه°±هڈ¯ن»¥ه†چو‰¾هˆ°و–‡ن»¶ن؛†م€‚

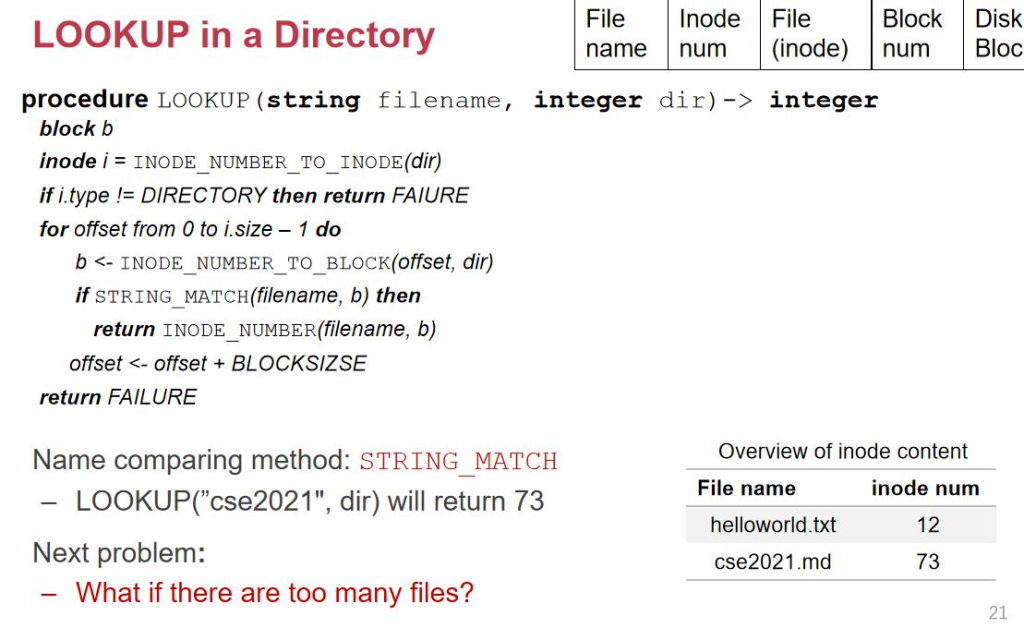

è؟™و ·ه°±ن؛§ç”ںن؛† lookup çڑ„و–¹ه¼ڈï¼ڑ

هˆ°è؟™ن¸€و¥ن¸؛و¢ï¼Œو•´ن¸ھو–‡ن»¶ç³»ç»ں都ه®Œه¤‡ن؛†ï¼Œو¯ڈن¸ھو–‡ن»¶éƒ½وœ‰ن¸€ن¸ھه—符ن¸²çڑ„و–‡ن»¶هگچم€‚ن½†وک¯è؟کوœ‰ ç¼؛点,وˆ‘ن»¬çژ°هœ¨هڈھوœ‰ن¸€ن¸ھç›®ه½•ï¼Œè؟™ن¸ھç›®ه½•ن¸‹وœ‰ه¾ˆه¤ڑه¾ˆه¤ڑو–‡ن»¶ï¼ˆه‡ 百ن¸‡ن¸ھ),ls وœ‰ه¥½ه‡ ن¸ھه±ڈه¹•ï¼Œ 都ن¸چ能é‡چهگچçڑ„م€‚و‰€ن»¥وˆ‘ن»¬ه؛”该وœ‰ن¸€ن¸ھ path name ه±‚,ه¦‚وœç›®ه½•ن¹ںه½“هپڑن¸€ن¸ھو–‡ن»¶ï¼Œé‚£ن¹ˆç›®ه½•ه°± هڈ¯ن»¥è¢«هŒ…هگ«هœ¨هڈ¦ن¸€ن¸ھو–‡ن»¶é‡Œé¢م€‚ç›®ه½•ن¹ںوœ‰ن¸€ن¸ھ Inode-number,目ه½•ه’Œو–‡ن»¶هœ¨ inode è؟™ن¸€ه±‚وک¯ و²،وœ‰هŒ؛هˆ«çڑ„م€‚ه°±هƒڈ inode ه’Œ data هœ¨ن¸‹ه±‚都وک¯ block ن¸€و ·م€‚

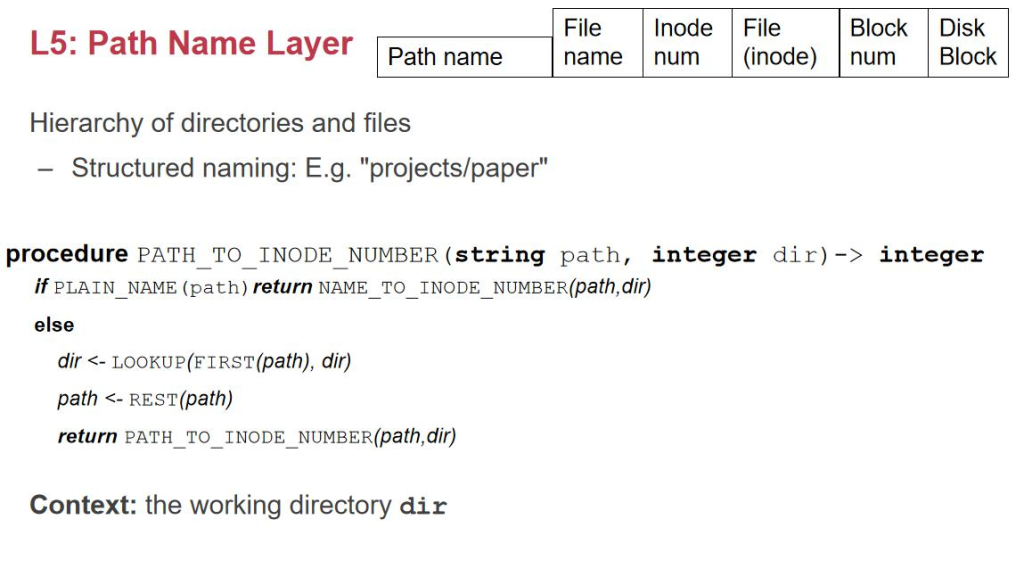

Path Name Layer

و—¢ç„¶ن¸چهŒ؛هˆ†ï¼Œوˆ‘ن»¬ه°±هڈ¯ن»¥وœ‰ن؛† path name,وˆ‘ن»¬هڈ¯ن»¥هˆ›ه»؛ projects/paper,وˆ‘ن»¬ه…ˆهژ»ه½“ه‰چ ç›®ه½•ن¸‹و‰¾ projects,و‰¾هˆ°ن»¥هگژه†چن»¥ projects ن¸؛ç›®ه½•و‰¾ paperم€‚

وژ¥ن¸‹و¥ن¸€ن¸ھé—®é¢که°±وک¯ç›®ه½•هگچه¤ھو·±ن؛†ï¼Œè¦پو‰“ه¥½ه‡ ه±‚ç›®ه½•م€‚هœ¨وˆ‘ن»¬ه‰چé¢è¯´çڑ„ç›®ه½•ç»“و„里é¢ï¼Œ ه¹¶و²،وœ‰ن»»ن½•هœ°و–¹ç»„织وˆ‘ن»¬وٹٹن¸€ن¸ھو–‡ن»¶هگچه¯¹ه؛”çڑ„ inode-number 设置وˆگهگŒن¸€ن¸ھم€‚ن¹ںه°±وک¯ن¸چهگŒو–‡ن»¶هگچه¯¹ه؛”هˆ°هگŒن¸€ن¸ھ inode-numberم€‚ه¦‚وœوˆ‘ن»¬ن¸؛ن¸€ن¸ھ inode هˆ›ه»؛ه¤ڑن¸ھ name,وˆ‘ن»¬ه°±هڈ¯ن»¥ن¸؛ن¸€ ن¸ھه¾ˆو·±ç›®ه½•çڑ„و–‡ن»¶هگچهˆ›ه»؛ن¸€ن¸ھه¾ˆçںçڑ„و–‡ن»¶هگچ,وœ€هگژه¯¹ه؛”çڑ„ inode وک¯ن¸€ن¸ھم€‚说وکژè؟™ن¸ھو–‡ن»¶هڈھوœ‰ن¸€ن¸ھم€‚

هپ‡è®¾ن¸€ن¸ھو–‡ن»¶وœ‰ن¸¤ن¸ھهگچه—,ه½“وˆ‘ن»¬هˆ وژ‰ن¸€ن¸ھهگچه—çڑ„و—¶ه€™ï¼Œç”¨هڈ¦ن¸€ن¸ھهژ»è®؟é—®وک¯èƒ½è®؟é—®è؟کوک¯ ن¸چ能è®؟é—®ه‘¢ï¼ں

ن»€ن¹ˆوک¯هˆ و–‡ن»¶ï¼ڑوœ¬è´¨و“چن½œهڈھوک¯هˆ 除目ه½•ن¸çڑ„helloworld.txt -> 12هˆ 除وژ‰ï¼Œه¹¶ن¸چوک¯هˆ 除block ن¸çڑ„و•°وچ®ï¼Œه› ن¸؛هڈ¯èƒ½هˆ«çڑ„هœ°و–¹è؟که¼•ç”¨ن؛†م€‚و‰€ن»¥وˆ‘ن»¬è¦پهœ¨ inode ن¸ç»´وٹ¤ن¸€ن¸ھ reference counter, ه¦‚وœهˆ 除ه®Œ reference counter == 0 ه°±هڈ¯ن»¥هˆ 除ن؛†م€‚هگŒو—¶وˆ‘ن»¬è؟ک需è¦پهٹ ن¸€ن¸ھ type و¥و ‡è¯†وک¯ن¸€ن¸ھ و™®é€ڑو–‡ن»¶è؟کوک¯ç›®ه½•م€‚

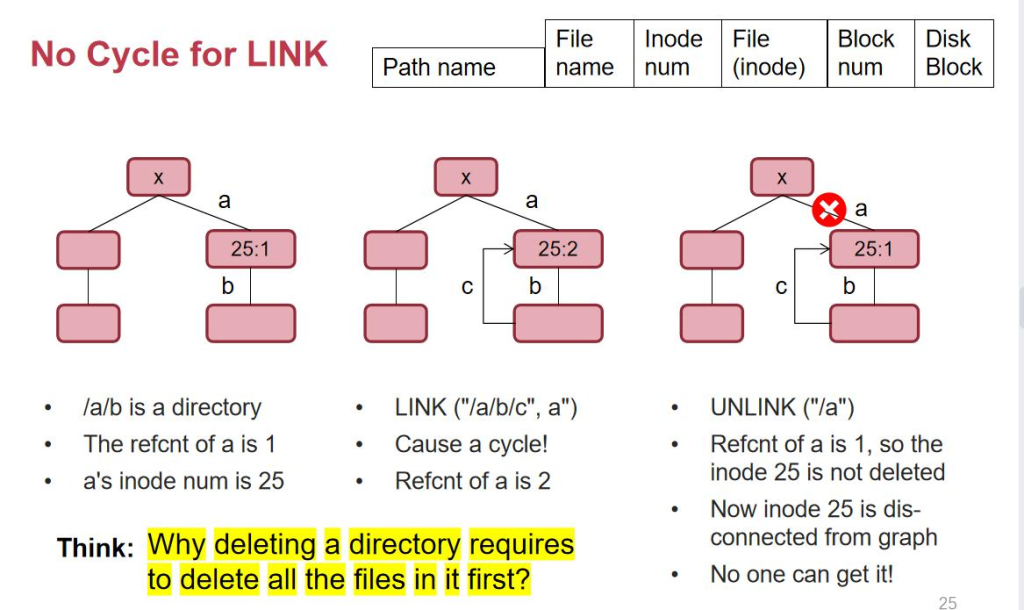

هپ‡è®¾ inode وœ‰ن¸ھ x,记ه½•ن؛†ç›®ه½• a,目ه½• a ن¸è®°ه½•ن؛†ç›®ه½• bم€‚هپ‡è®¾وˆ‘ن»¬çژ°هœ¨و¥ link وٹٹ/a/b/c ه¯¹ ه؛”هˆ°/a,ن¹ںه°±وک¯هœ¨ a çڑ„هگç›®ه½•ن¸‹ه»؛ç«‹ن؛†ن¸€ن¸ھوŒ‡هگ‘ a çڑ„ linkم€‚a çژ°هœ¨وœ‰ن¸¤ن¸ھن؛؛وŒ‡هگ‘ه®ƒï¼Œن¹ںه°±وک¯ /a ه’Œ/a/b/c,ه®ƒçڑ„ ref count وک¯ 2م€‚çژ°هœ¨وˆ‘ن»¬ه°è¯•هˆ 除/a,ه®ƒçڑ„ ref وک¯ 1,ن½†وک¯ن»ژ x ه†چن¹ںو‰¾ن¸چهˆ° a ن؛†م€‚ه› ن¸؛ه®ƒه”¯ن¸€çڑ„هگچه—被هˆ 除ن؛†م€‚ه®ƒو—¢و²،وœ‰è¢«هˆ وژ‰ï¼Œهڈˆن¸چ能被هڈ¦ه¤–çڑ„هœ°و–¹è®؟é—®هˆ°م€‚و‰€ن»¥ه°± ن¼ڑوˆگن¸؛ه†…هکهƒهœ¾م€‚و‰€ن»¥ç¦پو¢وŒ‡هگ‘ç›®ه½•م€‚

ه½“وˆ‘ن»¬هˆ 除ن¸€ن¸ھéç©؛ç›®ه½•çڑ„و—¶ه€™ï¼Œه…¶ه®وˆ‘ن»¬وک¯é€’ه½’هˆ 除çڑ„,هœ¨çœںه®çڑ„ linux 里é¢ï¼Œوˆ‘ن»¬ ه·²ç»ڈ考虑ن؛†è؟™ن¸ھé—®é¢کن؛†ï¼Œن½†è؟™ن¸ھ rm -r هœ¨ unix 第 6 版وک¯ن¸چهکهœ¨çڑ„م€‚

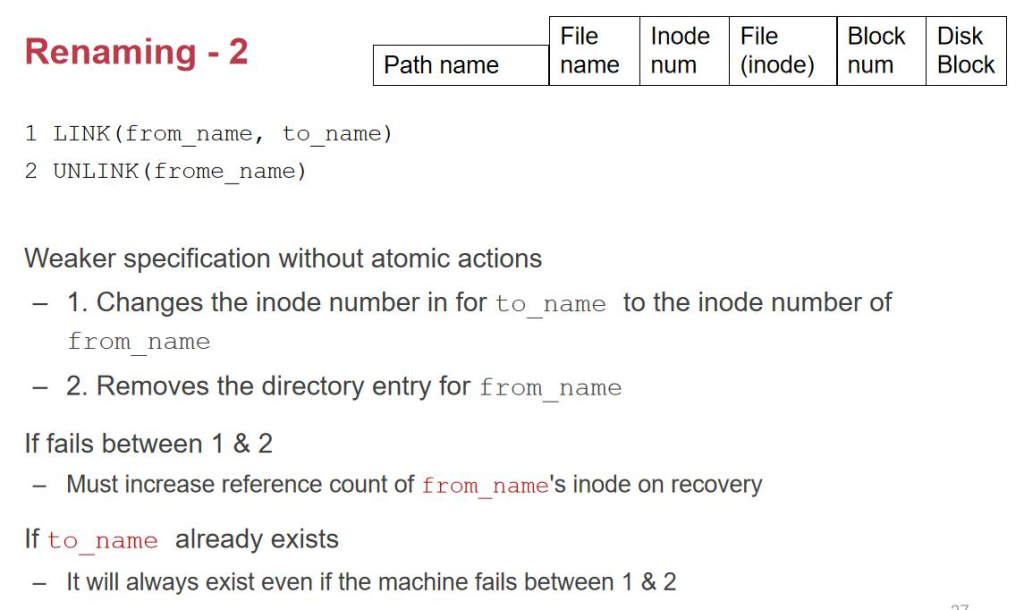

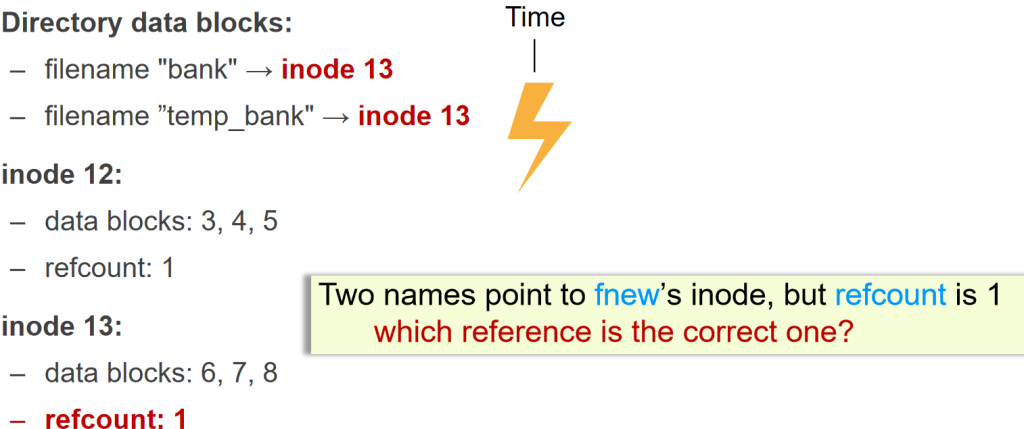

ه½“وˆ‘ن»¬هژ» rename çڑ„و—¶ه€™ï¼Œو”¹و–‡ن»¶هگچوک¯و–‡ن»¶ç³»ç»ںن¸éه¸¸ه¤چو‚çڑ„ن؛‹وƒ…م€‚هپ‡è®¾وˆ‘ن»¬è¦پهژ»هپڑو”¹ و–‡ن»¶هگچçڑ„و“چن½œï¼Œو¯”ه¦‚ mv (from,to),è؟™ن¸€ن¸ھوŒ‡ن»¤ç‰µو¶‰هˆ° 3 ن»¶ن؛‹وƒ…م€‚

- 1. وٹٹ to هˆ ن؛†ï¼Œto çڑ„ ref count هڈکوˆگ 0.

- 2. وٹٹ from هٹ ن¸€ن¸ھ to çڑ„هگچه—,from çڑ„ ref count هڈکوˆگ 2.

- 3. ه†چوٹٹ from çڑ„ ref count هڈکوˆگ 1

هœ¨è؟™ن¸ھè؟‡ç¨‹ن¸ن¸€و—¦هڈ‘ç”ںن؛†ن¸€و¬، crashم€‚و¯”ه¦‚هœ¨ 1 ه’Œ 2 ن¹‹é—´هڈ‘ç”ںن؛†و–电,وˆ‘ن»¬هڈ‘çژ°ه°‘ن؛† to è؟™ن¸ھو–‡ن»¶م€‚و‰€ن»¥è؟™ه°±وک¯وˆ‘ن»¬ atomic(هژںهگو€§ï¼‰çڑ„é—®é¢کم€‚هژںهگو€§ه°±وک¯ن¸چç®،ن¸é—´و–电çڑ„ن»€ن¹ˆوƒ…ه†µï¼Œ ه›ه¤چهˆ°و£ه¸¸وƒ…ه†µن»¥هگژ,è¦پن¹ˆه°±وک¯ه…¨هپڑ,è¦پن¹ˆه°±وک¯و²،هپڑ,ن¸چهکهœ¨ن¸é—´çڑ„وƒ…ه†µم€‚

Absolute Path Name Layer

وœ‰ن؛†è؟™ن¸ھن¹‹هگژ,وˆ‘ن»¬çژ°هœ¨وœ‰ن؛†ç›®ه½•ن؛†ï¼Œن¸€هڈ°وœ؛ه™¨وœ‰ه¾ˆه¤ڑن؛؛è¦پç™»ه½•ï¼Œوˆ‘ن»¬çœ‹هˆ°وˆ‘çڑ„و–‡ن»¶ï¼Œ38 ن½ 看هˆ°ن½ çڑ„و–‡ن»¶ï¼Œو–‡ن»¶ن¹‹é—´وک¯و²،وœ‰ن»»ن½•و–‡ن»¶و¸ éپ“هژ»و²ںé€ڑçڑ„م€‚ن¸؛ن؛†è§£ه†³è؟™ن¸ھé—®é¢ک,ه°±ه¼•ه…¥ن؛†و ¹ ç›®ه½•ï¼Œوœ‰ن؛†و ¹ç›®ه½•ن¹‹هگژ,ن¸€هڈ°وœ؛ه™¨ن¸ٹçڑ„و–‡ن»¶éƒ½هڈ¯ن»¥و ¹وچ®و ¹ç›®ه½•ه¼€ه§‹ç´¢ه¼•م€‚و ¹ç›®ه½•وœ€هگژه°±ه®ڑن¹‰ ن¸؛/,و ¹ç›®ه½•çڑ„.ه’Œ..都وŒ‡هگ‘ه®ƒè‡ھه·±م€‚

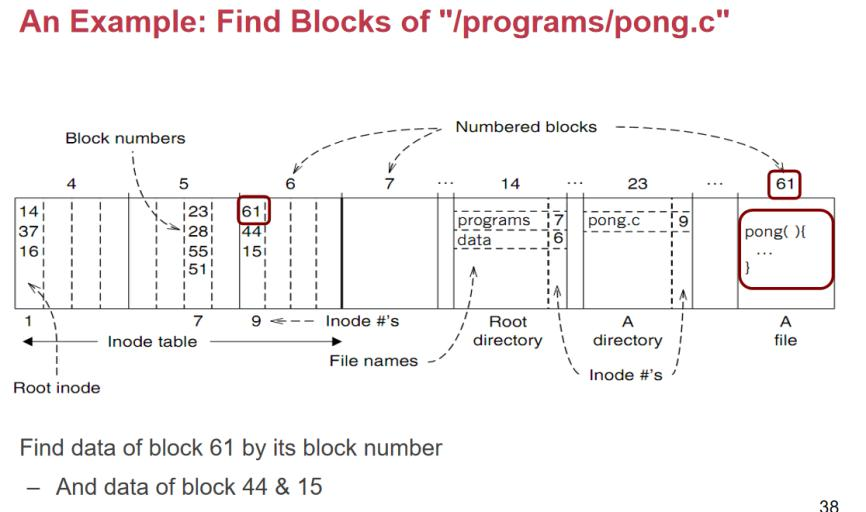

و•´ن¸ھè؟‡ç¨‹هˆ†ن¸؛ن»¥ن¸‹ه‡ ن¸ھو¥éھ¤ï¼Œو¸…و™°هœ°ه±•ç¤؛ن؛†ن»ژو ¹ç›®ه½•ه®ڑن½چهˆ° /programs/pong.c و–‡ن»¶çڑ„è·¯ه¾„解وگè؟‡ç¨‹ï¼ڑ

1. ه®ڑن½چو ¹ç›®ه½•

- و ¹ç›®ه½•çڑ„ç؛¦ه®ڑهœ°ه€ï¼ڑو ¹ç›®ه½•وک¯و–‡ن»¶ç³»ç»ںçڑ„起点,ه®ƒçڑ„ inode ç¼–هڈ·ç؛¦ه®ڑن¸؛ 1م€‚

- é€ڑè؟‡ super block و‰¾ inode tableï¼ڑو–‡ن»¶ç³»ç»ںçڑ„ super block ن¸è®°ه½•ن؛† inode table çڑ„èµ·ه§‹هœ°ه€م€‚وˆ‘ن»¬é€ڑè؟‡è؟™ن¸ھن؟،وپ¯و‰¾هˆ° inode tableم€‚

- و‰¾هˆ°و ¹ç›®ه½•çڑ„ inodeï¼ڑهœ¨ inode table ن¸ه®ڑن½چ inode ç¼–هڈ·ن¸؛ 1 çڑ„ inode و،目,读هڈ–ه…¶ه¯¹ه؛”çڑ„و•°وچ® blockم€‚

2. 解وگو ¹ç›®ه½•ه†…ه®¹

- 读هڈ– block 14ï¼ڑو ¹ç›®ه½•çڑ„ inode وŒ‡هگ‘çڑ„و•°وچ® block وک¯ block 14م€‚ه› و¤وˆ‘ن»¬è¯»هڈ– block 14 çڑ„ه†…ه®¹ï¼Œهڈ‘çژ°ه®ƒوک¯ن¸€ن¸ھç›®ه½•و–‡ن»¶م€‚

- ه®ڑن½چ

programsو،ç›®ï¼ڑهœ¨ block 14 ن¸ï¼Œو‰¾هˆ°هگچن¸؛programsçڑ„ç›®ه½•و،目,ه®ƒçڑ„ inode ç¼–هڈ·ن¸؛ 7م€‚

3. ه®ڑن½چ programs ç›®ه½•

- é€ڑè؟‡ inode table وں¥و‰¾ inode 7ï¼ڑه›هˆ° inode table,و‰¾هˆ°ç¬¬ 7 ن¸ھ inode و،ç›®م€‚

- 读هڈ– inode 7 وŒ‡هگ‘çڑ„و•°وچ®ه—ï¼ڑinode 7 وŒ‡هگ‘çڑ„و•°وچ®ه—وک¯ block 7,وˆ‘ن»¬è¯»هڈ–该 block çڑ„ه†…ه®¹م€‚

4. 解وگ programs ç›®ه½•

- ه®ڑن½چ

pong.cو،ç›®ï¼ڑهœ¨ block 7 çڑ„ه†…ه®¹ن¸ï¼Œو‰¾هˆ°هگچن¸؛pong.cçڑ„و–‡ن»¶و،目,ه®ƒçڑ„ inode ç¼–هڈ·ن¸؛ 9م€‚

5. ه®ڑن½چ pong.c و–‡ن»¶

- é€ڑè؟‡ inode table وں¥و‰¾ inode 9ï¼ڑه†چو¬،ه›هˆ° inode table,و‰¾هˆ°ç¬¬ 9 ن¸ھ inode و،ç›®م€‚

- 读هڈ– inode 9 وŒ‡هگ‘çڑ„و•°وچ®ه—ï¼ڑinode 9 وŒ‡هگ‘çڑ„و•°وچ®ه—وک¯ block 61م€‚

6. 读هڈ– pong.c و–‡ن»¶çڑ„ه†…ه®¹

- و‰¾هˆ° block 61ï¼ڑé€ڑè؟‡è¯»هڈ– block 61 çڑ„و•°وچ®ï¼Œوˆ‘ن»¬وœ€ç»ˆه¾—هˆ°ن؛†و–‡ن»¶

/programs/pong.cçڑ„ه†…ه®¹م€‚

و•´ن¸ھè·¯ه¾„解وگوک¯ن»ژو ¹ç›®ه½•ه¼€ه§‹ï¼Œن¾و¬،é€ڑè؟‡ inode ه’Œو•°وچ® block çڑ„وŒ‡é’ˆن¸چو–解وگو¯ڈن¸€ه±‚çڑ„ç›®ه½•ï¼Œç›´هˆ°وœ€ç»ˆه®ڑن½چهˆ°ç›®و ‡و–‡ن»¶çڑ„و•°وچ® block,ه®Œوˆگن؛†و–‡ن»¶è®؟é—®م€‚

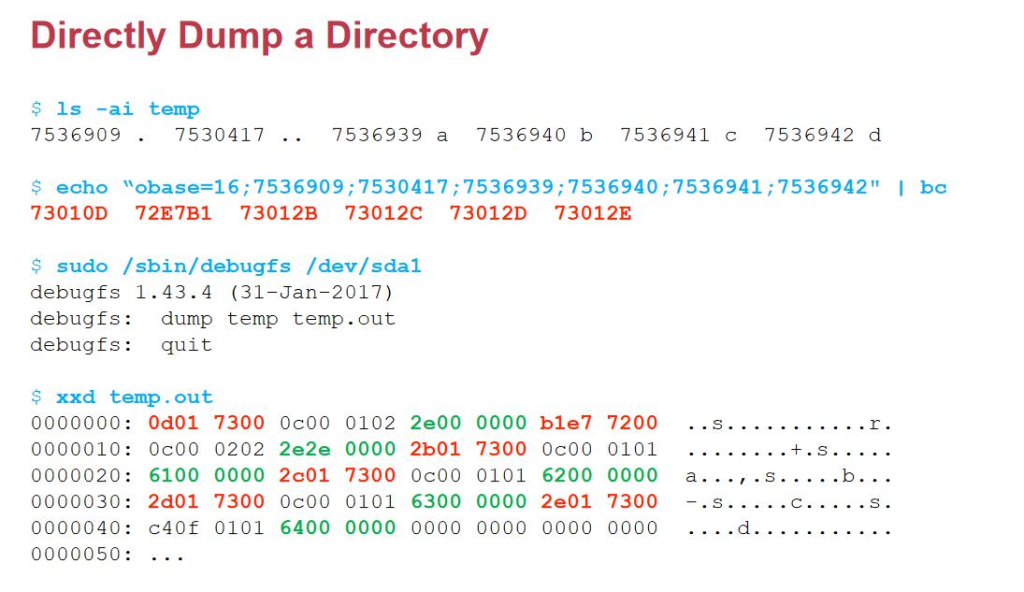

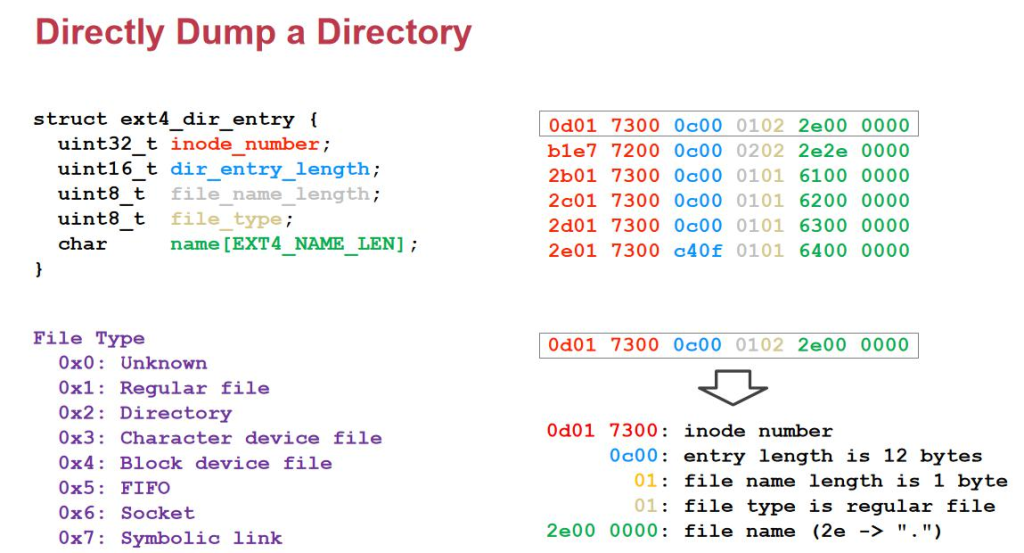

وˆ‘ن»¬هڈ¯ن»¥هˆ—ه‡؛ temp ç›®ه½•çڑ„ inode هڈ·وک¯ه¤ڑه°‘م€‚وˆ‘ن»¬هڈکوˆگ 16 è؟›هˆ¶ن»¥هگژه°±وک¯è؟™ن¸ھم€‚وˆ‘ن»¬هڈ¯ن»¥ç”¨ debug çڑ„و–¹ه¼ڈو‰“ه‡؛è؟™ن¸ھو–‡ن»¶م€‚è؟™ه°±وک¯ç›®ه½•هœ¨ç£پç›کن¸ٹçڑ„و•°وچ®م€‚

وˆ‘ن»¬é‡چو–°وژ’ه؛ڈهگژه°±هڈ¯ن»¥çœ‹ه‡؛,و¯ڈن¸€è،Œه¯¹ه؛”çڑ„ه°±وک¯و–‡ن»¶هگچم€‚2e ه°±وک¯.,2e2e ه°±وک¯..م€‚ 0102 ه°±وک¯ç›®ه½•çڑ„و„ڈو€م€‚0c00 ه°±وک¯é•؟ه؛¦م€‚c40f ه°±وک¯وœ€هگژن¸€é،¹هˆ°ه¤´ن؛†م€‚ه‰چé¢ç؛¢è‰²çڑ„部هˆ†ه°±وک¯ inode-numberم€‚وˆ‘ن»¬ه°±é€ڑè؟‡è؟™ن¸ھه®éھŒçœ‹هˆ°ن؛†è؟™ن¸ھçœںçڑ„ç›®ه½•é•؟è؟™ن¸ھو ·هگم€‚

وœ‰ن؛†ن¸‹é¢ن¸‰ه±‚ن¹‹هگژ, و•´ن¸ھو–‡ن»¶ç³»ç»ںه·²ç»ڈوˆگç«‹ن؛†ï¼Œن½†وک¯ه…‰ç”¨ inode-number هپڑهگچه—ن¸چوک¯ه¾ˆهڈ‹ه¥½م€‚و‰€ن»¥éœ€è¦پ用 inode ه’Œو–‡ن»¶هگچه¯¹ه؛”,وˆ‘ن»¬è®°ه½•هœ¨هچ•ç‹¬çڑ„ن¸€ن¸ھو–‡ن»¶é‡Œم€‚è؟™ن¸ھو–‡ن»¶ن¸چوک¯وˆ‘ن»¬éڑڈو„ڈهڈ¯ن»¥é€ڑè؟‡read-write ن؟®و”¹çڑ„,ه› ن¸؛è؟™ن¸ھو–‡ن»¶وک¯ن¸€ن¸ھç›®ه½•و–‡ن»¶م€‚ه®ƒه¯¹ن؛ژو–‡ن»¶ç³»ç»ںو¥è¯´وک¯ه…ƒو•°وچ®م€‚ه¯¹ن؛ژ Inode و¥è¯´ï¼Œ ç›®ه½•و‰€وœ‰çڑ„و•°وچ®éƒ½ن؟هکهœ¨و•°وچ®هŒ؛,ه’Œن¸€èˆ¬çڑ„و–‡ن»¶و²،ن»€ن¹ˆهŒ؛هˆ«م€‚ن½†وک¯ن»ژ用وˆ·çڑ„角ه؛¦و¥çœ‹ï¼Œç›®ه½•ه°±وک¯ن¸€ن¸ھه…ƒو•°وچ®ï¼Œن¸چ能é€ڑè؟‡open/read/write و¥ن؟®و”¹ç›®ه½•ï¼Œهڈھ能é€ڑè؟‡ lsم€‚然هگژوœ‰ن؛†ç›®ه½•ن¹‹هگژ, ه†چه¾€ن¸ٹ递ه½’هœ°و ‘çٹ¶ç»„织结و„م€‚وژ¥ن¸‹و¥è؟کوœ‰ link çڑ„و¦‚ه؟µï¼Œlink ه…¶ه®ه°±وک¯و–‡ن»¶هگچم€‚

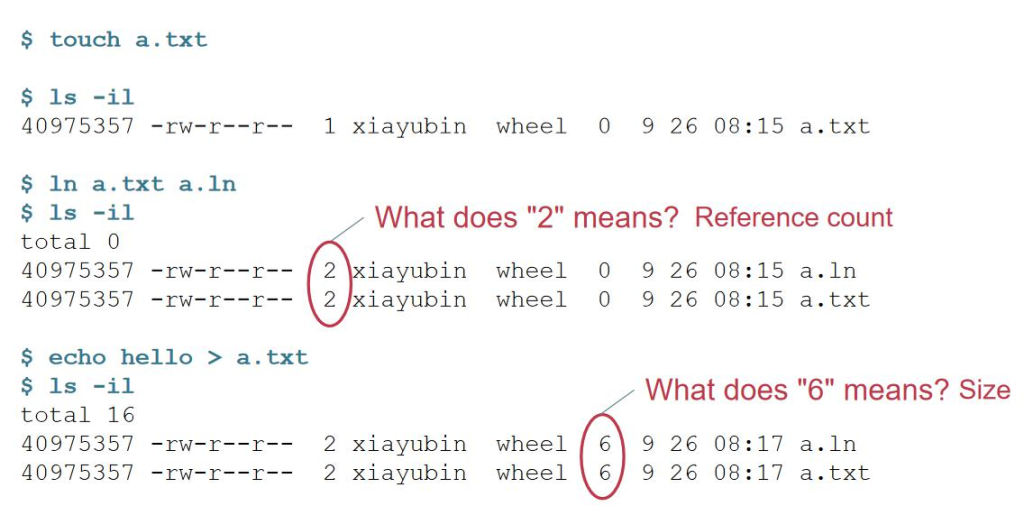

وˆ‘ن»¬هˆ›ه»؛ن¸€ن¸ھوŒ‡هگ‘ a.txt çڑ„ a.ln linkم€‚وˆ‘ن»¬هڈ‘çژ°çژ°هœ¨ه¤ڑن؛†ن¸€ن¸ھو–‡ن»¶ a.lnم€‚وˆ‘ن»¬هڈ‘çژ°ه®ƒن»¬çڑ„ و—¶é—´م€په¤§ه°ڈن¸€èµ·هڈکن؛†م€‚و‰€ن»¥ن¸ٹè؟°çڑ„ 2 وک¯ reference count,ه½“ ref cnt هڈکن¸؛ 0 çڑ„و—¶ه€™ï¼Œinode ه’Œ data ه°±ن¼ڑ被 free وژ‰م€‚6 ه°±وک¯و–‡ن»¶ size çڑ„ه¤§ه°ڈم€‚

ه½“وˆ‘ن»¬çں¥éپ“ link çڑ„و—¶ه€™ï¼Œه¦‚وœوˆ‘ن»¬çژ°هœ¨وڈ’ن؛†ن¸€ن¸ھ u ç›کهˆ°ن؛†ç”µè„‘ن¸م€‚ه¦‚وœوˆ‘ن»¬وƒ³هœ¨ن¸»وœ؛ن¸ هˆ›ه»؛ن¸€ن¸ھوŒ‡هگ‘ u ç›کçڑ„ link,è؟™وœ¬è؛«وک¯ن¸¤ن¸ھو–‡ن»¶ç³»ç»ں,inode-numberم€پspace 都وک¯ن¸چن¸€و ·çڑ„م€‚ وˆ‘ن»¬ن¸چ能直وژ¥ن½؟用 u ç›کو–‡ن»¶ç³»ç»ںن¸çڑ„ Inode-numberم€‚و‰€ن»¥ن¸چ能هˆ›ه»؛è·¨و–‡ن»¶ç³»ç»ںçڑ„ linkم€‚

Symbolic Link Layer

而第ن¸ƒه±‚ symbolic link layer,وˆ‘ن»¬هœ¨و–‡ن»¶ç³»ç»ںن¸هˆ›ه»؛ن؛†ن¸€ن¸ھو–°çڑ„و–‡ن»¶ï¼Œه†…ه®¹وک¯ن¸€ن¸ھه—符 ن¸²ï¼ŒوŒ‡هگ‘需è¦پ链وژ¥çڑ„و–‡ن»¶è·¯ه¾„ه’Œو–‡ن»¶هگچم€‚ه®ƒن¸چن¼ڑن»…ن»…هپœç•™هœ¨و‰“ه¼€ symbolic link وœ¬è؛«ï¼Œه®ƒن¼ڑ读 هڈ–ه‡؛و•°وچ®ï¼Œه¹¶ن¸”وŒ‡هگ‘è؟›ن¸€و¥çڑ„و“چن½œم€‚و‰€ن»¥هœ¨ inode_type ن¸è¦پو·»هٹ symbolic linkم€‚

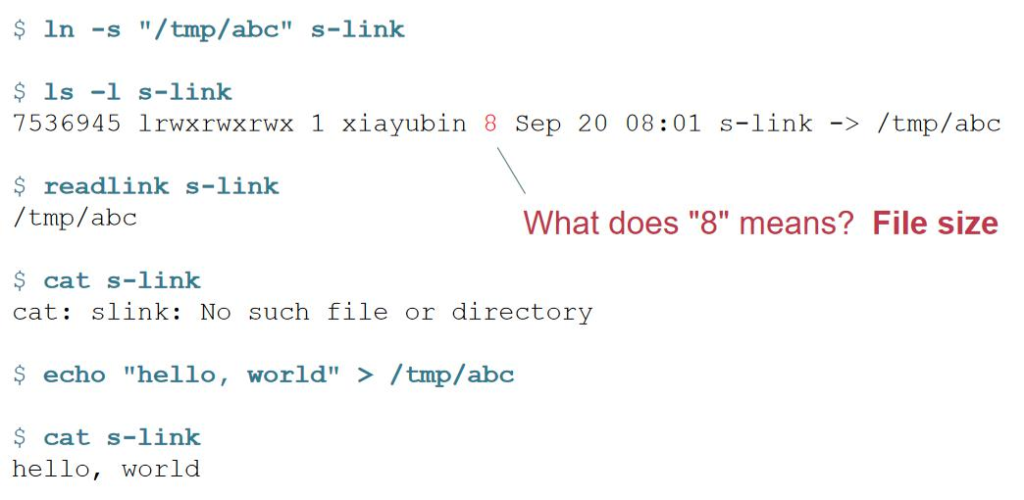

وˆ‘ن»¬هˆ›ه»؛ s-link çڑ„ن؟،وپ¯çڑ„و—¶ه€™ï¼Œوˆ‘ن»¬هڈ‘çژ°وک¯وŒ‡هگ‘/tmp/abc çڑ„م€‚وˆ‘ن»¬هڈ¯ن»¥é€ڑè؟‡ه‘½ن»¤ readlink و¥è¯»ه‡؛ symbolic link و–‡ن»¶çڑ„ه†…ه®¹م€‚8 وک¯/tmp/abc çڑ„ه¤§ه°ڈ,ه®ƒه…¶ه®ن¸چ需è¦پهژ»هک/0م€‚ه¦‚وœوˆ‘ن»¬ه° 试ن½؟用 cat و¥è¯»هڈ–و•°وچ®çڑ„و—¶ه€™ï¼Œن¼ڑوٹ¥é”™م€‚ه½“وˆ‘ن»¬وٹٹ hello, world é‡چه®ڑهگ‘هˆ°/tmp/abc çڑ„و—¶ه€™ï¼Œ و‰چن¼ڑ读هˆ° hello, worldم€‚و‰€ن»¥è؟™ن¸ھه‘ٹ诉وˆ‘ن»¬ه“ھو€•هژںه…ˆçڑ„è·¯ه¾„çڑ„و–‡ن»¶ن¸چهکهœ¨çڑ„è¯ï¼Œوˆ‘ن»¬ن¹ںهڈ¯ن»¥ن¸؛ é‚£ن¸ھن¸چهکهœ¨çڑ„و–‡ن»¶هˆ›ه»؛ن¸€ن¸ھ symbolic link,ن½†وک¯ه¯¹ن؛ژ hard link و¥è¯´ï¼Œوˆ‘ن»¬ن¸چ能ن¸؛ن¸چهکهœ¨çڑ„و–‡ ن»¶هˆ›ه»؛ن¸€ن¸ھ hard link,ه› ن¸؛ inode 都ن¸چهکهœ¨م€‚

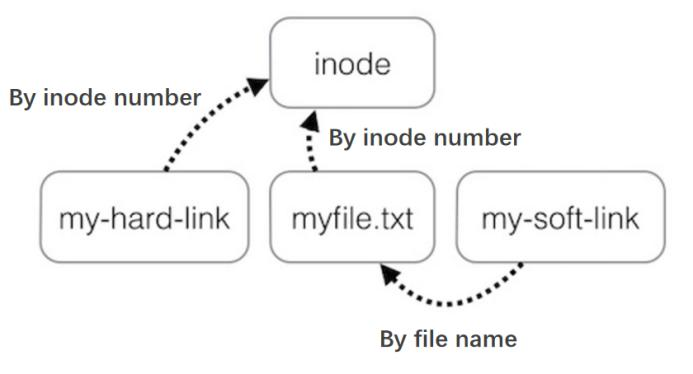

وˆ‘ن»¬هڈ¯ن»¥é€ڑè؟‡ن¸ٹه›¾و¥ه®،视ن¸€ن¸‹ hard link ه’Œ symbolic linkم€‚Hard link وک¯é€ڑè؟‡ inode-number 绑ه®ڑ,而 symbolic link(soft link)وک¯é€ڑè؟‡è·¯ه¾„ه’Œو–‡ن»¶هگچو¥ç»‘ه®ڑم€‚Symbolic link وک¯هڈ¯ن»¥وŒ‡هگ‘ç›®ه½•çڑ„, 而 hard link 除ن؛†.ه’Œ..وک¯ن¸چ能وŒ‡هگ‘ç›®ه½•çڑ„م€‚

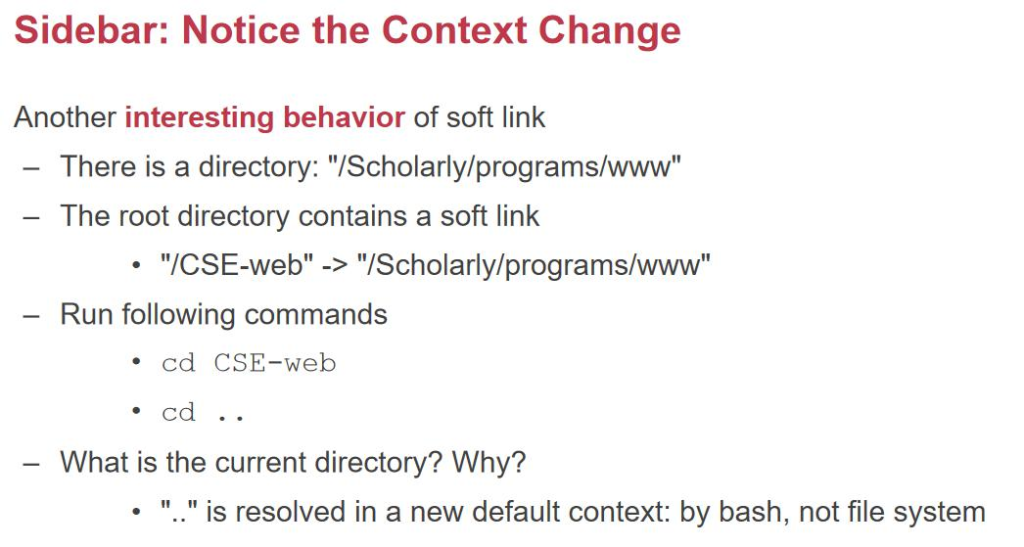

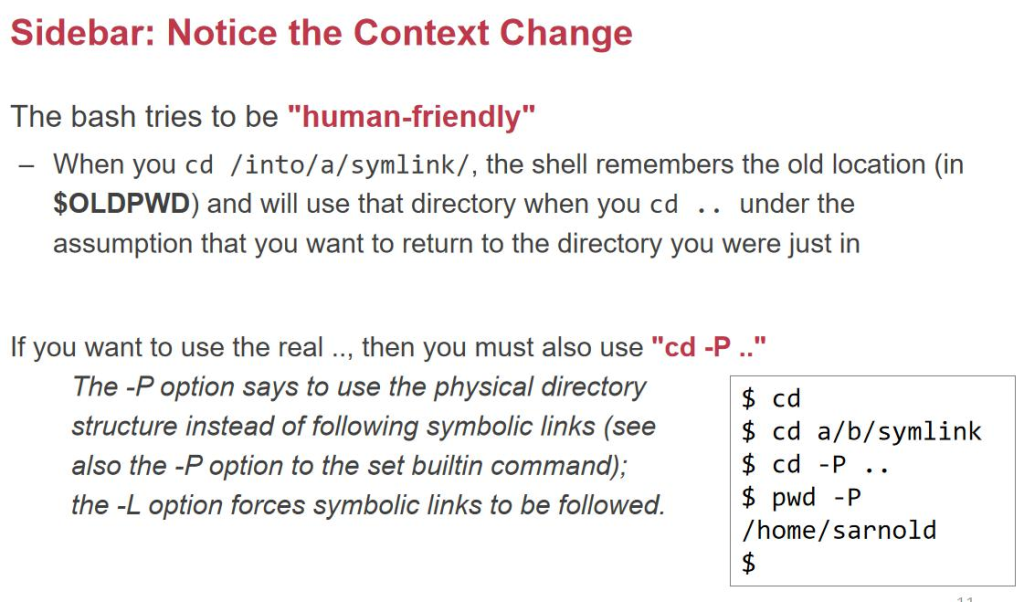

وœ‰ن¸€ن¸ھ/Scholarly/programs/www,وˆ‘ن»¬è§‰ه¾—ه¤ھé•؟ن؛†ï¼Œوˆ‘ن»¬هˆ›ه»؛ن¸€ن¸ھ symbolic link /CSE-webم€‚ وˆ‘ن»¬ن½؟用 cd CSE-web; cd ..; وˆ‘ن»¬ه› ن¸؛ç”و،ˆوک¯/Scholarly/programsم€‚ن؛‹ه®ن¸ٹ,ç”و،ˆوک¯و ¹ç›®ه½•م€‚

è؟™وک¯ bash è‡ھه·±هپڑçڑ„ن¼کهŒ–,ه®ƒè®¤ن¸؛è؟™و ·è·ں符هگˆç›´è§‰م€‚

وˆ‘ن»¬ç®€هچ•هپڑن¸€ن¸ھو€»ç»“,ه‰چé¢ 7 ه±‚里é¢وœ‰ه‡ ن¸ھه’Œç›´è§‰ن¸چ符هگˆçڑ„هœ°و–¹م€‚

1.و–‡ن»¶هگچه’Œو–‡ن»¶وک¯و²،وœ‰ه…³ç³»çڑ„م€‚و–‡ن»¶ç›¸ه…³çڑ„و•°وچ®هˆ†ن¸؛ه…ƒو•°وچ®ï¼ˆهکهœ¨ inode 里)ه’Œو•°وچ® (inode وŒ‡هگ‘ block ن¸ï¼‰م€‚而و–‡ن»¶هگچوک¯هکهœ¨ç›®ه½•é‡Œçڑ„م€‚و‰€ن»¥و–‡ن»¶çڑ„و–‡ن»¶هگچه’Œو–‡ن»¶ه¹¶و²،وœ‰ç›´وژ¥ çڑ„ه…³ç³»ï¼Œè؟™ن¹ںوک¯وˆ‘ن»¬هڈ¯ن»¥é€ڑè؟‡ hardlink ç»™ن¸€ن¸ھو–‡ن»¶èµ‹ن؛ˆه¤ڑن¸ھو–‡ن»¶هگچم€‚و‰€ن»¥ن»»ن½•ن¸€ن¸ھوŒ‡هگ‘ Inode çڑ„و–‡ن»¶هگچوک¯ç‰ن»·çڑ„,و–°هˆ›ه»؛çڑ„ hard link ه’Œهژںه…ˆçڑ„و–‡ن»¶ç´¢ه¼•وک¯ç‰ن»·çڑ„م€‚

2.ن»¥هڈٹç›®ه½•çڑ„ه¤§ه°ڈوک¯ه¾ˆه°ڈçڑ„,هڈھه’Œو–‡ن»¶هگچçڑ„é•؟çںوœ‰ه…³ç³»م€‚

讲ه®Œو–‡ن»¶çڑ„结و„ن»¥هگژ,وˆ‘ن»¬ه·²ç»ڈçں¥éپ“ن؛†ç£پç›کن¸é™و€پو–‡ن»¶وک¯و€ژن¹ˆç»„织çڑ„م€‚وˆ‘ن»¬وژ¥ن¸‹و¥çœ‹و–‡ ن»¶وک¯و€ژن¹ˆè¢«è¯»ه†™م€پè®؟é—®م€پهگŒو¥çڑ„م€‚

è؟™ن؛›و“چن½œéƒ½وک¯é€ڑè؟‡ system call çڑ„و–¹ه¼ڈوڈگن¾›ç»™ç”¨وˆ·çڑ„ه؛”用程ه؛ڈçڑ„م€‚而用وˆ·é€ڑه¸¸è؟کè¦پé€ڑè؟‡ lib42 çڑ„ه°پ装و¥è°ƒç”¨م€‚

وˆ‘ن»¬ن¹‹ه‰چه¦è؟‡ C,C وک¯ن¸چوک¯ن¸€ن¸ھè·¨ه¹³هڈ°çڑ„è¯è¨€ه‘¢ï¼ںوˆ‘ن»¬ include ن¸چهگŒه¤´و–‡ن»¶çڑ„و—¶ه€™ن¼ڑوœ‰ن¸چ هگŒçڑ„çژ¯ه¢ƒم€‚وˆ‘ن»¬ç”¨ C çڑ„ lib وک¯ fopen,هœ¨ linux ن¸‹وک¯ه¯¹ه؛”çڑ„ open çڑ„ syscallم€‚Fopen وک¯è؟”ه›ن¸€ن¸ھ file*,而 open وک¯è؟”ه›ن¸€ن¸ھ int çڑ„ syscallم€‚

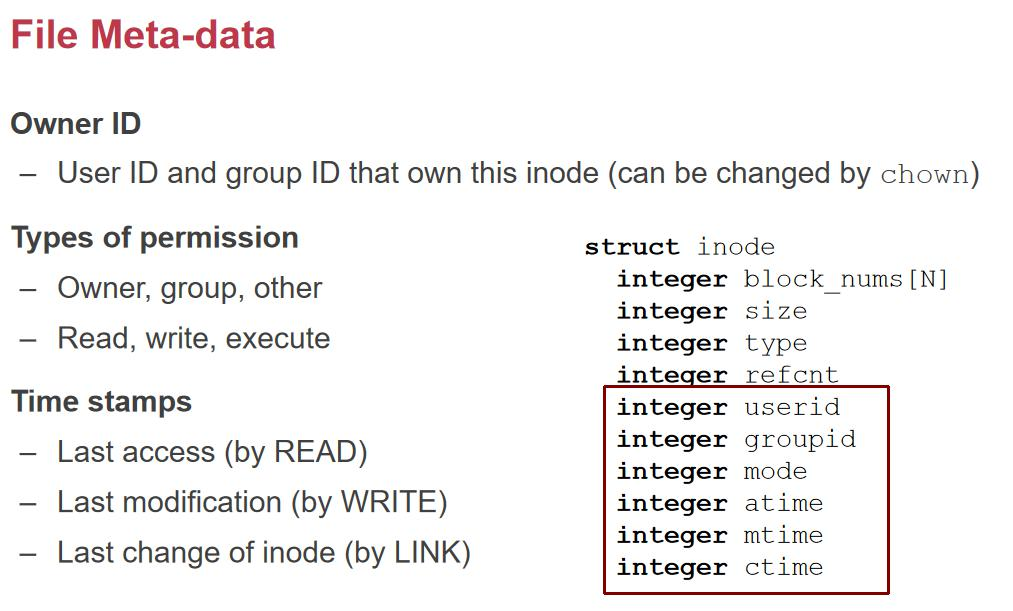

userid ه’Œ groupid هژ»هپڑè®؟é—®وژ§هˆ¶م€‚然هگژوک¯هڈ¯è¯»هڈ¯ه†™هڈ¯و‰§è،Œï¼Œè؟کè¦پن¸‰ن¸ھ time, last access, last modification, last change of inodeم€‚

Mtime 说çڑ„وک¯ data و”¹هٹ¨ï¼Œctime 说çڑ„وک¯ inode و”¹هٹ¨ï¼ˆlink و”¹هٹ¨ refcount,ن؟®و”¹وƒé™گ)م€‚

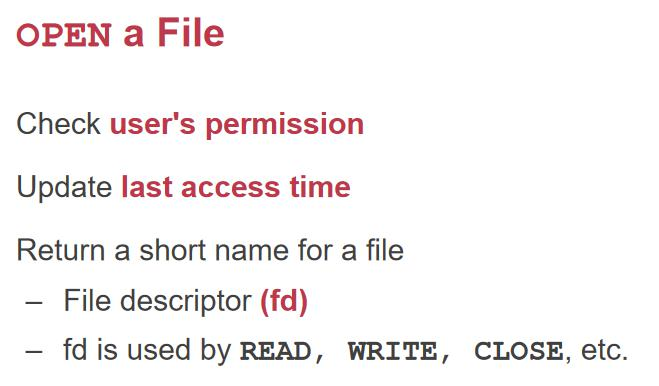

Open و–‡ن»¶çڑ„و—¶ه€™ï¼Œه…ˆè¦پ看و–‡ن»¶وک¯ه½’ه±ن؛ژه“ھن¸ھ用وˆ·çڑ„م€‚هŒ¹é…چ userid ه’Œ groupid,ه¦‚وœوƒ é™گن¸چهŒ¹é…چن¹ںن¸چن¼ڑ让ن½ و‰“ه¼€ï¼Œç„¶هگژو›´و–° last access timeم€‚然هگژè؟”ه›ن¸€ن¸ھ fd(و–‡ن»¶è¢«و‰“ه¼€ن¹‹هگژه°± ن¼ڑوœ‰ fd)م€‚

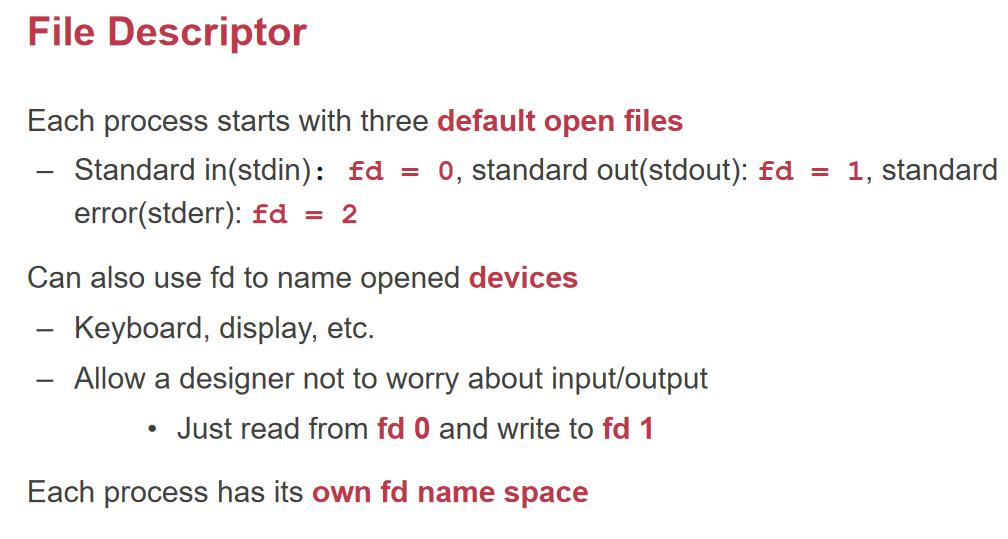

Fd هگŒو ·هڈ¯ن»¥è¢«ه‘½هگچو‰“ه¼€çڑ„设ه¤‡م€‚و¯”ه¦‚وˆ‘ن»¬و‰“ه¼€ن¸€ن¸ھé”®ç›کم€‚读çڑ„è¯ه°±وک¯ه¾—هˆ°é”®ç›کو£هœ¨è¾“ه…¥çڑ„ ه—و¯چم€‚و¯ڈن¸ھ process 都وœ‰وˆ‘ن»¬è‡ھه·±çڑ„ fd namesapceم€‚çژ°هœ¨وڈگن¸€ن¸ھé—®é¢کم€‚ن¸؛ن»€ن¹ˆوˆ‘ن»¬è¦پ用 fd و¥ ن½œن¸؛è؟”ه›çڑ„و–‡ن»¶ه‘¢ï¼ںن¸؛ن»€ن¹ˆن¸چè؟”ه› Inode 给用وˆ·ه‘¢ï¼ں

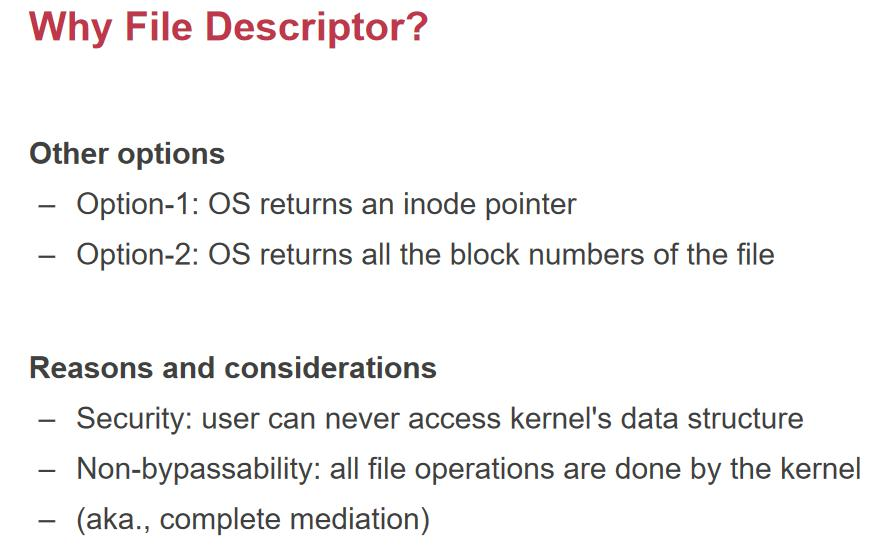

وˆ‘ن»¬ه¸Œوœ›ç”¨وˆ·ن¸چ能è®؟é—®ه†…و ¸çڑ„و•°وچ®ç»“و„,ه¦‚وœوˆ‘ن»¬ç›´وژ¥è؟”ه› inode çڑ„وŒ‡é’ˆï¼Œé‚£ن¹ˆه°±وٹٹه†… و ¸و•°وچ®ç›´وژ¥وڑ´éœ²ç»™ç”¨وˆ·ن؛†م€‚Non-byassability: inode وŒ‡é’ˆهڈ¯èƒ½ç»•è؟‡ open,ه› ن¸؛ open çڑ„و—¶ه€™و‹؟ هˆ°çڑ„وک¯ن¸€ن¸ھو–‡ن»¶هگچ,ن¹‹هگژه†چè؟”ه› fdم€‚ن½†وک¯ه¦‚وœوˆ‘ن»¬è؟”ه›çڑ„وک¯ inode,第ن؛Œو¬،ن¹‹هگژçڑ„ Open ه°± هڈ¯ن»¥éڑڈو—¶éڑڈهœ°و‹؟第ن¸€و¬،çڑ„ Inode è؟”ه›çڑ„وŒ‡é’ˆهژ»ç”¨ن؛†ï¼Œهڈ¯ن»¥ç»•è؟‡ OS هœ¨ open çڑ„و—¶ه€™çڑ„وƒé™گو£€وں¥م€‚ è؟™و ·ه؛”用程ه؛ڈه°±و²،وœ‰ن»»ن½•éƒ¨هˆ†ç»•è؟‡وƒé™گو£€وں¥م€‚

Fd è؟کè®°ه½•ن؛† cursor,ن¹ںه°±وک¯ه½“ه‰چçڑ„و–‡ن»¶م€‚

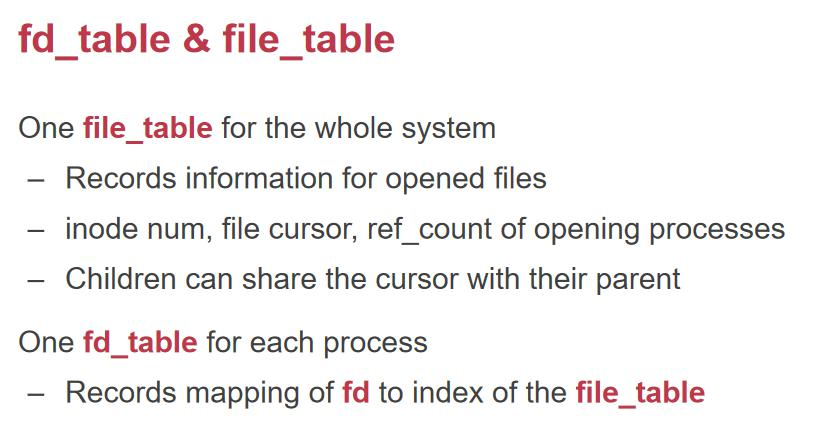

File_table وک¯و•´ن¸ھç³»ç»ںن¸€ه¼ è،¨ï¼Œè€Œ fd_table وک¯ن¸€ن¸ھè؟›ç¨‹ن¸€ه¼ è،¨م€‚

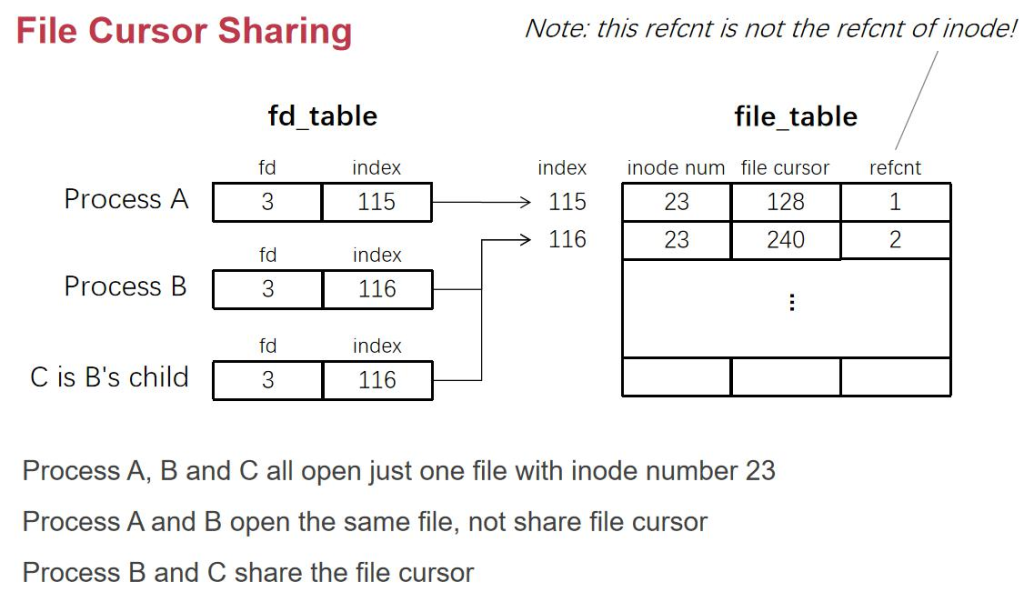

ن¸چهگŒè؟›ç¨‹ن¸çڑ„ fd_table,ه“ھو€• fd 相هگŒï¼ŒوŒ‡هگ‘çڑ„ file_table ن¸çڑ„ن½چç½®وک¯ن¸چن¸€و ·çڑ„م€‚C وک¯ B fork ه‡؛و¥çڑ„,继و‰؟ن؛†و‰€وœ‰و•°وچ®م€‚وچ¢هڈ¥è¯è¯´ï¼Œن¸¤ن¸ھè؟›ç¨‹و—¢هڈ¯ن»¥ه…±ن؛« fd_table(file cursor 相هگŒï¼‰ï¼Œن¹ں هڈ¯ن»¥ن¸چه…±ن؛«ï¼ˆç‹¬ç«‹ file_cursor)م€‚

ه®é™…ن¸ٹوˆ‘ن»¬هœ¨ print çڑ„و—¶ه€™ï¼Œه°±ن¼ڑéپ‡هˆ°ه…±ن؛« fd_table çڑ„وƒ…ه†µï¼Œه¦‚وœن¸چه…±ن؛«ï¼Œchild process هڈ¯èƒ½ه°±وٹٹ parent process çڑ„输ه‡؛覆盖وژ‰م€‚ و³¨و„ڈ file_table 里çڑ„ ref count وک¯è،¨ç¤؛ه¤ڑوœ‰ه°‘ن¸ھ fd وŒ‡هگ‘ه®ƒم€‚

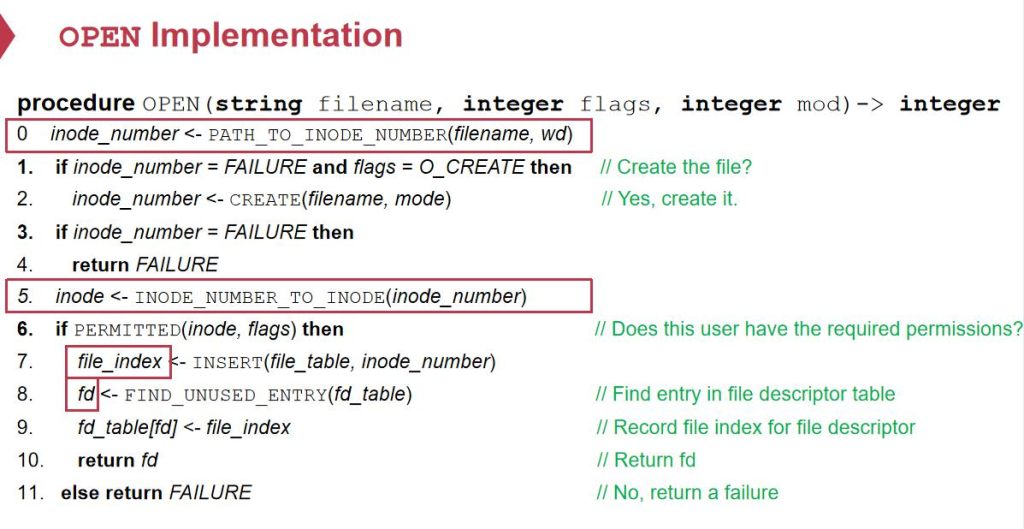

و³¨و„ڈ FIND_UNUSED_ENTRY,وک¯é€‰و‹©ه½“ه‰چو²،وœ‰ç”¨è؟‡çڑ„ fd ن¸وœ€ه°ڈçڑ„ن¸€ن¸ھم€‚ وژ¥ن¸‹و¥وˆ‘ن»¬çœ‹ه®é™…çڑ„ç£پç›کن¸ٹçڑ„结و„ï¼ڑ

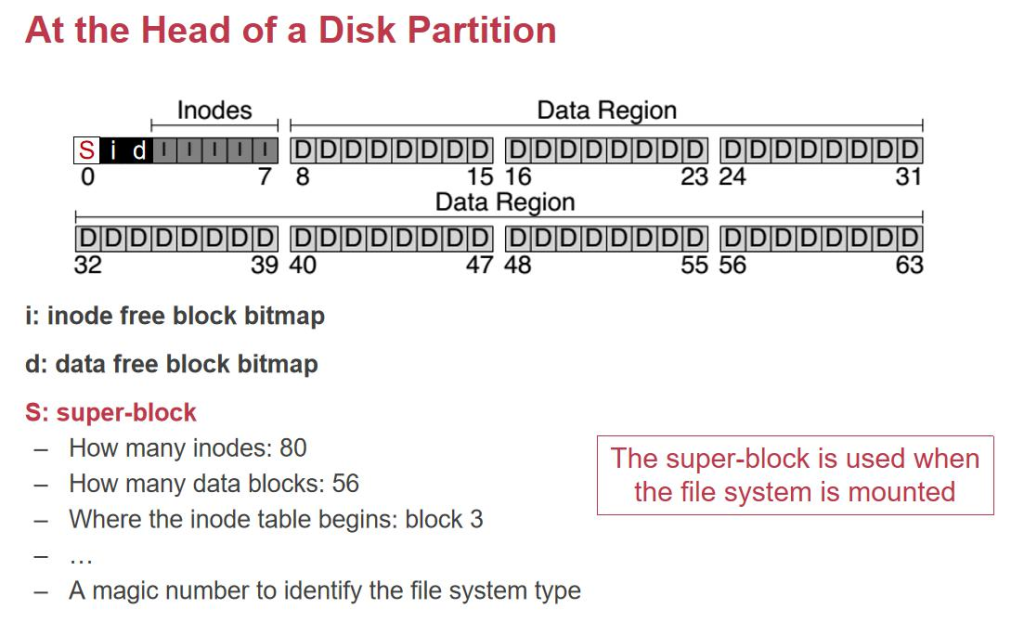

هœ¨ç£پç›کçڑ„ه¤´éƒ¨وˆ‘ن»¬و”¾ن¸€ن¸ھ:free inode bitmap,è؟کوœ‰ن¸€ن¸ھ data bitmap,وœ€ه¤´ن¸ٹوک¯ن¸€ن¸ھ Superblock,ه…¶ن¸è®°ه½•ن؛†ن¸€ن؛›ه…ƒو•°وچ®م€‚

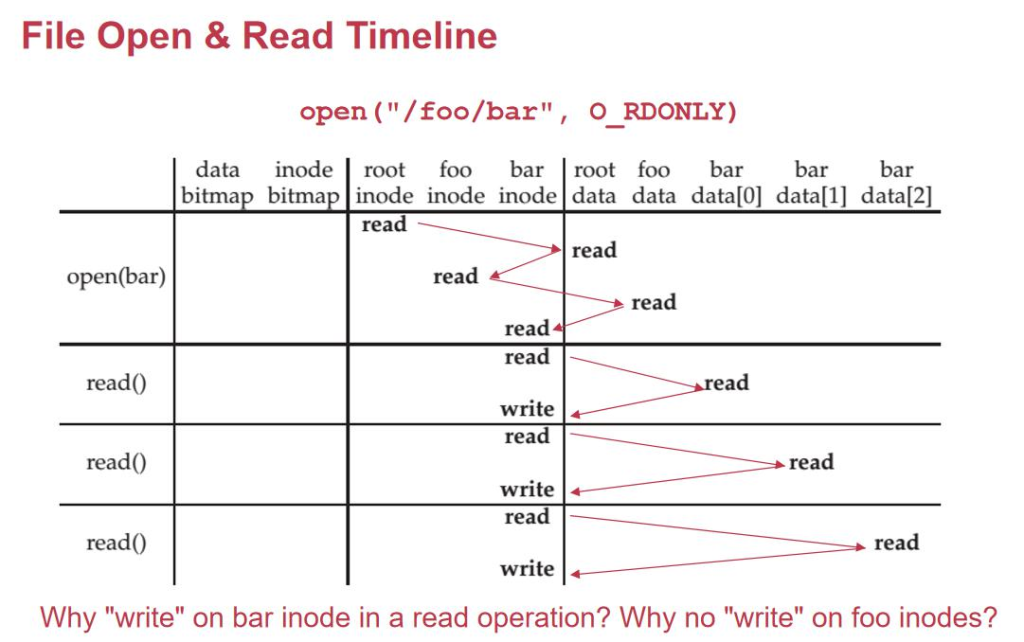

ه½“وˆ‘ن»¬هژ»و‰“ه¼€ن¸€ن¸ھو–‡ن»¶/foo/bar çڑ„و—¶ه€™ï¼Œوˆ‘ن»¬ه؛”该ه…ˆهژ»è¯» root_inode(ç؛¦ه®ڑن؟—وˆگçڑ„هœ°و–¹ï¼Œ 第ن¸€ن¸ھ inode çڑ„هœ°و–¹ï¼‰ï¼Œوˆ‘ن»¬ه°±هژ»è¯»و ¹ç›®ه½•ه¯¹ه؛”çڑ„ block number çڑ„ block,读هˆ°ن؛†و ¹ç›®ه½•ن¸‹ çڑ„و–‡ن»¶ï¼Œو‰¾هˆ°ن؛† foo çڑ„ inode,و‰¾هˆ° foo çڑ„و•°وچ®ï¼Œو‰¾هˆ°ن؛† bar çڑ„ inodeم€‚读çڑ„و—¶ه€™ï¼Œو‰¾هˆ° bar çڑ„ block 读,读ه®Œن؛†ن»¥هگژن؟®و”¹ن¸€ن¸‹ inode çڑ„ access timeم€‚

وˆ‘ن»¬هڈ‘çژ°هœ¨ read çڑ„و—¶ه€™ï¼Œوˆ‘ن»¬ن¸چه¾—ن¸چهژ» write ن¸€و¬،ç£پç›کن¸؛ن؛†و›´و–° access timeم€‚هœ¨ linux çڑ„و—¶ه€™ï¼Œهٹ è½½و–‡ن»¶ç³»ç»ںهگ¯هٹ¨çڑ„و—¶ه€™é»ک认ن¼ڑو·»هٹ noatime 选é،¹م€‚وˆ‘ن»¬ه¼±هŒ– atime çڑ„و›´و–°ï¼Œن¹ںه°± وک¯ه½“وˆ‘ن»¬ close çڑ„و—¶ه€™و‰چن¼ڑو›´و–° atime,而ن¸چè¦پ读ن¸€و¬،و›´و–°ن¸€و¬،,ه°½هڈ¯èƒ½ه‡ڈه°‘ç£پç›کçڑ„ه†™و“چن½œم€‚

简هچ•è¯´ï¼Œè؟™ن¸ھè؟‡ç¨‹çڑ„و ¸ه؟ƒوک¯ه› ن¸؛ç£پç›کو“چن½œوک¯هں؛ن؛ژ ه—(block) 而ن¸چوک¯هچ•ç‹¬çڑ„ه—èٹ‚,و¶‰هڈٹهˆ°و–‡ن»¶ç³»ç»ںه¦‚ن½•é«کو•ˆç®،çگ†ه’Œو›´و–°و•°وچ®ه—م€‚

1. 首ه…ˆï¼ڑو‰¾هˆ° /foo çڑ„ن؟،وپ¯

- و–‡ن»¶è·¯ه¾„解وگه…ˆن»ژو ¹ç›®ه½•ه¼€ه§‹ï¼Œé€گه±‚وں¥و‰¾م€‚

- و‰¾هˆ°

/fooو—¶ï¼ڑ- 读

/fooçڑ„ inodeï¼ڑن»ژ inode ن¸çں¥éپ“/fooçڑ„و•°وچ®ه—ç¼–هڈ·م€‚ - 读

/fooçڑ„و•°وچ®ه—ï¼ڑèژ·هڈ–里é¢çڑ„ه†…ه®¹ï¼ˆه¦‚و–‡ن»¶هگچه’Œ inode ç¼–هڈ·çڑ„ه¯¹ه؛”ه…³ç³»ï¼‰م€‚

- 读

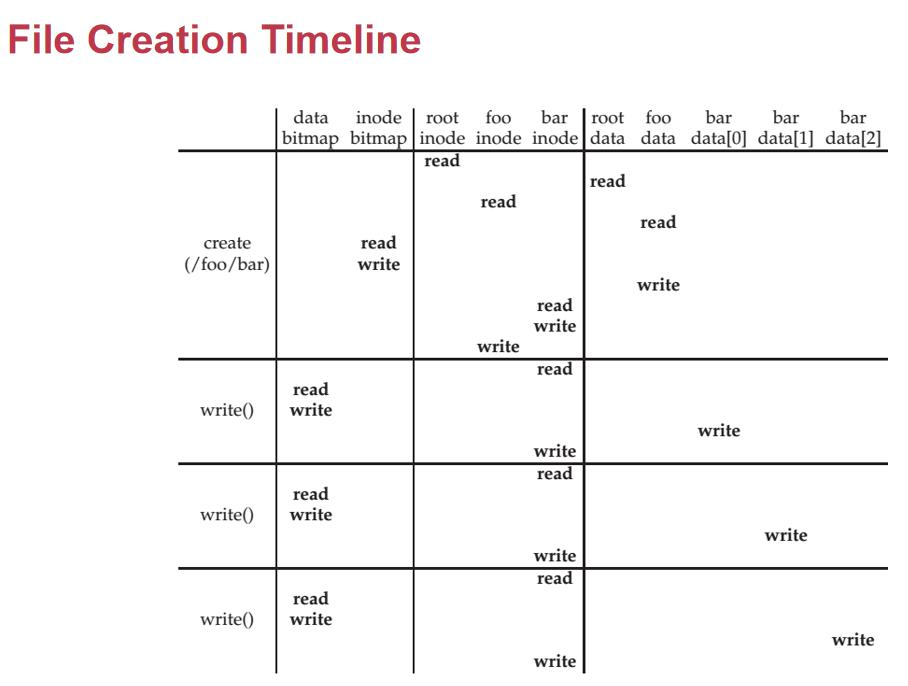

2. ه‡†ه¤‡هˆ›ه»؛ bar

- هˆ†é…چو–°çڑ„ inodeï¼ڑ

- 读 inode ن½چه›¾ï¼ˆinode bitmap)ï¼ڑو‰¾هˆ°ن¸€ن¸ھç©؛é—²çڑ„ inodeم€‚

- هˆ†é…چè؟™ن¸ھ inode ن½œن¸؛

barçڑ„ inodeم€‚

- و›´و–°

/fooçڑ„و•°وچ®ه—ï¼ڑ

- 读هڈ–

/fooçڑ„و•°وچ®ه—,و‰¾هˆ°هگˆé€‚ن½چç½®ه†™ه…¥barو–‡ن»¶هگچه’Œه®ƒçڑ„ inode ç¼–هڈ·م€‚

3. ن¸؛ن»€ن¹ˆهˆ›ه»؛و—¶è¦پ“读â€ï¼ں

è؟™ن¸ھ “读†و“چن½œن¸»è¦پوک¯ه› ن¸؛ç£پç›ک 物çگ†ه±‚ çڑ„特و€§ï¼ڑ

(1)ç£پç›کوŒ‰ه—و“چن½œ

- ç£پç›کçڑ„وœ€ه°ڈو“چن½œهچ•ن½چوک¯ ه—(block),é€ڑه¸¸وک¯ 4K ه¤§ه°ڈم€‚

- ه¦‚وœ

/fooçڑ„و•°وچ®ه—وک¯ 4K,ن½†وˆ‘ن»¬هڈھوƒ³ه¾€ه…¶ن¸ه†™ه…¥barçڑ„و،目(و¯”ه¦‚ه‡ هچپه—èٹ‚),ç£پç›کن¸چ能直وژ¥ه†™è؟™ه‡ هچپه—èٹ‚م€‚ - ه؟…é،»وٹٹ و•´ن¸ھ 4K ه—读ن¸ٹو¥ï¼Œن؟®و”¹ه…¶ن¸ن¸€éƒ¨هˆ†ï¼Œه†چه†™ه›ç£پç›کم€‚

(2)ه†™ه…¥و—¶ن؟وٹ¤هژںه§‹و•°وچ®

- ن¸؛ن؛†ن؟è¯پن¸چن¼ڑ覆盖وœھو”¹هڈکçڑ„部هˆ†ï¼Œه†™ç£پç›که‰چ需è¦پç،®ن؟ï¼ڑ

- و•°وچ®ه·²ç»ڈهœ¨ه†…هکن¸ه®Œو•´ن؟®و”¹ه¥½م€‚

- è؟™ه°±وک¯ “ه…ˆè¯»هگژه†™â€ çڑ„هژںه› م€‚

4. و›´و–° bar çڑ„ inode

- هˆ†é…چو•°وچ®ه—ï¼ڑ

- 读و•°وچ®ه—ن½چه›¾ï¼ˆdata bitmap)ï¼ڑو‰¾هˆ°ن¸€ن¸ھç©؛çڑ„ه—م€‚

- è؟™ن¸ھه—ه°†هکه‚¨

barçڑ„و–‡ن»¶ه†…ه®¹م€‚

- ه†™ inodeï¼ڑ

- هœ¨

barçڑ„ inode ن¸ï¼Œè®°ه½•ن¸‹è؟™ن¸ھو•°وچ®ه—ç¼–هڈ·م€‚

5. و€»ç»“ن¸؛ن»€ن¹ˆè¦پ读

- ç£پç›کوŒ‰ه—و“چن½œï¼ڑن¸چ能直وژ¥ه†™ه‡ ن¸ھه—èٹ‚,ه؟…é،»ه…ˆè¯»و•´ن¸ھه—م€‚

- 需è¦په®Œو•´و€§ï¼ڑن؟®و”¹ç›®ه½•و،目(ه¦‚

/fooçڑ„و•°وچ®ه—)و—¶ï¼Œه؟…é،»ç،®ن؟هژںو¥çڑ„ه…¶ن»–部هˆ†ن¸چن¸¢ه¤±م€‚ - ن½چه›¾çڑ„读هڈ–ï¼ڑن¸؛ن؛†و‰¾هˆ°ç©؛é—²çڑ„ inode ه’Œو•°وچ®ه—,ن¹ں需è¦پ读هڈ– inode ن½چه›¾ه’Œو•°وچ®ه—ن½چه›¾م€‚

و‰€ن»¥ï¼Œهˆ›ه»؛و–‡ن»¶çڑ„è؟‡ç¨‹è™½ç„¶çœ‹èµ·و¥وک¯â€œه†™â€ï¼Œن½†ه®é™…ن¸ٹ离ن¸چه¼€ 读و“چن½œï¼Œè؟™وک¯ن¸؛ن؛†هچڈè°ƒ ç£پç›ک物çگ†و“چن½œ ه’Œ و–‡ن»¶ç³»ç»ںçڑ„逻辑ç®،çگ†م€‚

وژ¥ن¸‹و¥وˆ‘ن»¬ه°±هڈ¯ن»¥و¥ه†™ن؛†ï¼Œن»ژ data_bit_map ن¸و‰¾ن¸€ن¸ھç©؛çڑ„ه†™ه›هژ»م€‚然هگژه†™ه›ه¯¹ه؛”çڑ„ block هگژه°±ه†چوٹٹ block number ه†™ه› inodeم€‚

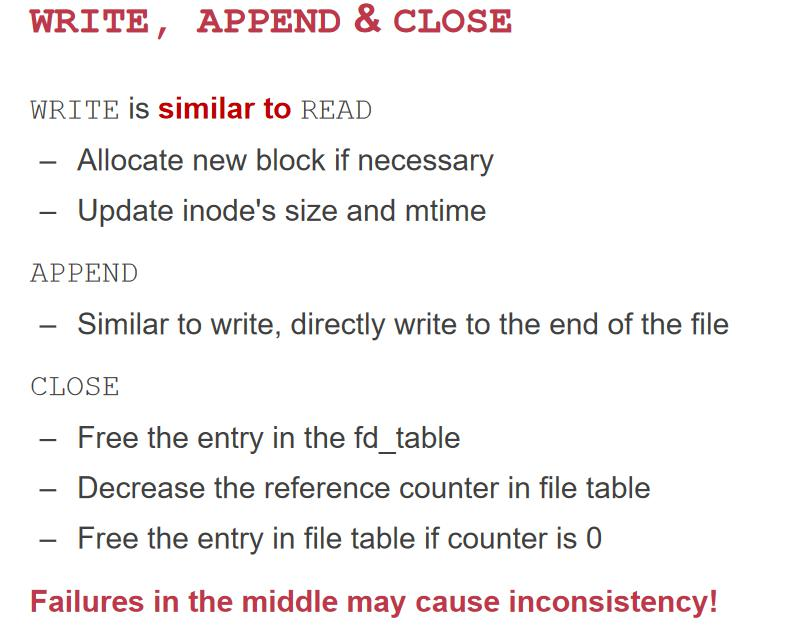

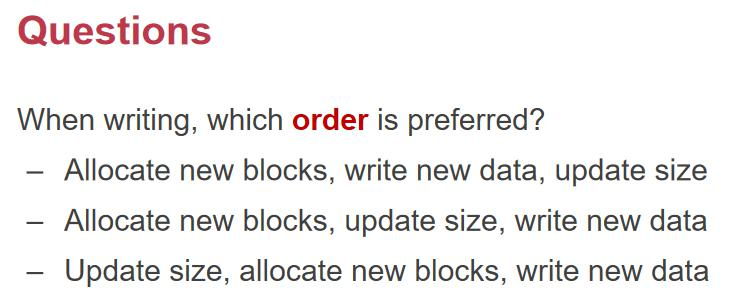

è؟™é‡Œوˆ‘ن»¬هڈ‘çژ°هœ¨ه‰چé¢çڑ„è؟‡ç¨‹ن¸ï¼Œوœ€éڑ¾çڑ„ن؛‹وƒ…ن¹ںه°±وک¯ن¸€و—¦هڈ‘é€پن؛† failure ه°±ن¼ڑه¯¼è‡´ن¸¥é‡چçڑ„é—®é¢کم€‚

وˆ‘ن»¬ç›´وژ¥ه›هˆ°هˆڑو‰چè؟™ن¸ھ write و“چن½œï¼Œن¸€و¬، write 需è¦په†™ 3 و¬،ç£پç›ک(data_bit_map, inode, data)م€‚é‚£ن¹ˆé—®é¢کو¥ن؛†ï¼Œه½“وˆ‘ن»¬هœ¨هپڑè؟™ن¸ھو“چن½œçڑ„و—¶ه€™و–电ن؛†ï¼Œن¼ڑهڈ‘ç”ں 3 2 وƒ…ه†µï¼Œن¹ںه°±وک¯ 000,001,010,…,111,

- 1. data ه†™ن؛†ï¼Œè€Œ data_bit_map,inode و²،ه†™م€‚ه…ƒو•°وچ®ه•¥éƒ½و²،و›´و–°ï¼Œه±ن؛ژ nothing çڑ„وƒ…ه†µم€‚

- 2. Data_bit_map ه†™ن؛†ï¼Œè€Œه…¶ن»–ن¸¤ن¸ھو²،ه†™م€‚ه¼•ه…¥ن؛†هƒهœ¾ï¼Œو²،وœ‰ن»»ن½•و–‡ن»¶çڑ„ inode وŒ‡هگ‘è؟™ ه—هŒ؛هںںم€‚وˆ‘ن»¬هڈ¯ن»¥é€ڑè؟‡وٹٹو•´ن¸ھ inode و‰«وڈڈن¸€éپچه¾—هˆ° list,然هگژهپڑهŒ¹é…چ,و›´و–°ن¸€ن¸‹ bit mapم€‚

- 3. inode و›´و–°ن؛†ï¼Œè€Œ block ه’Œ data_bitmap و²،و›´و–°م€‚وˆ‘ن»¬هڈ‘çژ°و•°وچ®وک¯é”™çڑ„,وœ‰هڈ¯èƒ½è®؟é—® هˆ°وƒé™گو–‡ن»¶ه¼•هڈ‘ه®‰ه…¨é—®é¢ک,هڈ¯ç”¨و€§ن¹ںوœ‰é—®é¢کم€‚è؟™ن¸ھé—®é¢کوک¯وœ€ه¤§çڑ„م€‚

- 4. Data و²،ه†™ï¼Œن¼ڑه¯¼è‡´ه®‰ه…¨و€§é—®é¢کم€‚

- 5. Data_bitmap و²،ه†™ï¼Œن¼ڑ被هڈ¦ن¸€ن¸ھو–‡ن»¶ه…±ç”¨ن¸€ن¸ھ blockم€‚

- 6. Inode و²،ه†™ï¼Œن؛§ç”ںوµھè´¹م€‚

ه¦‚وœè®©وˆ‘ن»¬وژ’ه؛ڈçڑ„è¯ï¼Œوˆ‘ن»¬ن¼ڑه…ˆه†™ data,ه†چه†™ data_bit_map,ه†چه†™ inodeم€‚ه› ن¸؛ inode éه¸¸é‡چè¦پم€‚

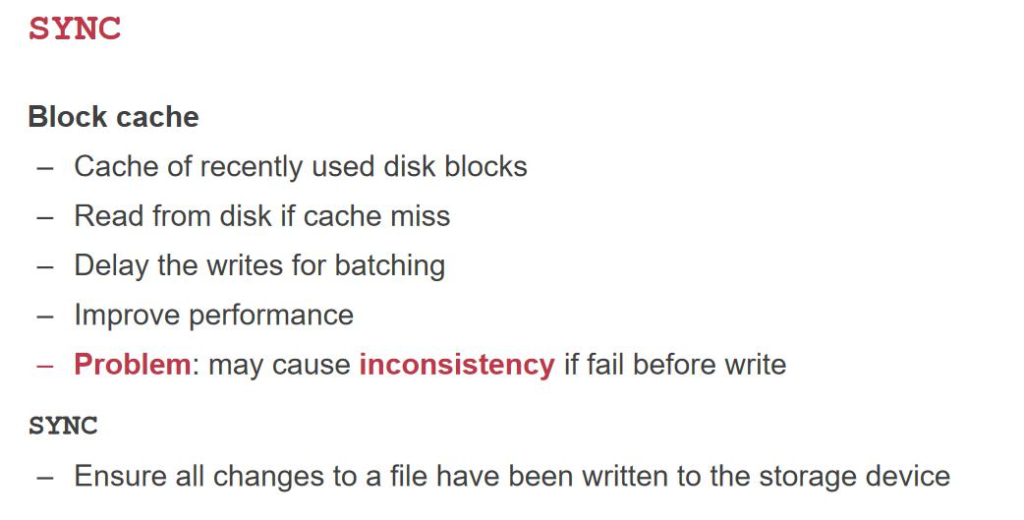

Order و²،هٹو³•ن؟è¯پ,ه› ن¸؛وˆ‘ن»¬هڈ‘é€پو“چن½œçڑ„و•°وچ®هڈ¯èƒ½وک¯وŒ‰ç…§é،؛ه؛ڈçڑ„,ن½†وک¯ cache çڑ„وƒ…ه†µوˆ‘ ن»¬ن¸چهڈ¯وژ§م€‚

ن¸؛ن؛†éپ؟ه…چè؟™ن¸ھé—®é¢ک,è؟™و—¶ه€™وˆ‘ن»¬ه°±è¦پ用هˆ° SYNC,وٹٹه†…هکن¸çڑ„و‰€وœ‰ن¸œè¥؟ flush هˆ°ç›کن¸ٹم€‚

ه¦‚وœوˆ‘ن»¬وٹٹن¸€ن¸ھو‰“ه¼€çڑ„و–‡ن»¶هˆ وژ‰ن؛†ï¼Œه¦‚وœ file_table ن¸çڑ„ ref_cnt ن¸چن¸؛ 0,需è¦پç‰ه¾… inode هœ¨è؟›ç¨‹ close çڑ„و—¶ه€™وٹٹه®ƒهˆ وژ‰م€‚

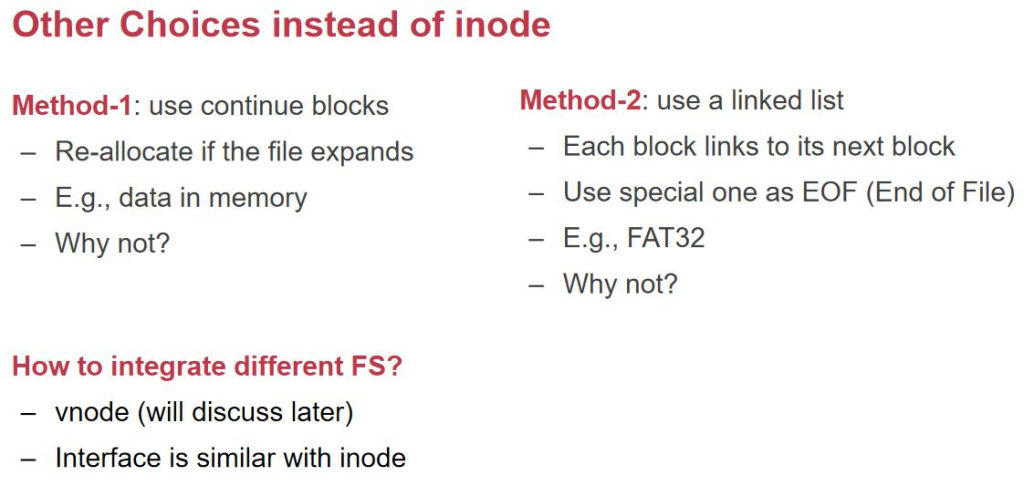

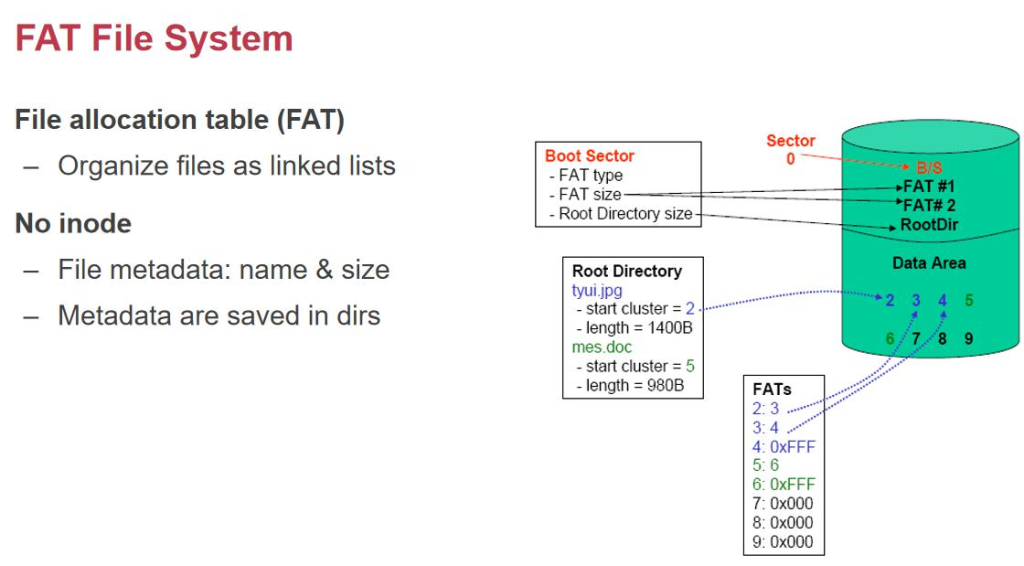

除ن؛† inode,وˆ‘ن»¬è؟کهڈ¯ن»¥و€ژن¹ˆç»„织و•°وچ®ه‘¢ï¼ںن¸؛ن»€ن¹ˆوˆ‘ن»¬ن¸چ适用链è،¨ه‘¢ï¼ںFAS32 ه°±وک¯ ن¸€ن¸ھ链è،¨م€‚

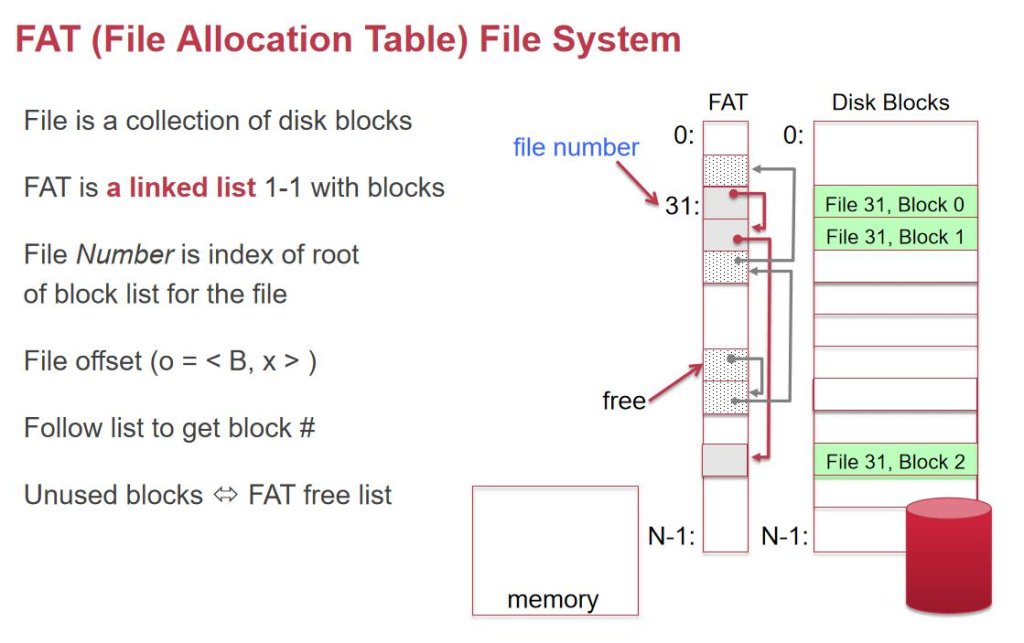

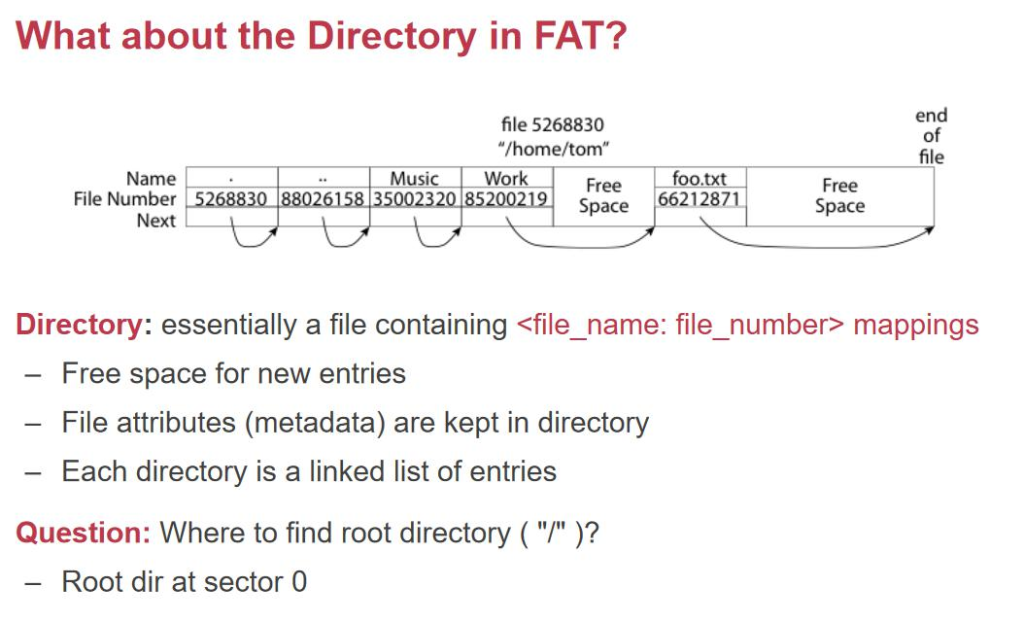

FAT32 ن½؟用 file allocation table و¥è®°ه½•و–‡ن»¶çڑ„第ن¸€ن¸ھ block-numberم€‚ه®ƒو²،وœ‰ Inode numberم€‚ FAT è،¨ه…¶ه®ه°±وک¯ن¸€ن¸ھ 64byte çڑ„è،¨م€‚ه½“وˆ‘ن»¬وٹٹè؟™ن¸ھè،¨ن¸²èµ·و¥ï¼Œوˆ‘ن»¬ه°±هڈ¯ن»¥وٹٹه¯¹ه؛”و•°وچ®ن¸²èµ·و¥م€‚ freelist ن¸€è·¯ن¸ٹوٹٹو‰€وœ‰ freeblock ن¸²هœ¨ن¸€èµ·م€‚وˆ‘ن»¬è¦پو–°هٹ ن¸€ن¸ھ block çڑ„و—¶ه€™ï¼Œوˆ‘ن»¬ه°±وٹٹ free_list وŒ‡هگ‘ه®ƒçڑ„ next,ه¤ڑه‡؛و¥ن¸€ن¸ھ free,然هگژو”¹ file32 çڑ„وœ€هگژن¸€ن¸ھوŒ‡هگ‘ free blockم€‚

é‚£ن¹ˆè؟™ن¹ˆن¸€ç§چ设è®،وœ‰ن»€ن¹ˆç‰¹ç‚¹ه‘¢ï¼ںه¯¹ن؛ژéڑڈوœ؛读ه†™ï¼Œéœ€è¦پéپچهژ†ن¸€éپچè؟™ن¸ھ linked_list,而وˆ‘ ن»¬çڑ„ Inode هڈھ需è¦پ读ن¸€éپچن¸‰ç؛§ç´¢ه¼•çڑ„链م€‚ه¦‚وœ linked_list وœ‰ن¸€ن¸ھهœ°و–¹هڈن؛†ï¼Œé‚£ن¹ˆه…¨éƒ¨éƒ½هڈن؛†م€‚ ن¸‰ç؛§é—´وژ¥ç´¢ه¼•هڈن؛†ن¹ںن¼ڑه¯¼è‡´ه¤§é‡ڈو•°وچ®و²،وœ‰ï¼Œن½†وک¯و¦‚çژ‡ه°ڈن¸€ç‚¹م€‚

NAT 适هگˆé،؛ه؛ڈ读ه†™م€‚و‰€ن»¥é€‚هگˆç”¨و¥هپڑو•°ç پ相وœ؛çڑ„هکه‚¨ن»‹è´¨م€‚

ç”±ن؛ژ fat è،¨و²،وœ‰ inode,و‰€ن»¥وˆ‘ن»¬è؟کوک¯è¦پè®°ه½•ن¸€ن؛›ه…ƒو•°وچ®م€‚وک¯è®°ه½•هœ¨ directory entry(目 ه½•é،¹ï¼‰ن¸م€‚inode çڑ„结و„وک¯ name: inode-numberم€‚而 FAT ن¸وک¯ name :第ن¸€ن¸ھ block çڑ„ number, size,….,هگ„ç§چه…ƒو•°وچ®çڑ„ن؟،وپ¯م€‚ه°±ç®—وœ‰ ref count,وˆ‘ن»¬ن¹ںن¸چçں¥éپ“هœ¨ه“ھ,需è¦پو‰«وڈڈن¸€éپچو‰€وœ‰çڑ„ ç›®ه½•م€‚و‰€ن»¥ FAT ن¸چو”¯وŒپ hard link çڑ„م€‚و ¸ه؟ƒه°±وک¯ name وک¯و–‡ن»¶çڑ„ه…ƒو•°وچ®çڑ„ن¸€éƒ¨هˆ†ï¼Œن؛ژوک¯وˆ‘ن»¬ه°±ن¸چ能让ن¸¤ن¸ھ name وŒ‡هگ‘ن¸€ن¸ھو•°وچ®م€‚

ه¦‚وœوˆ‘ن»¬وٹٹ U ç›کو ¼ه¼ڈهŒ–وˆگ FAT,وœ€ه¤§و”¯وŒپçڑ„ه¤§ه°ڈوک¯ 4G,è؟™ن¸ھ 4G وک¯ç”±ن»€ن¹ˆه†³ه®ڑçڑ„ï¼ںوک¯ه› ن¸؛ه…ƒو•°وچ®ن¸çڑ„ size هڈھوœ‰ 32 ن½چ,وœ€ه¤§هڈھ能è،¨ç¤؛ 4G çڑ„و–‡ن»¶م€‚而 Inode-based file system وک¯ç”±وœ‰ ه¤ڑه°‘ç؛§ indirect-block ه†³ه®ڑçڑ„م€‚ه¦‚وœوˆ‘ن»¬هœ¨ن¸€ن¸ھو–‡ن»¶ç³»ç»ں里é¢ï¼Œوˆ‘ن»¬çژ°هœ¨è¦پهکه¤§é‡ڈçڑ„و–‡ن»¶ï¼Œ ن½†و¯ڈن¸ھو–‡ن»¶ه°ڈن؛ژ 1k,ه¹³ه‡ 256byteم€‚而ن¸€ن¸ھ i-node ه°±وœ‰ 1k,ن؛ژوک¯وˆ‘ن»¬ن¸؛ن؛†è؟™ن¸ھو¯ڈن¸ھو–‡ن»¶çڑ„ هکه‚¨هˆ†é…چن¸€ن¸ھ 4k çڑ„ block ه’Œ 1k çڑ„ inodeم€‚ن؛‹ه®ن¸ٹوˆ‘ن»¬ن»ٹه¤©çڑ„ç£پç›کن¸ï¼Œوœ‰ه¾ˆه¤ڑ 4k çڑ„و•°وچ®و²،وœ‰ هکه®Œï¼Œè؟™ن¸ھهœ°و–¹وک¯ç”± size ه†³ه®ڑçڑ„م€‚وœ€هگژن¼ڑç•™ن¸‹ن¸€ن؛›ç©؛éڑ™çڑ„م€‚وˆ‘ن»¬وœ‰ن»€ن¹ˆهٹو³•وٹٹهˆ©ç”¨çژ‡وڈگé«که‘¢? ن¸€ن¸ھ简هچ•çڑ„هٹو³•وک¯ç›´وژ¥وٹٹو•°وچ®و”¾هœ¨ inode ن¸م€‚ن¸؛ن؛†éپ؟ه…چو–‡ن»¶ç³»ç»ں误解ن¸؛ blocknumber,ه†چهٹ ه‡ ن¸ھ flag ه°±è،Œن؛†م€‚è؟™و ·و–‡ن»¶هˆ©ç”¨çژ‡ ه°±وڈگé«کن؛†

هœ؛و™¯ï¼ڑوˆکهœ°è®°è€…ه¸¦و‰‹وœ؛,è؟›è؟‡ن¸€ن¸ھهŒ؛هںں,è؟›ه‡؛都وœ‰ن¸€ن¸ھه“¨ه…µم€‚è؟™ن¸ھه“¨ه…µéه¸¸و‡‚و–‡ن»¶ç³»ç»ں, 记者ن¸چ能让و–‡ن»¶ç³»ç»ںوœ‰ن»»ن½•çڑ„هڈکهŒ–,ه°±هڈ¯ن»¥ç”¨و–‡ن»¶ç³»ç»ںن¸و¯ڈن¸ھو–‡ن»¶çڑ„وœ€هگژن¸€ن¸ھ block ه¤ڑن½™çڑ„ ç©؛é—´م€‚è؟™ن¸ھو–¹و³•ن¸چن»…وˆکهœ°è®°è€…ن¹ںن¼ڑ用,黑ه®¢ن¹ںن¼ڑ用,病و¯’ه¦‚وœو”¾هœ¨è؟™ن¸ھهŒ؛هںںه°±و‰«وڈڈن¸چه‡؛و¥ن؛†م€‚ هٹ¨و€پهœ°ن؟®و”¹ inode ن¸çڑ„ size,ه°±هڈ¯ن»¥هœ¨وƒ³ç”¨çڑ„و—¶ه€™è°ƒç”¨هˆ°ç—…و¯’çڑ„ن»£ç پم€‚

هˆ†ه¸ƒه¼ڈو–‡ن»¶ç³»ç»ں

RPC

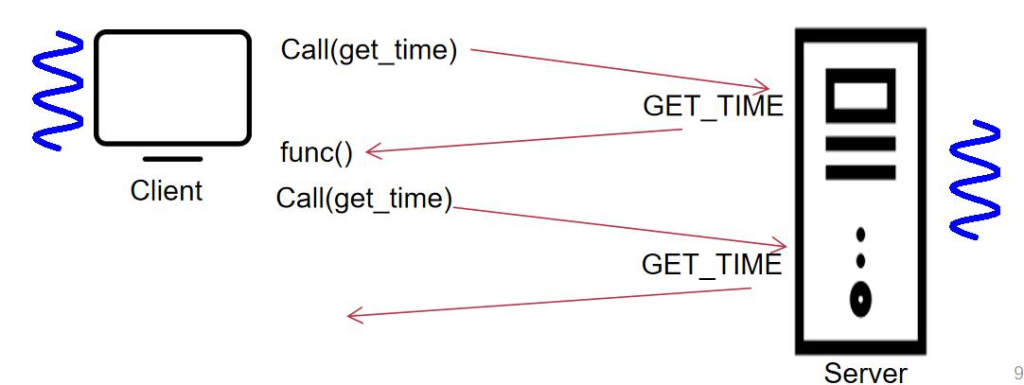

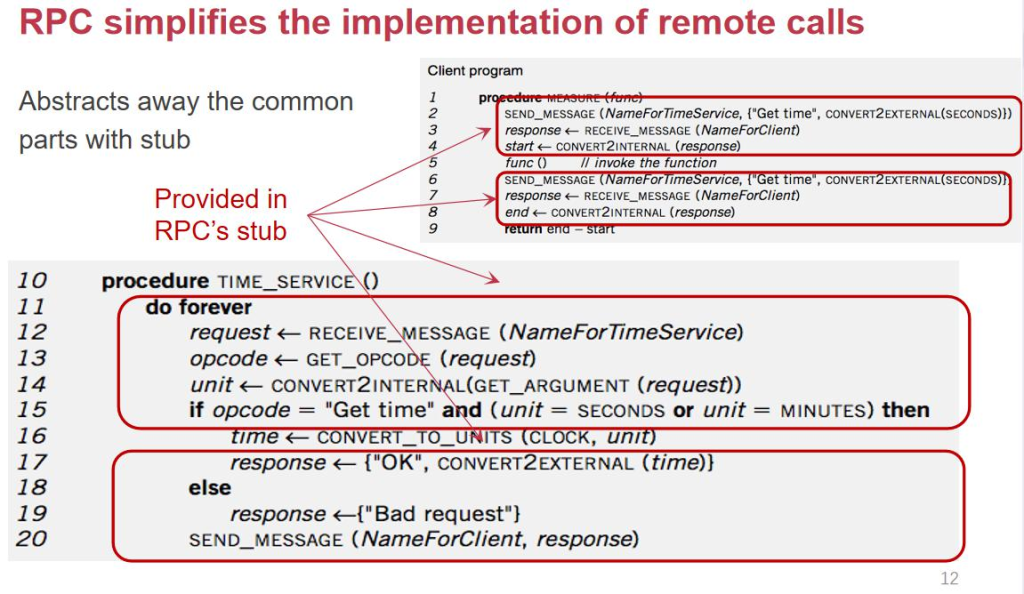

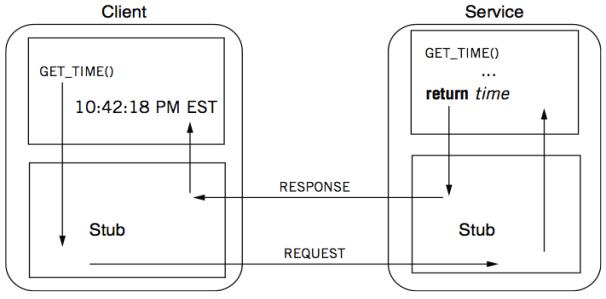

وˆ‘ن»¬ه¸Œوœ›وٹٹ file system ن»ژهچ•ن¸ھو‰©ه±•هˆ°ه¤ڑن¸ھم€‚è؟™ن¸ھهœ¨وژ¥è؟‘ 40 ه¹´ه‰چه°±وœ‰ن؛؛هپڑن؛†م€‚SUN ه…¬هڈ¸ ه¸Œوœ›ه¼€هڈ‘و²،وœ‰ç،¬ç›کçڑ„è®،ç®—وœ؛,و•°وچ®وک¯ن¸چوک¯éƒ½èƒ½ه…¨éƒ¨و¥è‡ھ网络م€‚ه¯¹ç”¨وˆ·وک¯é€ڈوکژçڑ„,وœ€ه؛•ه±‚çڑ„و ¸ ه؟ƒوٹ€وœ¯ه°±وک¯ RPCم€‚RPC ن¸چن»…ن»…وک¯ç”¨و¥وڈگن¾› Open,Write,Read وژ¥هڈ£ï¼ŒRPC è؟ک能ه®çژ°è·¨وœ؛ه™¨çڑ„ه‡½و•° 调用م€‚

ن¼ ç»ںçڑ„,ه¦‚وœوˆ‘ن»¬ن¸چ用 RPC,ه¤§ه®¶è¦پ调用网络çڑ„و—¶ه€™ï¼Œه°±è¦پن½؟用 socket,و‰“ه¼€ن¸€ن¸ھ socket, وœچهٹ،端è¦پ listen,然هگژهڈ¯ن»¥ accept ه¾—هˆ°ن¸€ن¸ھ fd,然هگژهœ¨هڈŒو–¹ن¹‹é—´هپڑن؛¤ن؛’,وˆ‘ن»¬éœ€è¦په†™ه¾ˆه¤ڑ glue code,ن¸چوک¯ه¾ˆو–¹ن¾؟,وˆ‘ن»¬ه¸Œوœ›وœ‰و›´هٹ 简هچ•çڑ„و“چن½œï¼Œclient çڑ„ن»£ç پهڈ¯ن»¥ç›´وژ¥ه†™ن¸€ن¸ھ fool()调用çڑ„ وک¯وœچهٹ،ه™¨ç«¯çڑ„ه‡½و•°ï¼Œè؟”ه›ه€¼ه°±وک¯ه¯¹ه؛”çڑ„è؟”ه›ه€¼م€‚وچ¢هڈ¥è¯è¯´وˆ‘ن»¬ه¸Œوœ› RPC ه’Œ PC(procedure call) وک¯ن¸€و ·çڑ„,وˆ‘ن»¬ن¸چ需è¦پ care ه®ƒوک¯ local è؟کوک¯ remote çڑ„م€‚除ن؛†هœ¨ framework ç؛§هˆ«ï¼Œهœ¨è¯è¨€ç؛§هˆ« ç”ڑ至都هŒ…هگ«ن؛† RPC 相ن¼¼çڑ„وœ؛هˆ¶ï¼Œو¯”ه¦‚ Java ن¸çڑ„ RMI(remote method invocation)م€‚说وکژ RPC وک¯ن¸€ن¸ھéه¸¸éه¸¸هں؛ç،€çڑ„ن½œç”¨م€‚

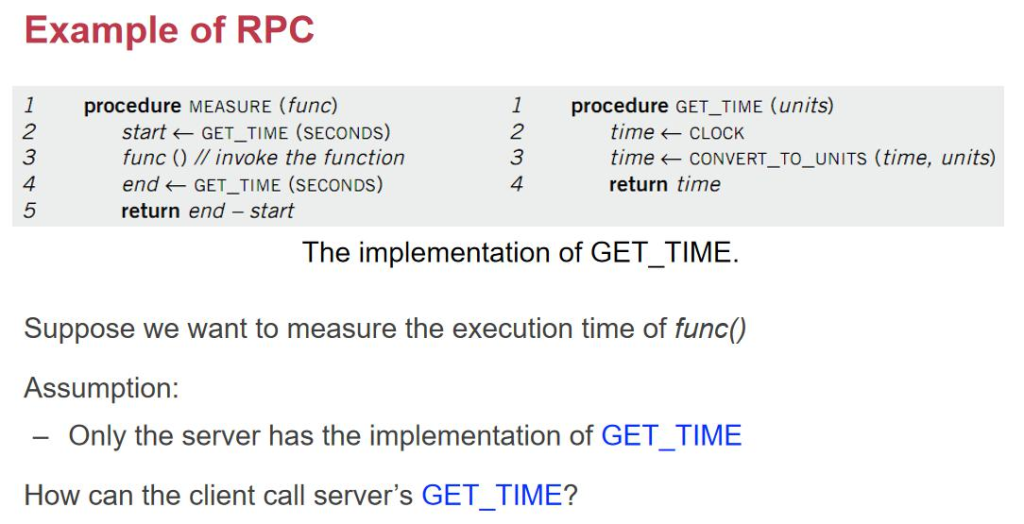

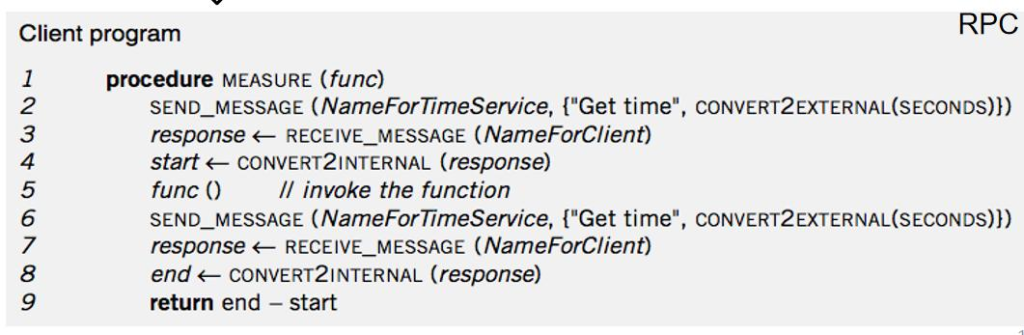

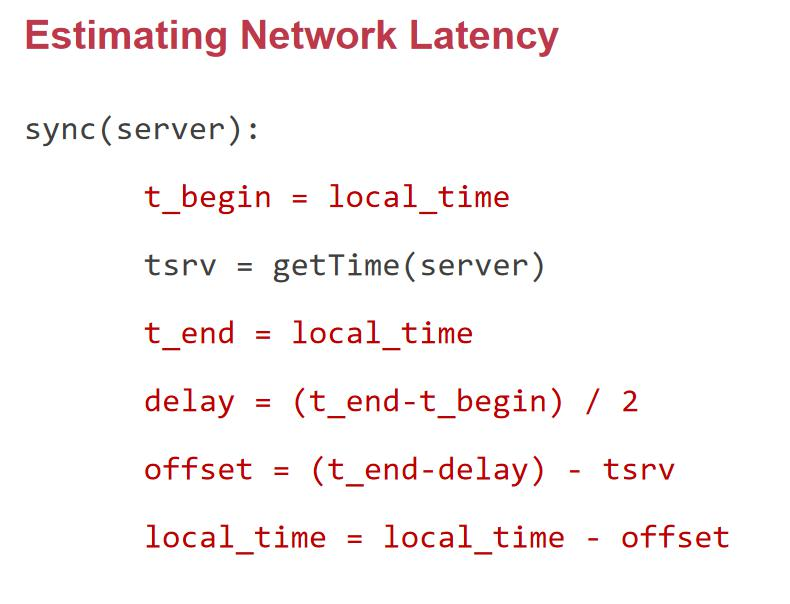

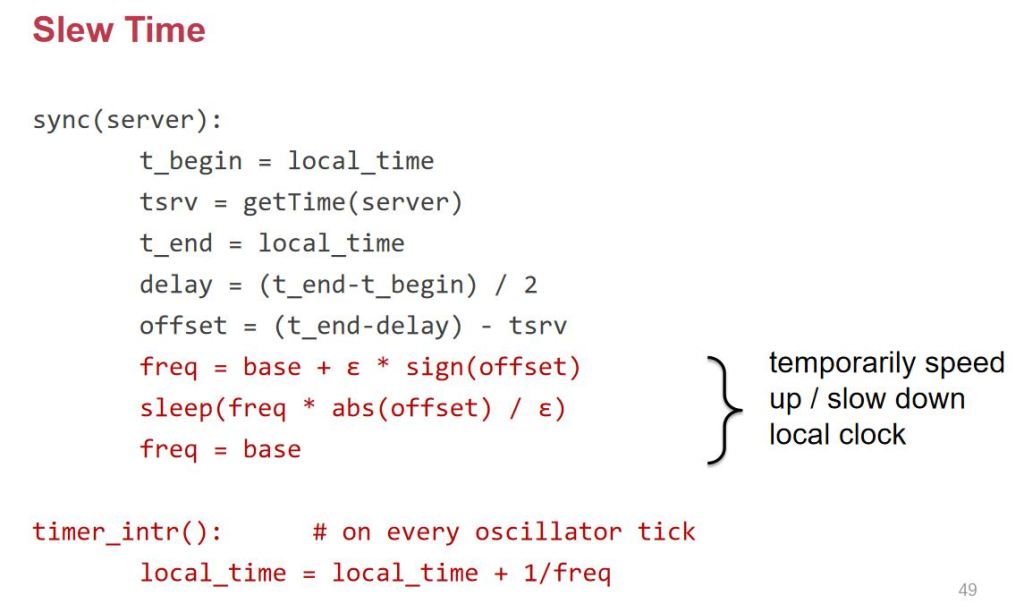

è؟™ن¸ھ mesure ه‡½و•°وک¯ç”¨و¥وµ‹é‡ڈ func çڑ„è؟گè،Œو—¶é—´م€‚Get_time ه°±وک¯و ¹وچ®ن¼ ه…¥çڑ„هچ•ن½چè؟”ه›ه¯¹ه؛” هچ•ن½چçڑ„و—¶é—´م€‚ه¦‚وœوˆ‘ن»¬وٹٹ GET_TIME و”¾هˆ°وœچهٹ،ه™¨ن¸ٹ,و¯”ه¦‚وˆ‘ن»¬وœ¬هœ°çڑ„و—¶é’ںن¸چو£ç،®ï¼Œè¯¥و€ژن¹ˆهژ» هپڑه‘¢ï¼ں

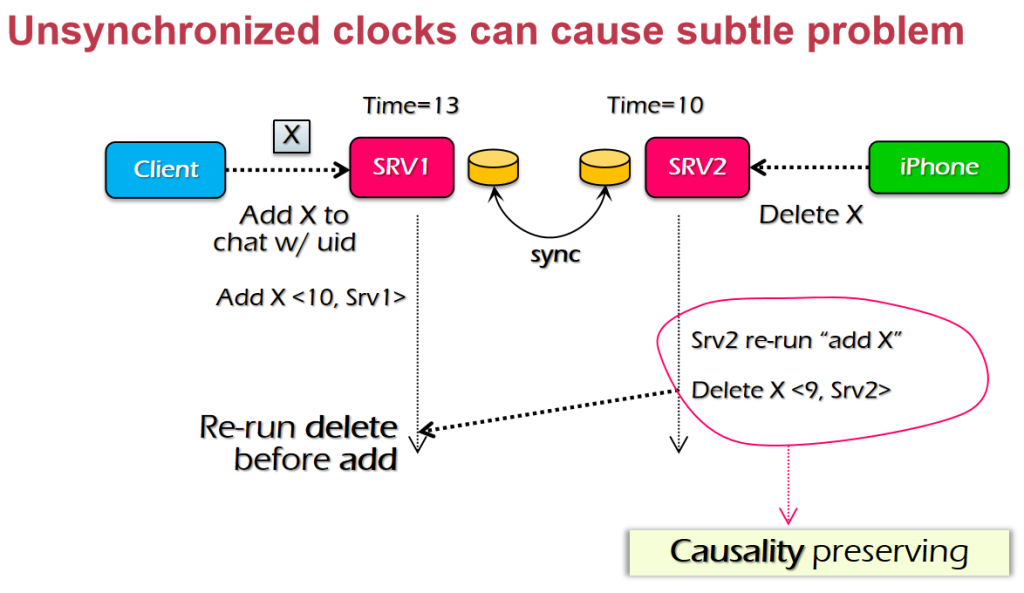

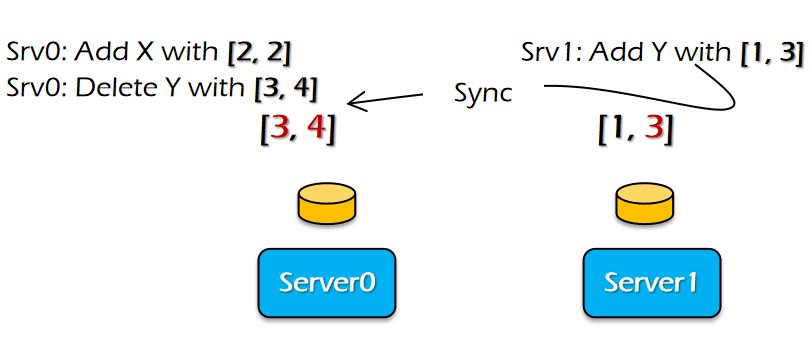

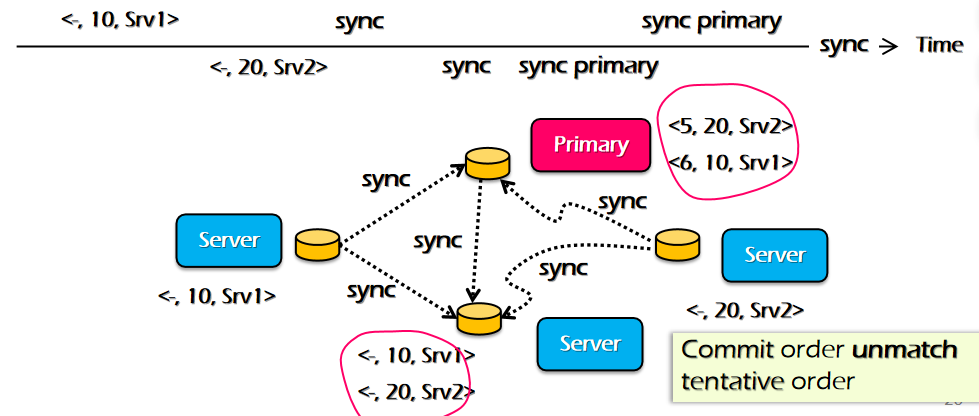

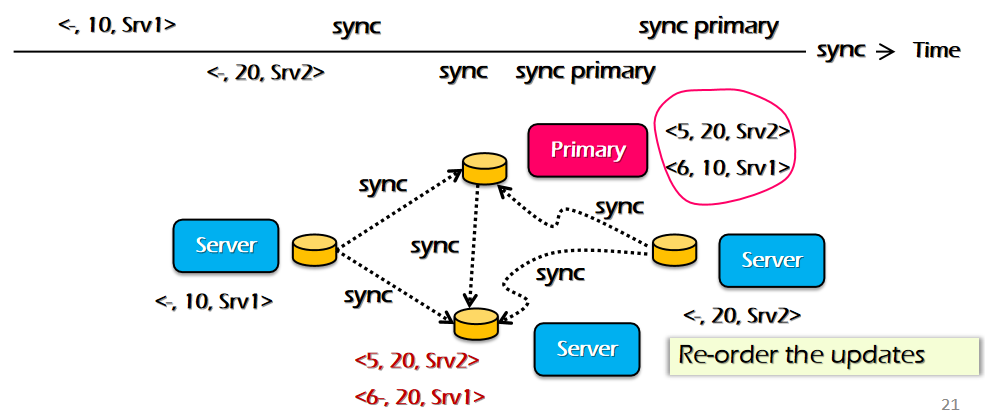

网络ه»¶è؟ں该و€ژن¹ˆهٹï¼ںوˆ‘ن»¬ن¹‹هگژن¼ڑ讨è®؛ه¯¹و—¶çڑ„ç®—و³•م€‚ وœ€ç®€هچ•çڑ„ه°±وک¯ه¤ڑ ping ه‡ و¬،,هڈ–ه‡ه€¼ï¼Œوˆ‘ن»¬هپ‡è®¾ن؛†ç½‘络و—¶ه»¶هں؛وœ¬ن¸ٹن¸چهڈک,ه¹¶ن¸”هپ‡è®¾ن؛†è؟‡ هژ»çڑ„و—¶é—´ç‰ن؛ژه›و¥çڑ„و—¶é—´م€‚ن¸€و—¦هœ¨è°ˆهˆ°هˆ†ه¸ƒه¼ڈçڑ„و—¶ه€™ï¼Œوˆ‘ن»¬ن¼ڑهڈ‘çژ°و—¶é’ںوک¯çœ‹èµ·و¥ç®€هچ•ن½†وک¯èƒŒ هگژوک¯ن¸€ن¸ھéه¸¸ه¤§çڑ„é—®é¢ک,ه› ن¸؛و²،وœ‰ن¸¤ن¸ھن؛؛çڑ„و—¶é’ںوک¯ن¸€و ·çڑ„م€‚

وˆ‘ن»¬éœ€è¦پوٹٹ second هڈ‚و•° convert ن¸€ن¸‹ï¼Œه› ن¸؛网络ن¸ٹçڑ„و•°وچ®وک¯ big-endian,然هگژن¼ ن¸€ن¸ھ Get time و‰“هŒ…وˆگن¸€ن¸ھ Message هڈ‘é€پç»™وœچهٹ،ه™¨ï¼Œه¾—هˆ° responseم€‚然هگژه†چ convert ه›و¥م€‚

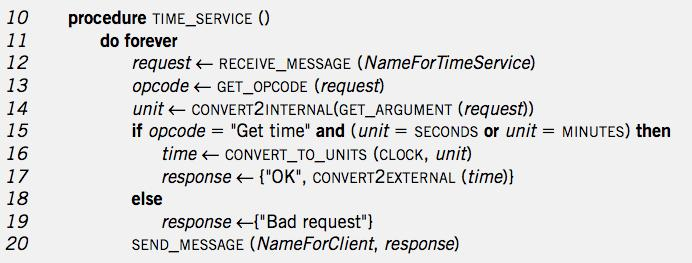

ه¾—هˆ° request هگژ,ه¯¹ه…¶هپڑ解وگه¾—هˆ° opcode ه’Œ unitم€‚ه¾—هˆ°و•°وچ®ن»¥هگژ,è؟”ه›ن¸€ن¸ھ response(OK ه’Œ bad request ن¸¤ç§چهڈ¯èƒ½ï¼‰م€‚ وˆ‘ن»¬çœ‹هˆ°ه®ƒو¥و¥ه›ه›هپڑن؛†ه¾ˆه¤ڑهˆ«çڑ„ن؛‹وƒ…,ه¾ˆه¤ڑه†…ه®¹وک¯هڈ¯ن»¥و¨،ه—هŒ–çڑ„م€‚

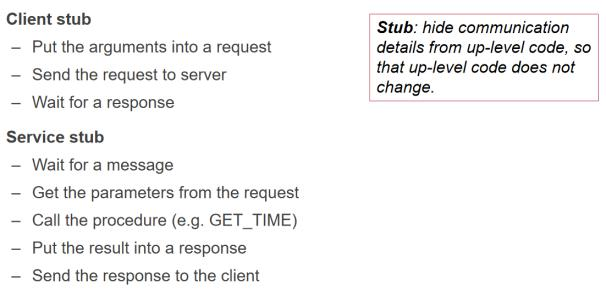

è؟™ن؛›éƒ½وک¯هڈ¯ن»¥و”¾هœ¨ RPC çڑ„ stub(و،©ن»£ç پ,ن¸چ用程ه؛ڈه‘کç®،çڑ„)ن¸ï¼Œه…¨éƒ¨ç”¨ه؛“çڑ„و–¹ه¼ڈهژ»ه°پ装起 و¥م€‚

هœ¨ stub ن¸ن¼ڑه®çژ° GET_TIME ه¹¶ن¸”هڈ‘é€پç»™è؟œç«¯ه¾—هˆ° responseم€‚Stub ه°±ه¾ˆه¥½هœ°ه°پ装ن؛†ه؛•ه±‚网络é€ڑ 讯çڑ„细èٹ‚م€‚ه¯¹ن؛ژ server و¥è¯´ن¸€و ·ï¼Œوˆ‘ن»¬ه®çژ°ن؛†ه؛•ن¸‹çڑ„ن¸€ه±‚م€‚

è؟™وک¯éه¸¸ç»ڈه…¸çڑ„解耦و–¹ه¼ڈ,程ه؛ڈه‘کن¸چ用考虑ه‡½و•°وک¯هœ¨وœ¬هœ°è؟کوک¯هœ¨è؟œç«¯ï¼Œه½“然è؟™وک¯هœ¨ن¸چه‡؛ ه¼‚ه¸¸çڑ„وƒ…ه†µم€‚

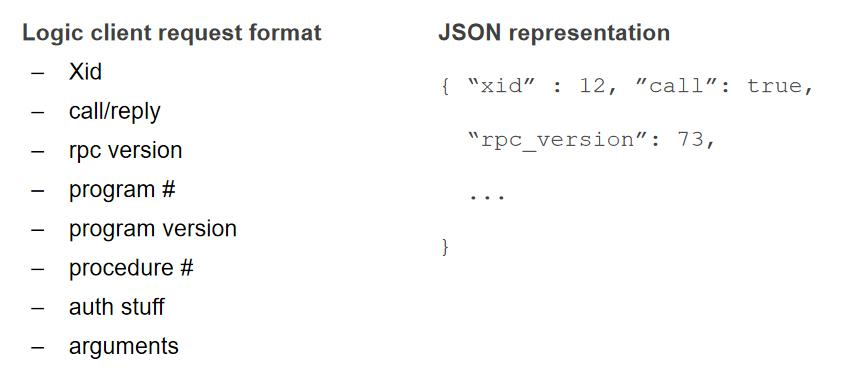

وˆ‘ن»¬éœ€è¦پوٹٹو•°وچ®ç”¨هگˆçگ†çڑ„و–¹ه¼ڈ marshal وژ’éکںهڈ‘هˆ°ç½‘ن¸ٹهژ»ï¼ˆserialize)م€‚وˆ‘ن»¬و¥è¯¦ç»†çœ‹ن¸€ن¸‹ï¼Œ هœ¨ 1984 è؟™ç¯‡è®؛و–‡ن¸وڈگه‡؛çڑ„ RPC هŒ…هگ«ن؛†ن»€ن¹ˆه†…ه®¹:

- 1. Xid,X وک¯ transaction çڑ„缩ه†™ï¼Œه®ƒوک¯ç”¨ه‘ٹ诉 server 请و±‚وک¯هڈ‘è؟‡ن؛†è؟کوک¯و²،هڈ‘è؟‡ï¼Œهœ¨ه‡؛ é”™çڑ„و—¶ه€™éه¸¸وœ‰ç”¨

- 2. Call/reply53

- 3. RPC version,و„ڈه‘³ç€هڈ¯ن»¥و”¯وŒپه¤ڑن¸ھ version,ن¸€هڈ°هچ•وœ؛çڑ„ه؛”用程ه؛ڈه’Œه؛“é€ڑه¸¸وک¯هگˆهœ¨ن¸€ èµ·çڑ„,ن½†وک¯ client ه’Œ server çڑ„版وœ¬هڈ¯èƒ½ن¸چ相هگŒï¼Œè¦پ考虑هˆ°ه…¼ه®¹و€§

- 4. Program, program version, procedure,هڈ¯èƒ½è°ƒç”¨ن¸€ن¸ھهڈ¯و‰§è،Œو–‡ن»¶و‰€وڈگن¾›çڑ„ه‡½و•°

- 5. Auth stuff,و¥هپڑéھŒè¯پ

- 6. Arguments,هڈ‚و•°

هگŒو ·هœ¨ reply çڑ„و—¶ه€™ن¹ںوœ‰ه‡ ن¸ھن¸چهگŒçڑ„هڈ‚و•°

- 1. Accepted

- 2. Success,accepted ه’Œ success çڑ„هŒ؛هˆ«وک¯ن»€ن¹ˆه‘¢ï¼ںAccepted وک¯ه’Œ RPC 相ه…³çڑ„,而 Success وک¯ه’Œوˆ‘ن»¬è°ƒç”¨çڑ„ serveice 相ه…³çڑ„م€‚وچ¢هڈ¥è¯è¯´ه¦‚وœ accepted وک¯ false,说وکژ RPC éک¶و®µه°±é”™ن؛†ï¼Œ و²،وœ‰è°ƒç”¨هˆ°ç¨‹ه؛ڈ,而 success وک¯è¯´وکژ RPC ن¹‹é—´وک¯هڈ¯ن»¥و£ه¸¸ه¯¹è¯ï¼Œن½†وک¯ه…·ن½“و‰§è،Œçڑ„و—¶ه€™ه‡؛é”™ن؛†

- 3. Results

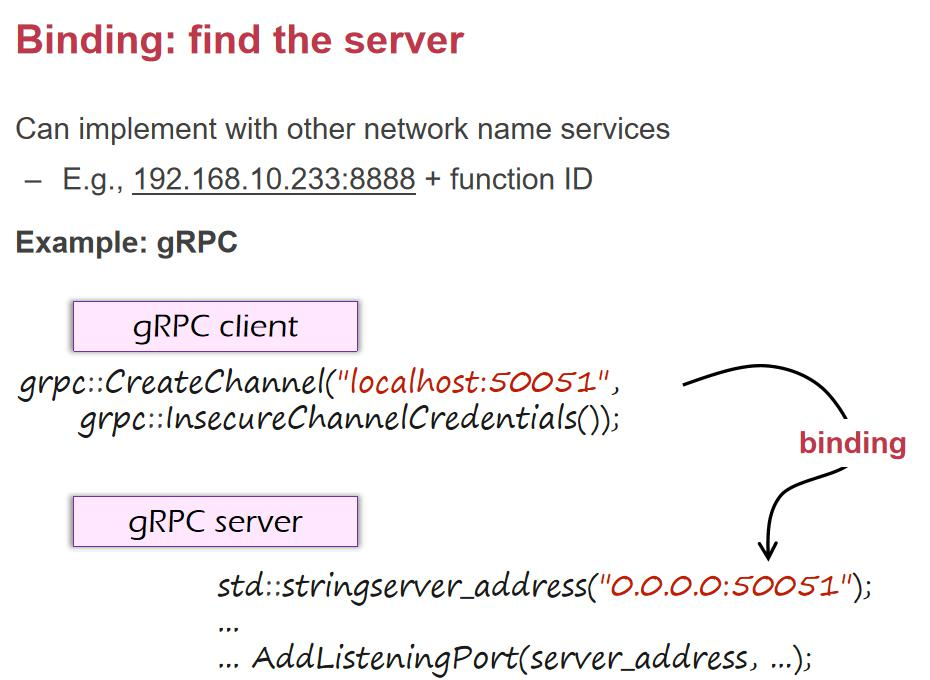

- 4. Auth stuff و€ژن¹ˆè®© client ه’Œ server ن؛’相绑ه®ڑه‘¢ï¼ں

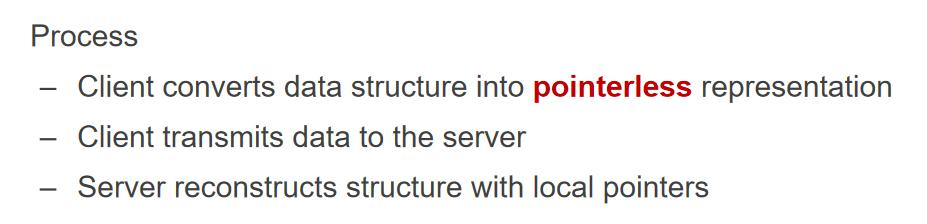

Client 该و€ژن¹ˆçں¥éپ“è؟™ن¸ھ端هڈ£ه‘¢ï¼ںو‰€ن»¥هœ¨ç³»ç»ںن¸ï¼Œmain discovery وœچهٹ،و³¨ه†Œç«¯هڈ£ï¼Œهڈ¯ن»¥هˆ—ه‡؛ و‰€وœ‰ service çڑ„端هڈ£م€‚و‰€è°“çڑ„وœچهٹ،هڈ‘çژ°ن¹ںوک¯هœ¨هˆ†ه¸ƒه¼ڈç³»ç»ںوک¯ه¾ˆé‡چè¦پçڑ„组وˆگ部هˆ†م€‚وˆ‘ن»¬éœ€è¦پوٹٹ و•°وچ®هڈ‘é€پç»™ server,è؟™ن»¶ن؛‹وƒ…看ن¼¼ç®€هچ•è؟کوŒ؛ه¤چو‚çڑ„,هœ¨çژ°ن»£çڑ„ rpc ç³»ç»ںن¸ç”±ن؛ژو•°وچ®هœ¨ن¸چهگŒçڑ„ و ¼ه¼ڈن¸è½¬وچ¢ï¼Œه…¶و—¶é—´وچںه¤±è¦پهچ وچ® 20%ن»¥ن¸ٹم€‚وˆ‘ن»¬هœ¨ن¼ paramater çڑ„و—¶ه€™ï¼Œه؟…é،» pass by value 而ن¸چوک¯ pass by referenceم€‚

ه¦‚وœه®çژ° pass by reference وˆ‘ن»¬هڈھ需è¦پ让هœ¨ page fault çڑ„و—¶ه€™ï¼Œن»ژهڈ¦ن¸€هڈ°ç”µè„‘çڑ„ه¯¹ه؛”è™ڑ و‹ںهœ°ه€ copy è؟‡و¥ه°±هڈ¯ن»¥ن؛†م€‚è؟™ن¸ھه°±وک¯ DSM(distributed shared memory),è؟™ن¸ھوٹ€وœ¯هœ¨ن½“育 馆ن¸çڑ„电视ه¢™ç”¨çڑ„وœ€ه¤ڑم€‚هœ¨ه±ڈه¹•çں©éکµن¸ٹ,用 DSM و¥ه…±ن؛«ه†…هکه¯¹ه؛”ن¸€ه—ه—ه±ڈه¹•çڑ„وک¾هکهچ³هڈ¯م€‚

هڈ‚و•°ن¼ 递

Server é‡چو–°هœ¨è‡ھه·±çڑ„程ه؛ڈن¸هˆ›ه»؛ pointerم€‚é‚£ن¹ˆن¼ هڈ‚هˆ°ه؛•وœ‰ن»€ن¹ˆوŒ‘وˆکه‘¢ï¼ںو ¸ه؟ƒه°±وک¯و¯ڈهڈ° وœ؛هگه¯¹و•°ه—çڑ„çگ†è§£وک¯ن¸چن¸€و ·çڑ„,و¯”ه¦‚ IEEE 754 çڑ„وµ®ç‚¹è§£é‡ٹو ‡ه‡†â€¦â€¦etcم€‚وک¯ 64 ن½چè؟کوک¯ 32 ن½چ è؟کوک¯و›´ه¤§ï¼ŒهŒ…و‹¬ه¯¹é½گو–¹ه¼ڈç‰ï¼Œهگ¦هˆ™وˆ‘ن»¬çڑ„و•°وچ®ه°±ن¼ڑهڈ‘ç”ںن¸¢ه¤±ï¼Œن¸؛ن؛†è§£ه†³è؟™ن؛›é—®é¢ک,ه°±ه؟…é،»è¦پ وœ‰ن¸€ن؛›و ‡ه‡†ï¼Œه¤§ه®¶ç»ںن¸€و»،足ن»€ن¹ˆè§„范م€‚ن¸€و—¦ server و›´و–°ن؛† message field,而 client و²،وœ‰و›´و–°ï¼Œ é‚£ن¹ˆه°±ن¼ڑه‡؛çژ°ن¸چن¸€è‡´م€‚

و‰€ن»¥ï¼Œوˆ‘ن»¬éœ€è¦پ考虑 backward compatibility(و–°ن»£ç پهڈ¯ن»¥هژ»è¯»و—§ن»£ç په†™çڑ„و•°وچ®ï¼‰ï¼Œforward compatibility(و—§ن»£ç پهڈ¯ن»¥هژ»è¯»و–°ن»£ç په†™çڑ„و•°وچ®ï¼‰ï¼Œوˆ‘ن»¬ه°±è¦پ用 encoding çڑ„و–¹ه¼ڈ,وœ€و—©çڑ„ SUN ه…¬هڈ¸وڈگه‡؛ن؛† XDR,ن»ٹه¤©وˆ‘ن»¬ç”¨çڑ„ه¾ˆه¤ڑçڑ„وک¯ JSON,è؟کوœ‰ن¸€ن؛› google protocol buffersم€‚ن¸؛ن»€ن¹ˆن¸چ 用 language specific format ه‘¢ï¼ںو¯”ه¦‚ java وڈگن¾›ن؛†هژںç”ںçڑ„ serializable وژ¥هڈ£ï¼Œن¸€و—¦ç»§و‰؟ن؛†ه®ƒï¼Œه°± هڈ¯ن»¥هڈکوˆگه؛ڈهˆ—هŒ–,Python ن¹ںوœ‰ pickle,ن½†وک¯ç¼؛点ه°±وک¯وٹٹوˆ‘ن»¬è‡ھه·±ç»‘و»هœ¨وںگن¸ھè¯è¨€ن¸ٹن؛†ï¼Œه¹¶ن¸” ه…¼ه®¹و€§ن¹ںن¸چه¥½م€‚

è؟™ç§چو ¼ه¼ڈçڑ„ه¥½ه¤„ï¼ڑhuman-readable,easy to debugم€‚

ç¼؛点ï¼ڑ

1. ه…³é”®çڑ„و•°وچ®ç»“و„çڑ„ encoding ن¼ڑه‡؛çژ°ن؛Œن¹‰و€§ï¼Œو¯”ه¦‚ 12 è؟™ن¸ھو•°ه—وˆ‘ن»¬ن¸چçں¥éپ“ type وک¯ن»€ ن¹ˆï¼Œوک¯ signed è؟کوک¯ unsigned ن¹‹ç±»çڑ„م€‚

2. ه°±وک¯è¦پو”¯وŒپ binary çڑ„و–‡ن»¶è¯¥و€ژن¹ˆهٹ,وˆ‘ن»¬ن¸چه¾—ن¸چ转وچ¢وˆگهں؛ن؛ژ base64 çڑ„و ¼ه¼ڈ,ن½†وک¯ è؟™هڈˆوک¯و‰‹هٹ¨è¦پهپڑè؟™و ·çڑ„ن¸€ن¸ھ转وچ¢م€‚

3. ه†—ن½™ هœ¨ linux 里وœ‰ن¸ھهژںهˆ™ï¼Œن¸چه¸Œوœ›و„é€ ه¤چو‚çڑ„程ه؛ڈ而ه¸Œوœ›و„é€ ه‡؛ن¸€ç³»هˆ—ه°ڈ程ه؛ڈ,é€ڑè؟‡ç®،éپ“çڑ„ ه½¢ه¼ڈهژ»و‹¼هœ¨ن¸€èµ·م€‚هœ¨ç®،éپ“ن¼ 输çڑ„و—¶ه€™ه؟…é،»ن½؟用 asc2 و¥هپڑن¼ 输م€‚

ه½“وˆ‘ن»¬وٹٹن¸¤ن¸ھ procedure و‹†هˆ†وˆگهˆ†ه¸ƒه¼ڈçڑ„و—¶ه€™ï¼Œوˆ‘ن»¬ وٹٹو‹†çڑ„و–¹ه¼ڈ细هŒ–هˆ°ن؛†ه‡½و•°çڑ„ç²’ه؛¦ï¼Œوٹٹن¸چهگŒوœچهٹ،ه™¨çڑ„ه‡½و•°ن¸²هœ¨ن¸€èµ·م€‚è؟™وک¯وˆ‘ن»¬ن»¥هگژè¦په¦çڑ„ function as a service,ه‡½و•°هڈ¯ن»¥هœ¨وœچهٹ،ه™¨ن¸ٹن»»و„ڈçڑ„و¥ه›éƒ¨ç½²وˆ–è؟پ移,ه°±هڈ¯ن»¥وڈگهچ‡èµ„و؛گهˆ©ç”¨çژ‡ï¼Œ ه‡½و•°و€ژن¹ˆو‹†وک¯ن¸€ن¸ھه…³é”®ï¼Œو‹†çڑ„ن¸چه¥½ه°±ن¼ڑوٹٹن؛¤ن؛’频ç¹پçڑ„ن¸¤ن¸ھه‡½و•°ن»ژ function call و‹†وˆگ rpc é™چن½ژ55 و€§èƒ½م€‚

هœ¨ن¼ 输و•°وچ®çڑ„و—¶ه€™ï¼Œن¸چهگŒوœ؛ه™¨ه¯¹و•°وچ®çڑ„解é‡ٹوک¯ن¸چ相هگŒçڑ„,و‰€ن»¥وˆ‘ن»¬è¦په¯¹و•°وچ®é‡چو–°هژ»هپڑه؛ڈ هˆ—هŒ–م€‚ن¸ژو¤ç›¸ه¯¹çڑ„ه°±وک¯ binary format,ه¥½ه¤„ه°±وک¯ه¾ˆه®¹وک“هژ‹ç¼©م€په¾ˆç´§ه‡‘,ه¾ˆه؟«ه°±هڈ¯ن»¥هڈکوˆگه†…هک ن¸çڑ„و•°وچ®ç»“و„ï¼›ç¼؛点ه°±وک¯ن؛؛ç±»è¦پ读و‡‚ه°±ه¾ˆéڑ¾م€‚

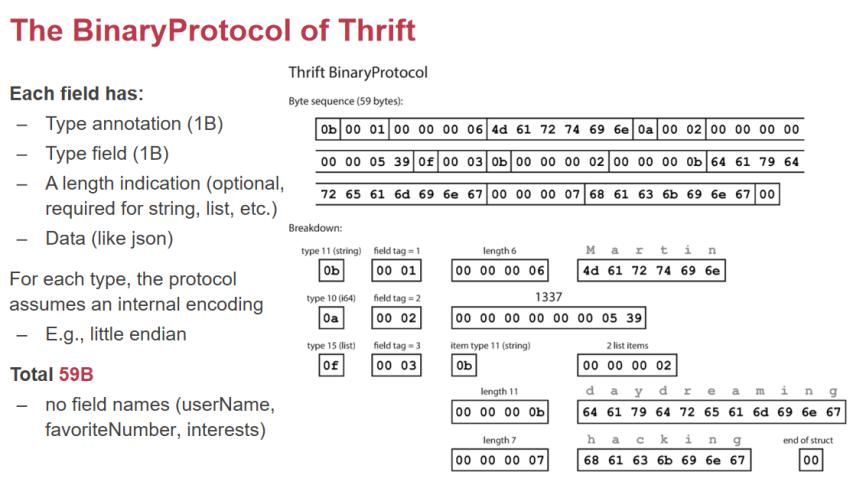

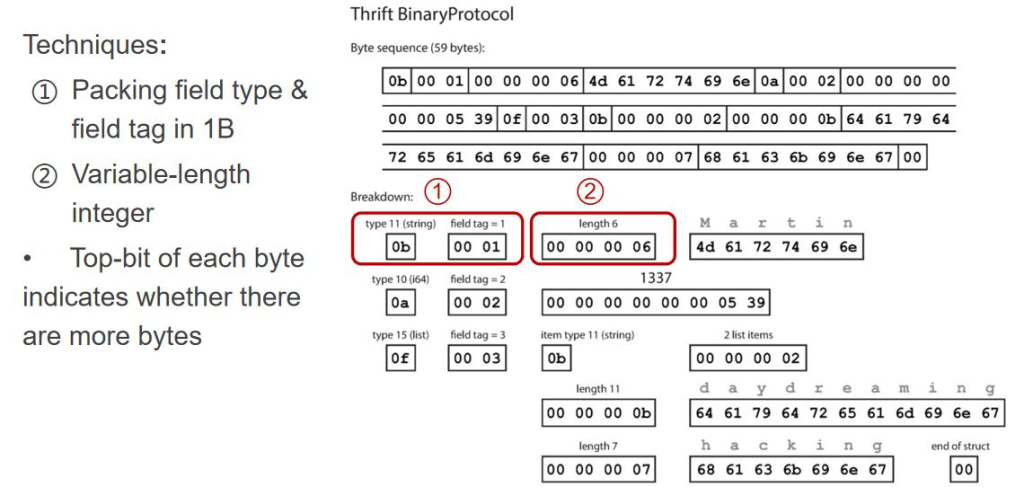

وˆ‘ن»¬هڈ¯ن»¥è؟›ن¸€و¥هژ»هژ‹ç¼©ï¼Œن¸؛ن»€ن¹ˆè¦پوٹٹ type و”¾هœ¨وœ€ه¤´ن¸ٹه‘¢ï¼Œè؟™ن¸ھé،؛ه؛ڈوک¯ه¾ˆه…³é”®çڑ„,ه½“وˆ‘ ن»¬هœ¨هپڑن¸€ن¸ھ server و”¶هˆ°ن¸€ن¸ھ request,ن¸€ه¼€ه§‹ن»€ن¹ˆéƒ½ن¸چçں¥éپ“,读هˆ°çڑ„第ن¸€ن¸ھ byte ه°±ه¾ˆه…³é”®ï¼Œ ه‘ٹ诉وˆ‘ن»¬هگژé¢وک¯ن¸€ن¸ھ string,è؟™ن¸ھ string وک¯ن¸€ن¸ھ 1 هڈ·ï¼ˆusername),وژ¥ن¸‹و¥ن¸²ن¸€ن¸ھ length=6, هگژو¥وک¯ن¼ 6 ن¸ھ byteم€‚然هگژوک¯ i64 ç±»ه‹â€¦â€¦ï¼Œçœںو£وœ‰ç”¨çڑ„و•°وچ®éƒ½وک¯ data,ه‰چé¢è؟™ن؛›و•°وچ®éƒ½وک¯ metadata,ن¸؛ن؛†ç»„织è؟™ن؛›و•°وچ®ï¼Œmetadata وک¯ه؟…需çڑ„م€‚

1. وٹٹ 3 ن¸ھ byte هڈکوˆگن¸€ن¸ھ byte,ه› ن¸؛ tag ن¸چن¼ڑه¤ھه¤§

2. Length ه¾ˆوµھ费,وˆ‘ن»¬هڈ¯ن»¥ç”¨ن¸€ن¸ھهڈکé•؟çڑ„ 8 ن½چ list,ن¹ںه°±وک¯و¯ڈ 8 ن½چه¦‚وœç¬¬ن¸€ن½چن¸؛ 1, 说وکژه‰©ن½™ 7 ن½چن¸وœ‰و•°ه—م€‚

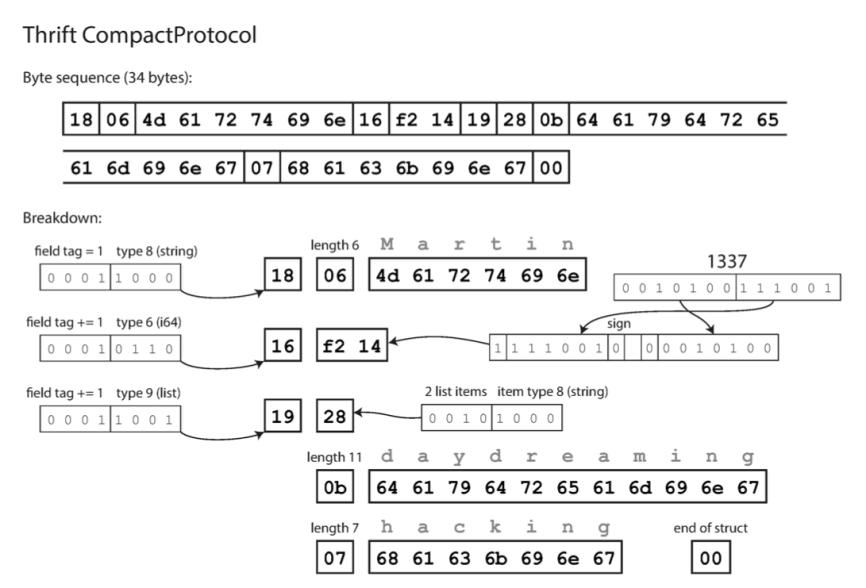

وœ€هگژ结وœه¦‚ن¸‹ï¼ڑ

é€ڑè؟‡è؟™ç§چو–¹ه¼ڈهڈ¯ن»¥وٹٹ tag ه’Œ type هژ‹ç¼©وˆگن¸€ن¸ھ byte,وœ€هگژه°±وک¯ 34 ن¸ھ byte ه°±وک¯è؟™ن¹ˆو¥çڑ„م€‚

Forward compatibilityï¼ڑوˆ‘ن»¬هڈھوƒ³è¦پن؟è¯پ field tag ه’Œ field type وک¯ه…¼ه®¹و€§هچ³هڈ¯ï¼Œè·³è؟‡ن¸چ认识 çڑ„ه—و®µم€‚

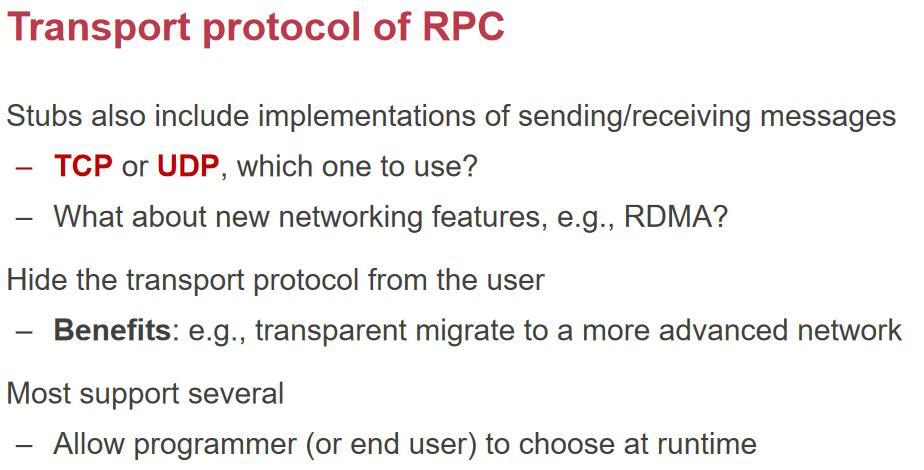

وˆ‘ن»¬ç®€هچ•و¥çœ‹ن¸€ن¸‹هڈ‚و•°ن¼ 递çڑ„ه°ڈèٹ‚ï¼ڑhuman-readable ه’Œو•ˆçژ‡çڑ„وƒè،،م€پوœ€çںè¶ٹه¥½م€پن؟è¯په…¼ ه®¹و€§م€‚و•´ن¸ھه؛ڈهˆ—هŒ–çڑ„è؟‡ç¨‹وک¯è‡ھهٹ¨çڑ„م€‚用وˆ·هڈھ需è¦پوڈگن¾› IDL هژ»ه†™è؟™ن¸ھ结و„م€‚هœ¨وœ€ه؛•ن¸‹è؟کè¦پ考虑 وک¯ TCP è؟کوک¯ UDP,ن¸چه®¹وک“ن¸¢هŒ…çڑ„وƒ…ه†µن¸‹ه°±هڈ¯ن»¥ن½؟用 UDPم€‚

ç”ڑ至هڈ¯ن»¥ن½؟用 RDMA(direct memory access)م€‚ه½“用وˆ·ن½؟用çڑ„و—¶ه€™ï¼Œوˆ‘ن»¬ن¸چ用ه…³ç³»ه؛•ه±‚ çڑ„网络ه®çژ°م€‚

éپ‡هˆ° Failure

ه½“ RPC éپ‡هˆ° FAILURE و€ژن¹ˆهٹï¼ںه¯¹ن؛ژن¸€ن¸ھ local çڑ„ procedure call çڑ„وƒ…ه†µن¸‹ï¼Œfailure çڑ„وƒ…ه†µ ن¸‹وک¯ه¾ˆه°‘çڑ„,ه¦‚وœè°ƒç”¨ه‡½و•°çڑ„وƒ…ه†µéƒ½ه‡؛é”™ن؛†è¯´وکژوœ؛ه™¨ه·²ç»ڈه‡؛ن؛†ه¾ˆه¤§çڑ„é—®é¢کم€‚Call ه°±وک¯وٹٹهœ°ه€ هژ‹و ˆè·³è½¬هˆ°ه¯¹ن؛ژçڑ„ه‡½و•°هœ°ه€هژ»و‰§è،Œï¼Œه¦‚وœè؟™ç§چوƒ…ه†µن¸‹éƒ½ه‡؛é”™ن؛†ï¼Œè¯´وکژè؟™ن¸ھè®،ç®—وœ؛وœ‰ه¾ˆه¤§çڑ„é—® é¢کن؛†ï¼Œè؟™ن¸ھ程ه؛ڈهں؛وœ¬ن¸ٹن¼ڑ被 kill وژ‰ï¼Œن¸€èˆ¬و¥è¯´وˆ‘ن»¬ن¸چهژ»è€ƒè™‘ call ه¸¦و¥çڑ„é—®é¢کم€‚é‚£ن¹ˆه¦‚وœهڈکوˆگ ن؛† RPC,éپ‡هˆ°é—®é¢کçڑ„و¦‚çژ‡è؟œè؟œه¤§ن؛ژوœ¬هœ°çڑ„调用م€‚ه؛ڈهˆ—هŒ–ه‡؛é”™م€پRPC 版وœ¬ه‡؛é”™م€په¯¹و–¹ server crashم€پ 网络ه‡؛错,ه½“ن¸€ن¸ھ RPC 调用و²،وœ‰ه¾—هˆ°ن»»ن½•è؟”ه›çڑ„و—¶ه€™ï¼Œوœ‰ن»¥ن¸‹وƒ…ه†µ

- 1. 网络问é¢ک,هŒ…و²،وœ‰هˆ° serverم€‚

- 2. Server çڑ„ response و²،وœ‰ه›هˆ° clientم€‚ وˆ‘ن»¬و²،وœ‰هٹو³•هŒ؛هˆ†ه‡؛ن¸ٹé¢ن¸¤è€…م€‚

- 3. è؟œç¨‹ crash

- 4. Request éکںهˆ—

- 5. è؟œç¨‹و‰§è،Œن؛†ï¼Œن½†وک¯ن½ 超و—¶ن؛†

- 6. و‰§è،Œن؛†ï¼Œè؟کهœ¨ delay ç‰ه¾… RPC 调用ن»¥هگژç‰ه¤ڑن¹…ï¼ںè؟™ن¸ھو—¶é—´ه°±ه¾ˆ tricky,هڈھ能و ¹وچ®ç»ڈéھŒو¥è®¾ç½®م€‚

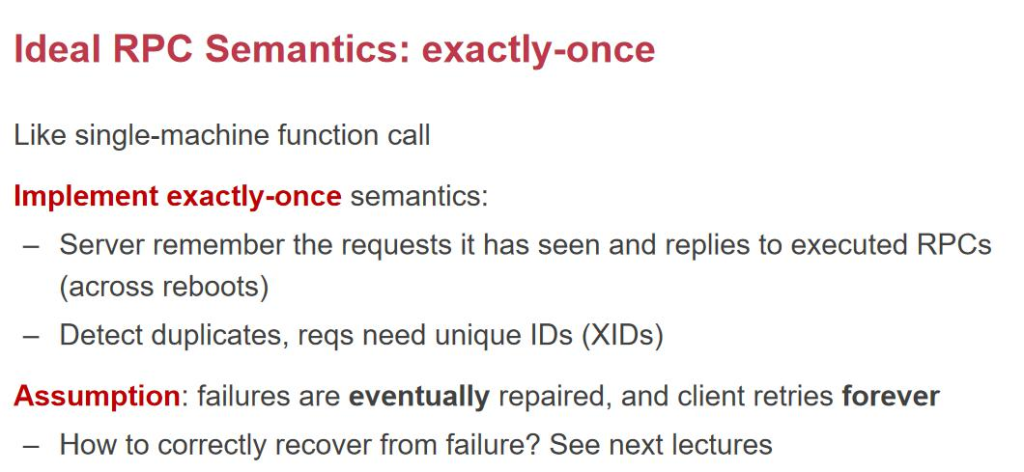

ه¯¹ن؛ژ RPC و¥è¯´ï¼Œن¼ڑ return ن¸€ن¸ھ错误 statusم€‚RPC çڑ„وœںوœ›ç»“وœï¼Œexactly once,وˆ‘ن»¬ن¼ڑéپ‡هˆ°ï¼ڑ 0 و¬،,server و²،و‰§è،Œ 1 و¬،,و£ه¸¸ 1 و¬،وˆ–ه¤ڑو¬،,client هڈ¯èƒ½ç‰ن¸چهڈٹن؛†ه†چهڈ‘ن¸€و¬،م€‚ و‰€ن»¥ RPC ن¸€èˆ¬وڈگن¾› at least once(و²،و”¶هˆ° response ه°±é‡چ试,直هˆ° ok)ه’Œ at most once(هڈھ هڈ‘é€پن¸€و¬،) ه¹‚ç‰و€§ï¼ڑوˆ‘ن»¬ه¸Œوœ›ه®çژ° at most once,وˆ‘ن»¬èƒ½ن¸چ能让ن¸€ن¸ھو“چن½œو‰§è،Œن¸€و¬،ه’Œو‰§è،Œن¸¤و¬،وک¯ن¸€ و ·çڑ„م€‚و¯”ه¦‚وŒ‰ç”µو¢¯ï¼ڑوŒ‰ن¸‰و¬،ه’ŒوŒ‰ن¸€و¬،وک¯ن¸€و ·çڑ„,ن½†وک¯هکé’±ن¸چوک¯ه¹‚ç‰çڑ„م€‚ه¦‚وœه®çژ°ن¸چن؛†ه¹‚ç‰و€§ï¼Œ و€ژن¹ˆه®çژ° at most once ه‘¢ï¼Œوˆ‘ن»¬è¦پوœ‰هˆ«çڑ„وœ؛هˆ¶هژ»è®°ه½•م€‚Server هڈ¯ن»¥وٹٹو‰§è،Œوˆگهٹںçڑ„ xid è®°ه½•ن¸‹ و¥ï¼Œه¦‚وœهڈ‘çژ°ه·²ç»ڈهپڑè؟‡ن؛†é‚£ه°±è؟”ه› OKم€‚

RPC وœ‰ه¾ˆه¤ڑ component,هœ¨ç½‘络ن¸ٹن¼ 输çڑ„و ¼ه¼ڈè¦پوœ‰و ‡ه‡†ï¼Œوˆ‘ن»¬é€ڑè؟‡ lib و¥ه®çژ°ه؛•ه±‚细èٹ‚ stub,ه®ڑن¹‰ه®Œن؛† IDL هگژ,وˆ‘ن»¬ه°±هڈ¯ن»¥è‡ھهٹ¨ن؛§ç”ںن¸€ن؛› stub code,然هگژهژ»هپڑه؛ڈهˆ—هŒ–,server ه°±وک¯ هژ» reply,server çڑ„ framework ن¼ڑوٹٹ message dispatch هˆ°ن¸چهگŒçڑ„ server ن¸م€‚ 超و—¶و–¹و،ˆï¼ڑè¦پ设置ن¸€ن¸ھ超و—¶و—¶é—´م€‚

NFS

- NFS وک¯ن»€ن¹ˆï¼ڑNFS وک¯ن¸€ç§چهˆ†ه¸ƒه¼ڈو–‡ن»¶ç³»ç»ںهچڈ议,ه…پ许ه®¢وˆ·ç«¯é€ڑè؟‡ç½‘络è®؟é—®è؟œç¨‹وœچهٹ،ه™¨ن¸ٹçڑ„و–‡ن»¶ï¼Œهƒڈو“چن½œوœ¬هœ°و–‡ن»¶ن¸€و ·ن½؟用è؟™ن؛›و–‡ن»¶م€‚

- هں؛وœ¬هژںçگ†ï¼ڑه®¢وˆ·ç«¯ه°†è؟œç¨‹وœچهٹ،ه™¨çڑ„و–‡ن»¶ç³»ç»ں“وŒ‚è½½â€هˆ°وœ¬هœ°ï¼Œé€ڑè؟‡ç½‘络è؟›è،Œو–‡ن»¶çڑ„读هڈ–م€په†™ه…¥ç‰و“چن½œم€‚

- و— çٹ¶و€پ设è®،ï¼ڑNFS وœچهٹ،ه™¨ن¸چن؟ç•™ه®¢وˆ·ç«¯çڑ„çٹ¶و€پن؟،وپ¯ï¼Œو¯ڈو¬،请و±‚独立ه¤„çگ†ï¼Œوœچهٹ،ه™¨ه´©و؛ƒهگژو— 需وپ¢ه¤چه®¢وˆ·ç«¯çٹ¶و€پم€‚

- 缓هکوœ؛هˆ¶ï¼ڑن¸؛ن؛†وڈگé«کو€§èƒ½ï¼Œه®¢وˆ·ç«¯هڈ¯ن»¥ç¼“هکو–‡ن»¶و•°وچ®ï¼Œه‡ڈه°‘è®؟é—®وœچهٹ،ه™¨çڑ„و¬،و•°م€‚

é—®é¢ک

- ه®¹é‡ڈé™گهˆ¶ï¼ڑهڈھ能ن¾èµ–هچ•ن¸ھوœچهٹ،ه™¨ن¸ٹçڑ„ç£پç›ک,ه®¹é‡ڈوœ‰é™گم€‚

- هڈ¯é و€§é—®é¢کï¼ڑه¦‚وœوœچهٹ،ه™¨ه´©و؛ƒï¼Œè؟œç¨‹و–‡ن»¶ه°†و— و³•è®؟é—®م€‚

- و€§èƒ½é—®é¢کï¼ڑو–‡ن»¶çڑ„و€§èƒ½هڈ—é™گن؛ژهچ•ن¸ھو–‡ن»¶çڑ„و“چن½œن»¥هڈٹهچ•ن¸€çڑ„网络ه¸¦ه®½م€‚

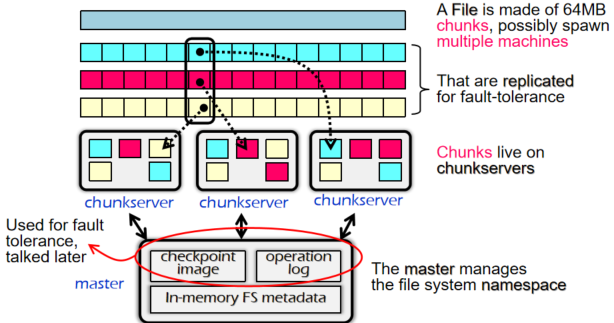

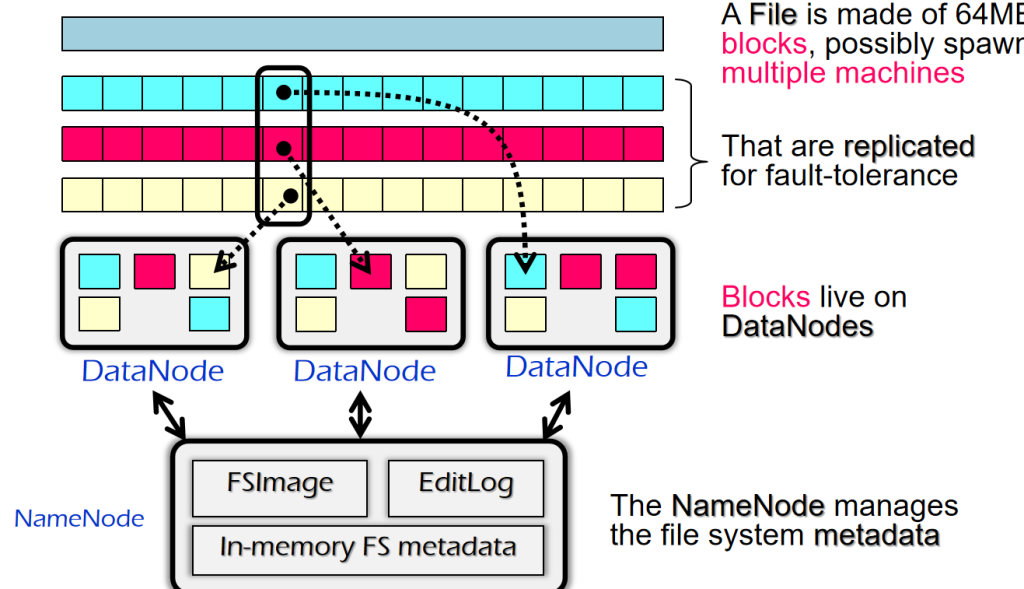

GFS

GFS(Google File System)وک¯ن¸“ن¸؛هˆ†ه¸ƒه¼ڈه¤§è§„و¨،و•°وچ®هکه‚¨è®¾è®،çڑ„و–‡ن»¶ç³»ç»ں,解ه†³ن؛†هœ¨ن¼ ç»ںو–‡ن»¶ç³»ç»ںن¸éڑ¾ن»¥ه؛”ه¯¹çڑ„ه®¹é‡ڈم€پهڈ¯é و€§ه’Œو€§èƒ½é—®é¢کم€‚ه…¶ه®çژ°و–¹ه¼ڈهڈ¯ن»¥هˆ†ن¸؛ن»¥ن¸‹ه‡ ن¸ھه…³é”®ç‚¹ï¼ڑ

و€»ن½“ه®çژ°

1. هˆ†ه¸ƒه¼ڈو¶و„

GFS 采用هˆ†ه¸ƒه¼ڈو–‡ن»¶ç³»ç»ںو¶و„م€‚و–‡ن»¶è¢«هˆ†ه‰²وˆگه¤ڑن¸ھ较ه¤§çڑ„و•°وچ®ه—(é€ڑه¸¸ن¸؛64 MB),و¯ڈن¸ھه—هکه‚¨هœ¨ن¸چهگŒçڑ„وœچهٹ،ه™¨ï¼ˆç§°ن¸؛Chunkserver)ن¸ٹم€‚è؟™و ·ï¼Œé€ڑè؟‡ه°†و–‡ن»¶هˆ†ه¸ƒهˆ°ه¤ڑن¸ھوœچهٹ،ه™¨ï¼Œهڈ¯ن»¥ه¤§ه¹…وڈگهچ‡ç³»ç»ںçڑ„هکه‚¨ه®¹é‡ڈه’Œو€§èƒ½ï¼Œè½»و¾و‰©ه±•و•´ن¸ھ集群çڑ„ه®¹é‡ڈم€‚

2. ن¸»èٹ‚点ç®،çگ†

GFS ن½؟用ن¸€ن¸ھن¸»èٹ‚点(Master node)و¥ç®،çگ†و–‡ن»¶ن¸ژه—(Chunk)ن¹‹é—´çڑ„وک ه°„ه…³ç³»م€‚ن¸»èٹ‚点هکه‚¨ن؛†و–‡ن»¶ç›®ه½•ه’Œو¯ڈن¸ھو–‡ن»¶ه—çڑ„ن½چ置,ه®¢وˆ·ç«¯é€ڑè؟‡ن¸ژن¸»èٹ‚点çڑ„ن؛¤ن؛’و‰¾هˆ°و‰€éœ€çڑ„و–‡ن»¶ه—هگژ,直وژ¥ن¸ژ Chunkserver è؟›è،Œو•°وچ®ن؛¤وچ¢م€‚è؟™ç§چ设è®،简هŒ–ن؛†و–‡ن»¶çڑ„وں¥و‰¾ه’Œç®،çگ†م€‚

3. ه¤ڑه‰¯وœ¬وœ؛هˆ¶

ن¸؛ن؛†وڈگé«کهڈ¯é و€§ï¼Œو¯ڈن¸ھو–‡ن»¶ه—هœ¨ن¸چهگŒçڑ„ Chunkserver ن¸ٹوœ‰ه¤ڑن¸ھه‰¯وœ¬ï¼ˆé€ڑه¸¸ن¸؛3ن¸ھ)م€‚ه½“ن¸€ن¸ھوœچهٹ،ه™¨هڈ‘ç”ںو•…éڑœو—¶ï¼Œه®¢وˆ·ç«¯هڈ¯ن»¥ن»ژه…¶ن»–ه‰¯وœ¬ن¸èژ·هڈ–و•°وچ®ï¼Œن؟è¯پو–‡ن»¶ن¸چن¼ڑه› ن¸؛هچ•ç‚¹و•…éڑœè€Œن¸¢ه¤±م€‚è؟™ç§چه‰¯وœ¬وœ؛هˆ¶è®© GFS هœ¨é¢ه¯¹ç،¬ن»¶و•…éڑœو—¶ن¾ç„¶èƒ½ه¤ںن؟وŒپé«کهڈ¯ç”¨و€§م€‚

4. ه¹¶è،Œè¯»ه†™

GFS و”¯وŒپه¹¶è،Œè¯»ه†™و“چن½œï¼Œه¤ڑن¸ھه®¢وˆ·ç«¯هڈ¯ن»¥هگŒو—¶ن»ژن¸چهگŒçڑ„ Chunkserver 读هڈ–و–‡ن»¶ه—م€‚é€ڑè؟‡ه¹¶è،ŒهŒ–读ه†™ï¼ŒGFS ه¤§ه¤§وڈگé«کن؛†و–‡ن»¶è®؟é—®çڑ„و•ˆçژ‡ï¼Œه°¤ه…¶هœ¨ه¤„çگ†ه¤§و–‡ن»¶و—¶ï¼Œèƒ½ه¤ںه……هˆ†هˆ©ç”¨ç½‘络ه¸¦ه®½ه’Œوœچهٹ،ه™¨çڑ„è®،算能هٹ›م€‚

5. و¾و•£ن¸€è‡´و€§و¨،ه‹

GFS 采用ن؛†ن¸€ç§چ و¾و•£ن¸€è‡´و€§و¨،ه‹ ,ه…پ许هœ¨ن¸€ه®ڑو—¶é—´ه†…و•°وچ®ه¤„ن؛ژن¸چن¸€è‡´çٹ¶و€پم€‚è؟™ç§چو¨،ه‹é€ڑè؟‡ن¸»èٹ‚点هچڈè°ƒه†™و“چن½œï¼Œç،®ن؟و•°وچ®وœ€ç»ˆèƒ½ه¤ںهœ¨ه¤ڑن¸ھه‰¯وœ¬ن¹‹é—´è¾¾وˆگن¸€è‡´و€§م€‚虽然و”¾ه®½ن؛†ن¸€éƒ¨هˆ†ن¸€è‡´و€§è¦پو±‚,ن½†è؟™ç§چ设è®،能ه¤ںوڈگé«کç³»ç»ںçڑ„ه†™ه…¥و€§èƒ½م€‚

6. ه®¹é”™ه’Œوپ¢ه¤چوœ؛هˆ¶

GFS ه…·وœ‰ه¾ˆه¼؛çڑ„ه®¹é”™èƒ½هٹ›ï¼Œç³»ç»ںن¼ڑه®ڑوœںو£€وµ‹ Chunkserver çڑ„çٹ¶و€پ,ه¦‚وœهڈ‘çژ°وںگن¸ھه‰¯وœ¬ن¸¢ه¤±وˆ–وœچهٹ،ه™¨و•…éڑœï¼Œن¸»èٹ‚点ن¼ڑè‡ھهٹ¨وŒ‡و´¾ه…¶ن»–وœچهٹ،ه™¨é‡چو–°هˆ›ه»؛该ه‰¯وœ¬ï¼Œن؟è¯پو•°وچ®çڑ„ه®Œو•´و€§ه’Œهڈ¯ç”¨و€§م€‚

و“چن½œ

GFS و²،وœ‰و ‡ه‡†çڑ„و“چن½œç³»ç»ںç؛§هˆ« API,ن¹ںو²،وœ‰ه®Œو•´çڑ„ POSIX APIم€‚ه®ƒوڈگن¾›çڑ„وک¯ 用وˆ·ç؛§ API م€‚

و”¯وŒپçڑ„و“چن½œï¼ڑ

- هں؛وœ¬و“چن½œï¼ڑcreate/delete/open/close/read/write(هˆ›ه»؛م€پهˆ 除م€پو‰“ه¼€م€په…³é—م€پ读هڈ–م€په†™ه…¥ï¼‰م€‚

- é¢ه¤–و“چن½œï¼ڑsnapshot/append(ه؟«ç…§م€پè؟½هٹ )م€‚

ن¸چو”¯وŒپçڑ„و“چن½œï¼ڑ

- 链وژ¥ï¼ˆlink)م€پ符هڈ·é“¾وژ¥ï¼ˆsymlink)م€پé‡چه‘½هگچ(rename)م€‚

相ه…³é—®é¢ک

GFSهڈھ用ن¸€ن¸ھmaster,ن¸؛ن»€ن¹ˆï¼ں

هڈ¯ن»¥ن½؟ه¾—设è®،简هچ•ï¼Œه› ن¸؛Googleو¯ڈن¸€ن¸ھه—ه¤§ه°ڈ64M,و‰€ن»¥éœ€è¦پç»´وٹ¤çڑ„ه—و•°é‡ڈن¸چه¤§ï¼Œهڈ¯ن»¥هپڑهˆ°ه†…هکه°±ه®Œوˆگن»»هٹ،م€‚

- و‰€وœ‰ه…ƒو•°وچ®هکه‚¨هœ¨ن¸»èٹ‚点çڑ„ه†…هکن¸

- 超ه؟«é€ںè®؟é—®

- هگچ称هˆ°ه—çڑ„وک ه°„

- ن½؟用ه†…هکن¸çڑ„و ‘结و„هکه‚¨

- هگŒو—¶هœ¨ç£پç›کن¸ٹçڑ„و“چن½œو—¥ه؟—ن¸وŒپن¹…هŒ–(و¯”ه¦‚ن¸»وœ؛وŒ‚ن؛†ï¼Œن»چ然هڈ¯ن»¥وپ¢ه¤چ,هگژç»ç« èٹ‚ن¼ڑ讨è®؛)

- ه—IDهˆ°ه—ن½چç½®çڑ„وک ه°„

- هکه‚¨هœ¨ه†…هکن¸ï¼Œن¸چ需è¦پو—¥ه؟—è®°ه½•

- هگ¯هٹ¨و—¶ن»ژو‰€وœ‰ه—وœچهٹ،ه™¨وں¥è¯¢ï¼ˆè¯¢é—®ه—çڑ„ن؟،وپ¯ï¼Œه؟«é€ںوژŒوڈ،و¯ڈن¸€ن¸ھChunkSercerن؟،وپ¯ï¼‰

- ن؟وŒپوœ€و–°çٹ¶و€پ ï¼ڑ ن¸»èٹ‚点è´ںè´£ç®،çگ†و‰€وœ‰ه†…ه®¹

ن؛¤ن؛’و¨،ه‹

GFSه®¢وˆ·ç«¯ن»£ç پهµŒه…¥هˆ°و¯ڈن¸ھه؛”用程ه؛ڈن¸

- و²،وœ‰و“چن½œç³»ç»ںç؛§هˆ«çڑ„API

ن¸ژن¸»èٹ‚点ن؛¤ن؛’è؟›è،Œه…ƒو•°وچ®ç›¸ه…³و“چن½œ

- ç›´وژ¥ن¸ژه—وœچهٹ،ه™¨ن؛¤ن؛’ن»¥ه¤„çگ†و•°وچ®

ن¸»èٹ‚点ن¸چوک¯و€§èƒ½ç“¶é¢ˆ

- ن¸»èٹ‚点ن»…è´ںè´£ه…ƒو•°وچ®ç®،çگ†ï¼Œن¸چهڈ‚ن¸ژه®é™…و•°وچ®ن¼ 输

و²،وœ‰و•°وچ®ç¼“هک

- ه®¢وˆ·ç«¯ه’Œه—وœچهٹ،ه™¨éƒ½ن¸چ缓هکو•°وچ®

- ه”¯ن¸€ن¾‹ه¤–وک¯ç³»ç»ں缓ه†²هŒ؛缓هک

و²،وœ‰و•°وچ®ç¼“هکهژںه›

- ه¤§و–‡ن»¶é€ڑه¸¸و²،وœ‰ه¤ھه¤ڑ缓هکçڑ„وœ؛ن¼ڑ

ه®¢وˆ·ç«¯ç¼“هکه…ƒو•°وچ®

- ن¾‹ه¦‚و–‡ن»¶ه—çڑ„ن½چç½®

读و“چن½œ

- èپ”ç³»ن¸»èٹ‚点(master)

- ه®¢وˆ·ç«¯é¦–ه…ˆن¸ژن¸»èٹ‚点é€ڑن؟،èژ·هڈ–و–‡ن»¶çڑ„相ه…³ن؟،وپ¯م€‚

- èژ·هڈ–و–‡ن»¶çڑ„ه…ƒو•°وچ®ï¼ˆmetadata)ï¼ڑه—هڈ¥وں„(chunk handles)

- ن¸»èٹ‚点è؟”ه›و–‡ن»¶çڑ„ه…ƒو•°وچ®ï¼Œç‰¹هˆ«وک¯ه—هڈ¥وں„çڑ„ن؟،وپ¯م€‚ه¦‚وœه…ƒو•°وچ®ه·²ç»ڈ被缓هک,و¤و¥éھ¤هڈ¯ن»¥è¢«è·³è؟‡م€‚

èژ·هڈ–و¯ڈن¸ھه—هڈ¥وں„çڑ„ن½چ置(location)

- ن¸»èٹ‚点è؟”ه›و–‡ن»¶çڑ„ه…ƒو•°وچ®ï¼Œç‰¹هˆ«وک¯ه—هڈ¥وں„çڑ„ن؟،وپ¯م€‚ه¦‚وœه…ƒو•°وچ®ه·²ç»ڈ被缓هک,و¤و¥éھ¤هڈ¯ن»¥è¢«è·³è؟‡م€‚

- ه®¢وˆ·ç«¯èژ·هڈ–è؟™ن؛›ه—و‰€هœ¨çڑ„وœچهٹ،ه™¨ن½چç½®م€‚و¯ڈن¸ھه—هڈ¯èƒ½هœ¨ه¤ڑن¸ھه‰¯وœ¬وœچهٹ،ه™¨ï¼ˆchunkserver)ن¸ٹوœ‰هکه‚¨ه‰¯وœ¬م€‚

- èپ”ç³»

ن»»ن½•هڈ¯ç”¨çڑ„ه—وœچهٹ،ه™¨ï¼ˆchunkserver)èژ·هڈ–ه—و•°وچ®ï¼ˆه¤ڑن¸ھوœچهٹ،ه™¨ن¸ن»»و„ڈن¸€ن¸ھهچ³هڈ¯ï¼Œه› ن¸؛ه¤‡ن»½è؟‡ï¼‰

- èپ”ç³»

- ه®¢وˆ·ç«¯ن»ژن»»و„ڈهڈ¯ç”¨çڑ„ه—وœچهٹ،ه™¨è¯·و±‚ه¹¶èژ·هڈ–و‰€éœ€çڑ„و•°وچ®ه—م€‚(çœںو£ه¼€ه§‹è¯»ï¼‰

ه†™و“چن½œ

- ه†™و“چن½œçڑ„ه¤چو‚و€§ï¼ڑن¸ژ读هڈ–相و¯”,ه†™و“چن½œن¸چه¤ھ频ç¹پ,ن½†و›´ه¤چو‚,ه› ن¸؛需è¦په¤„çگ†ن¸€è‡´و€§é—®é¢کم€‚

- ن¸€è‡´و€§و¨،ه‹ï¼ڑGFS 采用ن؛†ن¸€ç§چو¾و•£ن¸€è‡´و€§و¨،ه‹ï¼Œن½؟ه¾—ه®çژ°و›´هٹ 简هچ•é«کو•ˆم€‚(هڈ¯èƒ½و²،وœ‰è¯»هˆ°هˆڑه†™ه…¥çڑ„ن¸œè¥؟,وˆ–وک¯هگŒو—¶ه†™ن¸€ن¸ھن¸œè¥؟و—¶ه€™ï¼Œن؛Œè€…ن؛§ç”ںن؛†ه†²çھپ)

- 设è®،ç›®و ‡ï¼ڑ

- و¯ڈن¸ھه‰¯وœ¬وœ€ç»ˆو‹¥وœ‰ç›¸هگŒçڑ„و•°وچ®م€‚(وœ€ç»ˆن¸€è‡´و¨،ه‹ï¼‰

- ه‡ڈه°‘ن¸ژن¸»èٹ‚点çڑ„é€ڑن؟،م€‚

ن¸؛ن؟è¯پن¸€è‡´و€§éœ€è¦پهچڈè°ƒه†™و“چن½œ

ن¸؛ن»€ن¹ˆéœ€è¦پهچڈè°ƒï¼ں

- 考虑هˆ°ه¹¶هڈ‘ه†™ه…¥çڑ„وƒ…ه†µï¼Œه¤ڑن¸ھه®¢وˆ·ç«¯هڈ¯èƒ½هگŒو—¶ه¯¹هگŒن¸€ن¸ھه—è؟›è،Œه†™و“چن½œï¼Œه¦‚وœن¸چè؟›è،Œهچڈ调,هڈ¯èƒ½ن¼ڑه¯¼è‡´و•°وچ®ن¸چن¸€è‡´م€‚ه› و¤ï¼Œه؟…é،»ç”±ن¸€ن¸ھن¸»ه‰¯وœ¬و¥هچڈè°ƒه†™ه…¥é،؛ه؛ڈم€‚

ه¦‚ن½•é€‰و‹©ن¸»ه‰¯وœ¬ï¼ں

- وˆ‘ن»¬ن¸چ能直وژ¥وŒ‡ه®ڑن¸€ن¸ھن¸»ه‰¯وœ¬ï¼Œه› ن¸؛ن¸»ه‰¯وœ¬هڈ¯èƒ½ن¼ڑهڈ‘ç”ںو•…éڑœم€‚

解ه†³و–¹و،ˆ

- ن¸»èٹ‚点(Master)ن¼ڑهگ‘وںگن¸ھه‰¯وœ¬وژˆن؛ˆن¸€ن¸ھه—ç§ںç؛¦ï¼ˆChunk Lease),让è؟™ن¸ھه‰¯وœ¬وˆگن¸؛ن¸»ه‰¯وœ¬ï¼ˆPrimary Chunkserver)م€‚

- è؟™ن¸ھن¸»ه‰¯وœ¬وک¯ه”¯ن¸€èƒ½ه¤ںن؟®و”¹ه—(chunk)çڑ„ه‰¯وœ¬م€‚ه› و¤ï¼Œو‰€وœ‰çڑ„ه†™ن؟®و”¹éƒ½ه°†è¦پهڈ‘هˆ°è؟™é‡Œم€‚

- ه¦‚وœéœ€è¦پ,ن¸»ه‰¯وœ¬هڈ¯ن»¥è¯·و±‚ه»¶é•؟ç§ںç؛¦çڑ„و—¶é—´م€‚

- ن¸»èٹ‚点ن¼ڑه¢هٹ 该ه—çڑ„版وœ¬هڈ·ï¼Œه¹¶é€ڑçں¥ه…¶ن»–ه‰¯وœ¬è؟›è،ŒهگŒو¥م€‚

ه…·ن½“è؟‡ç¨‹

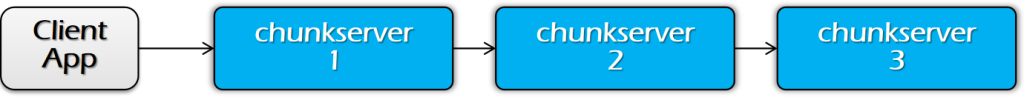

éک¶و®µ 1ï¼ڑهڈ‘é€پو•°وچ®

- ن¼ 输و•°وچ®ï¼Œن½†ن¸چه†™ه…¥و–‡ن»¶م€‚

- ه®¢وˆ·ç«¯ن¼ڑه¾—هˆ°ن¸€ن¸ھه‰¯وœ¬هˆ—è،¨ï¼Œو ‡è¯†ن¸»ه‰¯وœ¬ï¼ˆPrimary)ه’Œو¬،ç؛§ه‰¯وœ¬ï¼ˆSecondary)م€‚

- ه®¢وˆ·ç«¯ه°†و•°وچ®ه†™ه…¥وœ€è؟‘çڑ„ه‰¯وœ¬م€‚

- ç®،éپ“ه¼ڈ转هڈ‘ï¼ڑه‰¯وœ¬وœچهٹ،ه™¨é€ڑè؟‡وµپو°´ç؛؟و–¹ه¼ڈ转هڈ‘و•°وچ®م€‚(هڈ¯ن»¥ه‡ڈه°ڈهچ•ن¸ھن¼ 输و•°وچ®هژ‹هٹ›ï¼‰

- ه—وœچهٹ،ه™¨ه°†و•°وچ®هکه‚¨هœ¨ç¼“هکن¸ï¼ˆه†…هکن¸ï¼‰م€‚

éک¶و®µ 2ï¼ڑه†™ه…¥و•°وچ®

- ه°†و•°وچ®و·»هٹ هˆ°و–‡ن»¶ن¸ï¼ˆوڈگن؛¤ï¼‰م€‚

- ه®¢وˆ·ç«¯ç‰ه¾…و‰€وœ‰ه‰¯وœ¬ç،®è®¤ه·²ç»ڈو”¶هˆ°و•°وچ®م€‚

- ه®¢وˆ·ç«¯هگ‘ن¸»ه‰¯وœ¬ï¼ˆPrimary)هڈ‘é€په†™è¯·و±‚م€‚

- ن¸»ه‰¯وœ¬ï¼ˆPrimary)è´ںè´£ه؛ڈهˆ—هŒ–ه†™و“چن½œï¼ˆه…ˆه؛”用ه†™و“چن½œï¼Œç„¶هگژ转هڈ‘ç»™ه…¶ن»–ه‰¯وœ¬ï¼‰م€‚

- ه½“و‰€وœ‰ç،®è®¤ï¼ˆack)都و”¶هˆ°هگژ,ن¸»ه‰¯وœ¬هگ‘ه®¢وˆ·ç«¯هڈ‘é€پç،®è®¤م€‚

و€»ç»“

و•°وچ®وµپ(éک¶و®µ 1)ه’Œوژ§هˆ¶وµپ(éک¶و®µ 2)وک¯ن¸چهگŒçڑ„

- و•°وچ®وµپ(Phase 1)

- è·¯ه¾„ï¼ڑه®¢وˆ·ç«¯ï¼ˆClient)→ ه—وœچهٹ،ه™¨ï¼ˆChunkserver)→ ه—وœچهٹ،ه™¨ï¼ˆChunkserver)→ …(é€ڑè؟‡وµپو°´ç؛؟و–¹ه¼ڈ转هڈ‘و•°وچ®ï¼‰

- é،؛ه؛ڈï¼ڑو•°وچ®وµپçڑ„é،؛ه؛ڈو— ه…³ç´§è¦پ,و•°وچ®هڈ¯ن»¥هœ¨ن¸چهگŒçڑ„ه‰¯وœ¬é—´è‡ھç”±ن¼ 递م€‚

- وژ§هˆ¶وµپ(Phase 2)

- è·¯ه¾„ï¼ڑه®¢وˆ·ç«¯ï¼ˆClient)→ ن¸»ه‰¯وœ¬ï¼ˆPrimary)→ و‰€وœ‰و¬،ç؛§ه‰¯وœ¬ï¼ˆSecondaries)

- é،؛ه؛ڈï¼ڑه؟…é،»ن؟وŒپé،؛ه؛ڈ,ه°¤ه…¶وک¯هœ¨ه¤ڑن¸ھه®¢وˆ·ç«¯هگŒو—¶è؟›è،Œه†™و“چن½œو—¶ï¼Œن¸»ه‰¯وœ¬è´ںè´£ن؟è¯په†™و“چن½œçڑ„é،؛ه؛ڈم€‚

ه—版وœ¬هڈ·

- 用ن؛ژو£€وµ‹وںگن¸ھه‰¯وœ¬وک¯هگ¦وœ‰è؟‡وœںو•°وچ®م€‚

- ن¸»ه‰¯وœ¬ï¼ˆPrimary Chunkserver)维وٹ¤ه—çڑ„版وœ¬هڈ·م€‚(é‡چهگ¯و—¶ه€™هڈ¯ن»¥هˆ¤و–و›؟وچ¢ï¼‰

- ه¦‚وœو£€وµ‹هˆ°وںگن¸ھه‰¯وœ¬çڑ„و•°وچ®وک¯è؟‡وœںçڑ„,ه®ƒه°†è¢«و›؟وچ¢م€‚

و€»ç»“

- ه¤§ه¤ڑو•°و–‡ن»¶وک¯è؟½هٹ çڑ„,而ن¸چوک¯è¦†ç›–ï¼ڑ

- هژںه› ï¼ڑن¾‹ه¦‚هگ‘ Google çڑ„ه…¨çگƒهکه‚¨ن¸و·»هٹ و–°çڑ„网é،µو•°وچ®ï¼Œé€ڑه¸¸وک¯è؟½هٹ 而ن¸چوک¯è¦†ç›–ه·²وœ‰و•°وچ®م€‚(هگŒو—¶ه†™è؟کوک¯ن¼ڑوœ‰é—®é¢ک,هڈ¯èƒ½ن¼ڑوœ‰è¦†ç›–وƒ…ه†µï¼‰

- و–‡ن»¶ه†…çڑ„éڑڈوœ؛ه†™ه…¥éه¸¸ه°‘è§پï¼ڑ

- è؟™و„ڈه‘³ç€وˆ‘ن»¬éœ€è¦پوڈگن¾›é«کو•ˆçڑ„è؟½هٹ و“چن½œم€‚

- è؟½هٹ و“چن½œه§‹ç»ˆوک¯ن¸€è‡´çڑ„ï¼ڑ

- هچ³ن½؟ GFS 采用çڑ„وک¯ن¸€ن¸ھ较ه¼±çڑ„ن¸€è‡´و€§و¨،ه‹ï¼Œو‰€وœ‰و–‡ن»¶وœ€ç»ˆéƒ½ن¼ڑن؟وŒپن¸€è‡´ï¼ˆو‰€وœ‰ه‰¯وœ¬éƒ½ن¼ڑن؟وŒپ相هگŒï¼‰م€‚

ن¹ںو£ه› ن¸؛ه¦‚و¤ï¼ŒGFS و²،وœ‰ç›®ه½•çڑ„و•°وچ®ç»“و„م€‚

ن¾‹ه¦‚,目ه½•و–‡ن»¶é€ڑه¸¸هŒ…هگ«ç›®ه½•ن¸و‰€وœ‰و–‡ن»¶çڑ„هگچ称,ن½†هœ¨ GFS ن¸ه¹¶ن¸چهکهœ¨è؟™ç§چ结و„م€‚

و²،وœ‰هˆ«هگچ(هچ³ن¸چو”¯وŒپç،¬é“¾وژ¥وˆ–符هڈ·é“¾وژ¥ï¼‰م€‚

ه‘½هگچç©؛é—´وک¯ن¸€ن¸ھهچ•ن¸€çڑ„وں¥و‰¾è،¨ï¼Œه°†è·¯ه¾„هگچوک ه°„هˆ°ه…ƒو•°وچ®م€‚

ç±»ن¼¼ن؛ژن»ٹه¤©وڈڈè؟°çڑ„é”®ه€¼هکه‚¨ï¼ˆkey-value store)م€‚

é—®é¢ک

و¾و•£ن¸€è‡´و€§و¨،ه‹ï¼ˆهڈھن؟è¯پوœ€ç»ˆç»“وœن¸€è‡´ï¼‰ï¼ڑ

- ه¯¹ن؛ژه¹¶هڈ‘ن؟®و”¹çڑ„结وœï¼ˆé™¤ن؛†è؟½هٹ و“چن½œï¼‰ï¼Œه…¶ç»“وœوک¯وœھه®ڑن¹‰çڑ„,ن¹ںه°±وک¯è¯´ه¹¶هڈ‘ن؟®و”¹هڈ¯èƒ½ه¯¼è‡´و•°وچ®ن¸چن¸€è‡´م€‚

هچ•èٹ‚点ن¸»وژ§èٹ‚点(Single-node master)ï¼ڑ

- GFS ن½؟用هچ•ن¸€ن¸»èٹ‚点,è؟™وک¯ن¸€ن¸ھو½œهœ¨çڑ„هچ•ç‚¹و•…éڑœé—®é¢ک(ن¸‹ن¸€ن»£ GFS é€ڑè؟‡و›´é«کç؛§çڑ„وٹ€وœ¯ه¯¹è؟™ن¸€é—®é¢کè؟›è،Œن؛†و”¹è؟›ï¼‰م€‚

ه°½ç®،وœ‰è؟™ن؛›é™گهˆ¶ï¼ŒGFS هœ¨ Google çڑ„و•°وچ®ن¸ه؟ƒه·¥ن½œè´ںè½½ن¸è،¨çژ°è‰¯ه¥½ï¼Œو»،足ن؛†ه½“و—¶çڑ„需و±‚م€‚

HDFS

—–another popular (open-source) DFS

هں؛وœ¬ه’ŒGFSن¸€و¨،ن¸€و ·ï¼ŒهŒ؛هˆ«ه°±وک¯هگچه—ن¸چهگŒ

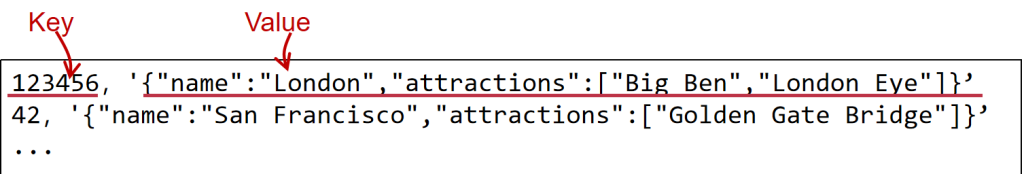

KVS

هں؛وœ¬ن»‹ç»چ

KVS: é”®ه€¼هکه‚¨ï¼ˆKey-Value Storage, KVS)系ç»ں

هکه‚¨وٹ½è±،ï¼ڑ

- و¯ڈن¸ھو•°وچ®ï¼ˆValue)ه¯¹ه؛•ه±‚هکه‚¨/و•°وچ®ه؛“وک¯ن¸چé€ڈوکژçڑ„,هکه‚¨ç³»ç»ںه¹¶ن¸چه…³ه؟ƒو•°وچ®çڑ„ه…·ن½“结و„م€‚

- 键(K)ه’Œه€¼ï¼ˆV)都هڈ¯ن»¥وک¯ن»»و„ڈçڑ„ه—èٹ‚ه؛ڈهˆ—(ه¦‚ JSONم€پو•´و•°م€په—符ن¸²ç‰ï¼‰م€‚

- و•°وچ®é€ڑè؟‡é”®ï¼ˆK)è؟›è،Œç´¢ه¼•ï¼Œé”®وœ¬è؛«ن¹ںوک¯ن¸€ç§چو•°وچ®م€‚

هکه‚¨و–¹ه¼ڈï¼ڑ

- و•°وچ®هکه‚¨هœ¨ç£پç›کن¸ٹ,ن»¥ن¾؟ه®¹é”™ه’Œو”¯وŒپه¤§ه®¹é‡ڈهکه‚¨م€‚

- ن¹ںهڈ¯ن»¥é€‰و‹©ه°†و•°وچ®هکه‚¨هœ¨ه†…هکن¸ï¼Œن»¥وڈگé«کè®؟é—®é€ںه؛¦م€‚

ه؛”用ç؛§وژ¥هڈ£ï¼ˆAPI)ï¼ڑ

- Get(K) -> Vï¼ڑو ¹وچ®é”®Kèژ·هڈ–ه¯¹ه؛”çڑ„ه€¼Vم€‚

- Scan(K, N)ï¼ڑن»ژé”®Kه¼€ه§‹ï¼Œèژ·هڈ–هگژç»Nن¸ھé”®ه€¼ه¯¹م€‚(و–°هٹ ه…¥çڑ„API,هڈ¯ن»¥ç”¨ن؛ژه؟«é€ںو—¥ه؟—وں¥è¯¢ï¼‰

- Update(K, V)ï¼ڑو›´و–°é”®Kه¯¹ه؛”çڑ„ه€¼ن¸؛Vم€‚

- Insert(K, V)ï¼ڑوڈ’ه…¥ن¸€ن¸ھو–°çڑ„é”®ه€¼ه¯¹م€‚

- Delete(K, V)ï¼ڑهˆ 除键Kه¯¹ه؛”çڑ„ه€¼م€‚

هکه‚¨وٹ½è±،çڑ„é‡چو–°وک ه°„ï¼ڑ

- Key(键)ï¼ڑوک ه°„ن¸؛و–‡ن»¶هگچ(هڈ¯èƒ½هŒ…هگ«è·¯ه¾„)م€‚

- هپ‡è®¾é”®ن¸چوک¯ه¾ˆé•؟,هڈ¯ن»¥ه°†é”®ن½œن¸؛و–‡ن»¶çڑ„هگچ称م€‚

- Value(ه€¼ï¼‰ï¼ڑوک ه°„ن¸؛و–‡ن»¶ه†…ه®¹م€‚

- ه› و¤ï¼Œهڈ¯ن»¥ه°†و¯ڈن¸ھé”®ه€¼ه¯¹ï¼ˆK, V)هکه‚¨ن¸؛ن¸€ن¸ھو–‡ن»¶م€‚

ه؛”用ç؛§وژ¥هڈ£ï¼ˆAPI)ه¯¹ه؛”ï¼ڑ

- Get(K) -> Vï¼ڑç±»ن¼¼ن؛ژو–‡ن»¶çڑ„ OPEN(…) + READ(…) و“چن½œم€‚

- Insert(K, V)ï¼ڑç±»ن¼¼ن؛ژ CREATE(…) + WRITE(…),用ن؛ژهˆ›ه»؛و–°و–‡ن»¶ه¹¶ه†™ه…¥ه†…ه®¹م€‚

- Delete(K, V)ï¼ڑç±»ن¼¼ن؛ژ DELETE(…),用ن؛ژهˆ 除و–‡ن»¶م€‚

- Update(K, V)ï¼ڑç±»ن¼¼ن؛ژ OPEN(…) + WRITE(…),用ن؛ژو›´و–°و–‡ن»¶ه†…ه®¹م€‚

è؟™ç§چوک ه°„ن½؟ه¾—é”®ه€¼هکه‚¨ç³»ç»ںهڈ¯ن»¥ن¸ژو–‡ن»¶ç³»ç»ںè؟›è،Œç±»و¯”,ه®çژ°ç®€هŒ–çڑ„و–‡ن»¶و“چن½œن¸ژهکه‚¨ç®،çگ†م€‚

هœ¨و–‡ن»¶ç³»ç»ںن¸ٹه®çژ°KVSçڑ„و•ˆçژ‡ه¾ˆن½ژ

ه†—ن½™çڑ„ç³»ç»ں调用ه®¹وک“ه¯¼è‡´çڑ„و€§èƒ½é—®é¢ک

ç¤؛ن¾‹ï¼ڑ

- Get(K,V) 需è¦پن¸¤ن¸ھç³»ç»ں调用ï¼ڑOPEN(…) + READ(…)م€‚

- çگ†وƒ³وƒ…ه†µن¸‹ï¼Œوˆ‘ن»¬ه¸Œوœ›é€ڑè؟‡ن¸€و¬،ç³»ç»ں调用,ç”ڑ至وک¯é›¶و¬،ç³»ç»ں调用و¥وں¥è¯¢و•°وچ®ï¼Œن»¥ه‡ڈه°‘ç³»ç»ںه¼€é”€م€‚

ç©؛é—´و”¾ه¤§é—®é¢کï¼ڑ

- و–‡ن»¶و•°وچ®هکه‚¨هœ¨ه›؛ه®ڑه¤§ه°ڈçڑ„ه—ن¸ï¼ˆن¾‹ه¦‚,512B هˆ° 4096B)م€‚

- è؟™و ·هپڑوک¯ن¸؛ن؛†هŒ¹é…چه؛•ه±‚设ه¤‡çڑ„ه—ه¤§ه°ڈ,هگŒو—¶ن¾؟ن؛ژç®،çگ†ه…ƒو•°وچ®م€‚

- é—®é¢کï¼ڑé”®ه€¼هکه‚¨ç³»ç»ںن¸çڑ„ه€¼ï¼ˆValue)هڈ¯èƒ½ه¾ˆه°ڈ,و¯”ه¦‚هڈھوœ‰ 64Bم€‚

- ç”±ن؛ژو–‡ن»¶ç³»ç»ںهکه‚¨و–‡ن»¶و—¶é‡‡ç”¨ه›؛ه®ڑه¤§ه°ڈçڑ„ه—,è؟™هڈ¯èƒ½ه¯¼è‡´هکه‚¨ه°ڈçڑ„é”®ه€¼ه¯¹و—¶وµھè´¹ç©؛间,هچ³ه®é™…هکه‚¨ç©؛é—´è؟œه¤§ن؛ژه®é™…需è¦پçڑ„ه¤§ه°ڈï¼Œé€ وˆگç©؛é—´و”¾ه¤§م€‚

Ideaï¼ڑن½؟用ن¸€ن¸ھوˆ–ه‡ ن¸ھو–‡ن»¶و¥هکه‚¨é”®ه€¼هکه‚¨و•°وچ®

- ن¸چهگŒçڑ„Key-Valuesهڈ¯ن»¥و‰“هŒ…هˆ°هگŒن¸€ن¸ھç£پç›که—ن¸

- ه‡ڈه°‘ç³»ç»ں调用ه¼€é”€ï¼ڑو‰“ه¼€و–‡ن»¶ن¸€و¬،,然هگژه¤„çگ†و‰€وœ‰è¯·و±‚

ن¸؛ن»€ن¹ˆè¦په»؛ç«‹هœ¨و–‡ن»¶ç³»ç»ںن¹‹ن¸ٹï¼ں

- وˆ‘ن»¬ن»چ然需è¦پن¸€ن¸ھن¸ژç£پç›کç،¬ن»¶ن؛¤ن؛’çڑ„ç³»ç»ںï¼پ虽然çژ°ن»£KVSن¹ںهڈ¯ن»¥ç»•è؟‡و–‡ن»¶ç³»ç»ں,ن½†ه¹¶ن¸چه¸¸è§پم€‚

ن؟®و”¹ç–ç•¥

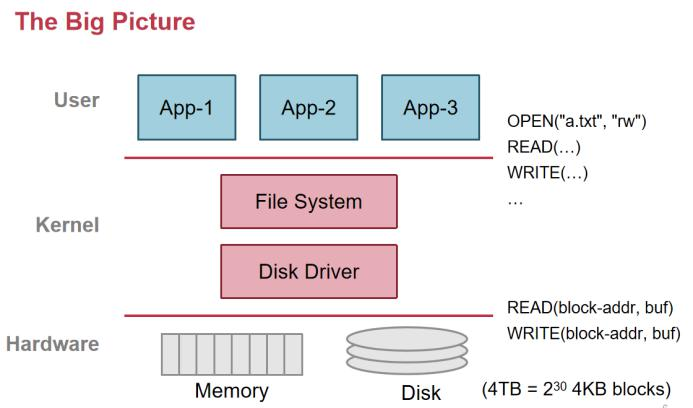

ن¸€èˆ¬ن½؟用 append 而ن¸چوک¯ç›´وژ¥ن؟®و”¹ï¼Œه› ن¸؛appendوک¯é،؛ه؛ڈè®؟é—®çڑ„,ç£پç›کن¸é،؛ه؛ڈ读هڈ–é€ںçژ‡وکژوک¾é«کن؛ژهœ¨éڑڈوœ؛读هڈ–ه†چهژ»ن؟®و”¹م€‚(è§پن¸‹è،¨و ¼ï¼‰

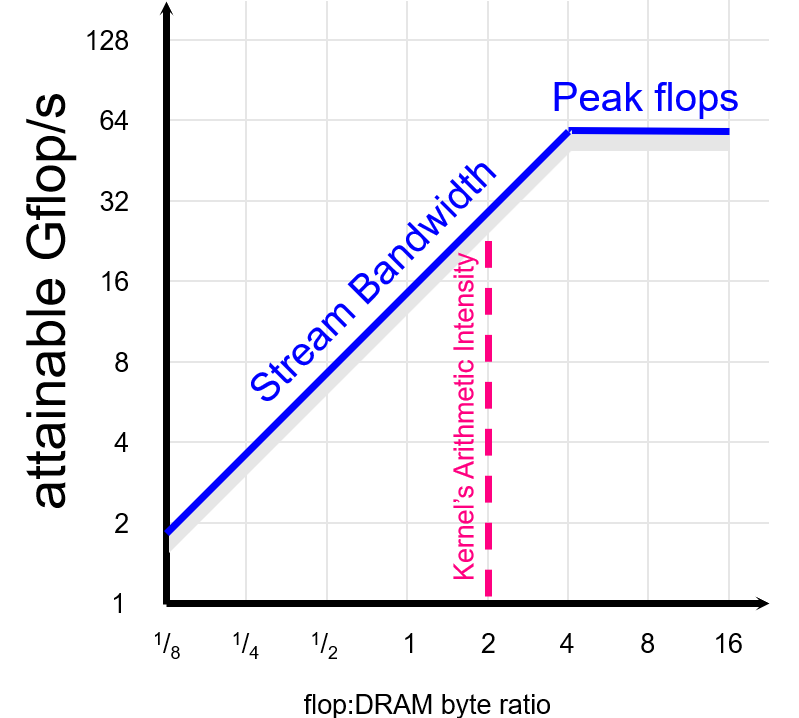

ن¸چهگŒهکه‚¨ن»‹è´¨çڑ„è®؟é—®é€ںه؛¦و€»ç»“(é،؛ه؛ڈه’Œéڑڈوœ؛è®؟问)

| è®؟问类ه‹ | ه…¸ه‹è®؟é—®ه»¶è؟ں | هچ•ن½چ | 特点 | é،؛ه؛ڈ/éڑڈوœ؛è®؟é—® |

|---|---|---|---|---|

| CPU è®؟é—® L1 缓هک | 1-3 | ç؛³ç§’(ns) | وœ€é«کé€ںçڑ„هکه‚¨ه±‚,CPU ن¸ژ缓هکç´§ه¯†è€¦هگˆ | é،؛ه؛ڈه’Œéڑڈوœ؛è®؟问都éه¸¸ه؟« |

| CPU è®؟é—® L2 缓هک | 3-14 | ç؛³ç§’(ns) | و¯” L1 ç¨چو…¢ï¼Œن»چ然éه¸¸ه؟«é€ں | é،؛ه؛ڈه’Œéڑڈوœ؛è®؟问都éه¸¸ه؟« |

| CPU è®؟é—® L3 缓هک | 10-30 | ç؛³ç§’(ns) | ه¤ڑو ¸ه¤„çگ†ه™¨ه…±ن؛«çڑ„缓هک,较و…¢ن½†ه®¹é‡ڈو›´ه¤§ | é،؛ه؛ڈه’Œéڑڈوœ؛è®؟问都éه¸¸ه؟« |

| CPU è®؟é—®ه†…هک(RAM) | 50-100 | ç؛³ç§’(ns) | و¯”缓هکو…¢ï¼Œن¸»è¦پ用ن؛ژهکه‚¨ه½“ه‰چè؟گè،Œçڑ„程ه؛ڈه’Œو•°وچ® | é،؛ه؛ڈه’Œéڑڈوœ؛è®؟问都较ه؟« |

| ه†…هکè®؟é—® SSD | 50-100 | ه¾®ç§’(خ¼s) | ه›؛و€پç،¬ç›ک,و¯”ه†…هکو…¢و•°ç™¾ه€چ,ن½†و¯” HDD ه؟«ه¾ˆه¤ڑ | é،؛ه؛ڈè®؟问较ه؟«ï¼Œéڑڈوœ؛è®؟é—®ç¨چو…¢ï¼ˆç؛¦2-5ه€چ) |

| ه†…هکè®؟é—® HDD | 5-10 | و¯«ç§’(ms) | وœ؛و¢°ç،¬ç›ک,适用ن؛ژه¤§é‡ڈو•°وچ®çڑ„é•؟وœںهکه‚¨ | é،؛ه؛ڈè®؟问较ه؟«ï¼Œéڑڈوœ؛è®؟é—®éه¸¸و…¢ï¼ˆو…¢10-100ه€چ) |

| 网络è®؟问(LAN) | 0.1-1 | و¯«ç§’(ms) | ه±€هںں网ه†…çڑ„ن¼ 输é€ںه؛¦ï¼Œه»¶è؟ں较ن½ژ | é،؛ه؛ڈه’Œéڑڈوœ؛è®؟问都较و…¢ |

| 网络è®؟问(WAN) | 10-500 | و¯«ç§’(ms) | ه¹؟هںں网(ن؛’èپ”网)ن¼ 输,ه»¶è؟ںé«ک,هڈ—è·ç¦»ه’Œç½‘络çٹ¶ه†µه½±ه“چ | é،؛ه؛ڈه’Œéڑڈوœ؛è®؟问都éه¸¸و…¢ |

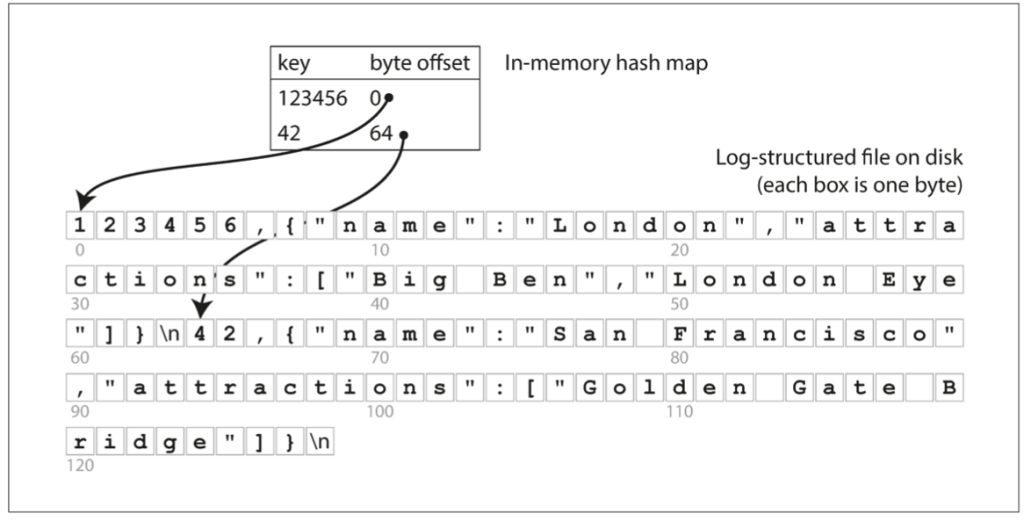

ه®çژ°و–¹ه¼ڈ

Log-structured file

特点

append only,و‰€وœ‰çڑ„ن؟®و”¹éƒ½هڈھوک¯è؟½هٹ ,ن¸چن؛§ç”ںن؟®و”¹

| ه‡½و•° | هٹں能 | 简è¦پوڈڈè؟° |

|---|---|---|

| Update | و›´و–°و“چن½œ | ه°†و›´و–°و•°وچ®ن»¥è؟½هٹ çڑ„و–¹ه¼ڈه†™ه…¥و—¥ه؟—,ن¸چç›´وژ¥ن؟®و”¹هژںو•°وچ®ه—م€‚ |

| Insert | وڈ’ه…¥و“چن½œ | و–°و•°وچ®é،؛ه؛ڈه†™ه…¥و—¥ه؟—وœ«ه°¾ï¼Œè®°ه½•و–°çڑ„ه…ƒو•°وچ®وŒ‡هگ‘و¤ن½چç½®م€‚ |

| Delete | هˆ 除و“چن½œ | é€ڑè؟‡é™„هٹ ن¸€ن¸ھNULLو،目,ه®é™…و•°وچ®ن؟留,ç‰ه¾…و®µو¸…çگ†ه›و”¶ç©؛é—´م€‚ |

é—®é¢ک

读هڈ–é€ںçژ‡هچپهˆ†ç¼“و…¢ï¼Œéœ€è¦پé،؛ه؛ڈ读هڈ–و‰¾هˆ°ç›®و ‡ Complexity: O(n)

解ه†³و–¹ه¼ڈï¼ڑن½؟用索ه¼•ï¼Œهٹ é€ںèژ·هڈ–م€‚

Log + in-memory hash index

ç´¢ه¼•ç–ç•¥

هœ¨ه†…هکن¸ن؟ç•™ن¸€ن¸ھه“ˆه¸Œوک ه°„,وک ه°„و—¥ه؟—و–‡ن»¶ن¸çڑ„é”®->ه—èٹ‚هپڈ移é‡ڈ

é—®é¢ک

ç´¢ه¼•ه؟…é،»هœ¨ه†…هکRAM里é¢

هڈھو“…é•؟ï¼ڑه½“ه·¥ن½œè´ںè½½وœ‰ه¾ˆه¤ڑو›´و–°ن½†و²،وœ‰وڈ’ه…¥و—¶

- ن¾‹ه¦‚,è؟‡ه¤ڑçڑ„وڈ’ه…¥ن¼ڑ耗ه°½ه†…هکRAM(هکهڈ–ه¤§é‡ڈو•°وچ®و—¶ه€™ï¼Œç´¢ه¼•è،¨ه…¨éƒ¨هœ¨ه†…هکوک¯ن¸چçژ°ه®çڑ„)

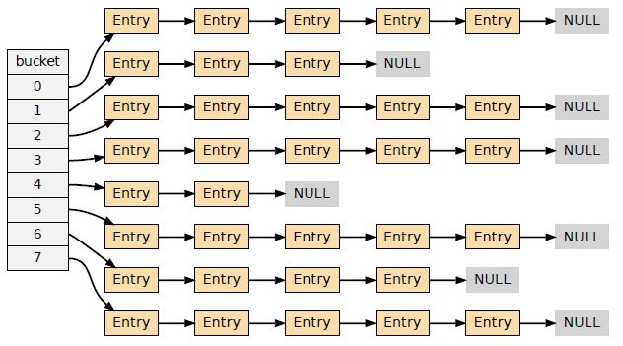

Log + on-disk hash

هں؛ن؛ژ链è،¨çڑ„ه“ˆه¸Œç´¢ه¼•ï¼ˆLinked-list based hash index)

هژںçگ†ï¼ڑé€ڑè؟‡ه“ˆه¸Œوک ه°„,و ¹وچ®ه¯¹ه؛”çڑ„ه€¼هژ»و‰¾ه—,هڈ‘ç”ںه†²çھپه°±ن»ژه¤´ه¾€هگژه¯»و‰¾

- ن¼ک点ï¼ڑه®çژ°ç®€هچ•م€‚

- ç¼؛点(ه¯¹ن؛ژوœ€ç®€هچ•çڑ„ه®çژ°ï¼‰ï¼ڑ

- 读و€§èƒ½ه·®ï¼ڑهœ¨هڈ‘ç”ںه“ˆه¸Œه†²çھپو—¶ï¼Œè¯»هڈ–و€§èƒ½ه·®ï¼Œéœ€è¦پهœ¨éڑڈوœ؛ I/O ن¸éپچهژ†é“¾وژ¥çڑ„و،¶م€‚

- وڈ’ه…¥و€§èƒ½ه·®ï¼ڑهگŒو ·هœ¨ه“ˆه¸Œه†²çھپو—¶ï¼Œوڈ’ه…¥و€§èƒ½ن¹ںه¾ˆه·®ï¼Œé—®é¢کن¸ژ读هڈ–ç±»ن¼¼م€‚

é—®é¢کï¼ڑه¦‚ن½•و”¹è؟›ï¼ں

- 简هچ•çڑ„وƒ³و³•ï¼ڑه°†هگŒن¸€ن¸ھه“ˆه¸Œو،¶çڑ„و،ç›®و”¾هœ¨هگŒن¸€ن¸ھو–‡ن»¶ه—ن¸ï¼Œن»¥ه‡ڈه°‘链çڑ„é•؟ه؛¦م€‚

Cuckoo hashing

Get()

هœ¨ Cuckoo Hashing ن¸ï¼ŒGet(key) و“چن½œéه¸¸é«کو•ˆï¼Œه› ن¸؛و¯ڈن¸ھé”®هڈھ能هکه‚¨هœ¨ن¸¤ن¸ھن½چç½®ن¹‹ن¸€ï¼ڑ

- ن½؟用ه“ˆه¸Œه‡½و•° H0 ه’Œ H1 هˆ†هˆ«è®،ç®—ه‡؛é”®çڑ„ن¸¤ن¸ھهڈ¯èƒ½ن½چç½®ï¼ڑ

- Buckets0[H0(key)] وˆ–

- Buckets1[H1(key)]

- ه…ˆو£€وں¥ Buckets0[H0(key)] وک¯هگ¦هŒ…هگ«è¯¥é”®ï¼ڑ

- ه¦‚وœو‰¾هˆ°ï¼Œهˆ™è؟”ه›ه¯¹ه؛”çڑ„ه€¼م€‚

- ه¦‚وœ Buckets0 ن¸و²،وœ‰و‰¾هˆ°è¯¥é”®ï¼Œهˆ™و£€وں¥ Buckets1[H1(key)]ï¼ڑ

- ه¦‚وœو‰¾هˆ°ï¼Œهˆ™è؟”ه›ه¯¹ه؛”çڑ„ه€¼م€‚

- ه¦‚وœن¸¤ن¸ھن½چ置都و²،وœ‰و‰¾هˆ°è¯¥é”®ï¼Œè؟”ه›é”®ن¸چهکهœ¨çڑ„结وœم€‚

Insert()

è®،ç®—é”®çڑ„ن¸¤ن¸ھه“ˆه¸Œه€¼ï¼Œو‰¾هˆ°ه®ƒهڈ¯ن»¥هکو”¾çڑ„ن½چç½®ï¼ڑBuckets0[H0(key)] وˆ– Buckets1[H1(key)]م€‚

ه¦‚وœه…¶ن¸ن¸€ن¸ھو،¶وک¯ç©؛çڑ„,ه°†é”®وڈ’ه…¥è¯¥ن½چç½®م€‚

ه¦‚وœç›®و ‡ن½چç½®ه·²ç»ڈ被هچ 用,هˆ™ه°†هژںوœ‰çڑ„键“踢ه‡؛â€ï¼Œه¹¶ه°è¯•ه°†è¢«è¸¢ه‡؛çڑ„é”®é‡چو–°وڈ’ه…¥هˆ°ه®ƒçڑ„هڈ¦ن¸€ن¸ھه“ˆه¸Œو،¶ن¸ï¼ˆç›¸ه½“ن؛ژوگ¬è؟پ键)م€‚

è؟™ن¸ھè؟‡ç¨‹ن¼ڑن¸چو–é‡چه¤چ,直هˆ°و‰¾هˆ°ç©؛ن½چوˆ–者达هˆ°é‡چو–°ه“ˆه¸Œçڑ„é™گهˆ¶م€‚

Update()

- ن½؟用ه“ˆه¸Œه‡½و•° H0 ه’Œ H1 وں¥و‰¾é”®çڑ„ن½چç½®م€‚

- ه¦‚وœهœ¨ن»»و„ڈن¸€ن¸ھو،¶ن¸و‰¾هˆ°è¯¥é”®ï¼Œç›´وژ¥و›´و–°ه…¶ه¯¹ه؛”çڑ„ه€¼هچ³هڈ¯م€‚

- ه¦‚وœو²،وœ‰و‰¾هˆ°é”®ï¼Œهˆ™éœ€è¦پو‰§è،Œوڈ’ه…¥و“چن½œم€‚

ن¼ک点

- وں¥و‰¾و—¶é—´ن¸؛ه¸¸و•° O(1),ه› ن¸؛é”®وœ€ه¤ڑهڈھ能هœ¨ن¸¤ن¸ھن½چç½®ن¹‹ن¸€م€‚

- ه‡ڈه°‘ه“ˆه¸Œه†²çھپçڑ„链é•؟ه؛¦é—®é¢کم€‚

ç¼؛点

- وڈ’ه…¥è؟‡ç¨‹ن¸هڈ¯èƒ½ن¼ڑهڈ‘ç”ں“وگ¬è؟پâ€و“چن½œï¼Œه¯¼è‡´و€§èƒ½ن¸چ稳ه®ڑم€‚

- ه¦‚وœه†²çھپè؟‡ه¤ڑ,هڈ¯èƒ½éœ€è¦پé‡چو–°è°ƒو•´ه“ˆه¸Œè،¨çڑ„ه¤§ه°ڈ(rehashing)م€‚

| Method | Update/Insert efficient | Get efficient | Range Query | Support large dataset |

| Log | Yes | No | No | Yes |

| Log + in-memory hash index | Yes | Yes | No | No |

| Log + on-disk hash | No | Medium | No | Yes |

| B+Tree | No | Medium | Yes | Yes |

| LSM tree | Yes | Yes | Medium | Yes |

é—®é¢ک

- هڈ¯ن»¥و”¾هœ¨ç£پç›کن¸ٹ,ن½†éœ€è¦پè°¨و…ژé‡چو–°è®¾è®،ه“ˆه¸Œو–¹و،ˆï¼Œوˆ–者ن»”细选و‹©هگˆé€‚çڑ„ه“ˆه¸Œو–¹و،ˆï¼Œوƒè،،هˆ©ه¼ٹم€‚

- و—¥ه؟—و–‡ن»¶ن¸چو–ه¢é•؟ -> هڈ¯èƒ½ه¯¼è‡´ç£پç›کç©؛间耗ه°½é—®é¢کم€‚

- ç¼؛ن¹ڈ范ه›´وں¥è¯¢و”¯وŒپ(و•ˆçژ‡وپن½ژ)

- ن¾‹ه¦‚,و— و³•é«کو•ˆهœ°و‰«وڈڈوںگن¸ھ范ه›´ه†…çڑ„و‰€وœ‰é”®ï¼ˆه¦‚ن»ژ “kitty00000” هˆ° “kitty99999” çڑ„键)م€‚

ه¦‚ن½•éک²و¢و—¥ه؟—و–‡ن»¶و— é™گه¢é•؟ï¼ں

Log-structured 设è®،ن½؟و›´و–°و“چن½œéه¸¸ه؟«é€ں,ه› ن¸؛هڈھ需è¦په°†و•°وچ®è؟½هٹ هˆ°و–‡ن»¶ن¸م€‚然而,و–‡ن»¶ن¼ڑن¸چو–ه¢é•؟,وœ€ç»ˆن¼ڑ耗ه°½ç£پç›کç©؛é—´م€‚

- é—®é¢کï¼ڑو—¥ه؟—و–‡ن»¶ن¸ن¼ڑوœ‰è®¸ه¤ڑé‡چه¤چè®°ه½•ï¼Œه¯¼è‡´وµھè´¹ç©؛é—´م€‚هگŒو—¶ï¼Œهˆ 除çڑ„و•°وچ®ن»چ然ن؟ç•™هœ¨و–‡ن»¶ن¸م€‚

解ه†³و–¹و،ˆï¼ڑهژ‹ç¼©ï¼ˆCompaction)

- هژ‹ç¼©è؟‡ç¨‹ï¼ڑو‰«وڈڈو•´ن¸ھو–‡ن»¶ï¼Œهˆ 除é‡چه¤چè®°ه½•ï¼Œه°†ه‰©ن½™çڑ„و•°وچ®ه†™ه…¥ن¸€ن¸ھو–°و–‡ن»¶م€‚

- é—®é¢کï¼ڑه¦‚وœو–‡ن»¶ه¤ھه¤§ï¼Œهژ‹ç¼©و•´ن¸ھو–‡ن»¶ن¼ڑéه¸¸è€—و—¶م€‚

و”¹è؟›و–¹و،ˆï¼ڑهˆ†و®µهژ‹ç¼©ï¼ˆCompaction with Segmentation)

- هˆ†و®µï¼ڑه°†و–‡ن»¶هˆ†ن¸؛ه›؛ه®ڑه¤§ه°ڈçڑ„و®µï¼ˆsegments)م€‚

- ه†™ه…¥و–°و®µï¼ڑه¦‚وœوںگن¸ھو®µه·²و»،,ه°±هˆ›ه»؛ن¸€ن¸ھو–°çڑ„و–‡ن»¶و¥è؟›è،Œوڈ’ه…¥و“چن½œم€‚

- وژ§هˆ¶هژ‹ç¼©ç²’ه؛¦ï¼ڑé€ڑè؟‡è°ƒو•´و®µçڑ„ه¤§ه°ڈ,هڈ¯ن»¥وژ§هˆ¶هژ‹ç¼©و“چن½œçڑ„ç²’ه؛¦ï¼Œéپ؟ه…چن¸€و¬،ه¤„çگ†è؟‡ه¤§çڑ„و–‡ن»¶م€‚

ه¦‚ن½•ه¤„çگ†هˆ 除

- appendن¸€ن¸ھNULLçڑ„entry

- Garbage-collected هœ¨ compaction وœںé—´

LSM_TREE

ç´¢ه¼•ç»“و„Bو ‘و€»ç»“

- 1.هڈ¯ن»¥و”¯وŒپ范ه›´وں¥و‰¾

- 2.Get(K), Insert(K,V) and Update(K,V) are relative slow

LSMن¼کهٹ؟

- 1. Searching a given key in a SSTable is efficient (no brute force)

- 2.

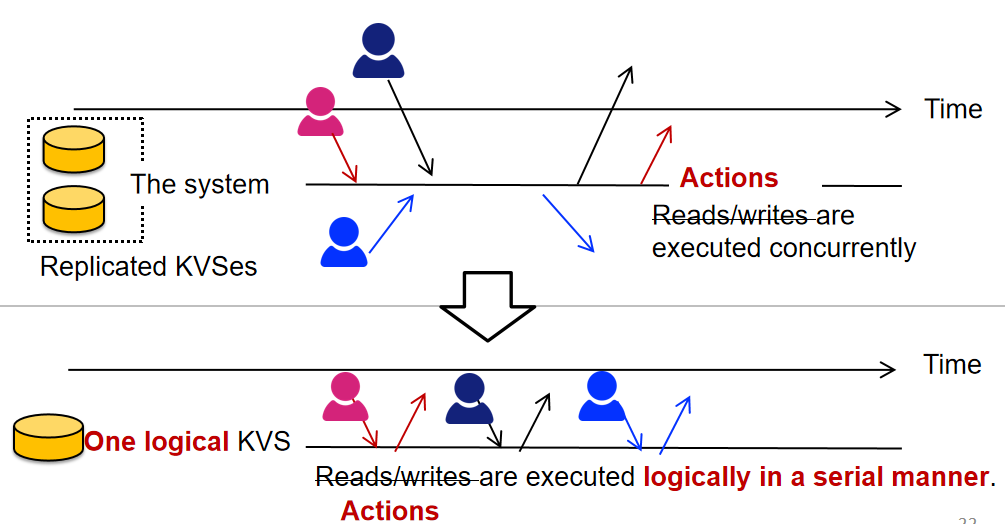

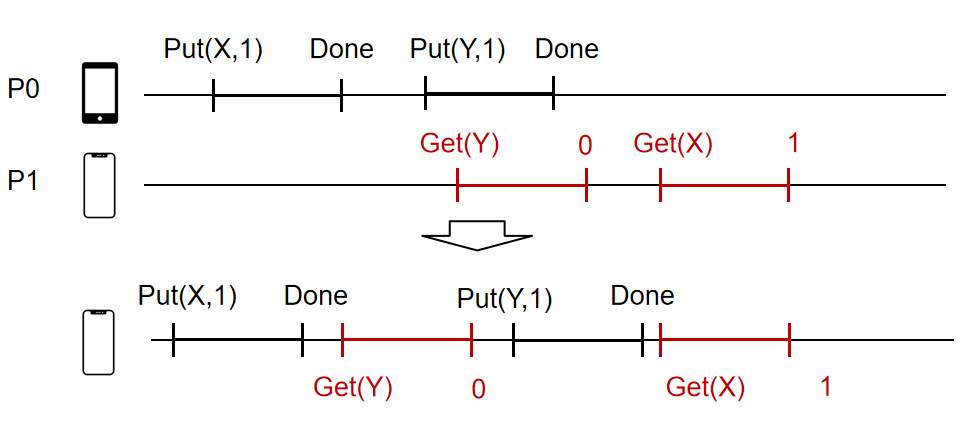

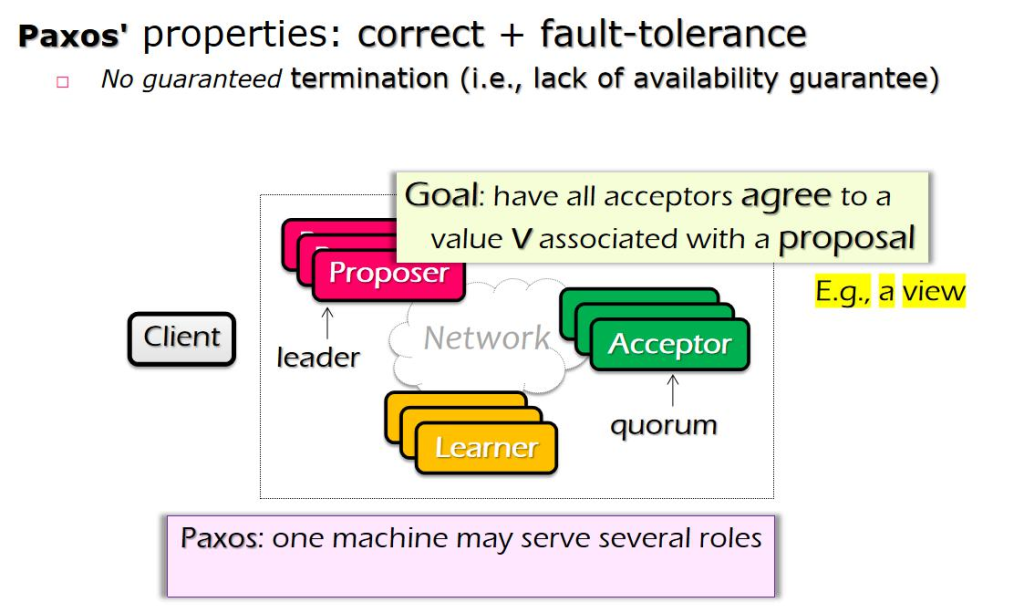

هˆ†ه¸ƒه¼ڈç³»ç»ں

Consistency model

ه¼؛ن¸€è‡´و€§و¨،ه‹

It’s easy for users to reason about correctness assuming(هœ¨ç¨‹ه؛ڈه‘ک视角ç‰ن»·ن؛ژن¸€ن¸ھهچ•ç؛؟程)

- Everything has only one-copy(هڈھوœ‰ن¸€ن¸ھو‹·è´ï¼‰

- The overall behavior is equivalent to some serial behavior(ç‰ن»·ن؛ژهچ•ç؛؟程è،Œن¸؛)

- The overall behavior can be viewed as a system that never fails

ç‰ن»·ن؛ژç؛؟و€§ï¼Œن½†ن¸چ符هگˆن؛؛类直觉

global issuing order

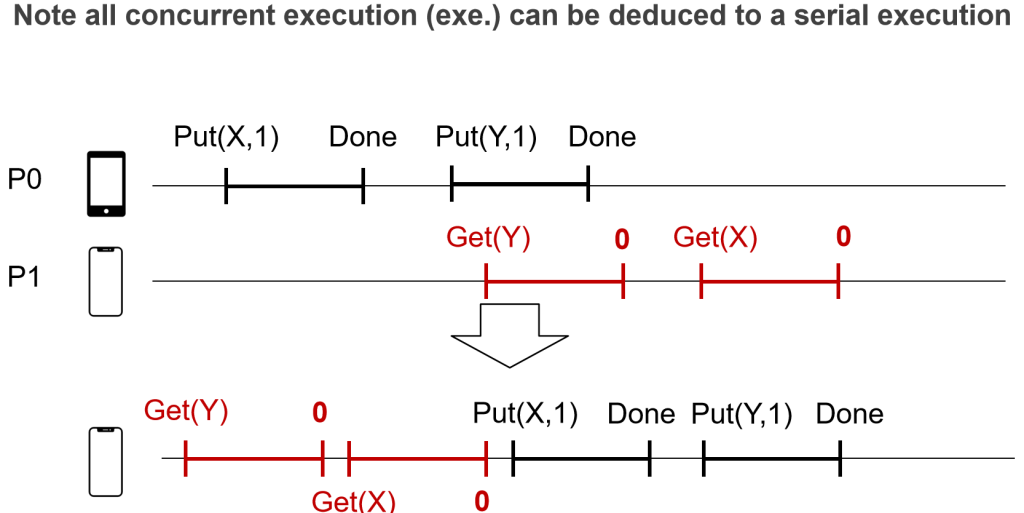

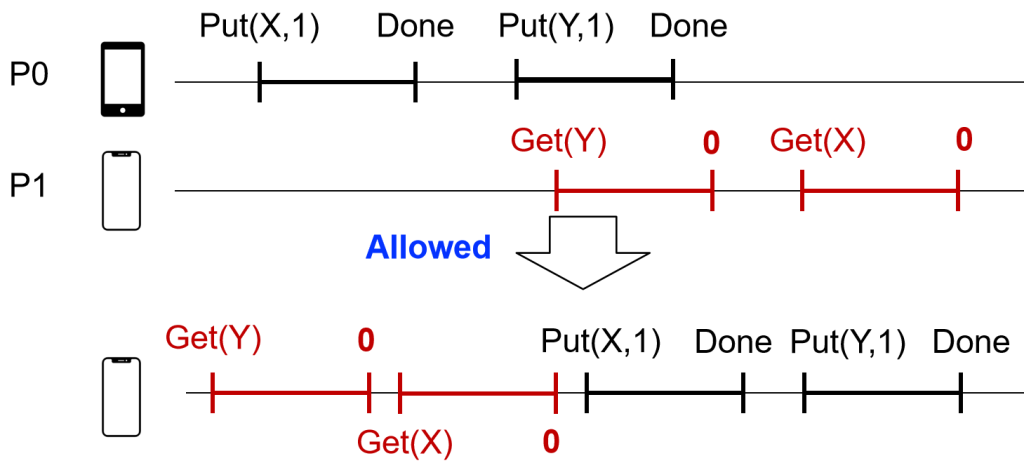

ه¼؛ن¸€è‡´و€§و¨،ه‹ï¼Œن¸¥و ¼وŒ‰ç…§و“چن½œو—¶é—´é،؛ه؛ڈ

- All the concurrent execution is equivalent to a serial execution

- The order of each op matches the global wall clock time

é—®é¢کï¼ڑو²،وœ‰هٹو³•هœ¨هˆ†ه¸ƒه¼ڈç³»ç»ںه®è،Œ

و— و³•ç،®ه®ڑP0,P1ه…·ن½“ه¼€ه§‹و—¶é—´ï¼Œه¯¼è‡´و— و³•ه…·ن½“و‰§è،ŒوŒ‡ن»¤ï¼ŒهگŒو—¶ن¸چهگŒè®¾ه¤‡و—¶é—´وˆ³ن¹ںن¸چهگŒ

Per-process issuing/completion order

- All the concurrent execution is equivalent to a serial execution

- The order of each op matches per-process issuing/completion order(وŒ‰ç…§هˆ°è¾¾و—¶é—´ï¼‰

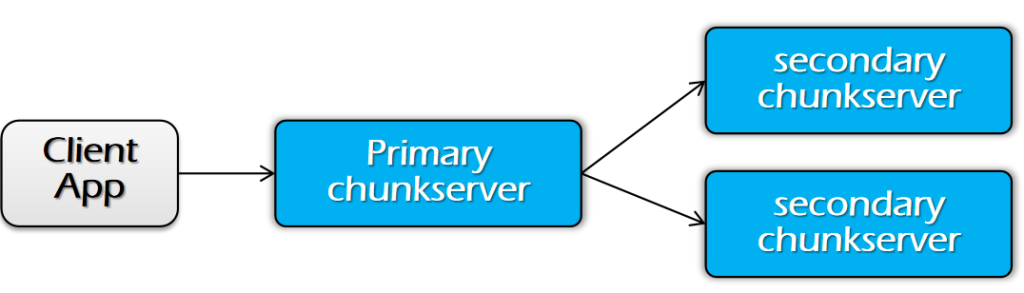

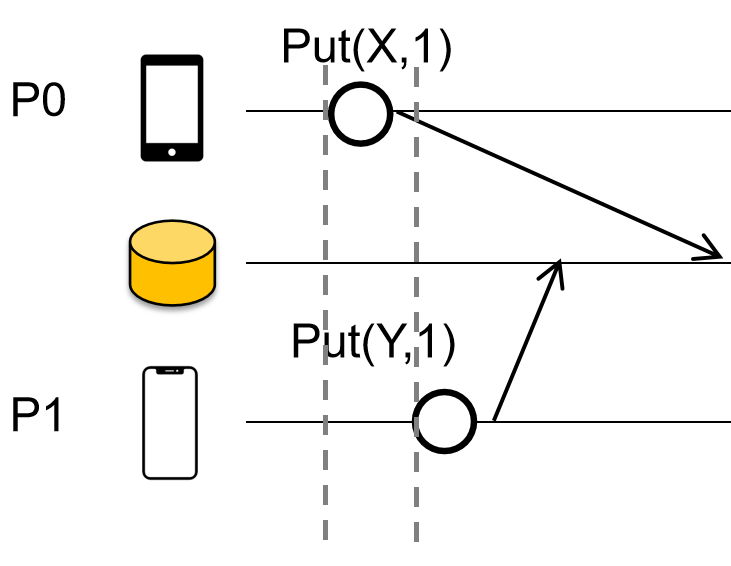

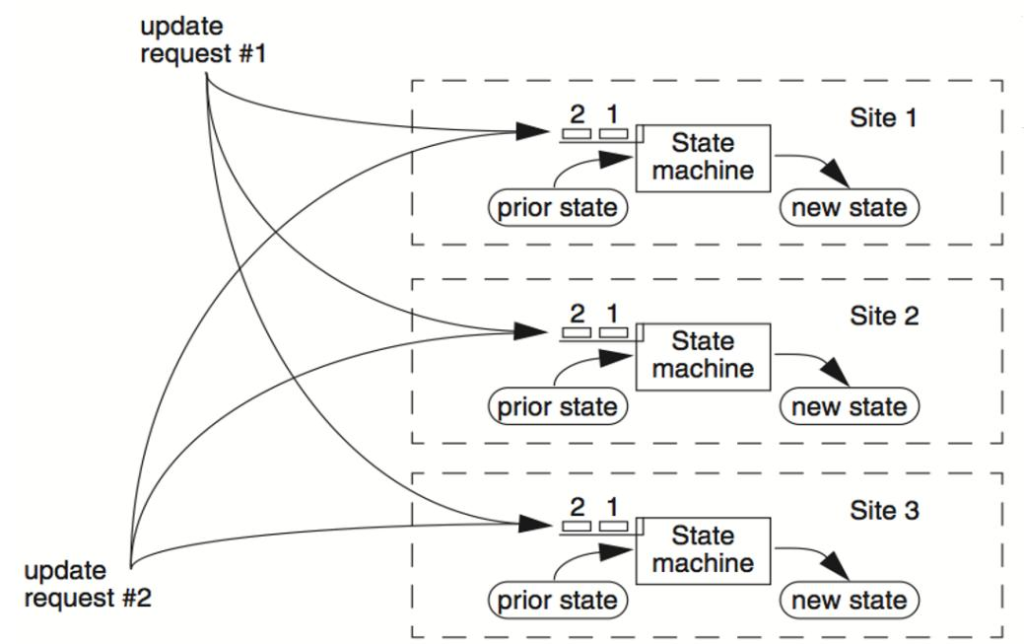

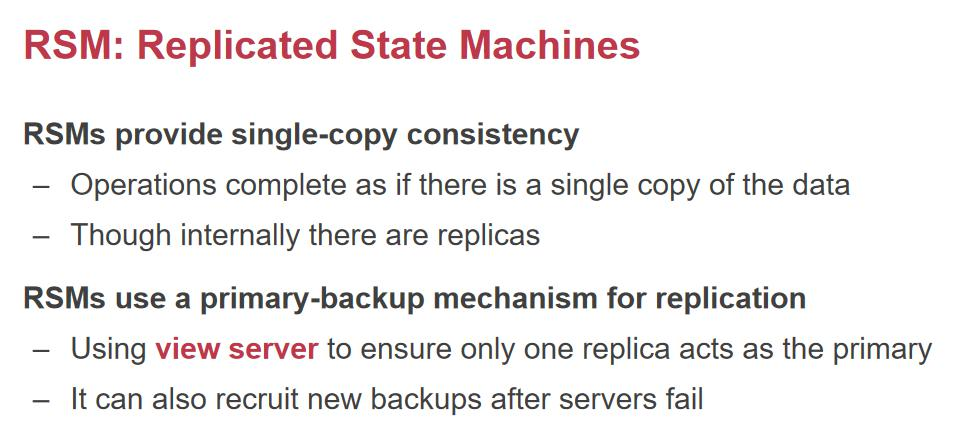

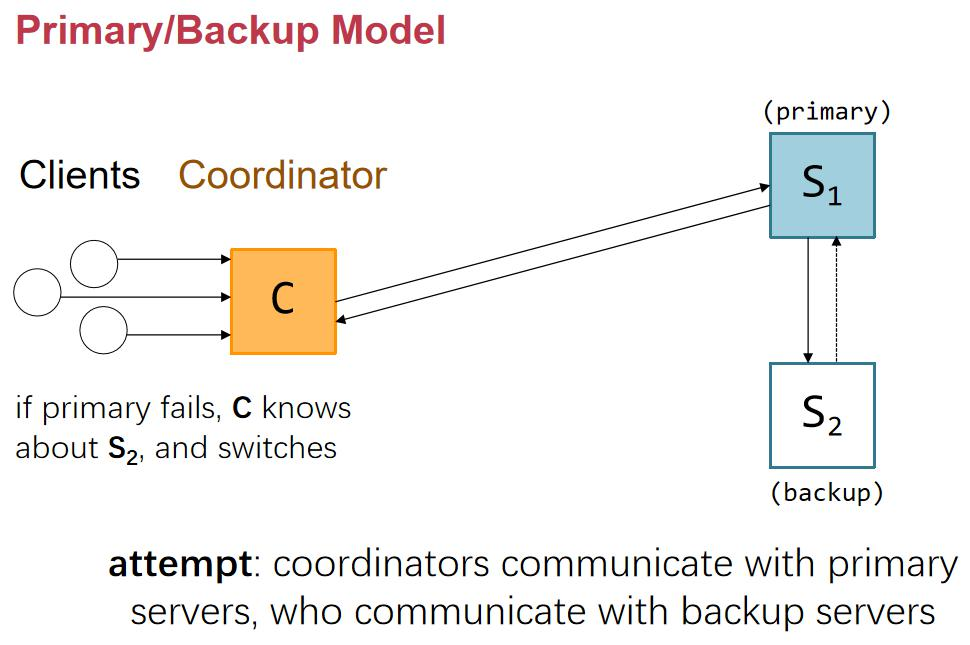

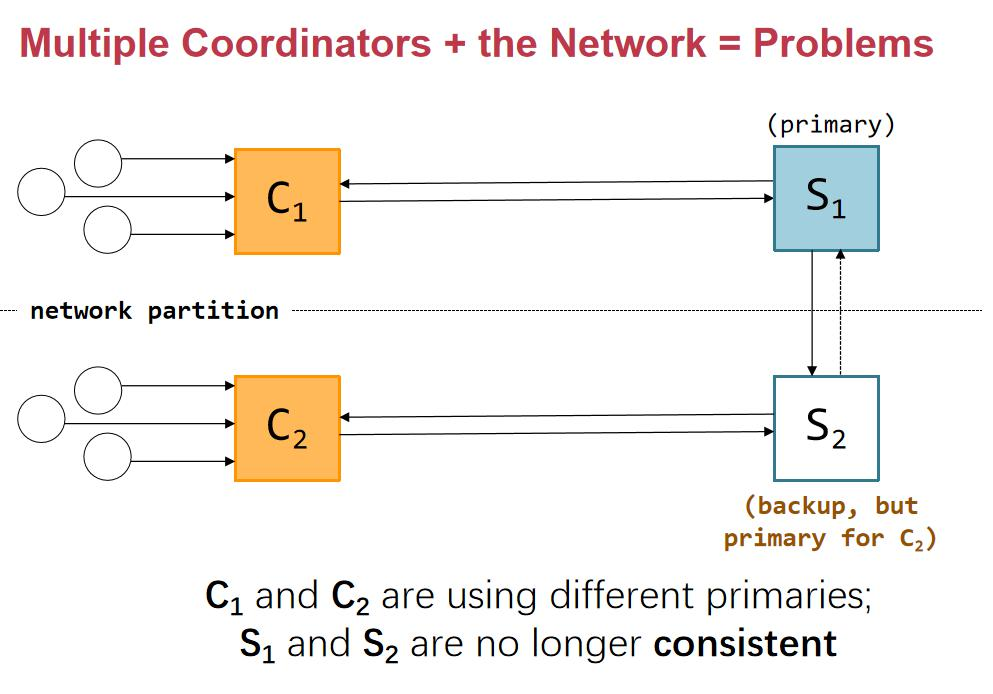

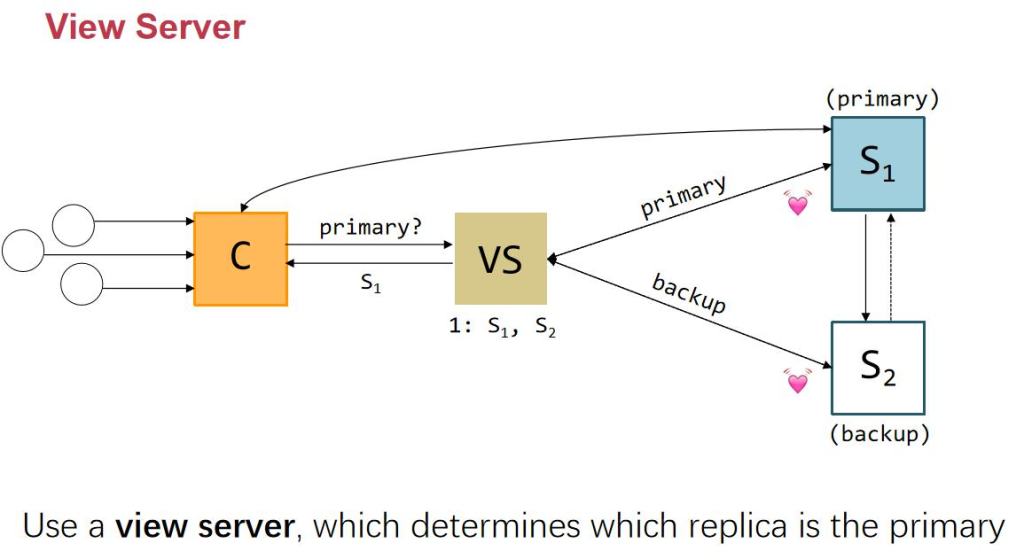

Primary-backup model

- Primary forwards writes to all the replicas

M0 executes writes locally (in order)

Respond OK

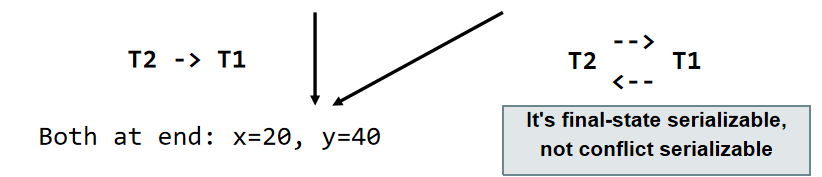

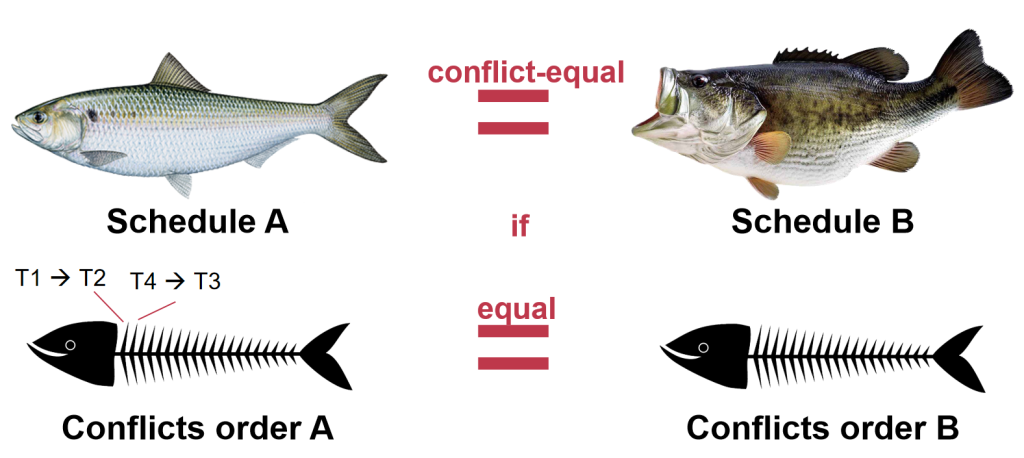

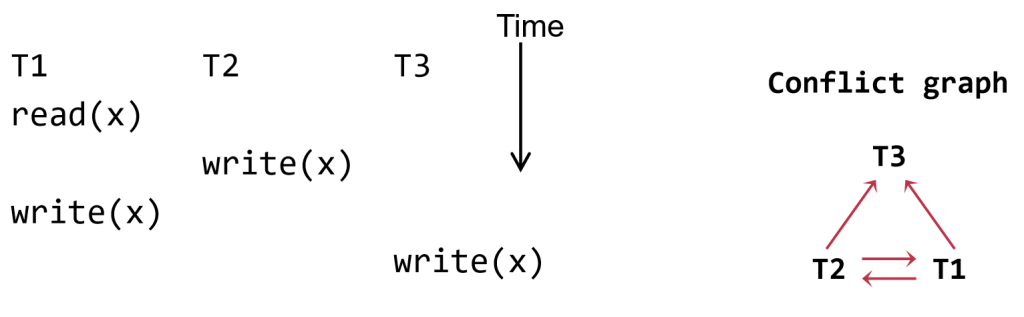

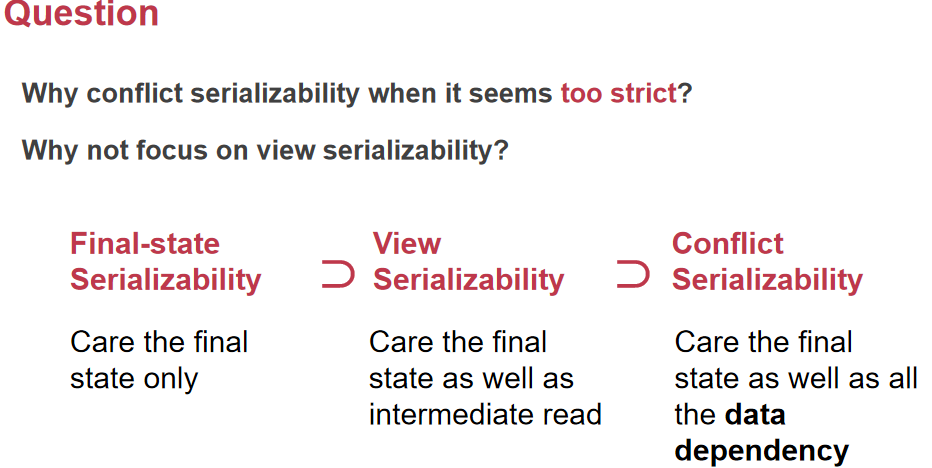

ن¸€è‡´و€§و¨،ه‹ه’Œوœ€ç»ˆن¸€è‡´و€§

逻辑و€§ن؟وŒپو£ç،®و€§çڑ„هژںه›

- و¯ڈن¸ھو•°وچ®é،¹هڈھوœ‰ن¸€ن¸ھه‰¯وœ¬م€‚

- و•´ن¸ھç³»ç»ںçڑ„è،Œن¸؛ç‰هگŒن؛ژوںگç§چن¸²è،Œè،Œن¸؛م€‚

- و•´ن¸ھç³»ç»ںçڑ„è،Œن¸؛هڈ¯ن»¥è¢«è§†ن¸؛ن¸€ن¸ھن»ژن¸چه¤±è´¥çڑ„ç³»ç»ں

è؟™ن¸‰ç§چن¸€è‡´و€§و¨،ه‹هœ¨هˆ†ه¸ƒه¼ڈç³»ç»ںن¸ه®ڑن¹‰ن؛†ن¸چهگŒçڑ„é،؛ه؛ڈه…³ç³»

1. ه…¨ه±€هڈ‘èµ·é،؛ه؛ڈ(ن¸¥و ¼ن¸€è‡´و€§ï¼‰

- ه®ڑن¹‰ï¼ڑو‰€وœ‰و“چن½œهœ¨ه…¨ه±€ن¸ٹوŒ‰ç…§و—¶é—´é،؛ه؛ڈè؟›è،Œï¼Œو‰€وœ‰è؟›ç¨‹éƒ½ه¯¹و“چن½œçڑ„é،؛ه؛ڈوœ‰ه®Œه…¨ن¸€è‡´çڑ„视ه›¾م€‚

- 特点ï¼ڑن»»ن½•ن¸€ن¸ھو“چن½œçڑ„结وœه؟…é،»هœ¨و‰€وœ‰هگژç»و“چن½œن¹‹ه‰چهڈ¯è§پ,ç،®ن؟ç³»ç»ںçٹ¶و€پهœ¨و‰€وœ‰ç”¨وˆ·çœ‹و¥وک¯ه®Œه…¨ن¸€è‡´çڑ„م€‚

- ه±€é™گو€§ï¼ڑه®çژ°ن¸¥و ¼ن¸€è‡´و€§é€ڑه¸¸éœ€è¦پ较é«کçڑ„ه»¶è؟ںه’Œه¤چو‚çڑ„هچڈè°ƒوœ؛هˆ¶م€‚

2. و¯ڈن¸ھè؟›ç¨‹çڑ„هڈ‘èµ·/ه®Œوˆگé،؛ه؛ڈ(é،؛ه؛ڈن¸€è‡´و€§ sequential consistency)

- ه®ڑن¹‰ï¼ڑو¯ڈن¸ھè؟›ç¨‹çڑ„و“چن½œهœ¨وœ¬هœ°وک¯وŒ‰ç…§ه…¶هڈ‘èµ·çڑ„é،؛ه؛ڈهڈ¯è§پ,ن½†ن¸چهگŒè؟›ç¨‹ن¹‹é—´çڑ„é،؛ه؛ڈهڈ¯èƒ½ن¸چن¸€è‡´م€‚

- 特点ï¼ڑ用وˆ·هڈ¯ن»¥çœ‹هˆ°è‡ھه·±هڈ‘èµ·çڑ„و“چن½œçڑ„é،؛ه؛ڈ,ن½†ه¯¹ن؛ژه…¶ن»–è؟›ç¨‹çڑ„و“چن½œçڑ„é،؛ه؛ڈو²،وœ‰ه…¨ه±€è§†ه›¾م€‚

- ه±€é™گو€§ï¼ڑه…پ许وںگن؛›و“چن½œçڑ„ه¹¶è،Œو€§ï¼Œن½†هڈ¯èƒ½ه¯¼è‡´ن¸چهگŒè؟›ç¨‹çœ‹هˆ°çڑ„ç³»ç»ںçٹ¶و€پن¸چن¸€è‡´م€‚

3. ه…¨ه±€â€œه®Œوˆگ-هڈ‘èµ·â€é،؛ه؛ڈ(ç؛؟و€§هŒ– linearizability)

- ه®ڑن¹‰ï¼ڑهœ¨ن¸€ن¸ھ逻辑و—¶é—´ç‚¹ن¸ٹ,و‰€وœ‰و“چن½œçڑ„ه®Œوˆگو—¶é—´ن¸ژهڈ‘èµ·و—¶é—´éƒ½وœ‰ن¸€ن¸ھن¸€è‡´çڑ„é،؛ه؛ڈ,هچ³و¯ڈن¸ھو“چن½œéƒ½وœ‰ن¸€ن¸ھه”¯ن¸€çڑ„و—¶é—´وˆ³ï¼Œن¸”و‰€وœ‰و“چن½œهœ¨و—¶é—´ن¸ٹوک¯é،؛ه؛ڈوژ’هˆ—çڑ„م€‚

- 特点ï¼ڑ用وˆ·هœ¨ن»»ن½•و—¶ه€™çœ‹هˆ°çڑ„ç³»ç»ںçٹ¶و€پ都وک¯ن¸€è‡´çڑ„,ن¸”هڈ¯ن»¥é€ڑè؟‡ن¸€ن¸ھè™ڑو‹ںçڑ„ç؛؟و€§هŒ–و—¶é—´è½´و¥çگ†è§£م€‚

- ه±€é™گو€§ï¼ڑو¯”ن¸¥و ¼ن¸€è‡´و€§ه®½و¾ï¼Œه…پ许و›´é«کçڑ„ه¹¶هڈ‘و€§ï¼Œن½†ن»چ然è¦پو±‚ç³»ç»ں能ه¤ںهœ¨é€»è¾‘ن¸ٹè؟›è،Œن¸€è‡´çڑ„و“چن½œé،؛ه؛ڈم€‚

ه®çژ°ç؛؟و€§هŒ– linearizability

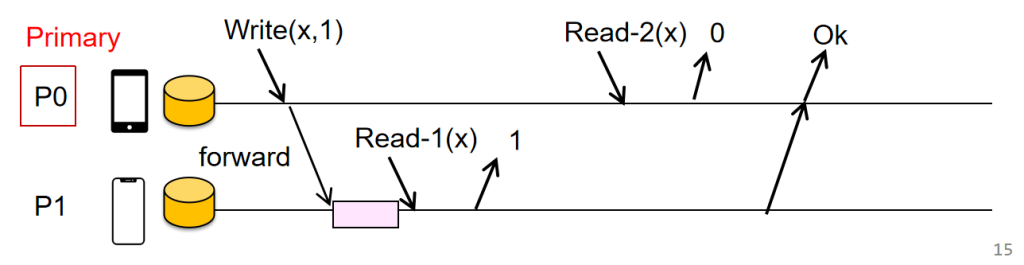

ه¯¹ن؛ژه†™و“چن½œï¼ڑ

ن¸»èٹ‚点(Primary)ه°†ه†™و“چن½œè½¬هڈ‘ç»™و‰€وœ‰ه‰¯وœ¬ï¼ˆReplicas)م€‚

ن¸»èٹ‚点هœ¨وœ¬هœ°وŒ‰é،؛ه؛ڈو‰§è،Œه†™و“چن½œم€‚

و‰§è،Œه®Œهگژ,ن¸»èٹ‚点è؟”ه›â€œOKâ€ç»™ه®¢وˆ·ç«¯م€‚

ه¯¹ن؛ژ读و“چن½œï¼ڑ

ن¸»èٹ‚点直وژ¥è؟”ه›ه…¶وœ¬هœ°و•°وچ®çڑ„ه‰¯وœ¬ç»™ه®¢وˆ·ç«¯م€‚

Implementing linearizability: Primary-backup approach

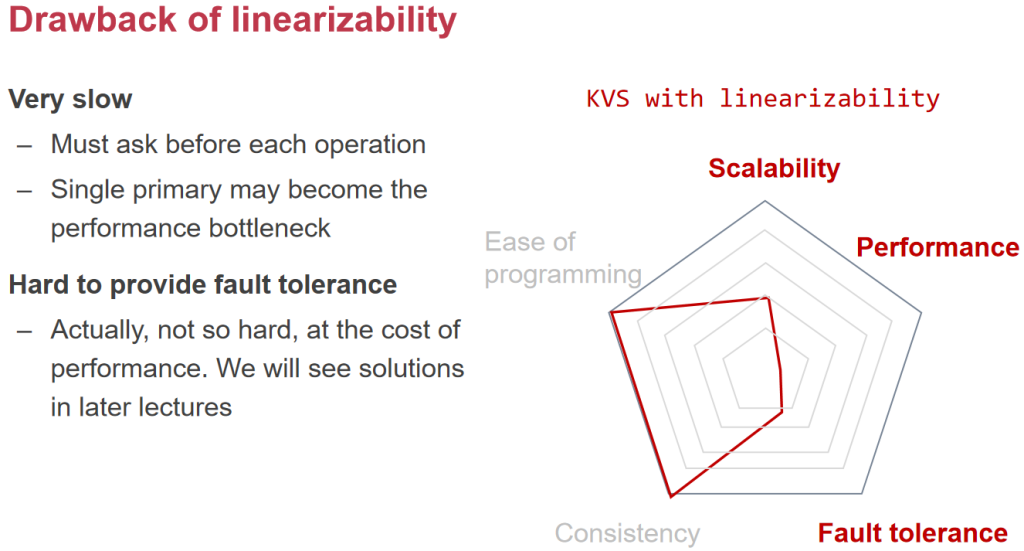

Primary-Backup Modelçڑ„ç¼؛点

و€§èƒ½é—®é¢کï¼ڑ

读هڈ–و€§èƒ½ï¼ڑو¯ڈو¬،读هڈ–و“چن½œéƒ½éœ€è¦پé¢ه¤–çڑ„ه¾€è؟”و—¶é—´ï¼ˆRTT)و¥èپ”ç³»ن¸»èٹ‚点(Primary)م€‚è؟™ه¢هٹ ن؛†ه»¶è؟ں,ه°¤ه…¶وک¯هœ¨é«کè´ںè½½çڑ„وƒ…ه†µن¸‹م€‚

ه†™ه…¥و€§èƒ½ï¼ڑه†™و“چن½œن¸چن»…需è¦پن¸ژن¸»èٹ‚点è؟›è،Œé€ڑن؟،,è؟ک需è¦پن¸ژو‰€وœ‰ه‰¯وœ¬ï¼ˆBackups)èپ”系,è؟™ه¯¼è‡´و›´ه¤ڑçڑ„RTT,è؟›ن¸€و¥ه¢هٹ ن؛†ه»¶è؟ںم€‚

هڈ¯و‰©ه±•و€§é—®é¢کï¼ڑ

ن¸»èٹ‚点هڈ¯èƒ½وˆگن¸؛و€§èƒ½ç“¶é¢ˆم€‚éڑڈç€ه®¢وˆ·ç«¯è¯·و±‚çڑ„ه¢هٹ ,ن¸»èٹ‚点需è¦په¤„çگ†و‰€وœ‰çڑ„读ه†™و“چن½œï¼Œهڈ¯èƒ½ه¯¼è‡´è´ںè½½è؟‡é‡چ,ه½±ه“چو•´ن½“ç³»ç»ںçڑ„ه“چه؛”و—¶é—´ه’Œهگهگگé‡ڈم€‚

هڈ¯é و€§é—®é¢کï¼ڑ

ه¦‚وœن¸»èٹ‚点وˆ–وںگن¸ھه‰¯وœ¬ه´©و؛ƒï¼Œç³»ç»ںçڑ„هڈ¯é و€§ن¼ڑهڈ—هˆ°ه½±ه“چم€‚虽然هڈ¯ن»¥è®¾è®،ه†—ن½™وœ؛هˆ¶ï¼Œن½†هœ¨ن¸»èٹ‚点ه´©و؛ƒçڑ„وƒ…ه†µن¸‹ï¼Œç³»ç»ںهڈ¯èƒ½ن¼ڑهڈکه¾—ن¸چهڈ¯ç”¨ï¼Œه°¤ه…¶وک¯ه¦‚وœو²،وœ‰وœ‰و•ˆçڑ„و•…éڑœè½¬ç§»وœ؛هˆ¶م€‚

وˆ‘ن»¬هڈ¯ن»¥ه…پ许read读هڈ–ن»»و„ڈه‰¯وœ¬هگ—ï¼ں

ه¯¹ن؛ژه†™و“چن½œï¼ڑ

- ن¸»èٹ‚点(Primary)转هڈ‘ه†™è¯·و±‚ï¼ڑن¸»èٹ‚点ه°†ه†™و“چن½œè½¬هڈ‘ç»™و‰€وœ‰ه‰¯وœ¬ï¼ˆReplicas)م€‚

- وœ¬هœ°و‰§è،Œï¼ڑن¸»èٹ‚点(M0)هœ¨وœ¬هœ°وŒ‰é،؛ه؛ڈو‰§è،Œه†™و“چن½œم€‚

- ه“چه؛”ï¼ڑو‰§è،Œه®Œهگژ,ن¸»èٹ‚点è؟”ه›â€œOKâ€ç»™ه®¢وˆ·ç«¯ï¼Œè،¨ç¤؛ه†™ه…¥وˆگهٹںم€‚

ه¯¹ن؛ژ读و“چن½œï¼ڑ

è؟”ه›ه‰¯وœ¬و•°وچ®ï¼ڑن»»ن½•ه‰¯وœ¬éƒ½هڈ¯ن»¥è؟”ه›ه…¶وœ¬هœ°و•°وچ®çڑ„ه‰¯وœ¬ç»™ه®¢وˆ·ç«¯م€‚è؟™ç§چ设è®،ه…پ许ن»ژه¤ڑن¸ھه‰¯وœ¬è؟›è،Œè¯»هڈ–,ن»¥وڈگé«کهڈ¯ç”¨و€§ه’Œو€§èƒ½م€‚

é—®é¢ک,و¤و—¶P0éک…读ن؛§ç”ںé—®é¢ک

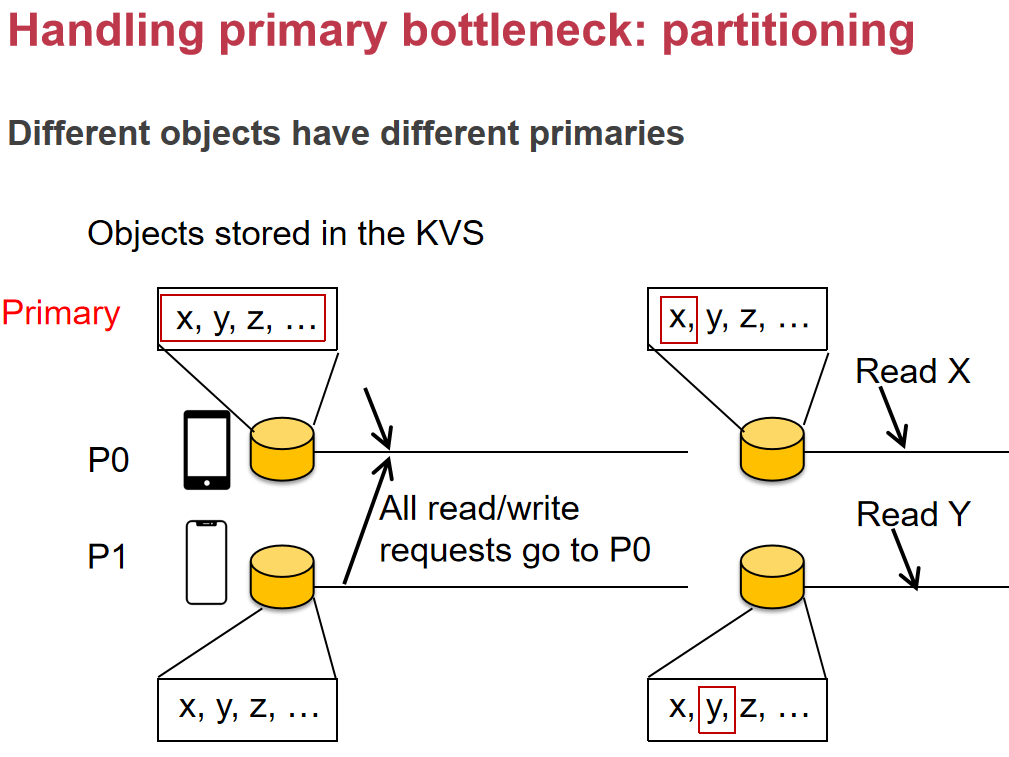

é€ڑè؟‡هˆ†هŒ؛و¥ن¼کهŒ–Primary-Backupç³»ç»ںçڑ„و€§èƒ½ï¼Œç‰¹هˆ«وک¯è§£ه†³ن؛†هڈ¯و‰©ه±•و€§é—®é¢کم€‚و¯ڈن¸ھPrimaryèٹ‚点ه¤„çگ†ن¸چهگŒه¯¹è±،çڑ„读ه†™è¯·و±‚,وœ‰و•ˆهˆ†و•£ن؛†è´ں载,ه‡ڈه°‘ن؛†هچ•èٹ‚点وˆگن¸؛瓶颈çڑ„é£ژ险م€‚

Eventual consistency

特点ï¼ڑ

وœ€ç»ˆن¸€è‡´و€§ï¼ˆEventual consistency )ï¼ڑو‰€وœ‰وœچهٹ،ه™¨وœ€ç»ˆéƒ½ن¼ڑو”¶هˆ°و‰€وœ‰ه†™و“چن½œï¼Œو‹¥وœ‰ç›¸هگŒه†™و“چن½œçڑ„وœچهٹ،ه™¨ه°†وœ‰ن¸€è‡´çڑ„و•°وچ®ه†…ه®¹م€‚ه› و¤ï¼Œه¦‚وœو•°وچ®و²،وœ‰و–°çڑ„و›´و–°و“چن½œï¼Œوœ€ç»ˆو‰€وœ‰çڑ„è®؟问都ن¼ڑè؟”ه›وœ€هگژن¸€و¬،و›´و–°çڑ„ه€¼م€‚

ن¼کهŒ–çڑ„读ه†™و“چن½œï¼ڑ

读و“چن½œï¼ڑè؟”ه›وœچهٹ،ه™¨ن¸ٹçڑ„وœ€و–°وœ¬هœ°ه‰¯وœ¬و•°وچ®ï¼Œè؟™و ·هڈ¯ن»¥وڈگé«ک读و“چن½œçڑ„و€§èƒ½ï¼Œه‡ڈه°‘ه»¶è؟ںم€‚

ه†™و“چن½œï¼ڑه†™و“چن½œé¦–ه…ˆهœ¨وœ¬هœ°و‰§è،Œه¹¶ç›´وژ¥è؟”ه›ï¼Œه†™ه…¥çڑ„و•°وچ®ن¼ڑهœ¨هگژهڈ°ن¼ و’هˆ°و‰€وœ‰وœچهٹ،ه™¨ï¼ˆن¾‹ه¦‚é€ڑè؟‡هگŒو¥و“چن½œï¼‰م€‚è؟™وک¯و€§èƒ½وœ€ن¼کçڑ„ه®çژ°و–¹ه¼ڈ,ه› ن¸؛ه†™و“چن½œن¸چن¼ڑه› ن¸؛ç‰ه¾…هگŒو¥è€Œه»¶è؟ںم€‚

GFS çڑ„وœ€ç»ˆن¸€è‡´و€§و¨،ه‹

GFS ن½؟用ن¸€ç§چç±»ن¼¼وœ€ç»ˆن¸€è‡´و€§çڑ„و¨،ه‹ï¼Œهچ³â€œو¯ڈن¸ھه‰¯وœ¬وœ€ç»ˆن¼ڑوœ‰ç›¸هگŒçڑ„و•°وچ®â€م€‚GFS é€ڑè؟‡ن½؟用ن¸»èٹ‚点و¥هچڈè°ƒه†™و“چن½œï¼Œه®çژ°وœ€ç»ˆن¸€è‡´و€§م€‚è؟™ç§چو–¹ه¼ڈ适用ن؛ژو•°وچ®ن¸ه؟ƒçڑ„هœ؛و™¯م€‚

GFS 适هگˆèپٹه¤©ه؛”用هگ—ï¼ں

وک¾ç„¶ن¸چ适هگˆï¼Œهژںه› ه¦‚ن¸‹ï¼ڑ

- é«که»¶è؟ںï¼ڑGFS çڑ„ن¸»èٹ‚点هچڈè°ƒه’ŒهگŒو¥è؟‡ç¨‹هڈ¯èƒ½ه¯¼è‡´è¾ƒé«که»¶è؟ں,و— و³•و»،足èپٹه¤©ه؛”用çڑ„ه®و—¶و€§éœ€و±‚م€‚

- ه‰¯وœ¬هگŒو¥é—®é¢کï¼ڑèپٹه¤©ه؛”用需è¦په؟«é€ںهگŒو¥و•°وچ®ï¼ŒGFS çڑ„وœ€ç»ˆن¸€è‡´و€§و¨،ه‹هڈ¯èƒ½ه¯¼è‡´و¶ˆوپ¯ن¸چهگŒو¥م€‚

- 设è®،ç›®و ‡ن¸چهگŒï¼ڑGFS ن¸»è¦پن¸؛ه¤§è§„و¨،هکه‚¨è®¾è®،,ن¸چ适هگˆéœ€è¦پن½ژه»¶è؟ںم€پé«کن¸€è‡´و€§çڑ„èپٹه¤©ه؛”用هœ؛و™¯م€‚

وˆ‘ن»¬وƒ³هœ¨èپٹه¤©ç±»ه؛”用程ه؛ڈن¸è¯»/ه†™ن»€ن¹ˆ

و–¹و³•ï¼ڑç›´وژ¥ه†™ه…¥ç¦»ه®¢وˆ·ç«¯وœ€è؟‘çڑ„وœچهٹ،ه™¨ï¼Œوœچهٹ،ه™¨ç،®è®¤ه†™ه…¥هگژ,ه†چه°†و›´و–°ن¼ و’ç»™ه…¶ن»–وœچهٹ،ه™¨م€‚وœچهٹ،ه™¨هڈ¯ن»¥ه’Œه®¢وˆ·ç«¯هœ¨هگŒن¸€ن½چç½®م€‚

é—®é¢کï¼ڑ

هœ¨è؟™ç§چ设置ن¸‹ï¼Œهڈ¯èƒ½ه‡؛çژ°çڑ„é—®é¢کï¼ڑ

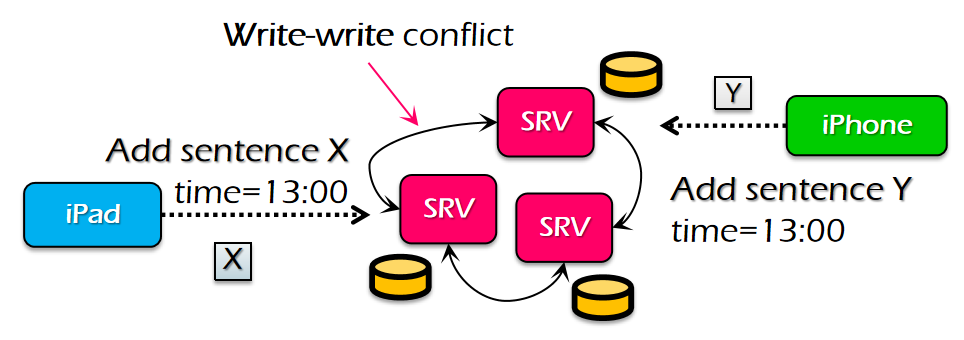

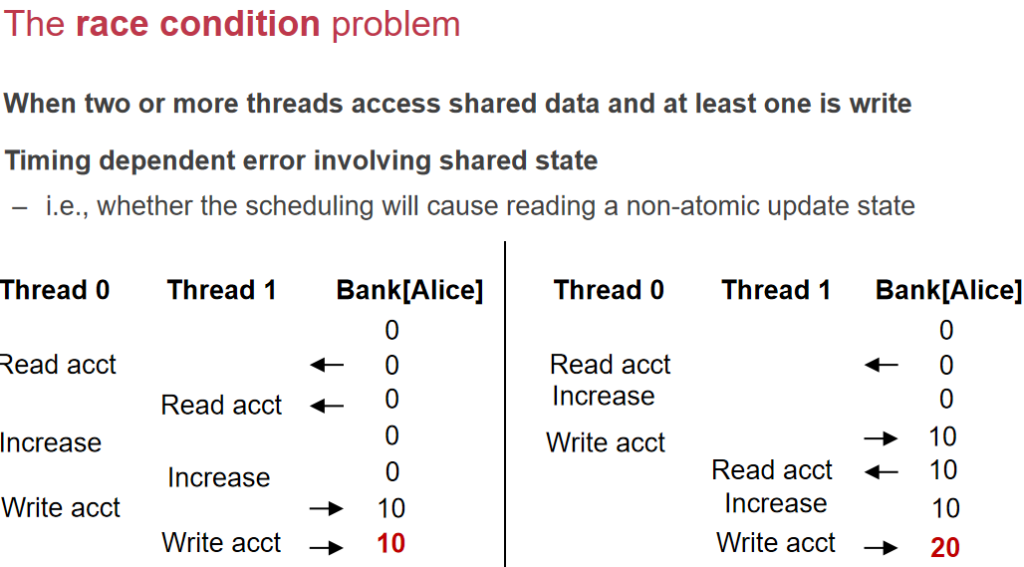

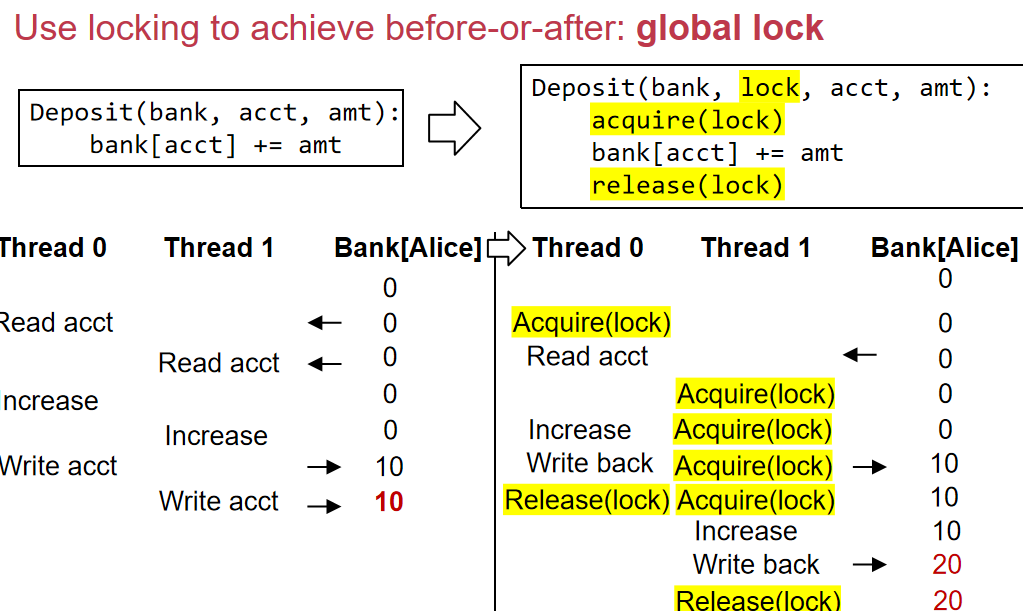

ن¸€ن¸ھه¸¸è§پçڑ„ه¼‚ه¸¸çژ°è±،هڈ«هپڑه†™-ه†™ه†²çھپم€‚ه½“ه¤ڑن¸ھوœچهٹ،ه™¨هœ¨ن¸چçں¥éپ“ه½¼و¤çڑ„وƒ…ه†µن¸‹هگŒو—¶و›´و–°ç›¸هگŒçڑ„و•°وچ®و—¶ï¼Œن¼ڑهڈ‘ç”ںè؟™ç§چوƒ…ه†µم€‚

结وœï¼ڑو•°وچ®ه‡؛çژ°هˆ†و§م€‚ن¾‹ه¦‚,ن¸€ن¸ھوœچهٹ،ه™¨ه…ˆو·»هٹ X هگژو·»هٹ Y,而هڈ¦ن¸€ن¸ھوœچهٹ،ه™¨é،؛ه؛ڈ相هڈچ,وœ€ç»ˆçڑ„و•°وچ®ه°±ن¸چن¸€è‡´ï¼Œو— و³•ن؟è¯پهڈھوœ‰ن¸€ن¸ھو£ç،®çڑ„版وœ¬م€‚