Index

第дёҖз« пјҡStateful and Stateless пјҢCookie and Session, е®һдҫӢжұ , Scope пјҢж•°жҚ®еә“иҝһжҺҘжұ

第дәҢз« пјҡMessaging , еҗҢжӯҘејӮжӯҘйҖҡдҝЎпјҢдёүз§Қи®ўйҳ…ж–№ејҸеҜ№жҜ” пјҢKafka

第дёүз« пјҡWebsocket

第еӣӣз« пјҡTransactionпјҲACID и„ҸиҜ»е№»иҜ»пјүпјҢдёӨйҳ¶ж®өжҸҗдәӨпјҢд№җи§Ӯ/жӮІи§ӮзҰ»зәҝрҹ”’

第дә”з« пјҡи°ғеәҰпјҲеҸҜдёІиЎҢеҢ–и°ғеәҰпјүпјҢеҗ„з§Қж—Ҙеҝ—пјҲйҖ»иҫ‘/зү©зҗҶ/redo/undo/redoundo/иЎҘеҒҝпјүпјҢзі»з»ҹеҙ©жәғжҒўеӨҚе®һзҺ°

第е…ӯз« пјҡзәҝзЁӢпјҲеӨҡзәҝзЁӢпјҢзәҝзЁӢжұ пјҢзәҝзЁӢе№Іжү°пјҢSynchronizedпјүпјҢй«ҳзә§е№¶еҸ‘зү№жҖ§пјҢFork/Join

第дёғз« пјҡCacheпјҢMemcacheпјҢRedisпјҢдёҖиҮҙжҖ§е“ҲеёҢ

з¬¬е…«з« пјҡеҸҚеҗ‘зҙўеј•пјҢLucene

第д№қз« пјҡSOAPпјҢRestfulпјҢWeb ServiceпјҢSOA

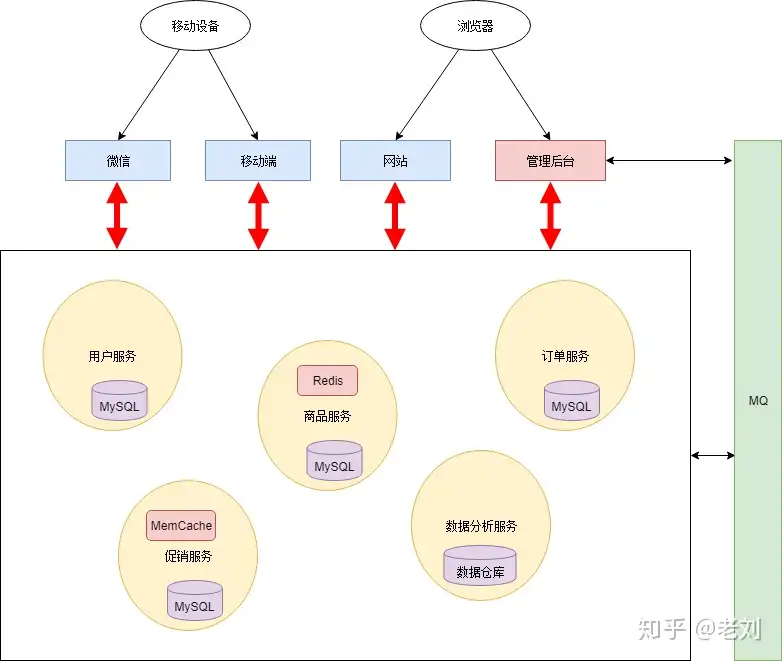

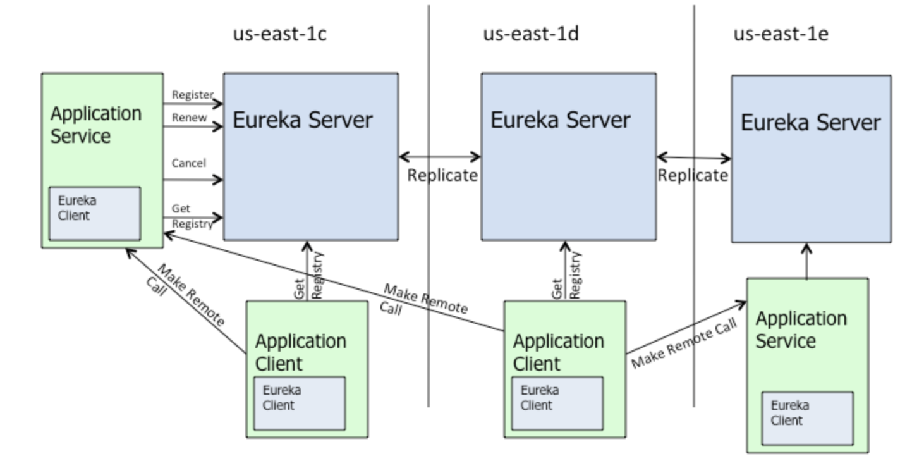

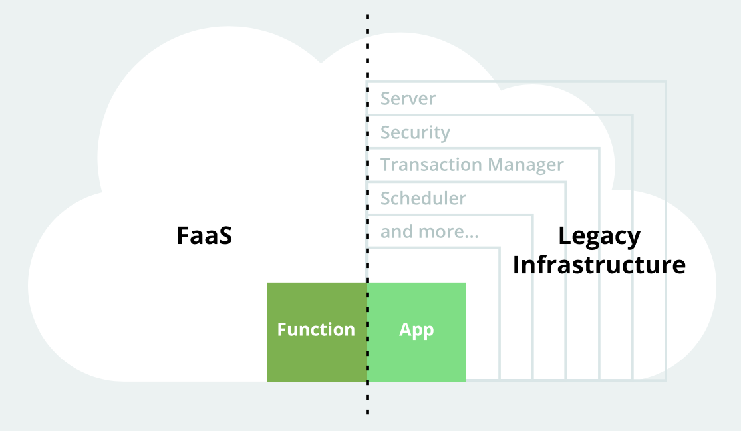

第еҚҒз« пјҡMicroServiceпјҢEurakaпјҢServerless

第еҚҒдёҖз« пјҡMysqlдјҳеҢ–1пјҲж–Ҫе·Ҙдёӯвҡ пёҸпјүIn a big mess , Who can help meрҹҳӯ

第еҚҒдәҢз« пјҡMysqlдјҳеҢ–2пјҲж–Ҫе·Ҙдёӯвҡ пёҸпјүIn a big mess , Who can help meрҹҳӯ

第еҚҒдёүз« пјҡMysqlж•°жҚ®еә“жҒўеӨҚдёҺеӨҮд»ҪпјҲйҖ»иҫ‘зү©зҗҶеӨҮд»ҪпјҢbinlogпјҢsnapshotпјү

第еҚҒеӣӣз« пјҡMySQLеҲҶеҢә

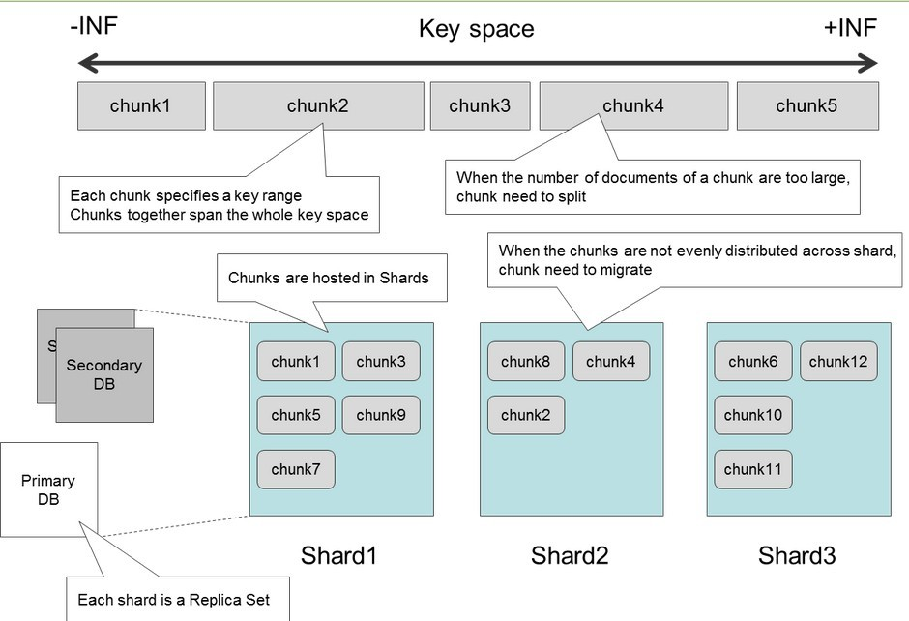

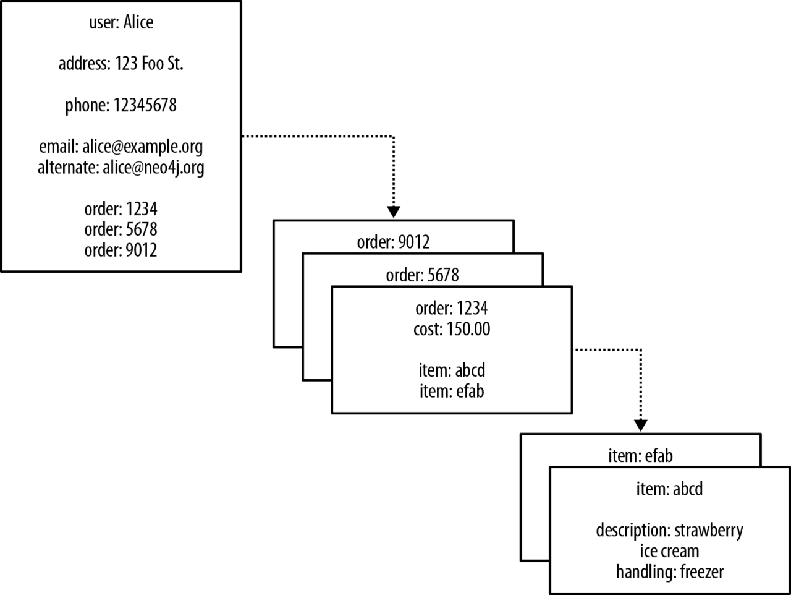

第еҚҒдә”з« пјҡNosqlпјҢMongoDBпјҢDAOе’ҢRepositoryе·®ејӮпјҢshardingиҝҮзЁӢ

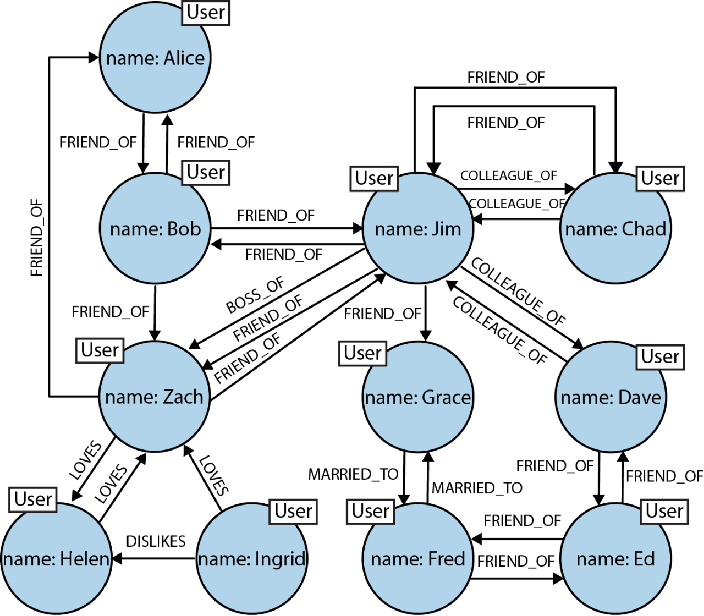

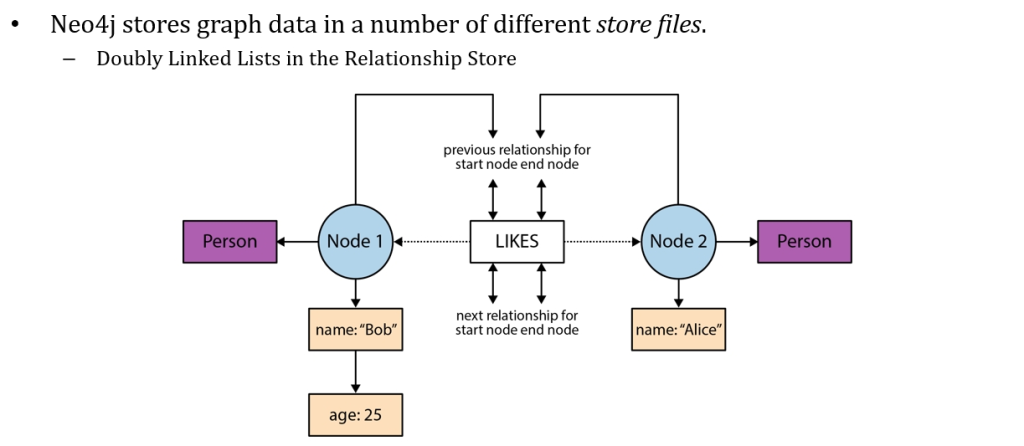

第еҚҒе…ӯз« пјҡеӣҫж•°жҚ®еә“пјҢNeo4j

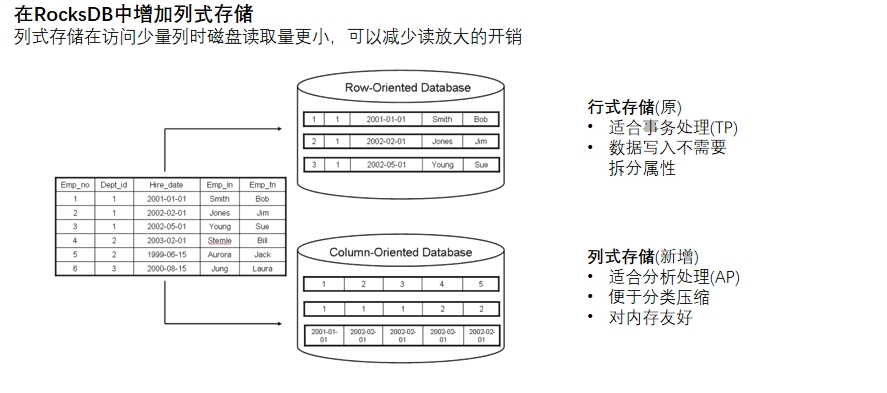

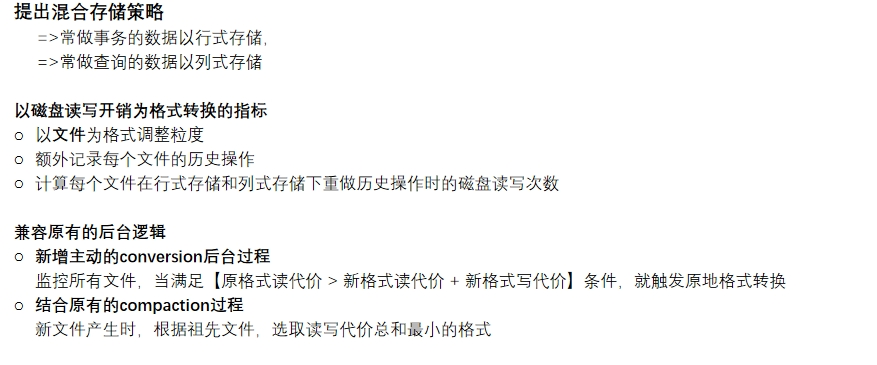

第еҚҒдёғз« пјҡLSM-Tree, ssTableпјҢеҗ‘йҮҸж•°жҚ®еә“

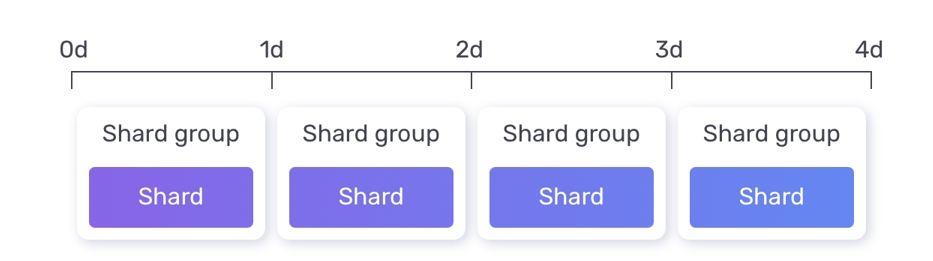

第еҚҒе…«з« пјҡж—¶еәҸж•°жҚ®еә“пјҢinfluxDB

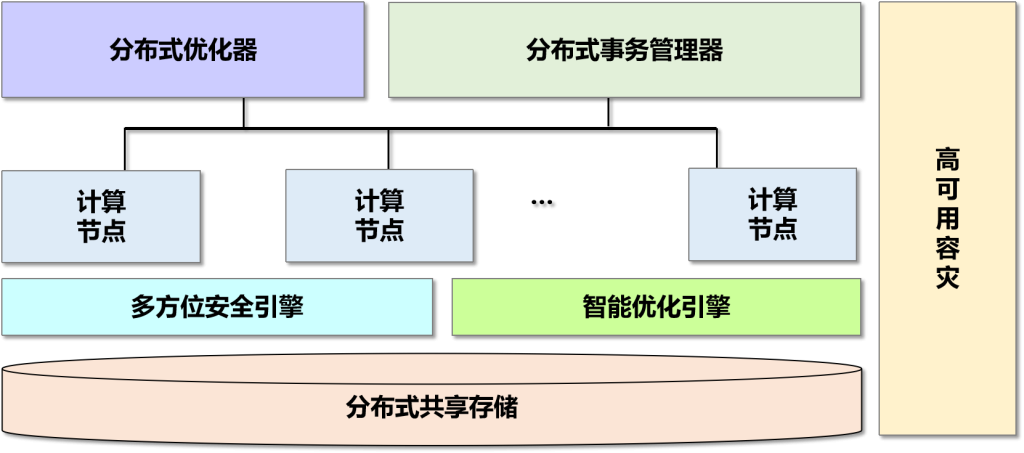

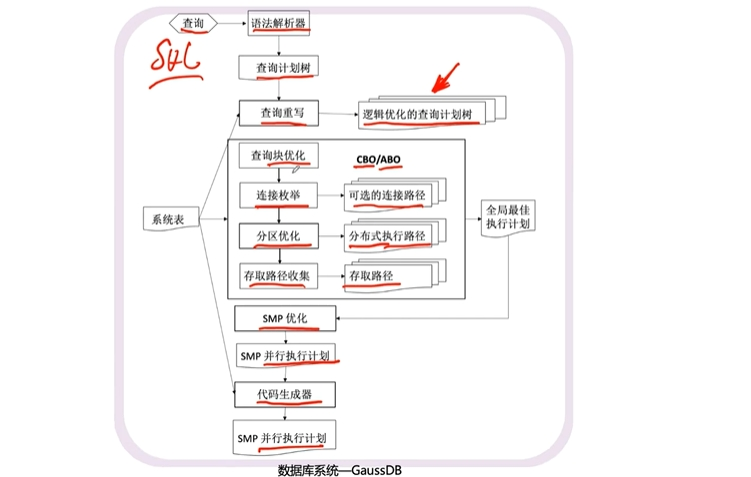

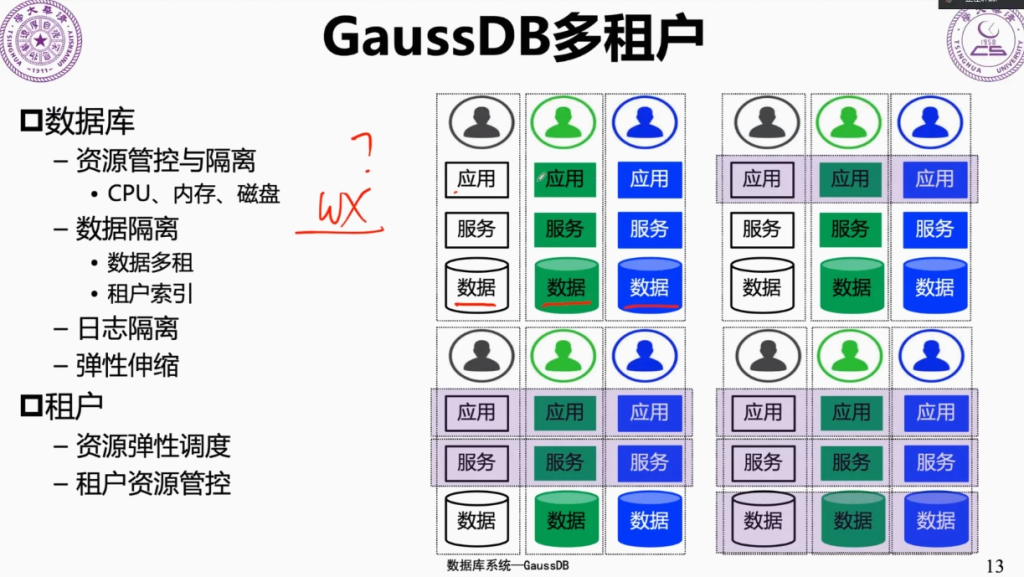

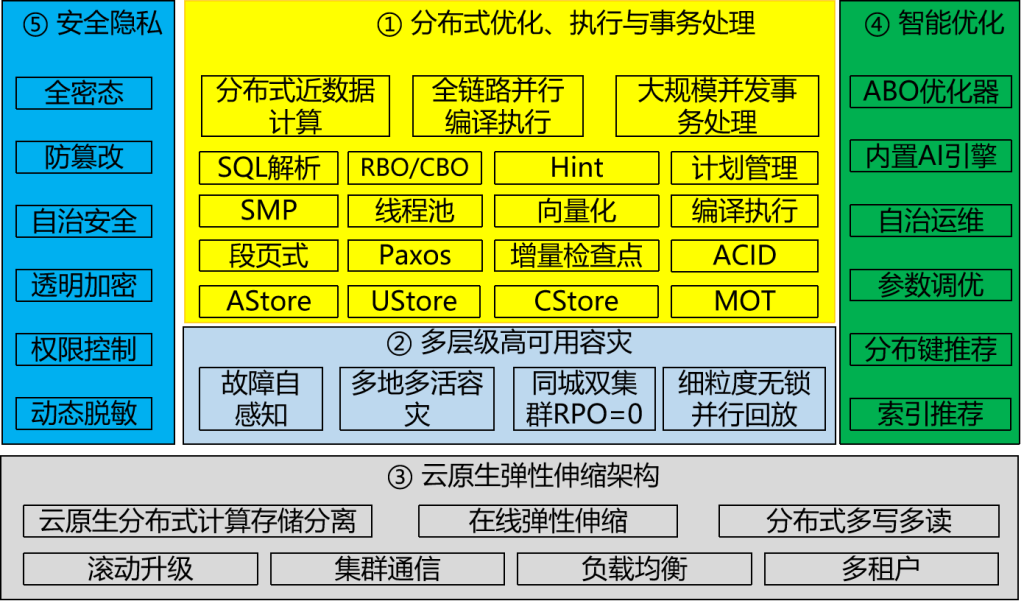

第еҚҒд№қз« пјҡGaussDBпјҢдә‘ж•°жҚ®еә“

第дәҢеҚҒз« пјҡData WarehouseпјҢData Lake

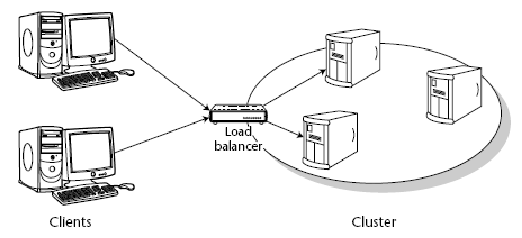

第дәҢеҚҒдёҖз« пјҡClusterпјҢйӣҶзҫӨпјҢиҙҹиҪҪеқҮиЎЎпјҢsessionз»ҙжҠӨпјҢNginxпјҢеҸҚеҗ‘д»ЈзҗҶ

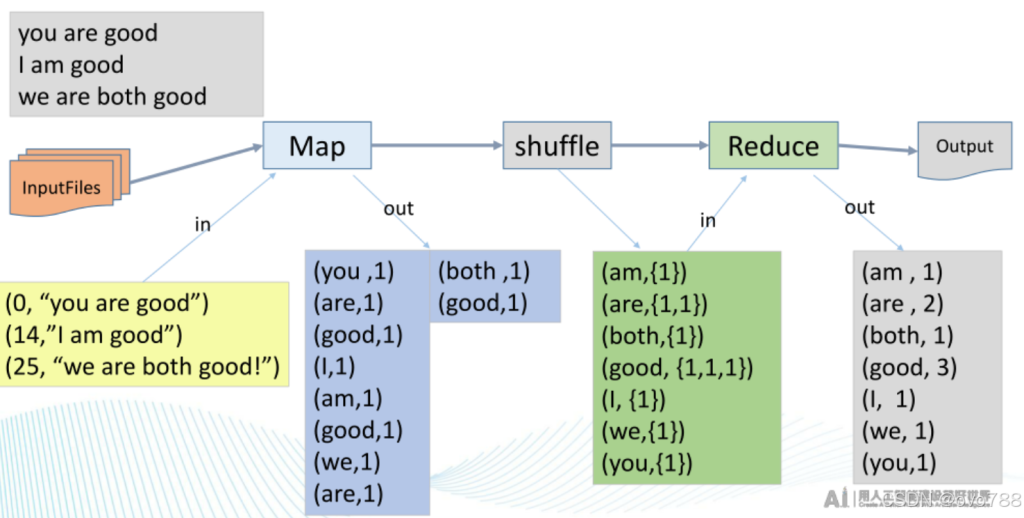

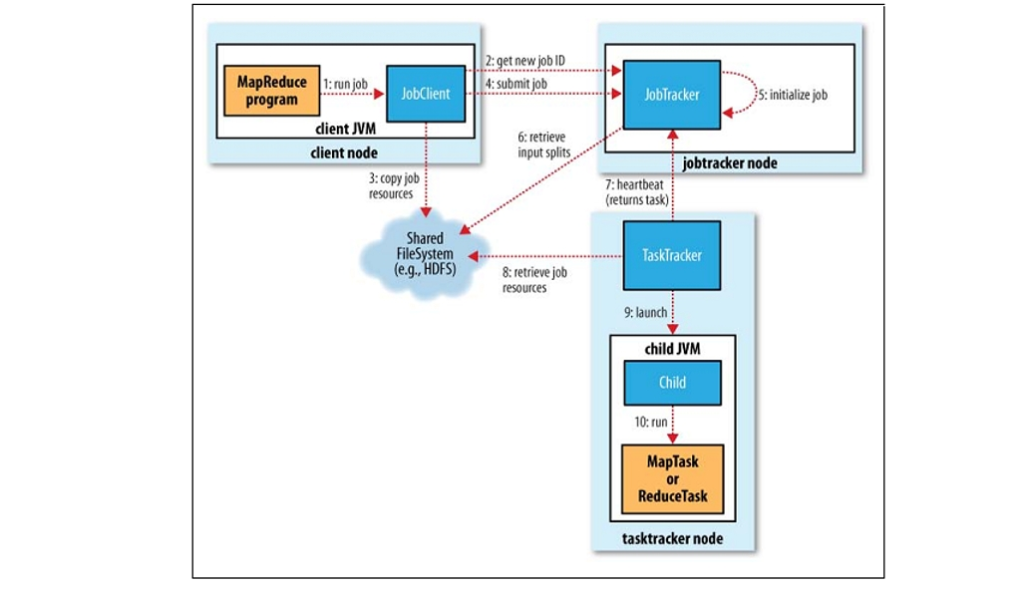

第дәҢеҚҒдәҢз« пјҡcloud computingпјҢMapReduceпјҢedge computing

第дәҢеҚҒдёүз« пјҡGraphQL(д»ҘеҸҠе’Ң RESTful APIпјүеҜ№жҜ”

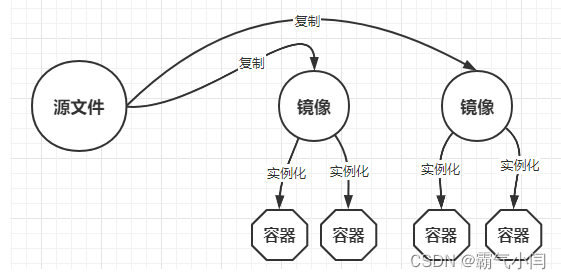

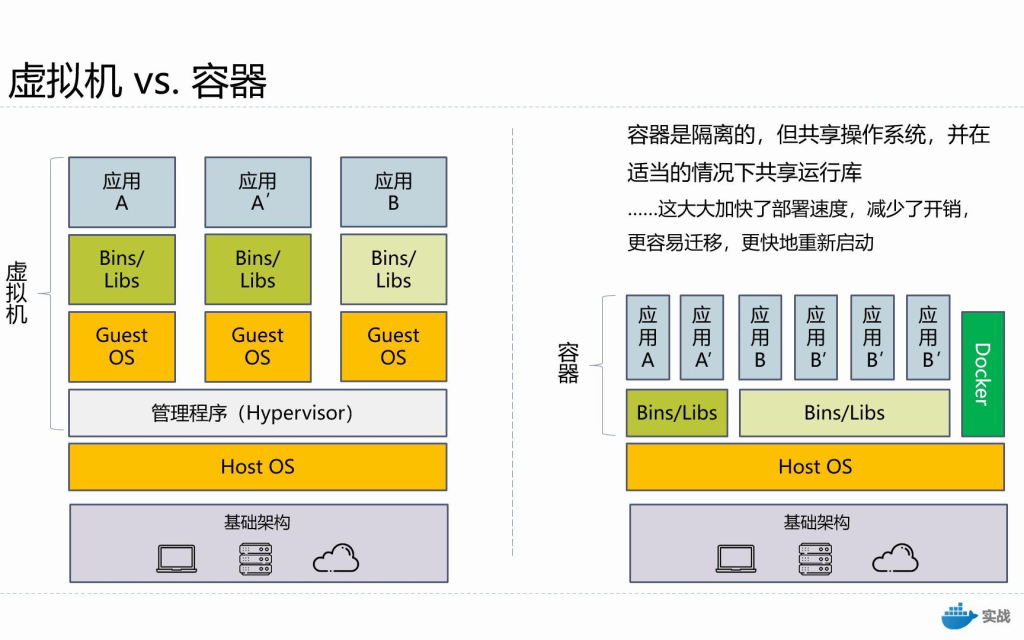

第дәҢеҚҒеӣӣз« пјҡDockerпјҢImageпјҢVolumeпјҢmounts

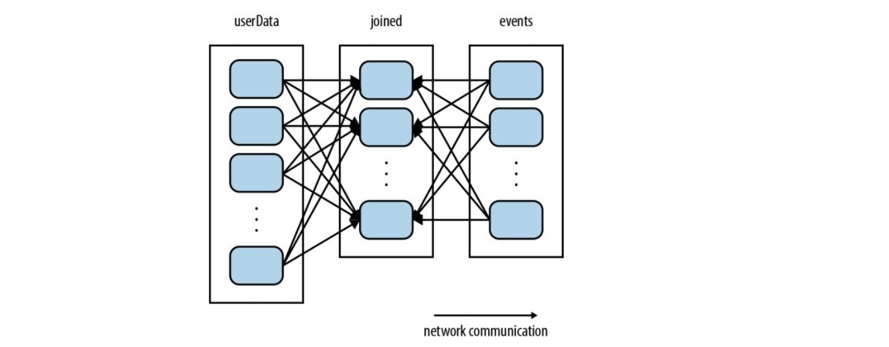

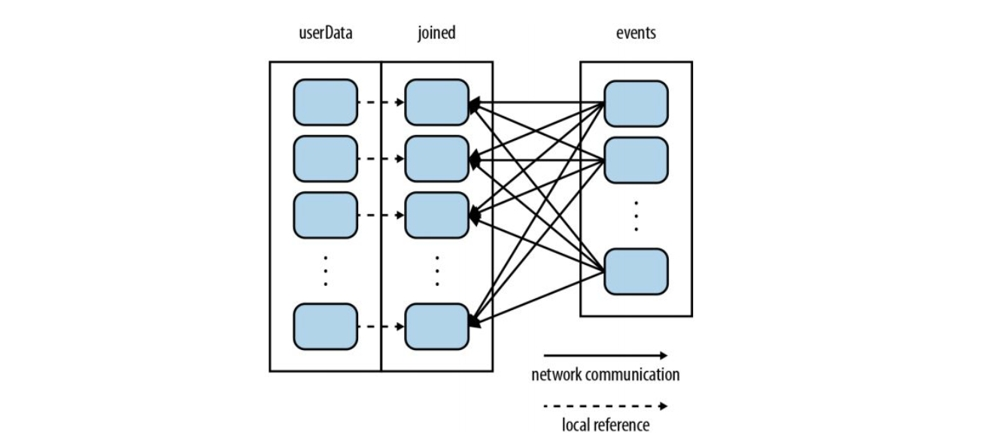

第дәҢеҚҒдә”з« пјҡHadoopпјҢ Reducerж•°зӣ® пјҢYarn

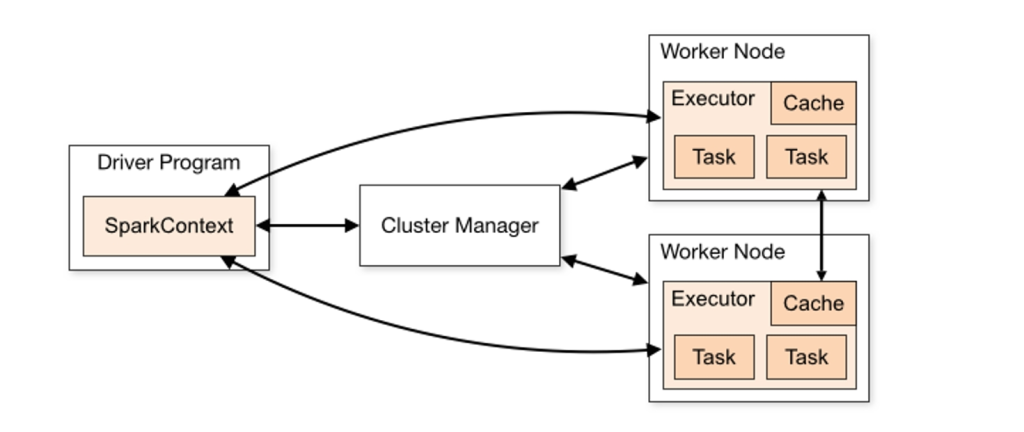

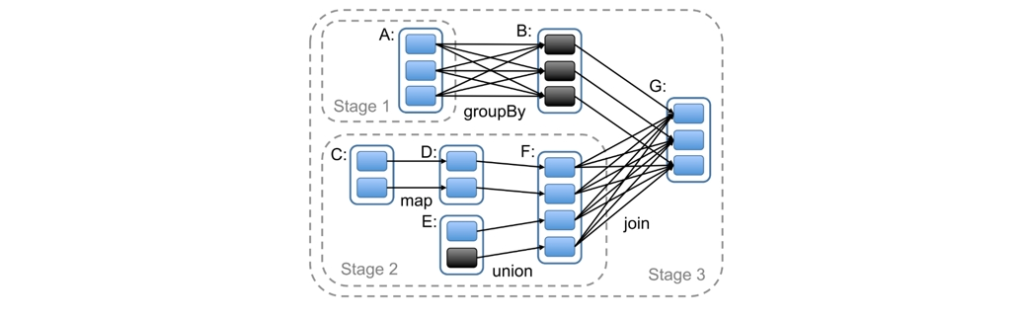

第дәҢеҚҒе…ӯз« пјҡSpark

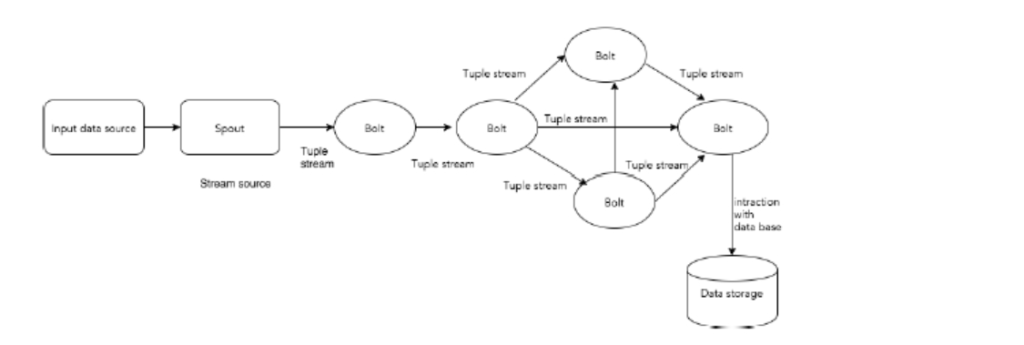

第дәҢеҚҒдёғз« пјҡStromпјҢHadoop е’Ң StormеҜ№жҜ”

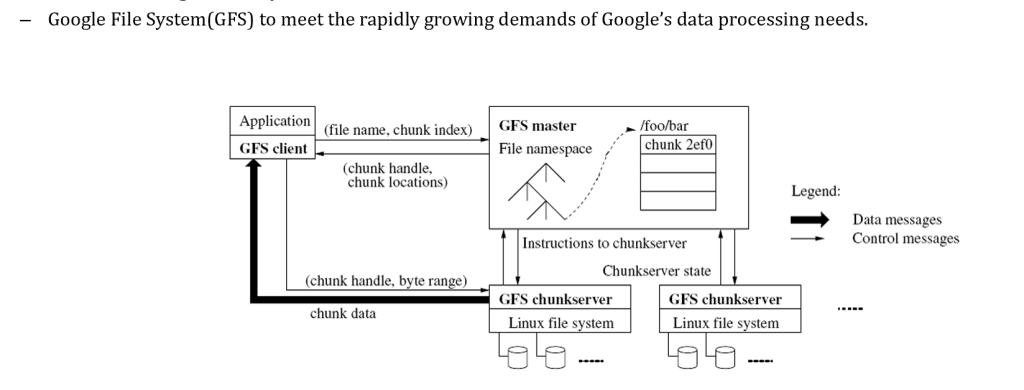

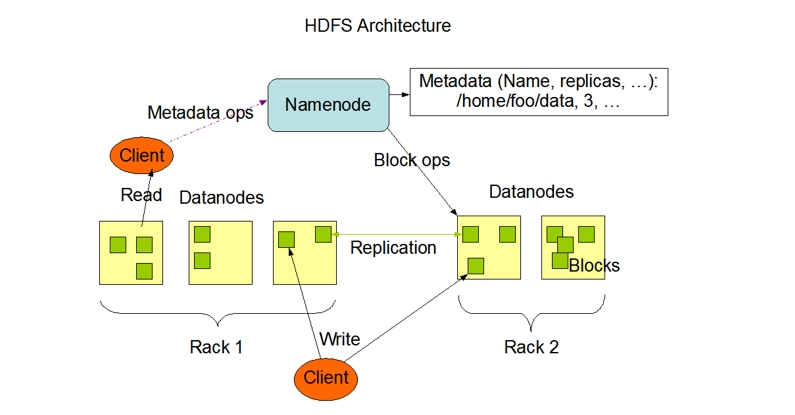

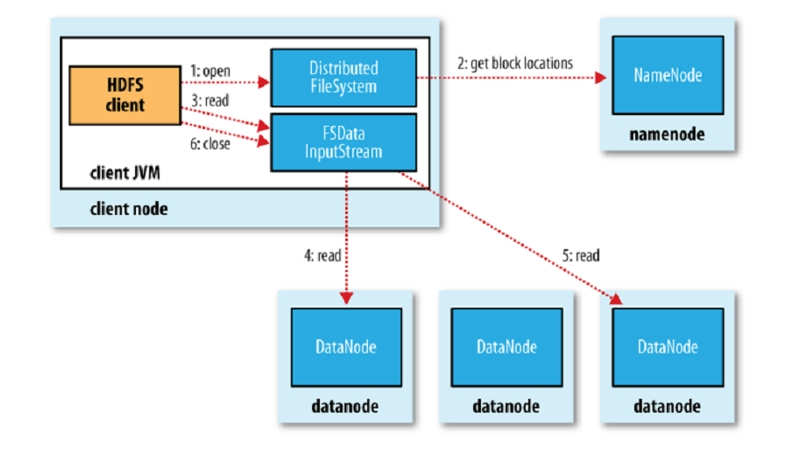

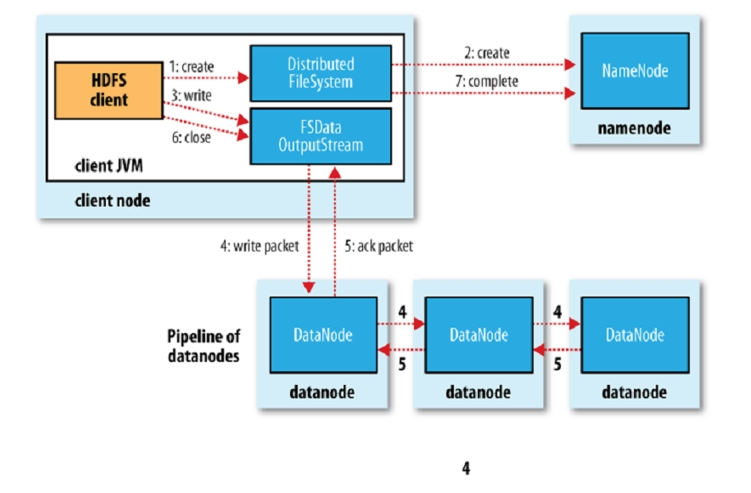

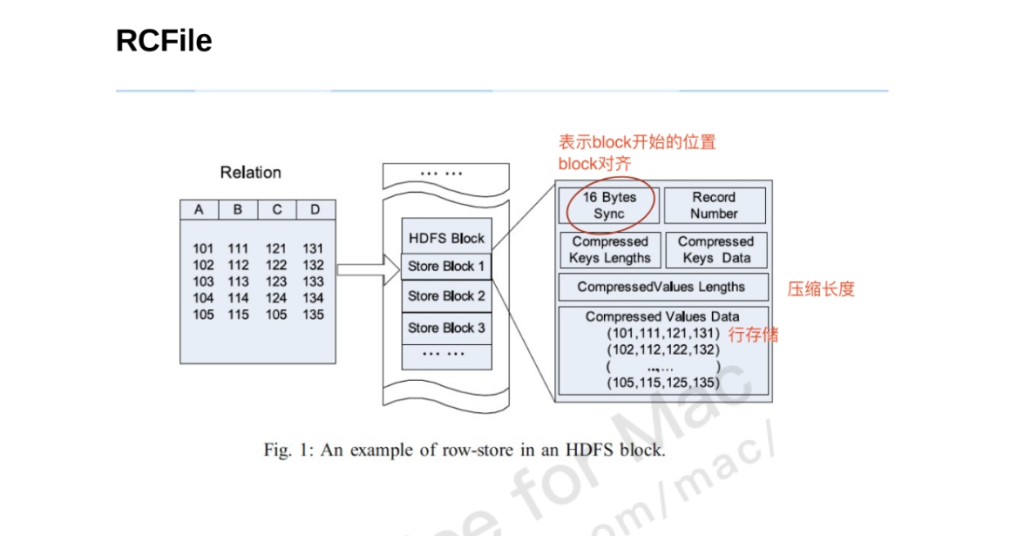

第дәҢеҚҒе…«з« пјҡHdfs

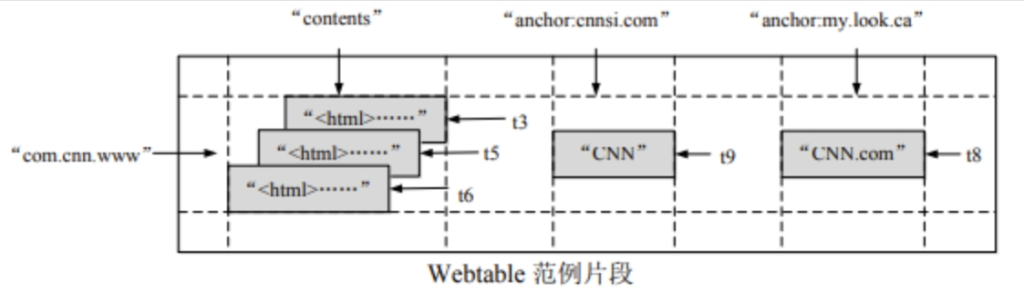

第дәҢеҚҒд№қз« пјҡHbaseпјҢWeb Table

第дёүеҚҒз« пјҡHIVEпјҢETLпјҢHIVEе’Ңдј з»ҹж•°жҚ®еә“зҡ„еҜ№жҜ”

第дёүеҚҒдёҖз« пјҡFLINK

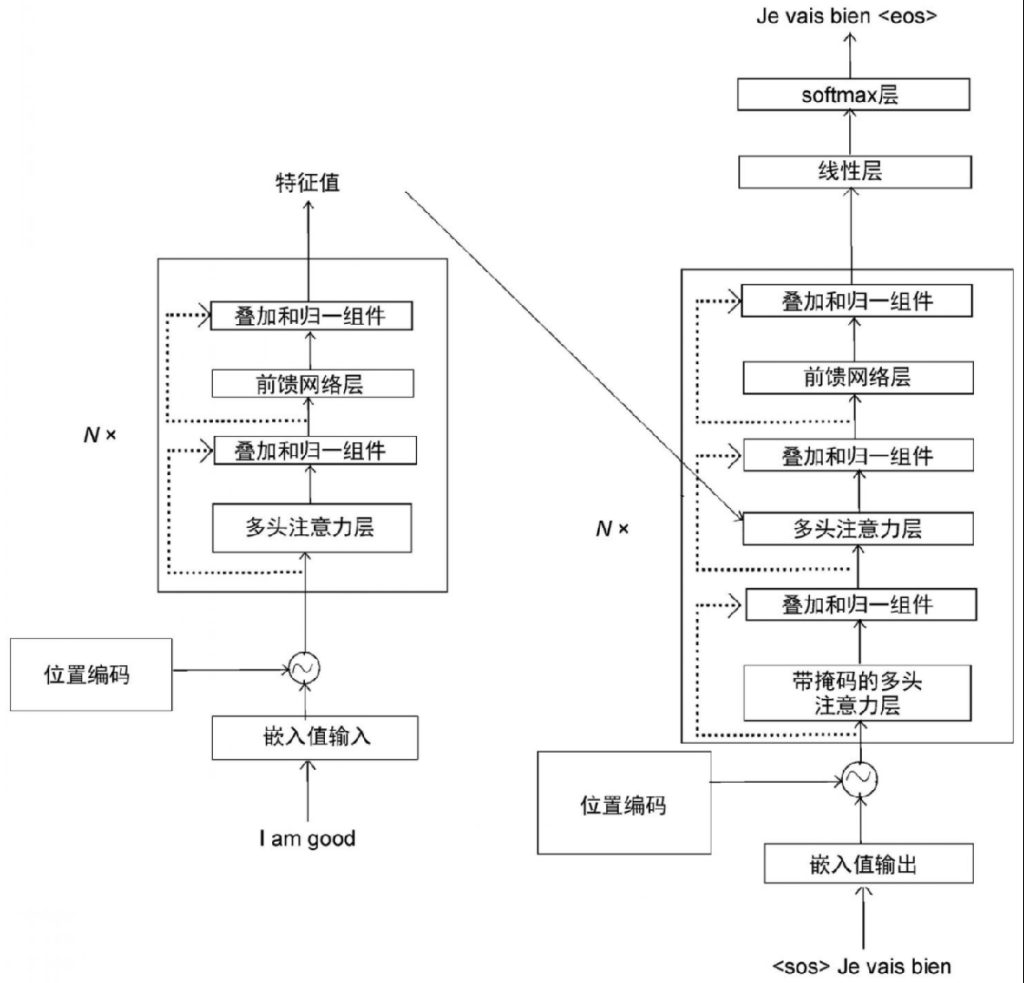

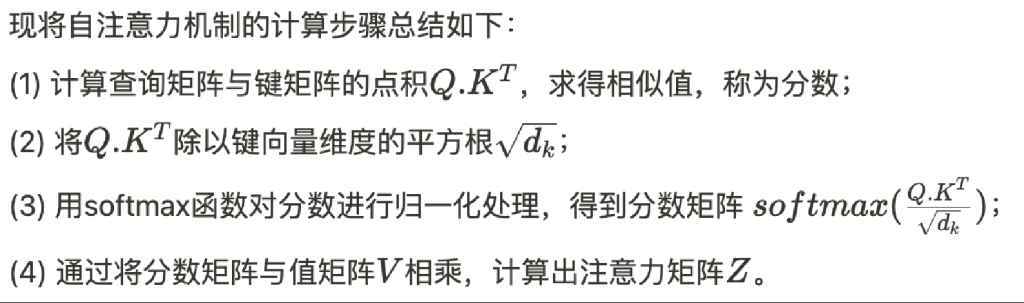

第дёүеҚҒдәҢз« пјҡAI

第дёҖз«

Stateful and Stateless

| еҜ№жҜ”з»ҙеәҰ | Stateful | Stateless |

|---|---|---|

| е®ҡд№ү | жңҚеҠЎеҷЁз»ҙжҠӨе®ўжҲ·з«ҜзҠ¶жҖҒ | жңҚеҠЎеҷЁдёҚз»ҙжҠӨе®ўжҲ·з«ҜзҠ¶жҖҒ |

| зҠ¶жҖҒеӯҳеӮЁ | жңҚеҠЎеҷЁдҝқеӯҳзҠ¶жҖҒпјҲдјҡиҜқгҖҒдёҠдёӢж–Үпјү | жңҚеҠЎеҷЁдёҚдҝқеӯҳзҠ¶жҖҒпјҢе®ўжҲ·з«ҜжҜҸж¬ЎеҸ‘йҖҒе®Ңж•ҙиҜ·жұӮдҝЎжҒҜ |

| иҜ·жұӮзӢ¬з«ӢжҖ§ | иҜ·жұӮд№Ӣй—ҙдҫқиө–еҺҶеҸІзҠ¶жҖҒ | жҜҸдёӘиҜ·жұӮзӢ¬з«ӢпјҢж— йңҖеҺҶеҸІдҝЎжҒҜ |

| иө„жәҗеҚ з”Ё | й«ҳпјҢеҚ з”ЁжңҚеҠЎеҷЁеҶ…еӯҳжҲ–еӯҳеӮЁиө„жәҗ | дҪҺпјҢжңҚеҠЎеҷЁж— зҠ¶жҖҒеӯҳеӮЁ |

| жү©еұ•жҖ§ | йҡҫд»Ҙжү©еұ•пјҢйңҖиҰҒеҗҢжӯҘзҠ¶жҖҒ | жҳ“дәҺжү©еұ•пјҢж— йңҖзҠ¶жҖҒеҗҢжӯҘ |

| е®№й”ҷжҖ§ | е®№й”ҷжҖ§дҪҺпјҢжңҚеҠЎеҷЁж•…йҡңдјҡеҜјиҮҙзҠ¶жҖҒдёўеӨұ | е®№й”ҷжҖ§й«ҳпјҢжңҚеҠЎеҷЁж— зҠ¶жҖҒеҪұе“Қ |

| еӨҚжқӮжҖ§ | жңҚеҠЎеҷЁи®ҫи®ЎеӨҚжқӮпјҢйңҖз»ҙжҠӨдјҡиҜқдҝЎжҒҜ | е®ўжҲ·з«Ҝи®ҫи®ЎеӨҚжқӮпјҢйңҖжҸҗдҫӣе®Ңж•ҙиҜ·жұӮдҝЎжҒҜ |

| зӨәдҫӢеҚҸи®®/жҠҖжңҜ | FTPгҖҒTelnetгҖҒWebSocket | HTTPгҖҒRESTful APIгҖҒDNS жҹҘиҜў |

| йҖӮз”ЁеңәжҷҜ | е®һж—¶дә’еҠЁгҖҒй•ҝж—¶й—ҙдјҡиҜқпјҲ银иЎҢгҖҒжёёжҲҸпјү | й«ҳ并еҸ‘гҖҒж— зҠ¶жҖҒдәӢеҠЎпјҲжҗңзҙўеј•ж“ҺгҖҒеҫ®жңҚеҠЎпјү |

| дјҳзӮ№ | дҫҝдәҺеӨ„зҗҶеӨҚжқӮдәӨдә’пјҢж”ҜжҢҒе®һж—¶зҠ¶жҖҒз®ЎзҗҶ | з®ҖеҢ–жңҚеҠЎеҷЁи®ҫи®ЎпјҢжҳ“жү©еұ• |

| зјәзӮ№ | й«ҳиө„жәҗеҚ з”ЁпјҢйҡҫд»Ҙжү©еұ• | зҪ‘з»ңејҖй”ҖеӨ§пјҢдёҚж”ҜжҢҒеӨҚжқӮдјҡиҜқ |

Cookie and Session

HttpеҚҸи®®жҳҜдёҖз§Қж— зҠ¶жҖҒзҡ„еҚҸи®®пјҢдҪҶжҳҜжңүж—¶йңҖиҰҒи®°еҪ•зҠ¶жҖҒпјҢиҫҫжҲҗStatefulгҖӮдёәжӯӨпјҢжңүдәҶCookieе’ҢSessionгҖӮ

- Cookieпјҡе®ўжҲ·з«ҜжөҸи§ҲеҷЁз”ЁжқҘдҝқеӯҳз”ЁжҲ·дҝЎжҒҜзҡ„дёҖз§ҚжңәеҲ¶пјӣеҪ“жҲ‘们йҖҡиҝҮжөҸи§ҲеҷЁиҝӣиЎҢзҪ‘йЎөи®ҝй—®зҡ„ж—¶еҖҷпјҢжңҚеҠЎеҷЁдјҡе°ҶдёҖдәӣж•°жҚ®д»ҘCookieзҡ„еҪўејҸдҝқеӯҳеңЁе®ўжҲ·з«ҜжөҸи§ҲеҷЁдёҠпјҢеҪ“дёӢж¬Ўе®ўжҲ·з«ҜжөҸи§ҲеҷЁеҶҚж¬Ўи®ҝй—®иҜҘзҪ‘з«ҷж—¶пјҢдјҡе°ҶCookieж•°жҚ®еҸ‘йҖҒз»ҷжңҚеҠЎеҷЁпјҢжңҚеҠЎеҷЁйҖҡиҝҮCookieж•°жҚ®жқҘиҫЁеҲ«з”ЁжҲ·иә«д»ҪгҖӮпјҲCookieеӯҳзҡ„жҳҜkey-valueй”®еҖјеҜ№пјү

- SessionпјҡиЎЁзӨәдёҖдёӘдјҡиҜқпјҢжҳҜеұһдәҺжңҚеҠЎеҷЁз«Ҝзҡ„дёҖз§Қе®№еҷЁеҜ№иұЎпјӣй»ҳи®Өжғ…еҶөдёӢпјҢй’ҲеҜ№жҜҸдёӘжөҸи§ҲеҷЁзҡ„иҜ·жұӮпјҢserverйғҪдјҡеҲӣе»әдёҖдёӘsessionеҜ№иұЎпјҢз”ҹжҲҗдёҖдёӘsessionIdпјҢз”ЁдәҺж ҮиҜҶиҜҘsessionеҜ№иұЎпјҢеҗҢж—¶е°Ҷ sessionIdд»Ҙcookieзҡ„еҪўејҸеҸ‘йҖҒз»ҷе®ўжҲ·з«ҜжөҸи§ҲеҷЁпјҢе®ўжҲ·з«ҜжөҸи§ҲеҷЁеҶҚж¬Ўи®ҝй—®иҜҘзҪ‘з«ҷж—¶пјҢдјҡе°Ҷcookieж•°жҚ®еҸ‘йҖҒз»ҷжңҚеҠЎеҷЁпјҢжңҚеҠЎеҷЁйҖҡиҝҮcookieж•°жҚ®жқҘиҫЁеҲ«з”ЁжҲ·иә«д»ҪпјҢд»ҺиҖҢжүҫеҲ°еҜ№еә”зҡ„sessionеҜ№иұЎпјҢеҰӮжһңжүҫдёҚеҲ°пјҢе°ұдјҡеҲӣе»әдёҖдёӘж–°зҡ„sessionеҜ№иұЎгҖӮз®ҖеҚ•жқҘиҜҙпјҢSessionзҡ„дҪңз”Ёе°ұжҳҜеё®еҠ©жҲ‘们е®һзҺ°дёҖдёӘжңүзҠ¶жҖҒзҡ„ HttpеҚҸи®®гҖӮ

е®һдҫӢжұ пјҲеҜ№иұЎжұ пјү

“еҜ№иұЎжұ ”пјҲObject PoolпјүжҳҜдёҖз§Қи®ҫи®ЎжЁЎејҸпјҢе®ғжҳҜдёҖз§Қз”ЁдәҺз®ЎзҗҶе’ҢйҮҚз”ЁеҜ№иұЎе®һдҫӢзҡ„жңәеҲ¶пјҢд»ҘжҸҗй«ҳжҖ§иғҪе’Ңиө„жәҗеҲ©з”ЁзҺҮзҡ„ж–№ејҸгҖӮеҜ№иұЎжұ йҖҡеёёз”ЁдәҺеҮҸе°‘еҲӣе»әе’Ңй”ҖжҜҒеҜ№иұЎзҡ„ејҖй”ҖпјҢзү№еҲ«жҳҜеңЁеҜ№иұЎзҡ„еҲӣе»әжҲҗжң¬иҫғй«ҳжҲ–йў‘з№ҒеҲӣе»әе’Ңй”ҖжҜҒеҜ№иұЎеҸҜиғҪеҜјиҮҙжҖ§иғҪдёӢйҷҚзҡ„жғ…еҶөдёӢгҖӮ

еңЁJavaдёӯпјҢеҜ№иұЎжұ йҖҡеёёжҳҜдёҖдёӘйӣҶеҗҲпјҢз”ЁдәҺеӯҳеӮЁе’Ңз®ЎзҗҶеӨҡдёӘеҜ№иұЎе®һдҫӢгҖӮеҪ“йңҖиҰҒдҪҝз”ЁеҜ№иұЎж—¶пјҢеҸҜд»Ҙд»ҺеҜ№иұЎжұ дёӯиҺ·еҸ–дёҖдёӘеҸҜз”Ёзҡ„еҜ№иұЎпјҢиҖҢдёҚжҳҜжҜҸж¬ЎйғҪеҲӣе»әж–°зҡ„еҜ№иұЎгҖӮдёҖж—ҰдҪҝз”Ёе®ҢжҲҗпјҢеҸҜд»Ҙе°ҶеҜ№иұЎиҝ”еӣһеҲ°еҜ№иұЎжұ дёӯпјҢд»ҘдҫҝзЁҚеҗҺйҮҚз”ЁпјҢиҖҢдёҚжҳҜз«ӢеҚій”ҖжҜҒе®ғгҖӮдҪҶжҳҜе®һдҫӢжұ ж•°йҮҸжҳҜжңүдёҠйҷҗзҡ„пјҢдёҚеҸҜиғҪж— йҷҗеҲ¶еҸҳеӨ§пјҲDDosж”»еҮ»еҶ…еӯҳзӣҙжҺҘзҲҶдәҶпјүгҖӮ

еӣ жӯӨпјҢдёәдәҶжңҚеҠЎеӨҡдёӘеҜ№иұЎпјҢеңЁе®һдҫӢжұ ж»ЎдәҶеҗҺпјҢеҸҜд»ҘжҠҠжңҖдёҚеёёз”Ёзҡ„еҜ№иұЎж”ҫеҲ°зЎ¬зӣҳдёҠгҖӮеҰӮжһңжңүйңҖиҰҒеҶҚжҚўеҮәгҖӮ

иҝҷжҳҜеӣ дёәStatefulеј•е…Ҙзҡ„й—®йўҳпјҢеӣ жӯӨзі»з»ҹиҰҒе°ҪйҮҸStatelessпјҢжҲ–иҖ…е°ҪеҸҜиғҪжҺ§еҲ¶е®һдҫӢпјҢд№ҹе°ұжңүдәҶScopeгҖӮ

Scopes

“scope”пјҲдҪңз”Ёеҹҹпјүз”ЁдәҺе®ҡд№үSpringе®№еҷЁеҰӮдҪ•з®ЎзҗҶbeanе®һдҫӢзҡ„з”ҹе‘Ҫе‘Ёжңҹе’ҢеҸҜи§ҒжҖ§гҖӮе…¶дёӯsingletonе’ҢprototypeеҸҜд»ҘеңЁжҜҸдёҖдёӘBeanеҜ№иұЎеүҚйғҪе®ҡд№үпјҢиҖҢе…¶дҪҷзҡ„дҪңз”ЁдәҺж•ҙдёӘWebгҖӮ

| Scope | Description | и§ЈйҮҠ |

|---|---|---|

| singleton | пјҲй»ҳи®Өпјүе°ҶеҚ•дёӘ Bean е®ҡд№үзҡ„дҪңз”ЁеҹҹйҷҗеҲ¶дёәжҜҸдёӘ Spring IoC е®№еҷЁзҡ„еҚ•дёӘеҜ№иұЎе®һдҫӢгҖӮ | ж•ҙдёӘ Spring е®№еҷЁдёӯеҸӘеҲӣе»әдёҖдёӘе®һдҫӢпјҢе…ЁеұҖе…ұдә« |

| prototype | е°ҶеҚ•дёӘ Bean е®ҡд№үзҡ„дҪңз”ЁеҹҹйҷҗеҲ¶дёәд»»ж„Ҹж•°йҮҸзҡ„еҜ№иұЎе®һдҫӢгҖӮ | жҜҸж¬ЎиҺ·еҸ– Bean ж—¶йғҪдјҡеҲӣе»әдёҖдёӘж–°е®һдҫӢпјҢжҜ”еҰӮcontrollerи°ғз”Ёserviceд№ҹдјҡеҲӣе»әж–°зҡ„гҖӮ |

| request | е°ҶеҚ•дёӘ Bean е®ҡд№үзҡ„дҪңз”ЁеҹҹйҷҗеҲ¶дёәеҚ•дёӘ HTTP иҜ·жұӮзҡ„з”ҹе‘Ҫе‘ЁжңҹгҖӮд»…еңЁж”ҜжҢҒ Web зҡ„ Spring ApplicationContext дёӯжңүж•ҲгҖӮ | жҜҸж¬ЎHTTPиҜ·жұӮйғҪдёҖдёӘж–°е®һдҫӢпјҢйҖӮеҗҲдёҺиҜ·жұӮзӣёе…ізҡ„ж•°жҚ®еӨ„зҗҶпјҢжҜ”еҰӮиҜ·жұӮеҸӮж•°ж ЎйӘҢзӯүгҖӮ |

| session | е°ҶеҚ•дёӘ Bean е®ҡд№үзҡ„дҪңз”ЁеҹҹйҷҗеҲ¶дёә HTTP дјҡиҜқзҡ„з”ҹе‘Ҫе‘ЁжңҹгҖӮд»…еңЁж”ҜжҢҒ Web зҡ„ Spring ApplicationContext дёӯжңүж•ҲгҖӮ | жҜҸдёӘ HTTP дјҡиҜқе‘ЁжңҹеҶ…йғҪдјҡжңүзӢ¬з«Ӣзҡ„ Bean е®һдҫӢпјҢйҖӮеҗҲз”ЁжҲ·зҷ»еҪ•зҠ¶жҖҒпјҢеңЁдёҖдёӘsessionеҶ…еӨҡдёӘhttpеҸӘжңүдёҖдёӘе®һдҫӢгҖӮ |

| application | е°ҶеҚ•дёӘ Bean е®ҡд№үзҡ„дҪңз”ЁеҹҹйҷҗеҲ¶дёә ServletContext зҡ„з”ҹе‘Ҫе‘ЁжңҹгҖӮд»…еңЁж”ҜжҢҒ Web зҡ„ Spring ApplicationContext дёӯжңүж•ҲгҖӮ | Bean зҡ„з”ҹе‘Ҫе‘ЁжңҹдёҺж•ҙдёӘ Web еә”з”Ёзҡ„з”ҹе‘Ҫе‘ЁжңҹдёҖиҮҙпјҢйҖӮеҗҲеӯҳеӮЁе…ЁеұҖй…ҚзҪ®гҖҒе…ұдә«иө„жәҗзӯүгҖӮе’ҢsingletonеҢәеҲ«жҳҜз”ЁеңЁwebгҖӮ |

| websocket | е°ҶеҚ•дёӘ Bean е®ҡд№үзҡ„дҪңз”ЁеҹҹйҷҗеҲ¶дёә WebSocket дјҡиҜқзҡ„з”ҹе‘Ҫе‘ЁжңҹгҖӮд»…еңЁж”ҜжҢҒ Web зҡ„ Spring ApplicationContext дёӯжңүж•ҲгҖӮ | жҜҸдёӘ WebSocket дјҡиҜқеҲӣе»әдёҖдёӘ Bean е®һдҫӢпјҢйҖӮеҗҲе®һж—¶йҖҡдҝЎеңәжҷҜдёӢдёҺеҚ•дёӘз”ЁжҲ·иҝһжҺҘзӣёе…ізҡ„ж•°жҚ®жҲ–зҠ¶жҖҒгҖӮ |

з”ЁдёӨдёӘжөҸи§ҲеҷЁпјҲжЁЎжӢҹ2дёӘйҡ”зҰ»зҡ„sessionпјүпјҢеҗ„иҮӘеҸ‘йҖҒ1дёӘrequest

| Controller | |||

| Prototype | session | ||

| Service | prototype | 4 service instances 4 controller instances | 4 service instances 2 controller instances |

| session | 2 service instances 4 controller instances | 2 service instances 2 controller instances | |

ж•°жҚ®еә“иҝһжҺҘжұ

иҝһжҺҘжұ пјҲConnection Poolпјүзҡ„жң¬иҙЁжҳҜзәҝзЁӢжұ пјҢжҳҜдёҖз§Қз”ЁдәҺз®ЎзҗҶе’ҢйҮҚз”Ёж•°жҚ®еә“иҝһжҺҘгҖҒзҪ‘з»ңиҝһжҺҘжҲ–е…¶д»–иө„жәҗиҝһжҺҘзҡ„жҠҖжңҜпјҢж—ЁеңЁжҸҗй«ҳеә”з”ЁзЁӢеәҸжҖ§иғҪе’Ңиө„жәҗеҲ©з”ЁзҺҮгҖӮиҝһжҺҘжұ йҖҡиҝҮз»ҙжҠӨдёҖз»„е·ІеҲӣе»әзҡ„иҝһжҺҘе®һдҫӢпјҢ并еңЁйңҖиҰҒж—¶еҲҶ й…ҚиҝҷдәӣиҝһжҺҘпјҢд»ҘеҮҸе°‘еҲӣе»әе’Ңй”ҖжҜҒиҝһжҺҘзҡ„ејҖй”ҖгҖӮ

иҝһжҺҘжұ ж•°йҮҸпјҲз»ҸйӘҢе…¬ејҸпјү

connections = ((core_count * 2) + effective_spindle_count)

- core_count: CPU ж ёеҝғж•°гҖӮ

- effective_spindle_count: жңүж•ҲзЈҒзӣҳж•°

еҪ“зәҝзЁӢж•°иҝҮеӨ§пјҢзәҝзЁӢдёҠдёӢж–ҮеҲҮжҚўдјҡйҷҚдҪҺж•ҲзҺҮгҖӮиҖҢйҖүжӢ©2еҖҚCPUж ёеҝғж•°жҳҜеӣ дёәиҝҷж ·дёҠдёӢж–ҮеҲҮжҚўжҜ”иҫғе°‘пјҲжңҖеҗҲзҗҶпјүпјҢиҖҢеҠ дёҠжңүж•ҲзЈҒзӣҳж•°жҳҜеӣ дёәеҫҖзЈҒзӣҳеҶҷж—¶и®ӨдёәCPUеҹәжң¬з©әй—ІпјҢдё»иҰҒеҚ з”ЁйҖҡйҒ“гҖӮ

иҝҷиҜҙжҳҺж•°жҚ®еә“иҝһжҺҘж•°е’Ңи®ҝй—®зҡ„ж•°йҮҸжІЎе…ізі»пјҢеҸӘе’ҢиҮӘе·ұ硬件еӣ зҙ жңүе…іпјҢзҗҶжғізҡ„иҝһжҺҘжұ жҳҜ вҖңе°Ҹжұ еӯҗпјҢеӨ§еҺӢеҠӣвҖқпјҡдҪ еёҢжңӣзәҝзЁӢзӯүеҫ…иҺ·еҸ–иҝһжҺҘпјҢиҖҢдёҚжҳҜиҝһжҺҘиҝҮеӨҡеҜјиҮҙз®ЎзҗҶжҲҗжң¬й«ҳгҖӮеӨ„зҗҶдёҚиҝҮжқҘж•°жҚ®еә”иҜҘжҚўеҘҪжңәеҷЁгҖӮ

第дәҢз«

Messaging – JMS

MessagingпјҡжҳҜдёҖз§ҚеңЁиҪҜ件组件жҲ–еә”з”ЁзЁӢеәҸд№Ӣй—ҙиҝӣиЎҢйҖҡдҝЎзҡ„ж–№жі•

жҳҜдёҖз§Қpeer-to-peerзҡ„ж–№ејҸпјҢеӨ§е®¶йғҪдёҖж ·еҸҜд»ҘжҺҘ收д№ҹеҸҜд»ҘеҸ‘йҖҒж¶ҲжҒҜпјҢжҜҸдёӘе®ўжҲ·з«ҜйғҪиҝһжҺҘеҲ°дёҖдёӘж¶ҲжҒҜд»ЈзҗҶпјҢиҜҘд»ЈзҗҶжҸҗдҫӣеҲӣе»әгҖҒеҸ‘йҖҒгҖҒжҺҘ收е’ҢиҜ»еҸ–ж¶ҲжҒҜзҡ„еҠҹиғҪпјҢиҝҷж ·е°ұеҸҜд»Ҙи§ЈеҶіжқҫж•ЈиҖҰеҗҲзҡ„й—®йўҳпјҢдҪҝеҫ—еҲҶеёғејҸжҲҗдёәеҸҜиғҪпјҲеҸҜд»ҘиҪ¬еҸ‘з»ҷе…¶е®ғжңҚеҠЎеҷЁж¶ҲжҒҜдәҶпјҢиҖҢдёҚжҳҜеҸӘеҸҜд»ҘеҺ»еӨ„зҗҶж¶ҲжҒҜ

JMSпјҲJava Mesage ServiceпјүпјҡжҳҜдёҖз§Қ Java APIпјҢе…Ғи®ёеә”з”ЁзЁӢеәҸеҲӣе»әгҖҒеҸ‘йҖҒгҖҒжҺҘ收е’ҢиҜ»еҸ–ж¶ҲжҒҜпјҢејҖжәҗзҡ„е®һзҺ°жңүkafkaпјҢJMSиҝҳе…·еӨҮд»ҘдёӢзү№зӮ№пјҡ

- ејӮжӯҘпјҲAsynchronousпјүпјҡ

- жҺҘ收客жҲ·з«ҜдёҚйңҖиҰҒеңЁеҸ‘йҖҒе®ўжҲ·з«ҜеҸ‘йҖҒж¶ҲжҒҜж—¶з«ӢеҚіжҺҘ收ж¶ҲжҒҜгҖӮеҸ‘йҖҒз«ҜеҸҜд»ҘеҸ‘йҖҒж¶ҲжҒҜ并继з»ӯжү§иЎҢе…¶д»–д»»еҠЎпјӣжҺҘ收з«ҜеҸҜд»ҘзЁҚеҗҺжҺҘ收иҝҷдәӣж¶ҲжҒҜгҖӮ

- еҸҜйқ пјҲReliableпјүпјҡ

- е®һзҺ° JMS API зҡ„ж¶ҲжҒҜжҸҗдҫӣиҖ…еҸҜд»ҘзЎ®дҝқж¶ҲжҒҜд»…иў«дј йҖ’дёҖж¬Ўдё”д»…дёҖж¬ЎгҖӮеҜ№дәҺдёҚйңҖиҰҒй«ҳеҸҜйқ жҖ§зҡ„еә”з”ЁпјҢд№ҹеҸҜд»ҘйҖүжӢ©иҫғдҪҺзҡ„еҸҜйқ жҖ§ж°ҙе№іпјҢжҜ”еҰӮе…Ғи®ёдёўеӨұж¶ҲжҒҜжҲ–жҺҘ收йҮҚеӨҚзҡ„ж¶ҲжҒҜгҖӮ

JMSж¶ҲжҒҜдј иҫ“жЁЎеһӢ

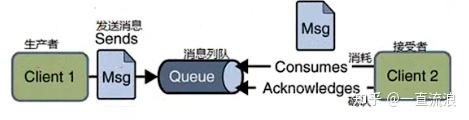

- зӮ№еҜ№зӮ№пјҲPoint-to-PointпјҢP2PпјүжЁЎеһӢпјҡ

- еңЁиҝҷдёӘжЁЎеһӢдёӯпјҢж¶ҲжҒҜз”ҹдә§иҖ…еҸ‘йҖҒж¶ҲжҒҜеҲ°йҳҹеҲ—пјҲQueueпјүпјҢж¶ҲжҒҜж¶Ҳиҙ№иҖ…д»ҺйҳҹеҲ—дёӯжҺҘ收ж¶ҲжҒҜгҖӮ

- жҜҸдёӘж¶ҲжҒҜеҸӘиғҪиў«дёҖдёӘж¶Ҳиҙ№иҖ…жҺҘ收пјҢдёҖж—Ұж¶ҲжҒҜиў«ж¶Ҳиҙ№пјҢе®ғе°ұдјҡд»ҺйҳҹеҲ—дёӯ移йҷӨпјҢзЎ®дҝқж¶ҲжҒҜдёҚдјҡйҮҚеӨҚеӨ„зҗҶгҖӮ

- иҝҷз§ҚжЁЎеһӢйҖӮз”ЁдәҺйңҖиҰҒзЎ®дҝқж¶ҲжҒҜеҸӘиў«еӨ„зҗҶдёҖж¬Ўзҡ„еңәжҷҜпјҢдҫӢеҰӮи®ўеҚ•еӨ„зҗҶгҖҒз”ЁжҲ·иҜ·жұӮеӨ„зҗҶзӯүгҖӮ

- еҸ‘еёғ/и®ўйҳ…пјҲPublish/SubscribeпјҢPub/SubпјүжЁЎеһӢпјҡ

- еңЁеҸ‘еёғ/и®ўйҳ…жЁЎеһӢдёӯпјҢж¶ҲжҒҜз”ҹдә§иҖ…пјҲеҸ‘еёғиҖ…пјүе°Ҷж¶ҲжҒҜеҸ‘йҖҒеҲ°дё»йўҳпјҲTopicпјүпјҢиҖҢж¶ҲжҒҜж¶Ҳиҙ№иҖ…пјҲи®ўйҳ…иҖ…пјүи®ўйҳ…ж„ҹе…ҙи¶Јзҡ„дё»йўҳгҖӮ

- дёҖдёӘеҸ‘еёғиҖ…еҸ‘йҖҒзҡ„ж¶ҲжҒҜеҸҜд»Ҙиў«еӨҡдёӘи®ўйҳ…иҖ…жҺҘ收пјҢиҝҷдҪҝеҫ—еҸ‘еёғ/и®ўйҳ…жЁЎеһӢйқһеёёйҖӮеҗҲйңҖиҰҒдёҖеҜ№еӨҡйҖҡдҝЎзҡ„еңәжҷҜгҖӮ

- и®ўйҳ…иҖ…еҸҜд»Ҙи®ҫзҪ®иҝҮж»ӨжқЎд»¶пјҢеҸӘжҺҘ收满足зү№е®ҡжқЎд»¶зҡ„ж¶ҲжҒҜпјҢиҝҷеўһеҠ дәҶж¶ҲжҒҜдј иҫ“зҡ„зҒөжҙ»жҖ§гҖӮ

дёӨз§ҚжЁЎеһӢзҡ„зү№зӮ№еҜ№жҜ”пјҡ

- дёҖеҜ№дёҖ vs дёҖеҜ№еӨҡпјҡ

- P2PжЁЎеһӢжҳҜдёҖеҜ№дёҖзҡ„ж¶ҲжҒҜдј иҫ“пјҢжҜҸжқЎж¶ҲжҒҜеҸӘжңүдёҖдёӘж¶Ҳиҙ№иҖ…гҖӮ

- Pub/SubжЁЎеһӢжҳҜдёҖеҜ№еӨҡзҡ„ж¶ҲжҒҜдј иҫ“пјҢдёҖжқЎж¶ҲжҒҜеҸҜд»Ҙиў«еӨҡдёӘи®ўйҳ…иҖ…жҺҘ收гҖӮ

- йҳҹеҲ— vs дё»йўҳпјҡ

- еңЁP2PжЁЎеһӢдёӯпјҢдҪҝз”ЁйҳҹеҲ—дҪңдёәж¶ҲжҒҜзҡ„е®№еҷЁпјҢйҳҹеҲ—дҝқиҜҒдәҶж¶ҲжҒҜзҡ„йЎәеәҸжҖ§е’ҢзӢ¬з«ӢжҖ§гҖӮ

- еңЁPub/SubжЁЎеһӢдёӯпјҢдҪҝз”Ёдё»йўҳдҪңдёәж¶ҲжҒҜзҡ„еҸ‘еёғзӮ№пјҢдё»йўҳе…Ғи®ёеӨҡдёӘи®ўйҳ…иҖ…жҺҘ收ж¶ҲжҒҜгҖӮ

- ж¶ҲжҒҜзЎ®и®Өпјҡ

- еңЁP2PжЁЎеһӢдёӯпјҢж¶Ҳиҙ№иҖ…йҖҡеёёйңҖиҰҒжҳҫејҸзЎ®и®Өж¶ҲжҒҜпјҢе‘ҠзҹҘж¶ҲжҒҜжңҚеҠЎеҷЁж¶ҲжҒҜе·Іиў«жҲҗеҠҹеӨ„зҗҶгҖӮ

- еңЁPub/SubжЁЎеһӢдёӯпјҢи®ўйҳ…иҖ…еҸҜиғҪйңҖиҰҒзЎ®и®Өж¶ҲжҒҜпјҢд№ҹеҸҜиғҪдёҚйңҖиҰҒпјҢиҝҷеҸ–еҶідәҺе…·дҪ“зҡ„е®һзҺ°е’Ңй…ҚзҪ®гҖӮ

- ж¶ҲжҒҜжҢҒд№…жҖ§пјҡ

- еңЁдёӨз§ҚжЁЎеһӢдёӯпјҢйғҪеҸҜд»Ҙй…ҚзҪ®ж¶ҲжҒҜзҡ„жҢҒд№…жҖ§пјҢзЎ®дҝқж¶ҲжҒҜдёҚдјҡеӣ дёәзі»з»ҹж•…йҡңиҖҢдёўеӨұгҖӮ

JMSзҡ„иҝҷдёӨз§Қж¶ҲжҒҜдј иҫ“жЁЎеһӢдёәдёҚеҗҢзҡ„еә”з”ЁеңәжҷҜжҸҗдҫӣдәҶзҒөжҙ»зҡ„ж¶ҲжҒҜдј йҖ’жңәеҲ¶пјҢе…Ғи®ёејҖеҸ‘иҖ…ж №жҚ®дёҡеҠЎйңҖжұӮйҖүжӢ©еҗҲйҖӮзҡ„жЁЎеһӢжқҘе®һзҺ°ж¶ҲжҒҜйҖҡдҝЎгҖӮ

JMSж¶ҲжҒҜж јејҸпјҲдёҚиҜҰз»Ҷеұ•ејҖдәҶпјҢж„ҹи§үдёҚйҮҚиҰҒпјү

- ж¶ҲжҒҜеӨҙ (Header)

- еҝ…йңҖйғЁеҲҶпјҢеҢ…еҗ«дёҺж¶ҲжҒҜзӣёе…ізҡ„еҹәжң¬дҝЎжҒҜпјҢжҜ”еҰӮж¶ҲжҒҜзҡ„зӣ®зҡ„ең°гҖҒж ҮиҜҶз¬ҰгҖҒж—¶й—ҙжҲізӯүгҖӮ

- дҪңз”Ёпјҡеё®еҠ©ж¶ҲжҒҜдј йҖ’е’Ңи·Ҝз”ұгҖӮ

- еұһжҖ§ (Properties)(еҸҜйҖү)

- з”ЁжҲ·жҲ–зі»з»ҹиҮӘе®ҡд№үзҡ„й”®еҖјеҜ№пјҲkey-value pairпјүгҖӮ

- дҪңз”ЁпјҡжҗәеёҰйўқеӨ–дҝЎжҒҜжҲ–е…ғж•°жҚ®пјҢеё®еҠ©ж¶ҲжҒҜжҺҘ收方зҗҶи§Јж¶ҲжҒҜеҶ…е®№жҲ–иҝӣиЎҢзӯӣйҖүгҖӮ

- ж¶ҲжҒҜдҪ“ (Body)(еҸҜйҖү)

- ж¶ҲжҒҜзҡ„дё»иҰҒеҶ…е®№пјҢйҖҡеёёеҢ…еҗ«дёҡеҠЎж•°жҚ®гҖӮ

- ж јејҸеҸҜд»ҘжҳҜ ж–Үжң¬пјҲеҰӮ JSONгҖҒXMLпјүгҖҒеӯ—иҠӮжөҒгҖҒеҜ№иұЎзӯүгҖӮ

еҗҢжӯҘе®ўжҲ·з«Ҝ-жңҚеҠЎеҷЁжЁЎеһӢй—®йўҳе’ҢеұҖйҷҗ

еҗҢжӯҘе®ўжҲ·з«Ҝ-жңҚеҠЎеҷЁжЁЎеһӢпјҲSynchronous client-server modelпјүпјҡе®ўжҲ·з«ҜеҸ‘йҖҒиҜ·жұӮеҗҺзӯүеҫ…жңҚеҠЎеҷЁе“Қеә”пјҢйҳ»еЎһејҸжү§иЎҢгҖӮеҹәжң¬зҡ„еҘҪеӨ„жҳҜеҫҲз®ҖеҚ•дҪҶеңЁй«ҳ并еҸ‘еңәжҷҜдёӢж•ҲзҺҮдҪҺдёӢгҖӮ

| зү№зӮ№ | жҸҸиҝ° | еҪұе“Қ |

|---|---|---|

| зҙ§иҖҰеҗҲпјҲTightly Coupledпјү | е®ўжҲ·з«Ҝе’ҢжңҚеҠЎеҷЁй«ҳеәҰдҫқиө–пјҢеҚҸи®®гҖҒж•°жҚ®ж јејҸйңҖе®Ңе…ЁдёҖиҮҙгҖӮ | зјәд№ҸзҒөжҙ»жҖ§пјҢйҡҫд»Ҙжү©еұ•пјҢдҝ®ж”№дёҖж–№йңҖж”№еҠЁеҸҰдёҖж–№гҖӮ |

| жІЎжңүдәӨд»ҳдҝқиҜҒпјҲNo Delivery Guaranteesпјү | ж¶ҲжҒҜдј йҖ’еҸҜиғҪеӨұиҙҘпјҢжңҚеҠЎеҷЁеҸҜиғҪдёўеӨұиҜ·жұӮпјҲжҜ”еҰӮжңҚеҠЎеҷЁдёҚеңЁзәҝпјүпјҢе®ўжҲ·з«ҜеҸҜиғҪжңӘ收еҲ°е“Қеә”пјҢж— еҶ—дҪҷдҝқиҜҒ | еўһеҠ ж•°жҚ®дёўеӨұзҡ„йЈҺйҷ©пјҢзі»з»ҹеҸҜйқ жҖ§йҷҚдҪҺгҖӮ |

| иҪҜ件зү©з§ҚеҢ–пјҲSoftware Speciationпјү | дёҚеҗҢзі»з»ҹйҡҫд»Ҙе…је®№жҲ–еҚҸеҗҢпјҢйҡҸзқҖйңҖжұӮеҸҳеҢ–пјҢе®ўжҲ·з«Ҝе’ҢжңҚеҠЎеҷЁйҖҗжёҗжј”еҢ–дёәзӢ¬з«Ӣзҡ„вҖңзү©з§ҚвҖқгҖӮ | еҘҪеӨ„жҳҜжҸҗй«ҳдәҶзҒөжҙ»жҖ§пјҢеҸҜд»Ҙи®©е…¶жӣҙдё“жіЁиҮӘе·ұзҡ„йңҖжұӮгҖӮдҪҶзі»з»ҹйҡҫд»ҘйӣҶжҲҗпјҢйҷҚдҪҺз»ҙжҠӨжҖ§е’Ңжү©еұ•жҖ§гҖӮ |

| жІЎжңүиҜ·жұӮзј“еҶІпјҲWithout a Request Bufferпјү | жңҚеҠЎеҷЁж”¶еҲ°иҜ·жұӮеҗҺйңҖз«ӢеҚіеӨ„зҗҶпјҢж— зј“еӯҳжңәеҲ¶гҖӮ | й«ҳ并еҸ‘жҲ–й«ҳиҙҹиҪҪж—¶пјҢе®№жҳ“еҮәзҺ°жҖ§иғҪ瓶йўҲжҲ–зі»з»ҹеҙ©жәғгҖӮ |

| иҝҮдәҺејәи°ғиҜ·жұӮе’Ңе“Қеә”пјҲToo Much Emphasis on Requests and Responsesпјү | ејәи°ғиҜ·жұӮдёҺе“Қеә”зҡ„дәӨдә’пјҢеҝҪз•ҘејӮжӯҘйҖҡдҝЎжҲ–дәӢ件й©ұеҠЁзӯүжӣҙй«ҳж•Ҳзҡ„жЁЎејҸгҖӮ | зі»з»ҹзҒөжҙ»жҖ§дёҚи¶іпјҢйҡҫд»Ҙеә”еҜ№еӨҚжқӮдёҡеҠЎйңҖжұӮгҖӮ |

| йҖҡдҝЎдёҚеҸҜйҮҚж”ҫпјҲCommunication is not Replayableпјү | ж¶ҲжҒҜдёўеӨұеҗҺж— жі•йҮҚж”ҫпјҢе®ўжҲ·з«ҜжҲ–жңҚеҠЎеҷЁж— жі•жҒўеӨҚд№ӢеүҚзҠ¶жҖҒгҖӮ | ж•°жҚ®еҸҜиғҪдёўеӨұпјҢзі»з»ҹе®№й”ҷжҖ§е·®пјҢеҪұе“Қз”ЁжҲ·дҪ“йӘҢгҖӮ |

и§ЈеҶіж–№жі•пјҡејӮжӯҘжЁЎеһӢ

еҠ дёҖдёӘж¶ҲжҒҜдёӯй—ҙ件пјҢжңҚеҠЎз«Ҝе’Ңе®ўжҲ·з«ҜйғҪдёҺдёӯй—ҙ件дәӨдә’пјҢеҶҚз”ұдёӯй—ҙ件иҪ¬еҸ‘гҖӮ жҜ”еҰӮcontroller收еҲ°ж¶ҲжҒҜпјҢз»ҷkafkaпјҢserviceзӣ‘еҗ¬kafkaеҺ»еӨ„зҗҶгҖӮиҝҷж ·е®һйҷ…дёҠеҸҢж–№йғҪжҳҜеҜ№зӯүзҡ„пјҢйғҪеҸҜд»ҘжҺҘ收еҸ‘йҖҒж¶ҲжҒҜгҖӮ

жӯӨж—¶ж¶ҲжҒҜеҸҜиғҪеҚҒеҲҶй’ҹеҗҺжүҚеӨ„зҗҶпјҲдёҡеҠЎз№ҒеҝҷдёӢпјүпјҢдё”еңЁcontrollerдёӢе·Із»Ҹиҝ”еӣһз»“жһңпјҢиҰҒе‘ҠиҜүеүҚз«ҜеӨ„зҗҶе®ҢжҲҗпјҢе°ұжңүдәҶдёүз§Қж–№ејҸпјҡ

| е®һзҺ°ж–№ејҸ | еҺҹзҗҶ | дјҳеҠЈеҠҝ |

| JavaScriptзӣ‘еҗ¬ | жҠҠеӨ„зҗҶе®ҢжҲҗзҡ„ж¶ҲжҒҜд№ҹжҺЁеҲ°TopicйҮҢйқўпјҢеҶҚз”ұеүҚз«ҜжҹҘиҜўпјҢеҺҹзҗҶеҰӮеҜ„дҝЎ | дјҳзӮ№пјҡзӣҙжҺҘдәӨдә’пјҢдёҚйңҖиҰҒеҚ•зӢ¬еҶҷж–°жҺҘеҸЈпјҲйғҪиҝҗиЎҢkafkaзӣ‘еҗ¬пјүпјҢеӨҚжқӮпјҢе®ўжҲ·з«ҜзӣҙжҺҘдёҺTopicиҝһжҺҘпјҢTopicзӣҙжҺҘжҡҙйңІпјҢйңҖиҰҒзЎ®дҝқж¶ҲжҒҜдј йҖ’зҡ„е®үе…ЁжҖ§пјҢйҳІжӯўжңӘжҺҲжқғзҡ„и®ўйҳ…е’Ңж¶ҲжҒҜзӘғеҸ–гҖӮ |

| Ajax | еүҚз«ҜеҶҚеҸ‘AjaxиҜ·жұӮпјҢиҪ®иҜўжңәеҲ¶жҹҘиҜў | ж— йңҖдёӯй—ҙ件жҜ”иҫғзҒөжҙ»пјҢдҪҶдёҘйҮҚеўһеҠ жңҚеҠЎеҷЁиҙҹиҪҪпјҢйҖ жҲҗдёҚеҝ…иҰҒзҡ„еёҰе®ҪжөӘиҙ№ |

| websocket | жңҚеҠЎеҷЁе®ўжҲ·з«Ҝwebsocketй“ҫжҺҘ | е®һж—¶жӣҙж–°пјҢеҸҢеҗ‘е·ҘдҪңпјҢиҠӮзңҒдәҶеёҰе®ҪйҖҡдҝЎйҮҸпјҢеҸҜд»ҘдҝқжҢҒжҢҒд№…иҝһжҺҘгҖӮдҪҶе®һзҺ°еӨҚжқӮеәҰй«ҳпјҢдҝқжҢҒиҝһжҺҘи®ІжҢҒз»ӯеҚ з”ЁжңҚеҠЎеҷЁиө„жәҗпјҢиҖҒжөҸи§ҲеҷЁдёҚе…је®№гҖӮ |

дәҢиҖ…并дёҚеӯҳеңЁз»қеҜ№зҡ„дјҳеҠҝеҠЈеҠҝпјҢдҫӢеҰӮзҷ»еҪ•йңҖиҰҒеҸҠж—¶зҡ„еҸҚйҰҲпјҢйӮЈд№ҲеҗҢжӯҘжЁЎеһӢжӣҙеҘҪгҖӮ

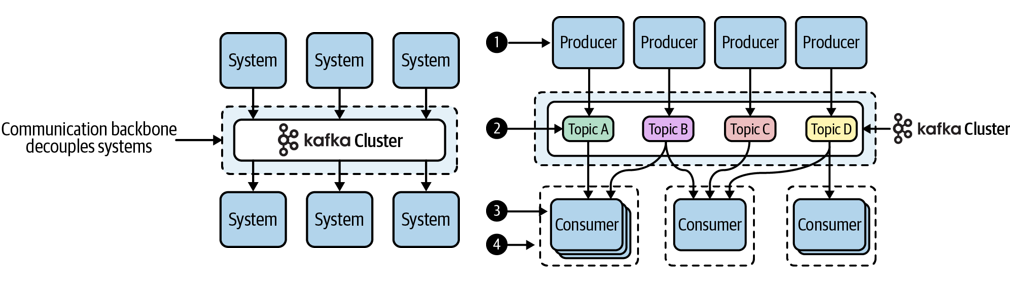

Kafka

дёҖз§Қж¶ҲжҒҜйҳҹеҲ—пјӣдё»иҰҒз”ЁжқҘеӨ„зҗҶеӨ§йҮҸж•°жҚ®зҠ¶жҖҒдёӢзҡ„ж¶ҲжҒҜйҳҹеҲ—пјҢдёҖиҲ¬з”ЁжқҘеҒҡж—Ҙеҝ—зҡ„еӨ„зҗҶгҖӮдё»иҰҒдҪңз”Ёжңүи§ЈиҖҰеҗҲпјҢејӮжӯҘеӨ„зҗҶпјҢжөҒйҮҸеүҠеі°гҖӮ

- kafkaзҡ„ж•°жҚ®еӯҳеӮЁеңЁlogйҮҢйқўпјҢж•°жҚ®еҫҖж–Ү件еҗҺйқўдёҚж–ӯиҝҪеҠ пјҢиҝҪеҠ зҡ„йҖҹеәҰжӣҙеҝ«

- logйҮҢйқўйғҪжҳҜжңүеәҸзҡ„дәӢ件пјҢжҜҸдёӘдәӢ件йғҪжңүдҪҚ移пјҢеҒҸ移йҮҸ

- еҪ“然жңүеҫҲеӨҡдёӘж¶Ҳиҙ№иҖ…пјҢжҠҠж¶Ҳиҙ№иҖ…еҲҶжҲҗдёҚеҗҢзҡ„з»„гҖӮеҪ“дёҖдёӘж¶ҲжҒҜиў«жүҖжңүзҡ„ж¶Ҳиҙ№иҖ…иҜ»иө°дәҶд№ӢеҗҺпјҢиҝҷдёӘж¶ҲжҒҜ жүҚдјҡиў«еҲ йҷӨжҺүпјӣеӨҡдёӘз”ЁжҲ·еҸҜд»ҘиҜ»еҸ–еҗҢдёҖдёӘlogпјҢ并且з»ҙжҠӨ他们еҗ„иҮӘзҡ„ж–Ү件дҪҚзҪ®пјҲйғҪеҲ°е“ӘйҮҢдәҶпјү

- иҝҷж ·е°ұиғҪдҝқиҜҒlogж–Ү件дёҚеҸҜиғҪж— йҷҗеҲ¶зҡ„еўһй•ҝ

- еҜ№дәҺйӣҶзҫӨзҡ„е®№зҒҫпјҢз”Ёз©әй—ҙжҚўеҸҜйқ жҖ§пјҢжҜ”еҰӮжҜҸдёӘж•°жҚ®еӯҳеӮЁдёӨдёӘеүҜжң¬пјҢиҝҷж ·жҜ”еҰӮжңүдёҖдёӘеҚЎеӨ«еҚЎжңҚеҠЎеҷЁеҙ©жәғдәҶпјҢиҝҳжңүдёҖдёӘеӨҮд»ҪиғҪеӨҹдҪҝз”ЁгҖӮеҜ№дәҺconsumerе®№зҒҫпјҢжӯӨж—¶е°ұйңҖиҰҒдёҖдёӘеҚҸи°ғеҷЁеңЁkafkaйӣҶзҫӨйҮҢйқўпјҢconsumerдёҖзӣҙеҸ‘еҝғи·іеҢ…з»ҷеҚҸи°ғеҷЁпјҢеҰӮжһңдёҚеҸ‘еҚҸи°ғеҷЁе°ұдёҚдјҡеҶҚжҠҠж¶ҲжҒҜз»ҷж•…йҡңзҡ„жңәеҷЁгҖӮ

第дёүз«

WebSocket

WebSocketжҳҜдёҖз§Қеә”з”ЁеҚҸи®®пјҢйҖҡиҝҮTCPеҚҸи®®еңЁдёӨдёӘеҜ№зӯүдҪ“д№Ӣй—ҙжҸҗдҫӣе…ЁеҸҢе·ҘпјҲеҸҢеҗ‘йғҪе·ҘдҪңпјүйҖҡдҝЎпјҢеҚіз”ЁжҲ·еҸҜд»Ҙдё»еҠЁз»ҷжңҚеҠЎеҷЁеҸ‘ж¶ҲжҒҜпјҢжңҚеҠЎеҷЁд№ҹеҸҜд»Ҙдё»еҠЁз»ҷз”ЁжҲ·дј йҖ’ж¶ҲжҒҜгҖӮ

- еңЁWebSocketеә”з”ЁзЁӢеәҸдёӯпјҢжңҚеҠЎеҷЁеҸ‘еёғWebSocketз«ҜзӮ№пјҢе®ўжҲ·з«ҜдҪҝз”Ёз«ҜзӮ№зҡ„URIиҝһжҺҘеҲ°жңҚеҠЎеҷЁгҖӮ

- WebSocketеҚҸи®®еңЁиҝһжҺҘе»әз«ӢеҗҺжҳҜеҜ№з§°зҡ„пјҡ

- е®ўжҲ·з«Ҝе’ҢжңҚеҠЎеҷЁеҸҜд»ҘеңЁиҝһжҺҘжү“ејҖж—¶йҡҸж—¶дә’зӣёеҸ‘йҖҒж¶ҲжҒҜпјҢд№ҹеҸҜд»ҘйҡҸж—¶е…ій—ӯиҝһжҺҘгҖӮ

- е®ўжҲ·з«ҜйҖҡеёёеҸӘиҝһжҺҘеҲ°дёҖдёӘжңҚеҠЎеҷЁпјҢжңҚеҠЎеҷЁжҺҘеҸ—жқҘиҮӘеӨҡдёӘе®ўжҲ·з«Ҝзҡ„иҝһжҺҘгҖӮ

WebSocketеҚҸи®®жңүдёӨйғЁеҲҶпјҡ

жҸЎжүӢпјҲhandshakeпјүе’Ңж•°жҚ®дј иҫ“пјҲdata transfer пјүгҖӮ

еҹәжң¬иҝҮзЁӢ

е®ўжҲ·з«ҜеҸ‘иө· WebSocket жҸЎжүӢиҜ·жұӮ

е®ўжҲ·з«ҜйҖҡиҝҮдҪҝз”Ёе…¶URIеҗ‘WebSocketз«ҜзӮ№еҸ‘йҖҒиҜ·жұӮжқҘеҗҜеҠЁжҸЎжүӢгҖӮ

жҸЎжүӢпјҲhandshakeпјүдёҺзҺ°жңүзҡ„еҹәдәҺHTTPзҡ„еҹәзЎҖи®ҫж–Ҫе…је®№пјҢWebжңҚеҠЎеҷЁи§ЈйҮҠе…¶дёәHTTPиҝһжҺҘеҚҮзә§иҜ·жұӮпјҢдёҖдёӘдҫӢеӯҗеҰӮдёӢпјҡ

GET /path/to/websocket/endpoint HTTP/1.1

Host: localhost

Upgrade: websocket

Connection: Upgrade

Sec-WebSocket-Key: xqBt3ImNzJbYqRINxEFlkg==

Origin: http://localhost

Sec-WebSocket-Version: 13жңҚеҠЎеҷЁе“Қеә” WebSocket жҸЎжүӢиҜ·жұӮ

HTTP/1.1 101 Switching Protocols

Upgrade: websocket

Connection: Upgrade

Sec-WebSocket-Accept: K7DJLdLooIwIG/MOpvWFB3y3FE8=Sec-WebSocket-Accept зҡ„з”ҹжҲҗ

- жңҚеҠЎеҷЁеҜ№Sec-WebSocket-Keyж ҮеӨҙзҡ„еҖјеә”з”Ёе·ІзҹҘж“ҚдҪңпјҢд»Ҙз”ҹжҲҗSec-WebSocket-Acceptж ҮеӨҙзҡ„еҖјгҖӮ

- е®ўжҲ·з«ҜеҜ№Sec-WebSocket-Keyж ҮеӨҙзҡ„еҖјеә”з”ЁзӣёеҗҢзҡ„ж“ҚдҪңпјҢеҰӮжһңз»“жһңдёҺд»ҺжңҚеҠЎеҷЁжҺҘ收еҲ°зҡ„еҖјеҢ№й…ҚпјҢеҲҷиҝһжҺҘжҲҗеҠҹе»әз«ӢгҖӮ

е»әз«Ӣ WebSocket иҝһжҺҘ

е®ўжҲ·з«Ҝ收еҲ°жңҚеҠЎеҷЁзҡ„е“Қеә”еҗҺпјҢйӘҢиҜҒ Sec-WebSocket-Accept жҳҜеҗҰжӯЈзЎ®гҖӮеҰӮжһңйӘҢиҜҒйҖҡиҝҮпјҢжңҚеҠЎеҷЁе’Ңе®ўжҲ·з«Ҝе°ұеҸҜд»Ҙдә’зӣёеҸ‘йҖҒж¶ҲжҒҜдәҶгҖӮ

ws://host:port/path?query

wss://host:port/path?query зӨәдҫӢе®һзҺ°

- еҲӣе»әз«ҜзӮ№зұ»пјҲendpointпјүгҖӮ

- е®һзҺ°з«ҜзӮ№зҡ„з”ҹе‘Ҫе‘Ёжңҹж–№жі•гҖӮ

- е°ҶжӮЁзҡ„дёҡеҠЎйҖ»иҫ‘ж·»еҠ еҲ°з«ҜзӮ№гҖӮ

- еңЁwebеә”з”ЁзЁӢеәҸеҶ…йғЁйғЁзҪІз«ҜзӮ№гҖӮ

еҜ№дәҺе…·дҪ“йҖ»иҫ‘е®һзҺ°пјҢз”ЁжҲ·еә”еҪ“е…ҲеҸ‘йҖҒйӘҢиҜҒпјҢжңҚеҠЎеҷЁиҝ”еӣһtokenпјҢеҶҚж №жҚ®tokenе»әз«ӢиҝһжҺҘдҝқиҜҒе”ҜдёҖжҖ§пјҲйҳІжӯўе…¶д»–дәәд№ҹеҸҜд»ҘиҝһжҺҘпјүгҖӮ

endpoint

еңЁWebSocketдёӯпјҢendpoint жҳҜжҢҮWebSocketйҖҡдҝЎзҡ„зӣ®ж ҮжҲ–з»ҲзӮ№гҖӮе®ғжҳҜWebSocketиҝһжҺҘзҡ„еҸҰдёҖз«ҜпјҢеҸҜд»Ҙ жҳҜжңҚеҠЎеҷЁжҲ–е®ўжҲ·з«ҜпјҢз”ЁдәҺжҺҘ收жҲ–еҸ‘йҖҒWebSocketж¶ҲжҒҜгҖӮ

е…ұжңүдёӨз§Қзұ»еһӢendpointпјҡ

- WebSocketжңҚеҠЎеҷЁз«Ҝ(endpoint)пјҡиҝҷжҳҜWebSocketйҖҡдҝЎзҡ„жңҚеҠЎеҷЁз«ҜпјҢе®ғзӯүеҫ…е®ўжҲ·з«Ҝзҡ„иҝһжҺҘиҜ·жұӮ并еӨ„зҗҶе®ғ们гҖӮдёҖж—ҰиҝһжҺҘе»әз«ӢпјҢжңҚеҠЎеҷЁз«Ҝе°ұдјҡзӣ‘еҗ¬жқҘиҮӘе®ўжҲ·з«Ҝзҡ„ж¶ҲжҒҜпјҢ并еҸҜд»Ҙеҗ‘е®ўжҲ·з«ҜеҸ‘йҖҒж¶ҲжҒҜгҖӮ WebSocketжңҚеҠЎеҷЁйҖҡеёёз”ЁдәҺе®һж—¶йҖҡдҝЎгҖҒеңЁзәҝжёёжҲҸгҖҒиҒҠеӨ©еә”з”ЁзӯүеңәжҷҜгҖӮ

- WebSocketе®ўжҲ·з«Ҝ(endpoint)пјҡиҝҷжҳҜWebSocketйҖҡдҝЎзҡ„е®ўжҲ·з«ҜпјҢе®ғдёҺWebSocketжңҚеҠЎеҷЁе»әз«ӢиҝһжҺҘпјҢ并еҸҜд»Ҙеҗ‘жңҚеҠЎеҷЁеҸ‘йҖҒж¶ҲжҒҜпјҢеҗҢж—¶жҺҘ收жңҚеҠЎеҷЁеҸ‘йҖҒзҡ„ж¶ҲжҒҜгҖӮWebSocketе®ўжҲ·з«ҜйҖҡеёёз”ЁдәҺдёҺжңҚеҠЎеҷЁиҝӣиЎҢеҸҢеҗ‘йҖҡдҝЎпјҢд»ҘиҺ·еҸ–е®һж—¶ж•°жҚ®жҲ–дёҺжңҚеҠЎеҷЁиҝӣиЎҢдәӨдә’гҖӮ

ж¶ҲжҒҜд»ЈзҗҶпјҲMessage Brokerпјү

еңЁWebSocketйҖҡдҝЎдёӯпјҢж¶ҲжҒҜд»ЈзҗҶжҳҜжҢҮWebSocketжңҚеҠЎеҷЁе’Ңе®ўжҲ·з«Ҝд№Ӣй—ҙзҡ„дёӯй—ҙ件пјҢз”ЁдәҺиҪ¬еҸ‘WebSocketж¶ҲжҒҜгҖӮе®ғе……еҪ“дәҶWebSocketжңҚеҠЎеҷЁе’Ңе®ўжҲ·з«Ҝд№Ӣй—ҙзҡ„жЎҘжўҒпјҢдҪҝе®ғ们еҸҜд»Ҙзӣёдә’йҖҡдҝЎгҖӮж¶ҲжҒҜд»ЈзҗҶеҸҜд»ҘжҳҜдёҖдёӘзӢ¬з«Ӣзҡ„жңҚеҠЎеҷЁпјҢд№ҹеҸҜд»ҘжҳҜWebSocketжңҚеҠЎеҷЁжң¬иә«гҖӮ

第еӣӣз«

Transaction

transactionжҳҜдёҖзі»еҲ—еҝ…йЎ»е…ЁйғЁжҲҗеҠҹе®ҢжҲҗзҡ„ж“ҚдҪңпјҢиҰҒд№ҲйғҪжү§иЎҢпјҢиҰҒд№ҲйғҪдёҚжү§иЎҢпјҲдәӢеҠЎеӣһж»ҡпјүпјҢдҝқиҜҒ ж•°жҚ®еә“ дёӯзҡ„ж•°жҚ®е§Ӣз»ҲеӨ„дәҺдёҖиҮҙзҡ„зҠ¶жҖҒгҖӮдәӢеҠЎзҡ„дё»иҰҒзӣ®ж ҮжҳҜзЎ®дҝқж•°жҚ®зҡ„дёҖиҮҙжҖ§гҖҒе®Ңж•ҙжҖ§е’ҢеҸҜйқ жҖ§пјҢе°Өе…¶жҳҜеңЁе№¶еҸ‘и®ҝй—®е’ҢејӮеёёжғ…еҶөдёӢгҖӮ

е®һзҺ°зҡ„жң¬иҙЁжҳҜдҫқиө–дәҺ ж—Ҙеҝ— е®һзҺ°зҡ„пјҢеҜ№дәҺеҶ…еӯҳеҸҳйҮҸжҜ”еҰӮдёҙж—¶еҸҳйҮҸint x пјҢ Int yпјҢдёҚдјҡи§ҰеҸ‘дәӢеҠЎеӣһж»ҡ

дәӢзү©еұһжҖ§

дәӢеҠЎеӨ„зҗҶзҡ„ACID

ACID жҳҜж•°жҚ®еә“дәӢеҠЎдёӯзҡ„еӣӣдёӘе…ій”®еұһжҖ§пјҢзЎ®дҝқж•°жҚ®еә“еңЁжү§иЎҢдәӢеҠЎж—¶иғҪеӨҹжӯЈзЎ®гҖҒе®үе…Ёең°еӨ„зҗҶж•°жҚ®гҖӮ

- еҺҹеӯҗжҖ§пјҡдёҚеҸҜеҲҶеүІпјҢзЎ®дҝқдәӢеҠЎдёӯзҡ„жҜҸдёҖжӯҘйғҪжү§иЎҢжҲҗеҠҹжҲ–дёҚжү§иЎҢпјҢйҒҝе…ҚйғЁеҲҶеӨұиҙҘгҖӮ

- дёҖиҮҙжҖ§пјҡжӯЈзЎ®дёҖиҮҙпјҢдҝқжҢҒж•°жҚ®еә“зҡ„е®Ңж•ҙжҖ§пјҢйҒҝе…ҚиҝқиғҢзәҰжқҹжқЎд»¶гҖӮ

- йҡ”зҰ»жҖ§пјҡдә’дёҚе№Іжү°пјҢйҒҝе…ҚдәӢеҠЎй—ҙзҡ„е№Іжү°пјҢзЎ®дҝқ并еҸ‘жү§иЎҢзҡ„дәӢеҠЎеҪјжӯӨзӢ¬з«ӢпјҢе’ҢдёІиЎҢеҫ—еҲ°зҡ„з»“жһңдёҖиҮҙгҖӮ

- жҢҒд№…жҖ§пјҡж°ёиҝңдҝқжҢҒпјҢдёҖж—ҰдәӢеҠЎжҸҗдәӨпјҢз»“жһңж°ёд№…з”ҹж•ҲпјҢйҒҝе…Қж•°жҚ®дёўеӨұгҖӮ

A – AtomicityпјҲеҺҹеӯҗжҖ§пјүпјҡ

- е®ҡд№үпјҡдәӢеҠЎдёӯзҡ„жүҖжңүж“ҚдҪңиҰҒд№Ҳе…ЁйғЁжҲҗеҠҹпјҢиҰҒд№Ҳе…ЁйғЁеӣһж»ҡгҖӮеҰӮжһңдәӢеҠЎдёӯзҡ„д»»дҪ•дёҖжӯҘж“ҚдҪңеӨұиҙҘпјҢеҲҷж•ҙдёӘдәӢеҠЎеӨұиҙҘпјҢж•°жҚ®еә“зҠ¶жҖҒдјҡеӣһеҲ°дәӢеҠЎејҖе§Ӣд№ӢеүҚзҡ„зҠ¶жҖҒпјҢзЎ®дҝқдёҚдјҡжңүйғЁеҲҶж“ҚдҪңжҲҗеҠҹзҡ„жғ…еҶөгҖӮ

- и§ЈйҮҠпјҡдәӢеҠЎиҰҒеғҸдёҖдёӘдёҚеҸҜеҲҶеүІзҡ„еҺҹеӯҗдёҖж ·жү§иЎҢгҖӮеҚідҫҝдәӢеҠЎдёӯеҢ…еҗ«еӨҡжӯҘж“ҚдҪңпјҢиҝҷдәӣж“ҚдҪңиҰҒд№Ҳе…ЁйғЁе®ҢжҲҗпјҢиҰҒд№Ҳе®Ңе…ЁдёҚжү§иЎҢгҖӮ

- дҫӢеӯҗпјҡ银иЎҢиҪ¬иҙҰж“ҚдҪңдёӯпјҢиҪ¬иҙҰзҡ„дёӨдёӘжӯҘйӘӨжҳҜд»ҺиҙҰжҲ·AжүЈй’ұгҖҒеҗ‘иҙҰжҲ·BеҠ й’ұгҖӮдәӢеҠЎзҡ„еҺҹеӯҗжҖ§зЎ®дҝқеҰӮжһңе…¶дёӯдёҖжӯҘеӨұиҙҘпјҢж•ҙдёӘиҪ¬иҙҰж“ҚдҪңе°ұдјҡеӣһж»ҡпјҢиҙҰжҲ·Aе’ҢиҙҰжҲ·Bзҡ„дҪҷйўқдҝқжҢҒдёҚеҸҳгҖӮ

C – ConsistencyпјҲдёҖиҮҙжҖ§пјүпјҡ

- е®ҡд№үпјҡдәӢеҠЎжү§иЎҢеҗҺпјҢж•°жҚ®еә“еҝ…йЎ»д»ҺдёҖдёӘдёҖиҮҙзҡ„зҠ¶жҖҒиҪ¬жҚўдёәеҸҰдёҖдёӘдёҖиҮҙзҡ„зҠ¶жҖҒгҖӮеңЁдёҖиҮҙжҖ§зәҰжқҹжқЎд»¶дёӢпјҢж•°жҚ®еә“дёӯзҡ„ж•°жҚ®дҝқжҢҒе®Ңж•ҙжҖ§гҖӮ

- и§ЈйҮҠпјҡдәӢеҠЎеңЁејҖе§Ӣе’Ңз»“жқҹж—¶пјҢж•°жҚ®еә“йғҪеҝ…йЎ»з¬ҰеҗҲжүҖжңүйў„и®ҫзҡ„规еҲҷгҖҒзәҰжқҹе’Ңж•°жҚ®е®Ңж•ҙжҖ§жқЎд»¶гҖӮдәӢеҠЎдёҚиғҪз ҙеқҸж•°жҚ®еә“зҡ„规еҲҷжҲ–е®Ңж•ҙжҖ§зәҰжқҹгҖӮ

- дҫӢеӯҗпјҡеҒҮи®ҫжңүдёҖдёӘж•°жҚ®еә“规еҲҷпјҢ规е®ҡ银иЎҢиҙҰжҲ·зҡ„дҪҷйўқдёҚиғҪдёәиҙҹж•°гҖӮдёҖж—ҰдәӢеҠЎжү§иЎҢе®ҢжҲҗпјҢж•°жҚ®еә“еҝ…йЎ»зЎ®дҝқиҝҷдёӘ规еҲҷдҫқж—§жҲҗз«ӢпјҢеҰӮжһңжҹҗдёӘж“ҚдҪңиҜ•еӣҫиҝқеҸҚ规еҲҷпјҢдәӢеҠЎе°Ҷиў«еӣһж»ҡгҖӮ

I – IsolationпјҲйҡ”зҰ»жҖ§пјүпјҡ

- е®ҡд№үпјҡеӨҡдёӘ并еҸ‘жү§иЎҢзҡ„дәӢеҠЎд№Ӣй—ҙеҪјжӯӨйҡ”зҰ»пјҢдёҖдёӘдәӢеҠЎзҡ„жү§иЎҢдёҚеә”еҪұе“Қ其他并еҸ‘дәӢеҠЎзҡ„жү§иЎҢз»“жһңгҖӮжҜҸдёӘдәӢеҠЎеә”иҜҘеҘҪеғҸжҳҜзӢ¬з«Ӣжү§иЎҢзҡ„пјҢеҚідҪҝеңЁеӨҡдәӢеҠЎе№¶еҸ‘зҡ„жғ…еҶөдёӢгҖӮ

- и§ЈйҮҠпјҡеҚідҪҝжңүеӨҡдёӘдәӢеҠЎе№¶еҸ‘иҝҗиЎҢпјҢзі»з»ҹд№ҹйңҖиҰҒзЎ®дҝқдёҖдёӘдәӢеҠЎдёӯзҡ„жңӘжҸҗдәӨж•°жҚ®дёҚдјҡиў«е…¶д»–дәӢеҠЎзңӢеҲ°жҲ–еҪұе“ҚпјҢйҳІжӯўвҖңи„ҸиҜ»вҖқгҖҒ”дёҚеҸҜйҮҚеӨҚиҜ»”гҖҒ”е№»иҜ»”зӯү并еҸ‘й—®йўҳгҖӮйҡ”зҰ»жҖ§йҖҡеёёйҖҡиҝҮдәӢеҠЎзҡ„йҡ”зҰ»зә§еҲ«жқҘе®һзҺ°пјҢеҰӮ

Read CommittedгҖҒRepeatable ReadзӯүгҖӮ - дҫӢеӯҗпјҡеҒҮи®ҫдәӢеҠЎAжӯЈеңЁдҝ®ж”№дёҖдёӘж•°жҚ®пјҢдҪҶе°ҡжңӘжҸҗдәӨпјҢдәӢеҠЎBдёҚеә”иҜҘиҜ»еҸ–еҲ°дәӢеҠЎAжңӘжҸҗдәӨзҡ„дёӯй—ҙзҠ¶жҖҒж•°жҚ®гҖӮ

D – DurabilityпјҲжҢҒд№…жҖ§пјүпјҡ

- е®ҡд№үпјҡдәӢеҠЎдёҖж—ҰжҸҗдәӨпјҢж•°жҚ®зҡ„дҝ®ж”№е°ұдјҡж°ёд№…дҝқеӯҳпјҢеҚідҪҝзі»з»ҹеҙ©жәғжҲ–ж•…йҡңпјҢе·ІжҸҗдәӨзҡ„дәӢеҠЎж•°жҚ®д№ҹдёҚдјҡдёўеӨұгҖӮ

- и§ЈйҮҠпјҡдәӢеҠЎжҸҗдәӨеҗҺпјҢзі»з»ҹдјҡзЎ®дҝқжүҖжңүж•°жҚ®зҡ„дҝ®ж”№жҢҒд№…еҢ–еӯҳеӮЁпјҢеҚідҪҝеҸ‘з”ҹ硬件жҲ–иҪҜ件故йҡңпјҢзі»з»ҹйҮҚеҗҜеҗҺж•°жҚ®д»Қ然еҸҜд»ҘжҒўеӨҚгҖӮйҖҡеёёйҖҡиҝҮеҶҷе…Ҙж—Ҙеҝ—жҲ–йҮҮз”Ёж•°жҚ®еә“еӨҮд»ҪжңәеҲ¶е®һзҺ°гҖӮ

- дҫӢеӯҗпјҡеҒҮи®ҫз”ЁжҲ·е®ҢжҲҗдәҶдёҖ次银иЎҢиҪ¬иҙҰж“ҚдҪң并жҸҗдәӨдәҶдәӢеҠЎпјҢеҚідҪҝзі»з»ҹеңЁиҪ¬иҙҰе®ҢжҲҗеҗҺ马дёҠеҙ©жәғпјҢиҪ¬иҙҰзҡ„ж•°жҚ®д№ҹеә”иҜҘж°ёд№…дҝқз•ҷпјҢ并еңЁзі»з»ҹжҒўеӨҚеҗҺеӯҳеңЁгҖӮ

еёёи§Ғж Үзӯҫи§ЈйҮҠ

Required

- иҜҙжҳҺпјҡй»ҳи®Өзҡ„дәӢеҠЎеұһжҖ§гҖӮеҰӮжһңеҪ“еүҚжІЎжңүдәӢеҠЎпјҢеҲҷж–°е»әдёҖдёӘдәӢеҠЎгҖӮеҰӮжһңи°ғз”Ёж—¶е·Із»ҸеӯҳеңЁдёҖдёӘдәӢеҠЎпјҢеҪ“еүҚж–№жі•е°ҶеҠ е…ҘеҲ°зҺ°жңүзҡ„дәӢеҠЎдёӯгҖӮжіЁж„ҸпјҒеңЁиҝӣе…Ҙе’ҢйҖҖеҮәж–№жі•зҡ„ж—¶еҖҷйғҪдјҡеҒҡжЈҖжҹҘпјҒ

- йҖӮз”ЁеңәжҷҜпјҡйҖӮз”ЁдәҺз»қеӨ§еӨҡж•°жғ…еҶөпјҢзЎ®дҝқжүҖжңүзӣёе…іж“ҚдҪңиҰҒд№ҲдёҖиө·жҸҗдәӨпјҢиҰҒд№ҲдёҖиө·еӣһж»ҡгҖӮ

- дј ж’ӯиЎҢдёәпјҡеҠ е…ҘзҺ°жңүдәӢеҠЎжҲ–еҲӣе»әдёҖдёӘж–°дәӢеҠЎгҖӮ

- е…·дҪ“дәӢдҫӢпјҡAдёӯжңүж–№жі•BпјҢиӢҘA,BеқҮдёәRequiredпјҢеҲҷеҸӘдјҡеҲӣе»әдёҖдёӘдәӢзү©

RequiresNew

- иҜҙжҳҺпјҡж— и®әи°ғз”Ёж—¶жҳҜеҗҰеӯҳеңЁдәӢеҠЎпјҢе§Ӣз»Ҳж–°е»әдёҖдёӘдәӢеҠЎгҖӮеҰӮжһңе·ІжңүдәӢеҠЎпјҢеҪ“еүҚдәӢеҠЎдјҡиў«жҢӮиө·пјҢеҫ…ж–°дәӢеҠЎз»“жқҹеҗҺжҒўеӨҚеҺҹжқҘзҡ„дәӢеҠЎгҖӮ

- йҖӮз”ЁеңәжҷҜпјҡз”ЁдәҺйңҖиҰҒж–№жі•зӢ¬з«Ӣжү§иЎҢгҖҒйҒҝе…ҚдёҺеӨ–йғЁдәӢеҠЎе№Іжү°зҡ„жғ…еҶөгҖӮ

- дј ж’ӯиЎҢдёәпјҡе§Ӣз»ҲеҲӣе»әж–°дәӢеҠЎпјҢеҺҹжңүдәӢеҠЎиў«жҡӮж—¶жҢӮиө·гҖӮ

- е…·дҪ“дәӢдҫӢпјҡLOGж“ҚдҪңдёҚеёҢжңӣиў«дёӯж–ӯпјҢеҸҜд»ҘеҚ•зӢ¬ејҖRequiresNewгҖӮиӢҘAдёӯжңүж–№жі•BпјҢиӢҘAдёәRequiredпјҢBдёәRequiresNew,йӮЈд№ҲBеҸ‘з”ҹй”ҷиҜҜдёҚдјҡеҪұе“ҚA

Supports

- иҜҙжҳҺпјҡж–№жі•еҸҜд»Ҙж”ҜжҢҒдәӢеҠЎпјҢдҪҶдёҚејәеҲ¶иҰҒжұӮгҖӮеҰӮжһңеҪ“еүҚжңүдәӢеҠЎпјҢж–№жі•е°ҶеҠ е…ҘзҺ°жңүдәӢеҠЎпјӣеҰӮжһңжІЎжңүдәӢеҠЎпјҢж–№жі•д№ҹеҸҜд»ҘйқһдәӢеҠЎжҖ§ең°жү§иЎҢгҖӮ

- йҖӮз”ЁеңәжҷҜпјҡз”ЁдәҺеҸҜйҖүжӢ©жҖ§зҡ„дәӢеҠЎж“ҚдҪңпјҢдәӢеҠЎжҖ§е№¶дёҚжҳҜеҝ…йңҖзҡ„гҖӮ

- дј ж’ӯиЎҢдёәпјҡеҰӮжһңжңүзҺ°жңүдәӢеҠЎеҲҷеҠ е…ҘпјҢеҗҰеҲҷйқһдәӢеҠЎжҖ§жү§иЎҢгҖӮ

- е…·дҪ“дәӢдҫӢпјҡиӢҘAдёӯжңүж–№жі•BпјҢдё”дәҢиҖ…еқҮдёәSupportsпјҢеҲҷжІЎжңүдәӢзү©гҖӮ

NotSupported

- иҜҙжҳҺпјҡеҪ“еүҚж–№жі•дёҚж”ҜжҢҒдәӢеҠЎгҖӮеҰӮжһңи°ғз”Ёж—¶жңүдәӢеҠЎеӯҳеңЁпјҢдәӢеҠЎдјҡиў«жҢӮиө·пјҢж–№жі•жү§иЎҢе®ҢжҲҗеҗҺеҶҚжҒўеӨҚеҺҹжқҘзҡ„дәӢеҠЎгҖӮ

- йҖӮз”ЁеңәжҷҜпјҡеҪ“дёҚеёҢжңӣж–№жі•еңЁдәӢеҠЎдёҠдёӢж–ҮдёӯиҝҗиЎҢж—¶пјҢжҜ”еҰӮдёҚйңҖиҰҒдәӢеҠЎдҝқиҜҒзҡ„дёҖдәӣеҸӘиҜ»ж“ҚдҪңгҖӮ

- дј ж’ӯиЎҢдёәпјҡжҢӮиө·зҺ°жңүдәӢеҠЎпјҢж— дәӢеҠЎж”ҜжҢҒгҖӮ

- е…·дҪ“дәӢдҫӢпјҡиӢҘAдёӯжңүж–№жі•BпјҢBдёәNotSupportedпјҢйӮЈд№ҲBдјҡдёҚеңЁдәӢзү©зҠ¶жҖҒжү§иЎҢ

Mandatory

- иҜҙжҳҺпјҡж–№жі•еҝ…йЎ»еңЁзҺ°жңүдәӢеҠЎдёҠдёӢж–Үдёӯжү§иЎҢгҖӮеҰӮжһңи°ғз”Ёж—¶жІЎжңүдәӢеҠЎеӯҳеңЁпјҢдјҡжҠӣеҮәејӮеёёгҖӮ

- йҖӮз”ЁеңәжҷҜпјҡејәеҲ¶иҰҒжұӮж–№жі•еҝ…йЎ»еңЁдәӢеҠЎдёӯжү§иЎҢгҖӮ

- дј ж’ӯиЎҢдёәпјҡеҝ…йЎ»жңүзҺ°жңүдәӢеҠЎпјҢеҰӮжһңжІЎжңүе°ұдјҡеӨұиҙҘгҖӮ

Never

- иҜҙжҳҺпјҡж–№жі•дёҚе…Ғи®ёеңЁдәӢеҠЎдёҠдёӢж–Үдёӯжү§иЎҢгҖӮеҰӮжһңи°ғз”Ёж—¶еӯҳеңЁдәӢеҠЎпјҢеҲҷжҠӣеҮәејӮеёёгҖӮ

- йҖӮз”ЁеңәжҷҜпјҡйңҖиҰҒзЎ®дҝқж–№жі•з»қеҜ№дёҚеңЁдәӢеҠЎдёӯжү§иЎҢж—¶гҖӮ

- дј ж’ӯиЎҢдёәпјҡдёҚиғҪжңүдәӢеҠЎпјҢеҰӮжһңжңүдәӢеҠЎеҲҷеӨұиҙҘгҖӮ

еӣһж»ҡпјҡжҠӣеҮә RuntimeException жҲ–иҖ… Error зҡ„ж—¶еҖҷпјҢspringдјҡиҮӘеҠЁеӣһж»ҡ

дәӢеҠЎйҡ”зҰ»зә§еҲ«

дәӢеҠЎйҡ”зҰ»зә§еҲ«жҺ§еҲ¶зҡ„жҳҜеҗҢдёҖж—¶й—ҙеҶ…еӨҡдёӘдәӢеҠЎеҰӮдҪ•зӣёдә’еҪұе“Қж•°жҚ®еҸҜи§ҒжҖ§зҡ„й—®йўҳгҖӮе®ғ规е®ҡдәҶдёҖдёӘдәӢеҠЎеҶ…зҡ„ж“ҚдҪңеңЁи®ҝй—®ж•°жҚ®ж—¶пјҢжҳҜеҗҰиғҪзңӢеҲ°е…¶д»–дәӢеҠЎеҜ№зӣёеҗҢж•°жҚ®зҡ„жӣҙж”№пјҢд»ҘеҸҠеҪ“еүҚдәӢеҠЎеҜ№е…¶д»–дәӢеҠЎжҳҜеҗҰеҸҜи§ҒгҖӮдёҚеҗҢзҡ„йҡ”зҰ»зә§еҲ«жҸҗдҫӣдәҶдёҚеҗҢзЁӢеәҰзҡ„ж•°жҚ®дёҖиҮҙжҖ§е’Ң并еҸ‘жҖ§дҝқжҠӨгҖӮ

йҡ”зҰ»жҖ§еҶІзӘҒжҖ»з»“

| иҜ»еҶҷеҶІзӘҒ | и„ҸиҜ» | дәӢеҠЎAиҜ»еҸ–дәҶдәӢеҠЎBдҝ®ж”№дҪҶжңӘжҸҗдәӨзҡ„ж•°жҚ®пјҲиҜ»еҲ°дәҶдәӢзү©еӨ„зҗҶзҡ„дёӯй—ҙзҠ¶жҖҒпјүпјҢдәӢеҠЎBйҡҸеҗҺеӣһж»ҡпјҢеҜјиҮҙAиҜ»зҡ„ж•°жҚ®ж— ж•ҲгҖӮ |

| иҜ»еҶҷеҶІзӘҒ | дёҚеҸҜйҮҚеӨҚиҜ» | дәӢеҠЎA第дёҖж¬ЎиҜ»еҸ–ж•°жҚ®еҗҺпјҢдәӢеҠЎBдҝ®ж”№е№¶жҸҗдәӨиҜҘж•°жҚ®пјҢдәӢеҠЎAеҶҚж¬ЎиҜ»еҸ–ж—¶ж•°жҚ®иў«дҝ®ж”№гҖӮ |

| иҜ»еҶҷеҶІзӘҒ | е№»иҜ» | дәӢеҠЎAжү§иЎҢиҢғеӣҙжҹҘиҜўеҗҺпјҢдәӢеҠЎBжҸ’е…Ҙ/еҲ йҷӨдәҶж»Ўи¶іжқЎд»¶зҡ„и®°еҪ•пјҢдәӢеҠЎAеҶҚж¬ЎжҹҘиҜўж—¶дёҚеҗҢгҖӮ |

| еҶҷеҶҷеҶІзӘҒ | и„ҸеҶҷ | дәӢеҠЎAе’ҢдәӢеҠЎBеҗҢж—¶дҝ®ж”№еҗҢдёҖжқЎи®°еҪ•пјҢдәӢеҠЎBзҡ„жҸҗдәӨиҰҶзӣ–дәҶдәӢеҠЎAзҡ„дҝ®ж”№гҖӮ |

дҪҝз”Ёж–№жі•

д»»еҠЎжң¬иә«жҳҜеңЁж•°жҚ®еә“е®ҢжҲҗпјҢеӣ жӯӨжҲ‘们йңҖиҰҒеңЁй“ҫжҺҘж•°жҚ®еә“зҡ„ж—¶еҖҷпјҢе‘ҠиҜүж•°жҚ®еә“жҲ‘们йңҖиҰҒд»Җд№Ҳйҡ”зҰ»пјҢж•°жҚ®еә“еҸҜд»Ҙеё®еҠ©е®ҢжҲҗеҠ й”Ғж“ҚдҪңгҖӮ

@Transactional(isolation = Isolation.READ_UNCOMMITTED)@Transactional(isolation = Isolation.READ_COMMITTED)@Transactional(isolation = Isolation.REPEATABLE_READ)@Transactional(isolation = Isolation.SERIALIZABLE)

еёёи§Ғж Үзӯҫи§ЈйҮҠ

Read Uncommittedпјҡ

- зү№жҖ§пјҡе…Ғи®ёдёҖдёӘдәӢеҠЎиҜ»еҸ–еҸҰдёҖдёӘжңӘжҸҗдәӨдәӢеҠЎзҡ„дҝ®ж”№пјҢеҸҜиғҪеҸ‘з”ҹи„ҸиҜ»пјҲDirty ReadпјүгҖӮ

- дјҳзӮ№пјҡ并еҸ‘жҖ§иғҪиҫғй«ҳгҖӮ

- зјәзӮ№пјҡжңҖдҪҺзҡ„йҡ”зҰ»зә§еҲ«пјҢеҸҜиғҪдјҡзңӢеҲ°жңӘжҸҗдәӨзҡ„ж•°жҚ®еҸҳеҢ–гҖӮ

- дҫӢеӯҗпјҡеҒҮи®ҫиҪҰзҘЁйў„и®ўдәҶпјҢжӯӨж—¶й”ҒдҪҸзҘЁпјҢйӮЈд№ҲеҰӮжһңжІЎжңүд№°жІЎйҖҖеҮәпјҢе…¶д»–дәәд№ҹд№°дёҚдәҶгҖӮ

Read Committedпјҡ

- зү№жҖ§пјҡеҸӘиғҪиҜ»еҸ–е·Із»ҸжҸҗдәӨзҡ„дәӢеҠЎдҝ®ж”№пјҢйҒҝе…ҚдәҶи„ҸиҜ»пјҢдҪҶеҸҜиғҪеҸ‘з”ҹдёҚеҸҜйҮҚеӨҚиҜ»пјҲNon-repeatable ReadпјүгҖӮ

- дјҳзӮ№пјҡеӨ§еӨҡж•°ж•°жҚ®еә“зҡ„й»ҳи®Өзә§еҲ«пјҢдҝқиҜҒжҜҸж¬ЎиҜ»еҸ–зҡ„ж•°жҚ®йғҪжҳҜе·ІжҸҗдәӨзҡ„гҖӮ

- зјәзӮ№пјҡеҗҢдёҖдәӢеҠЎдёӯпјҢиҝһз»ӯиҜ»еҸ–еҗҢдёҖжқЎж•°жҚ®еҸҜиғҪдјҡдёҚдёҖиҮҙгҖӮ

- дҫӢеӯҗпјҡеҗҢдёҖдёӘдәӢзү©еҶ…еӨҡж¬ЎеҜ№дёҖдёӘеҖјиҜ·жұӮпјҢ第дёҖж¬ЎGETдёәaпјҢ第дәҢж¬ЎGETе°ұеҸҜиғҪдёәbдәҶпјҢеӣ дёәжҜҸж¬ЎйғҪиҜ»еҸ–е·Із»ҸжҸҗдәӨзҡ„дәӢзү©дҝ®ж”№гҖӮ

Repeatable Readпјҡ

- зү№жҖ§пјҡдҝқиҜҒеҗҢдёҖдёӘдәӢеҠЎдёӯеӨҡж¬ЎиҜ»еҸ–зҡ„ж•°жҚ®жҳҜдёҖиҮҙзҡ„пјҢйҒҝе…ҚдёҚеҸҜйҮҚеӨҚиҜ»пјҢдҪҶеҸҜиғҪдјҡеҸ‘з”ҹе№»иҜ»пјҲPhantom ReadпјүгҖӮ

- дјҳзӮ№пјҡзЎ®дҝқиҜ»еҸ–зҡ„и®°еҪ•еңЁдәӢеҠЎжңҹй—ҙдёҚеҸ‘з”ҹеҸҳеҢ–гҖӮ

- зјәзӮ№пјҡд»ҚеҸҜиғҪжңүе№»иҜ»й—®йўҳпјҲеҚіжҸ’е…Ҙж–°ж•°жҚ®ж—¶зҡ„并еҸ‘й—®йўҳпјүгҖӮ

- и§ЈйҮҠпјҡдёҺдёҚеҸҜйҮҚеӨҚиҜ»зҡ„еҢәеҲ«еңЁдәҺпјҢдёҚеҸҜйҮҚеӨҚиҜ»жҳҜй’ҲеҜ№е·ІеӯҳеңЁзҡ„и®°еҪ•зҡ„дҝ®ж”№пјҢиҖҢе№»иҜ»еҲҷжҳҜеӣ дёә并еҸ‘дәӢеҠЎжҸ’е…ҘжҲ–еҲ йҷӨдәҶж–°зҡ„и®°еҪ•пјҢд»ҺиҖҢеҪұе“ҚдәҶжҹҘиҜўз»“жһңйӣҶзҡ„жқЎзӣ®ж•°йҮҸжҲ–еҶ…е®№гҖӮеҜ№дёҖдёӘеҗҢдёҖдёӘListеңЁеҗҢдёҖдәӢзү©иҜ»еҸ–пјҢ第дёҖж¬ЎиҜ»еҲ°10дёӘпјҢ第дәҢж¬ЎиҜ»еҲ°11дёӘпјҢеӣ дёәдёӯй—ҙжҸ’е…ҘдәҶдёҖдёӘж•°жҚ®гҖӮ

Serializableпјҡ

- зү№жҖ§пјҡжңҖй«ҳзә§еҲ«зҡ„йҡ”зҰ»пјҢдәӢеҠЎд№Ӣй—ҙе®Ңе…Ёйҡ”зҰ»пјҢд»ҝдҪӣдәӢеҠЎжҳҜдёҖдёӘжҺҘдёҖдёӘйЎәеәҸжү§иЎҢзҡ„пјҢи§ЈеҶідәҶе№»иҜ»й—®йўҳгҖӮ

- дјҳзӮ№пјҡжҸҗдҫӣдәҶжңҖй«ҳзҡ„дәӢеҠЎдёҖиҮҙжҖ§гҖӮ

- зјәзӮ№пјҡ并еҸ‘жҖ§е·®пјҢе®№жҳ“дә§з”ҹжҖ§иғҪ瓶йўҲгҖӮ

SpringдёӯеҜ№еә”дҪҝз”Ё

@Transactional(isolation = Isolation.READ_UNCOMMITTED)@Transactional(isolation = Isolation.READ_COMMITTED)@Transactional(isolation = Isolation.REPEATABLE_READ)@Transactional(isolation = Isolation.SERIALIZABLE)

еҲҶеёғејҸзі»з»ҹе®һзҺ°

еҸҜиғҪжңүеӨҡдёӘж•°жҚ®еә“пјҢжӯӨж—¶TransactionпјҲTomecat / SpringпјүдјҡиҮӘеҠЁеҚҸи°ғеӨҡдёӘж•°жҚ®жәҗ

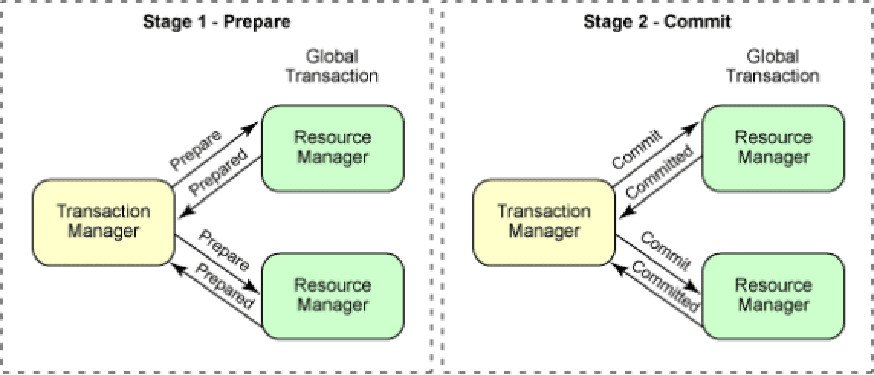

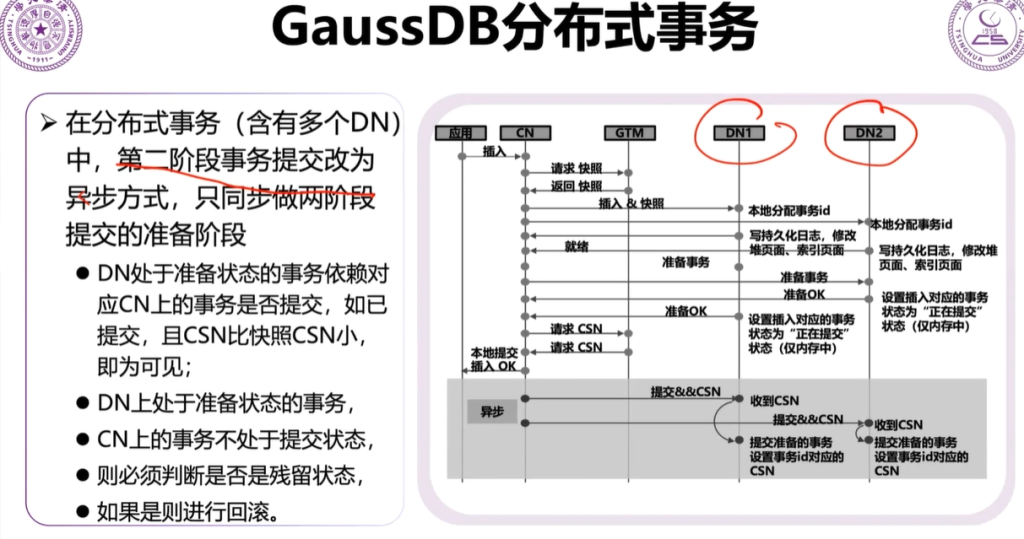

дёӨйҳ¶ж®өжҸҗдәӨ

第дёҖйҳ¶ж®өпјҡеә”з”ЁзЁӢеәҸпјҲUserпјүеҗ‘еҚҸи°ғиҖ…пјҲTransaction ManagerпјүеҸ‘йҖҒдёҖдёӘдәӢеҠЎиҜ·жұӮпјҢйҖҡзҹҘеҚҸи°ғиҖ…ејҖе§ӢдәӢеҠЎгҖӮеҚҸи°ғиҖ…еҗ‘жүҖжңүеҸӮдёҺиҖ…пјҲResource ManagerпјүпјҲеҸҜиғҪжҳҜеӨҡдёӘж•°жҚ®еә“гҖҒжңҚеҠЎзӯүпјүеҸ‘йҖҒдёҖдёӘвҖңеҮҶеӨҮжҸҗдәӨдәӢеҠЎвҖқзҡ„иҜ·жұӮпјҢиҜўй—®е®ғ们жҳҜеҗҰиғҪеӨҹжҲҗеҠҹжү§иЎҢдәӢеҠЎе№¶жҸҗдәӨз»“жһңгҖӮеҸӮдёҺиҖ…пјҲResource Managerпјүжү§иЎҢдәӢеҠЎе№¶еӣһеә”пјҲеҸӮдёҺиҖ…жү§иЎҢдәӢеҠЎпјҢдҪҶдёҚжҸҗдәӨпјҢиҖҢжҳҜе°ҶдәӢеҠЎж“ҚдҪңжҡӮж—¶дҝқеӯҳиө·жқҘпјҲдҫӢеҰӮй”ҒдҪҸзӣёе…іиө„жәҗпјүпјүгҖӮ

第дәҢйҳ¶ж®өпјҡжҸҗдәӨеүҚпјҢдёҖзҘЁеҗҰеҶіеҲ¶пјҢеҝ…йЎ»иҰҒйғҪеҸҜд»ҘжҸҗдәӨжүҚеҸҜд»ҘпјҢеҰӮжһңдёҖдёӘиҜҙеӣһж»ҡпјҢеҲҷйғҪйңҖиҰҒеӣһж»ҡпјӣжҺҘзқҖпјҢеҚҸи°ғиҖ…пјҲTransaction ManagerпјүеҸ‘йҖҒжҸҗдәӨжҲ–еӣһж»ҡиҜ·жұӮпјҢеҸӮдёҺиҖ…жү§иЎҢж“ҚдҪңпјҢжңҖеҗҺеҸӮдёҺиҖ…зЎ®и®Өз»“жһңгҖӮ

й—®йўҳпјҡеҸҜиғҪеӯҳеңЁж•°жҚ®дёҚдёҖиҮҙй—®йўҳпјҢеҰӮжһңеңЁжҸҗдәӨйҳ¶ж®өпјҢжңүеҸӮдёҺиҖ…жҸҗдәӨдәҶдәӢеҠЎпјҢдҪҶеҚҸи°ғиҖ…еҙ©жәғжҲ–жҹҗдәӣеҸӮдёҺиҖ…жІЎжңү收еҲ°жҸҗдәӨжҢҮд»ӨпјҢеҸҜиғҪеҜјиҮҙйғЁеҲҶжҸҗдәӨжҲҗеҠҹпјҢйғЁеҲҶжІЎжңүжҸҗдәӨпјҢеҮәзҺ°ж•°жҚ®дёҚдёҖиҮҙзҡ„жғ…еҶөпјҲйҖҡеёёйҖҡиҝҮдёүйҳ¶ж®өжҸҗдәӨеҚҸи®®зӯүж–№ејҸжқҘи§ЈеҶіпјүгҖӮ

зҰ»зәҝй”ҒпјҡжүҖи°“вҖңзҰ»зәҝвҖқжҢҮзҡ„жҳҜflushд№ӢеүҚпјҢж•°жҚ®иҜ»еҮәжқҘд№ӢеҗҺпјҢж”ҫеңЁдәҶtomcatзҡ„еҶ…еӯҳйҮҢпјӣиҝҷдёӘж—¶еҖҷжҳҜзҰ»зәҝзҡ„пјӣжүҖи°“вҖңеңЁзәҝвҖқпјҢе°ұжҳҜиҝҷдёӘеҜ№иұЎе®һж—¶еҸҚжҳ дәҶж•°жҚ®еә“зҡ„ж•°жҚ®пјӣдҪҶжҳҫ然ORжҳ е°„/JDBCйғҪжҳҜзҰ»зәҝзҡ„гҖӮ

жӮІи§ӮзҰ»зәҝй”Ғ

е®ҡд№үпјҡжӮІи§Ӯй”ҒеҒҮе®ҡеңЁе№¶еҸ‘ж“ҚдҪңж—¶пјҢдјҡз»ҸеёёеҸ‘з”ҹж•°жҚ®еҶІзӘҒпјҢеӣ жӯӨжҜҸж¬ЎиҜ»еҸ–жҲ–дҝ®ж”№ж•°жҚ®ж—¶пјҢйғҪзӣҙжҺҘй”Ғе®ҡиө„жәҗпјҢдҪҝеҫ—е…¶д»–дәӢеҠЎдёҚиғҪеҗҢж—¶еҜ№е…¶иҝӣиЎҢж“ҚдҪңгҖӮд№ҹе°ұжҳҜиҜҙпјҢе®ғвҖңжӮІи§ӮвҖқең°и®ӨдёәдјҡеҸ‘з”ҹеҶІзӘҒпјҢжүҖд»ҘеңЁи®ҝй—®иө„жәҗж—¶дјҡе…ҲиҺ·еҸ–й”ҒпјҢзЎ®дҝқеҪ“еүҚдәӢеҠЎзӢ¬еҚ иө„жәҗгҖӮ

- еҪ“дёҖдёӘдәӢеҠЎиҰҒж“ҚдҪңжҹҗжқЎи®°еҪ•ж—¶пјҢе®ғдјҡеҜ№иҜҘи®°еҪ•еҠ й”ҒгҖӮе…¶д»–дәӢеҠЎжғіиҰҒж“ҚдҪңиҜҘи®°еҪ•ж—¶пјҢеҝ…йЎ»зӯүеҫ…иҜҘй”ҒйҮҠж”ҫгҖӮ

- е…ёеһӢеңәжҷҜдёӢпјҢжӮІи§Ӯй”ҒйҖҡеёёйҖҡиҝҮж•°жҚ®еә“зҡ„й”ҒжңәеҲ¶пјҲдҫӢеҰӮиЎЁй”ҒжҲ–иЎҢй”Ғпјүе®һзҺ°гҖӮ

- еңЁеҶІзӘҒиҫғеӨҡгҖҒ并еҸ‘дҝ®ж”№иҫғеӨҡзҡ„еңәжҷҜдёӢпјҢеҰӮйҮ‘иһҚдәӨжҳ“гҖҒеә“еӯҳз®ЎзҗҶзӯүпјҢеҸҜд»ҘзЎ®дҝқж•°жҚ®зҡ„е®үе…Ёе’ҢдёҖиҮҙжҖ§гҖӮ

д№җи§ӮзҰ»зәҝй”Ғ

е®ҡд№үпјҡ д№җи§Ӯй”ҒеҒҮи®ҫеңЁеӨ§еӨҡж•°жғ…еҶөдёӢпјҢеӨҡдёӘдәӢеҠЎе№¶еҸ‘ж“ҚдҪңж—¶дёҚдјҡеҸ‘з”ҹеҶІзӘҒпјҢеӣ жӯӨеңЁжү§иЎҢж“ҚдҪң时并дёҚдјҡеҜ№иө„жәҗеҠ й”ҒгҖӮеҪ“дәӢеҠЎеңЁжҸҗдәӨдҝ®ж”№ж—¶пјҢзі»з»ҹдјҡйҖҡиҝҮдёҖдәӣж–№ејҸпјҲеҰӮзүҲжң¬еҸ·жҲ–ж—¶й—ҙжҲіпјүжқҘжЈҖжҹҘеңЁжӯӨжңҹй—ҙжҳҜеҗҰжңүе…¶д»–дәӢеҠЎеҜ№ж•°жҚ®иҝӣиЎҢдәҶдҝ®ж”№гҖӮеҰӮжһңеҸ‘зҺ°еҶІзӘҒпјҢеҲҷжӢ’з»қжҸҗдәӨпјҢдәӢеҠЎеҝ…йЎ»йҮҚж–°е°қиҜ•ж“ҚдҪңгҖӮиҝҷз§Қж–№ејҸвҖңд№җи§ӮвҖқең°и®ӨдёәеҶІзӘҒдёҚдјҡз»ҸеёёеҸ‘з”ҹгҖӮ

- д№җи§Ӯй”ҒдёҚдҫқиө–ж•°жҚ®еә“зҡ„зү©зҗҶй”ҒжңәеҲ¶пјҢиҖҢжҳҜйҖҡиҝҮзүҲжң¬еҸ·пјҲжҲ–ж—¶й—ҙжҲіпјүжңәеҲ¶жқҘжҺ§еҲ¶гҖӮ

- жҜҸж¬ЎиҜ»еҸ–и®°еҪ•ж—¶пјҢиҜ»еҸ–иҜҘи®°еҪ•зҡ„зүҲжң¬еҸ·гҖӮ

- еҪ“иҝӣиЎҢжӣҙж–°ж“ҚдҪңж—¶пјҢдјҡжЈҖжҹҘи®°еҪ•зҡ„еҪ“еүҚзүҲжң¬еҸ·жҳҜеҗҰдёҺиҜ»еҸ–ж—¶дёҖиҮҙгҖӮеҰӮжһңдёҖиҮҙпјҢеҲҷжӣҙж–°жҲҗеҠҹпјӣеҰӮжһңзүҲжң¬еҸ·дёҚдёҖиҮҙпјҢиҜҙжҳҺеңЁжӯӨжңҹй—ҙе…¶д»–дәӢеҠЎдҝ®ж”№дәҶиҜҘи®°еҪ•пјҢеҪ“еүҚдәӢеҠЎеӨұиҙҘпјҢйңҖиҰҒйҮҚж–°е°қиҜ•гҖӮ

- йҖӮеҗҲдәҺиҜ»еӨҡеҶҷе°‘зҡ„еә”з”ЁеңәжҷҜпјҢеҰӮжҠҘиЎЁжҹҘиҜўгҖҒз”ЁжҲ·жҹҘзңӢж•°жҚ®зӯүж“ҚдҪңгҖӮеӣ дёәеңЁиҝҷз§ҚеңәжҷҜдёӢпјҢж•°жҚ®еҶІзӘҒзҡ„еҸҜиғҪжҖ§иҫғе°ҸпјҢд№җи§Ӯй”ҒеҸҜд»Ҙжңүж•ҲжҸҗеҚҮжҖ§иғҪгҖӮ

дёӨз§Қй”Ғз®ҖеҚ•еҜ№жҜ”жҖ»з»“

| зү№жҖ§ | зІ—зІ’еәҰй”Ғ | з»ҶзІ’еәҰй”Ғ |

|---|---|---|

| й”Ғе®ҡиҢғеӣҙ | й”Ғе®ҡиҫғеӨ§иҢғеӣҙзҡ„иө„жәҗпјҲеҰӮж•ҙеј иЎЁгҖҒж•ҙдёӘйӣҶеҗҲпјү | й”Ғе®ҡиҫғе°Ҹзҡ„иө„жәҗеҚ•е…ғпјҲеҰӮжҹҗиЎҢгҖҒжҹҗдёӘеҜ№иұЎпјү |

| 并еҸ‘жҖ§иғҪ | иҫғе·®пјҢе®№жҳ“еҜјиҮҙй”Ғз«һдәү | 并еҸ‘жҖ§иҫғеҘҪпјҢиө„жәҗеҶІзӘҒиҫғе°‘ |

| еӨҚжқӮеәҰ | з®ҖеҚ•пјҢй”Ғз®ЎзҗҶиҫғе°‘пјҢйҒҝе…ҚиҝҮеӨҡзҡ„й”ҒиҜ·жұӮ | еӨҚжқӮпјҢйңҖиҰҒз®ЎзҗҶжӣҙеӨҡзҡ„й”Ғ |

| йҖӮз”ЁеңәжҷҜ | 并еҸ‘иҫғдҪҺгҖҒж“ҚдҪңиҢғеӣҙиҫғеӨ§гҖҒжү№йҮҸж“ҚдҪң | 并еҸ‘иҫғй«ҳгҖҒиө„жәҗз»ҶеҲҶгҖҒйңҖиҰҒзІҫзЎ®жҺ§еҲ¶жҜҸдёӘж“ҚдҪңзҡ„й”Ғе®ҡ |

| й”ҒејҖй”Җ | иҫғе°ҸпјҢй”Ғз®ЎзҗҶејҖй”ҖиҫғдҪҺ | иҫғеӨ§пјҢй”Ғзҡ„з®ЎзҗҶе’Ңз»ҙжҠӨејҖй”Җжӣҙй«ҳ |

| жӯ»й”ҒйЈҺйҷ© | жӯ»й”ҒйЈҺйҷ©иҫғе°Ҹ | жӯ»й”ҒйЈҺйҷ©иҫғеӨ§ |

зІ—зІ’еәҰй”ҒпјҲCoarse-Grained Lockingпјү

жҢҮзҡ„жҳҜй”Ғе®ҡиҫғеӨ§иҢғеӣҙзҡ„иө„жәҗжҲ–ж•°жҚ®еҚ•е…ғпјҢд»ҘжҺ§еҲ¶е№¶еҸ‘и®ҝй—®гҖӮжҜ”еҰӮиҜҙжҲ‘дёҖеј иЎЁиҝҳжҺ§еҲ¶е…¶е®ғиЎЁпјҲеӨ–й”®е…іиҒ”пјүпјҢйңҖиҰҒеҜ№ж•ҙдёӘиЎЁиҝӣиЎҢжҺ§еҲ¶гҖӮе®һзҺ°еҺҹзҗҶпјҡдёӨз»„ж•°жҚ®йҖҡиҝҮеј•з”Ёе…ұдә«еҗҢдёҖдёӘзүҲжң¬еҸ·з ҒпјҢйҖҡиҝҮеј•з”Ёзҡ„ж–№жі•пјҢдёӨдёӘж•°жҚ®еј•з”Ёзҡ„ жҳҜеҗҢдёҖдёӘзүҲжң¬еҸ·з ҒпјҲжүҖи°“зҡ„зүҲжң¬еҸ·дёҚжҳҜдёҖдёӘж•°еӯ—пјҢиҖҢжҳҜдёҖдёӘеҜ№иұЎпјҢиҝҷдёӘеҜ№иұЎйҮҢйқўжңүдёҖдёӘж•°еӯ—еұһжҖ§пјҢ иҝҷдёӘж•°еӯ—е°ұжҳҜзүҲжң¬еҸ·з ҒпјүгҖӮ

第дә”з«

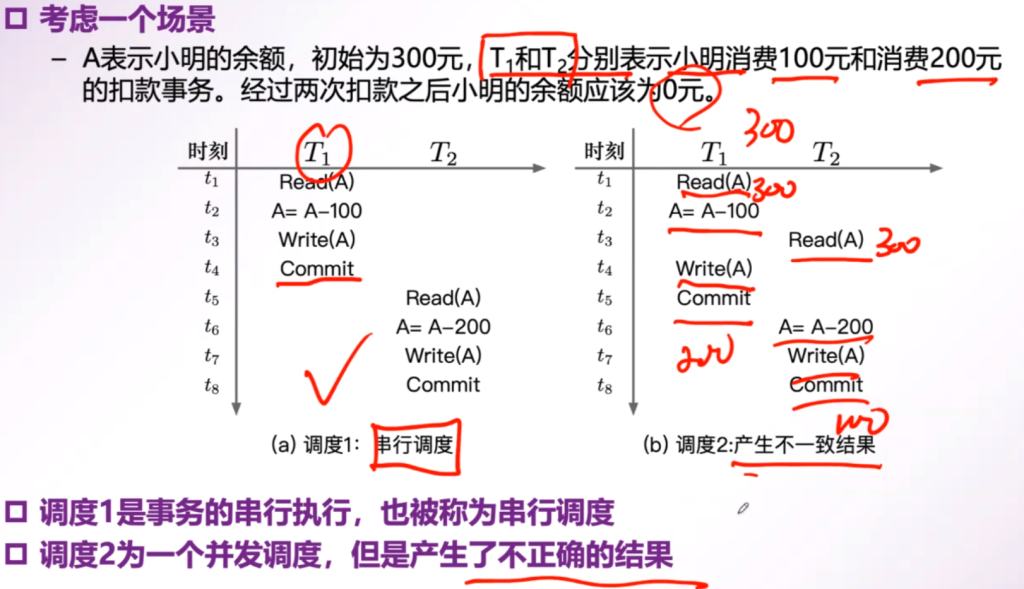

и°ғеәҰ

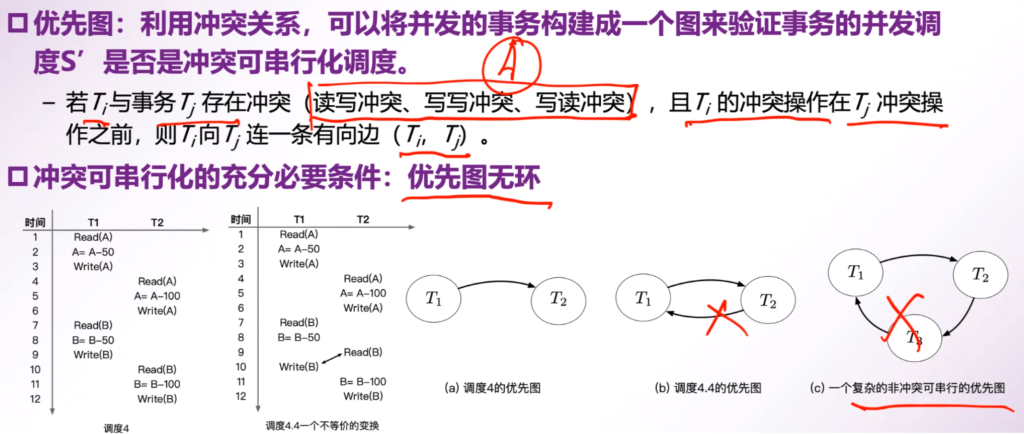

дҪңз”Ёпјҡи°ғеәҰдёәдәӢзү©зҡ„并еҸ‘еӨ„зҗҶиҝҮзЁӢдёӯпјҢеҶіе®ҡдәӢзү©дёӯжҜҸдёҖдёӘж“ҚдҪңзҡ„жү§иЎҢйЎәеәҸпјҢд»ҘжӯӨжқҘжҸҗй«ҳ并иЎҢж•ҲзҺҮгҖӮ

дёІиЎҢи°ғеәҰ

е®ҡд№үпјҡдәӢзү©дёІиЎҢжү§иЎҢ

еҸҜдёІиЎҢеҢ–и°ғеәҰ

з»ҷе®ҡдёҖдёӘ并еҸ‘и°ғеәҰSпјҢеӯҳеңЁдёҖдёӘдёІиЎҢи°ғеәҰSвҖҷпјҢеңЁд»»дҪ•ж•°жҚ®еә“зҠ¶жҖҒдёӢпјҢжҢүз…§и°ғеәҰSе’Ңи°ғеәҰS’жү§иЎҢеҗҺжүҖдә§з”ҹзҡ„з»“жһңйғҪжҳҜзӣёеҗҢзҡ„жӯӨж—¶и°ғеәҰSиў«з§°д№Ӣдёә еҸҜдёІиЎҢеҢ–и°ғеәҰ (serializable schedule)гҖӮ

еҸҜдёІиЎҢеҢ–и°ғеәҰзҡ„ж•°йҮҸеҚҒеҲҶе·ЁеӨ§пјҢдё”йҡҫд»Ҙж ЎйӘҢпјҢж•°жҚ®еә“дёӯдёҖиҲ¬йҖҡиҝҮжүҫеҲ°еҸҜдёІиЎҢеҢ–и°ғеәҰзҡ„еӯҗйӣҶ(е……еҲҶжқЎд»¶)пјҢеҚіжүҫеҲ°иғҪеӨҹжҸҗеүҚзЎ®и®ӨжҳҜеҸҜдёІиЎҢи°ғеәҰзҡ„并еҸ‘и°ғеәҰпјҲйғЁеҲҶи§ЈпјүпјҢиҝӣиҖҢжҸҗеҚҮи°ғеәҰж•ҲзҺҮгҖӮ

зӯүд»·ж“ҚдҪң

- дәӨжҚўиҝһз»ӯдёӨдёӘзӣёеҗҢж•°жҚ®иҜ»еҸ–ж“ҚдҪң

- дәӨжҚўиҝһз»ӯдёӨдёӘдёҚеҗҢж•°жҚ®иҜ»еҶҷж“ҚдҪң

йқһзӯүд»·ж“ҚдҪң

- дәӨжҚўиҝһз»ӯдёӨдёӘзӣёеҗҢж•°жҚ®зҡ„иҜ»еҶҷпјҢеҶҷеҶҷж“ҚдҪң

еҶІзӘҒеҸҜдёІиЎҢеҢ–и°ғеәҰзҡ„йӘҢиҜҒ

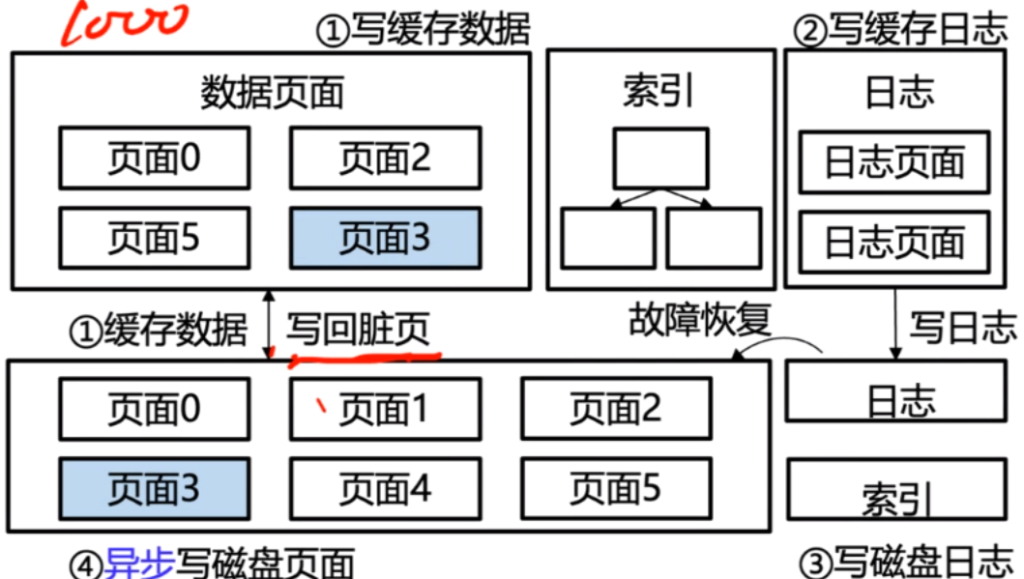

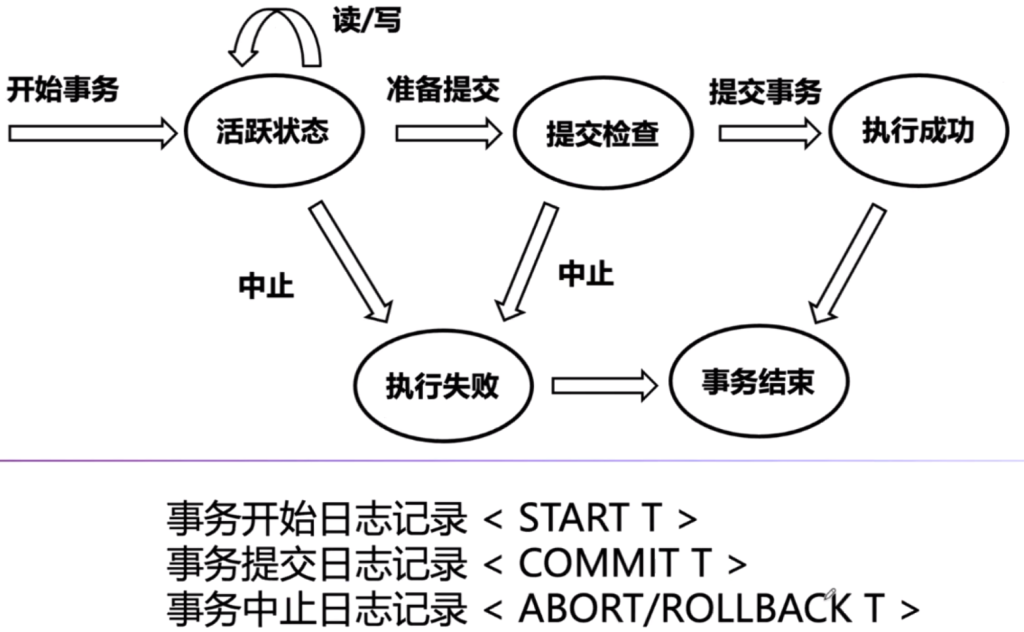

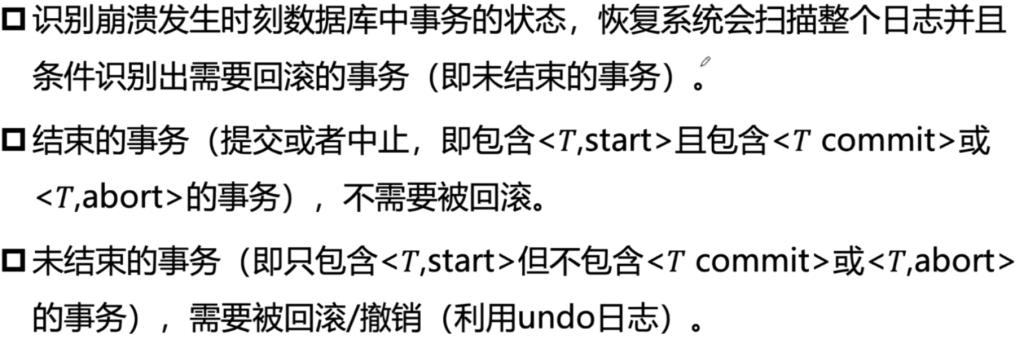

ж•°жҚ®еә“еҺҹеӯҗжҖ§е’ҢжҢҒд№…жҖ§е®һзҺ°

ж•…йҡңзі»з»ҹйҮҚеҗҜеҗҺпјҢеҶ…еӯҳж•°жҚ®дёўеӨұпјҢзЈҒзӣҳж•°жҚ®дёҚдёўеӨұ

еҺҹеӯҗжҖ§пјҲдәӢзү©иҝҗиЎҢдёӯпјү

- дәӢзү©иҝҗиЎҢжңҹй—ҙдёҚеҲ·зӣҳпјҢж•…йҡңзі»з»ҹйҮҚеҗҜеҗҺиҮӘеҠЁдҝқиҜҒеҺҹеӯҗжҖ§

- еӣ дёәж•ҙдёӘдәӢзү©иҝҳжІЎжңүиҝӣе…ҘзЎ¬зӣҳпјҢе°ұеҸҜд»ҘеҪ“жІЎжңүеӨ„зҗҶиҝҮиҝҷдёӘдәӢзү©пјҢзі»з»ҹйҮҚеҗҜеҗҺйҮҚж–°жү§иЎҢд»»еҠЎеҲҷе®№жҳ“дҝқжҢҒе…¶еҺҹеӯҗжҖ§

- еҚ з”ЁеҶ…еӯҳе®№жҳ“еҫҲеӨ§

- дәӢзү©иҝҗиЎҢжңҹй—ҙеҲ·зӣҳпјҢж•…йҡңзі»з»ҹйҮҚеҗҜйңҖиҰҒеӣһж»ҡдәӢеҠЎ

- йқўеҜ№йҮҚеҗҜжҜ”иҫғйә»зғҰпјҢиҖғиҷ‘еӣһж»ҡпјҲundoпјү

жҢҒд№…жҖ§пјҲдәӢзү©е·Із»Ҹе®ҢжҲҗпјү

- дәӢзү©е®ҢжҲҗж—¶еҲ·зӣҳпјҢж•…йҡңзі»з»ҹйҮҚеҗҜеҗҺиҮӘеҠЁдҝқиҜҒжҢҒд№…жҖ§

- дәӢзү©е®ҢжҲҗж—¶дёҚеҲ·зӣҳпјҢж•…йҡңзі»з»ҹйҮҚеҗҜеҗҺйңҖиҰҒйҮҚеҒҡиҜҘдәӢзү©(redo)

ж•°жҚ®еә“жҒўеӨҚеҹәжң¬еҺҹзҗҶ

- ж— ж•…йҡңдәӢеҠЎеӣһж»ҡ(дҫӢеҰӮиҙҰжҲ·е°ҸдәҺ0)пјҡеҪұе“ҚеҺҹеӯҗжҖ§пјҢж’Өй”ҖиҜҘдәӢеҠЎе·ІеҒҡж“ҚдҪң

- ж•…йҡңеӨұиҜҜеӣһж»ҡ(дҫӢеҰӮжӯ»й”ҒжқҖжӯ»дәӢеҠЎ)пјҡеҪұе“ҚеҺҹеӯҗжҖ§пјҢж’Өй”ҖиҜҘдәӢеҠЎе·ІеҒҡж“ҚдҪң

- зі»з»ҹж•…йҡң(дҫӢеҰӮйҮҚеҗҜ):еҶ…еӯҳж•°жҚ®дёўеӨұпјҢеҪұе“ҚеҺҹеӯҗжҖ§е’ҢжҢҒд№…жҖ§

- еҺҹеӯҗжҖ§пјҡж’Өй”ҖжңӘз»“жқҹ(дёҚеёҰCommitгҖҒAbortж Үи®°)зҡ„дәӢеҠЎ

- жҢҒд№…жҖ§пјҡйҮҚеҒҡе·Із»Ҹз»“жқҹ(еёҰCommitжҲ–Abortж Үи®°)зҡ„дәӢеҠЎ

- зі»з»ҹеҙ©жәғдёҚиғҪйҮҚеҗҜпјҡдёҚиғҪжҸҗдҫӣжңҚеҠЎпјҢеҪұе“ҚжҢҒд№…жҖ§

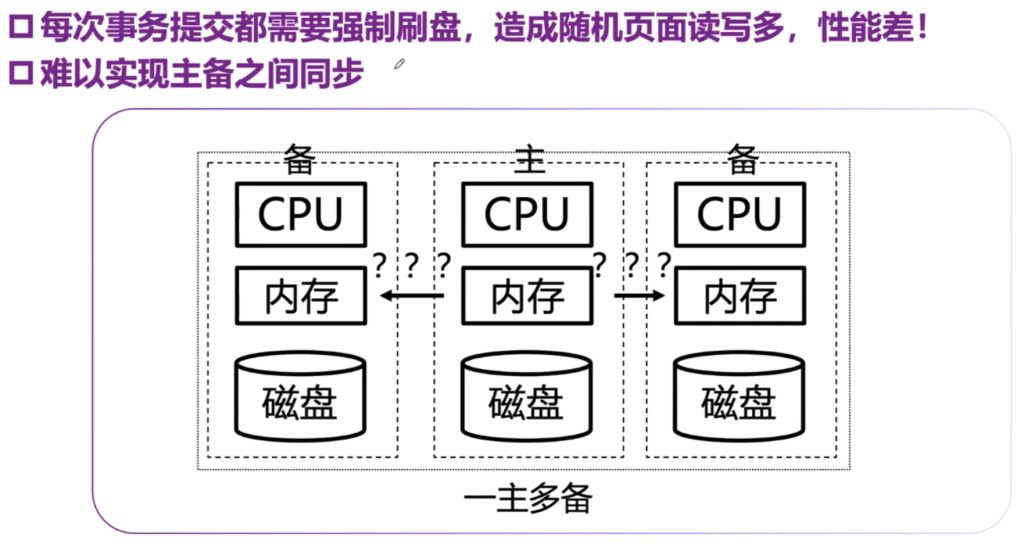

- дёҖдё»еӨҡеӨҮпјҡдё»еӨҮд№Ӣй—ҙйҖҡиҝҮж—Ҙеҝ—дҝқжҢҒдёҖиҮҙжҖ§пјҢеҸ‘з”ҹж•…йҡңеҗҺеҲҮжҚўеҲ°е…¶д»–зі»з»ҹ

- зЈҒзӣҳж•…йҡң:зЈҒзӣҳж•°жҚ®дёўеӨұпјҢеҪұе“ҚжҢҒд№…жҖ§

- зЈҒзӣҳж•°жҚ®еӨҡеүҜжң¬;ж•°жҚ®еӨҮд»ҪжңәеҲ¶:еҲӣе»әж•°жҚ®еӨҮд»ҪгҖҒж—Ҙеҝ—еӨҮд»Ҫ

- иҮӘ然зҒҫе®і:зі»з»ҹе®•жңәдёҚиғҪйҮҚеҗҜпјҢеҪұе“ҚжҢҒд№…жҖ§

- ејӮең°еӨҡжңәе®№зҒҫпјҡеӨҡжңәе®һж—¶дј иҫ“ж—Ҙеҝ—дҝқиҜҒдёҖиҮҙжҖ§пјҢеҸ‘з”ҹж•…йҡңеҗҺеҲҮжҚўеҲ°е…¶д»–зі»з»ҹ

й«ҳеҸҜз”ЁжҖ§жҢҮж Ү

йҖҡз”Ёй«ҳеҸҜз”ЁжҢҮж Ү:

- е№іеқҮж•…йҡңй—ҙйҡ”ж—¶й—ҙ MTBF(Mean Time between Failures):зі»з»ҹеңЁдёӨзӣёйӮ»ж•…йҡңй—ҙйҡ”жңҹеҶ…жӯЈзЎ®е·ҘдҪңзҡ„е№іеқҮж—¶й—ҙ

- е№іеқҮжҒўеӨҚж—¶й—ҙ MTTR(Mean Time to Repair):зі»з»ҹе№іеқҮд»Һж•…йҡңдёӯжҒўеӨҚйңҖиҰҒзҡ„ж—¶й—ҙ

- е№іеқҮжҚҹеқҸж—¶й—ҙ MTTF(Mean Time to Failure):зі»з»ҹеҮәзҺ°жҚҹеқҸзҡ„е№іеқҮж—¶й—ҙгҖӮ

ж•°жҚ®еә“е®№зҒҫжҢҮж Ү:

- жҒўеӨҚзӮ№зӣ®ж Ү RPO(Recovery Point Objective):дёҡеҠЎзі»з»ҹеңЁзі»з»ҹж•…йҡңеҗҺжүҖиғҪе®№еҝҚзҡ„ж•°жҚ®дёўеӨұйҮҸгҖӮ

- жҒўеӨҚж—¶й—ҙзӣ®ж Ү RTO(Recovery Time Objective):дёҡеҠЎзі»з»ҹжүҖиғҪе®№еҝҚзҡ„дёҡеҠЎеҒңжӯўжңҚеҠЎзҡ„жңҖй•ҝж—¶й—ҙгҖӮ

- дёҖиҲ¬з”ЁnдёӘ9жқҘиЎЁзӨә

- дҫӢеҰӮеӣӣдёӘд№қ99.99%иЎЁзӨәдёҖе№ҙ99.99%ж—¶й—ҙеҸҜз”ЁпјҢеҚідёҚеҸҜз”Ёж—¶й—ҙдёә365*24*60*0.01%=52.56еҲҶй’ҹ

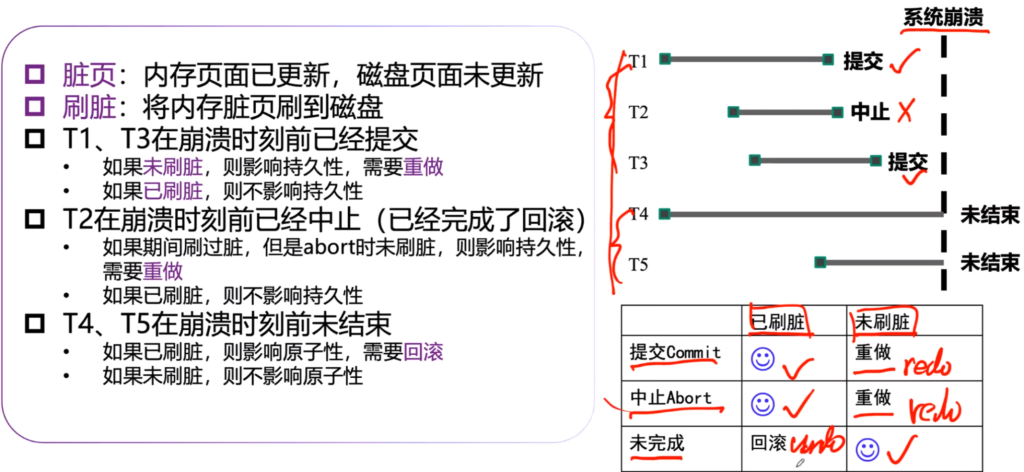

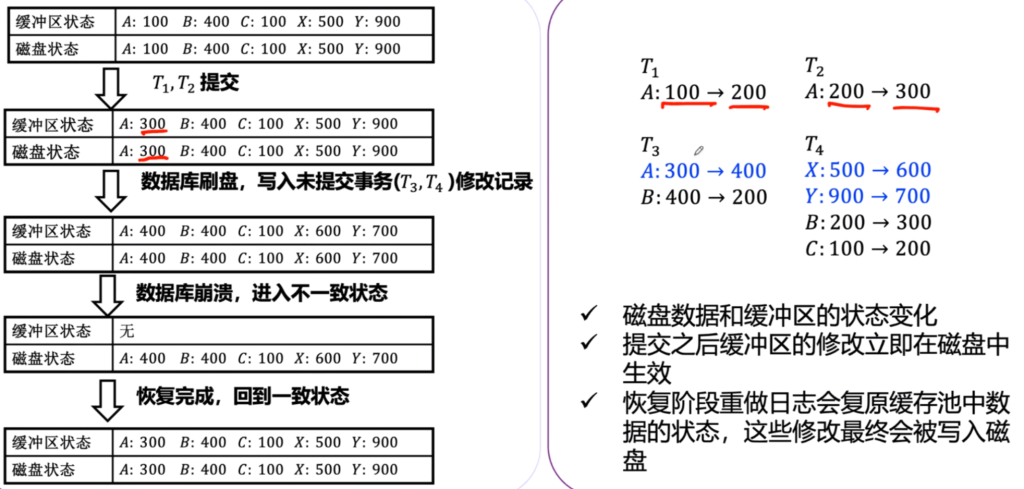

зі»з»ҹеҙ©жәғеӨ„зҗҶж–№ејҸ

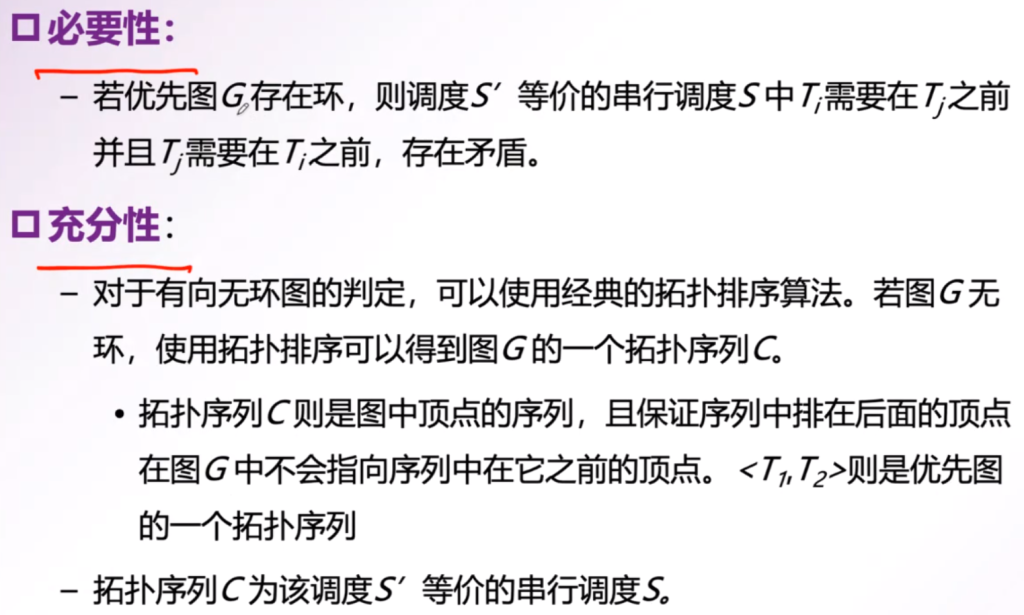

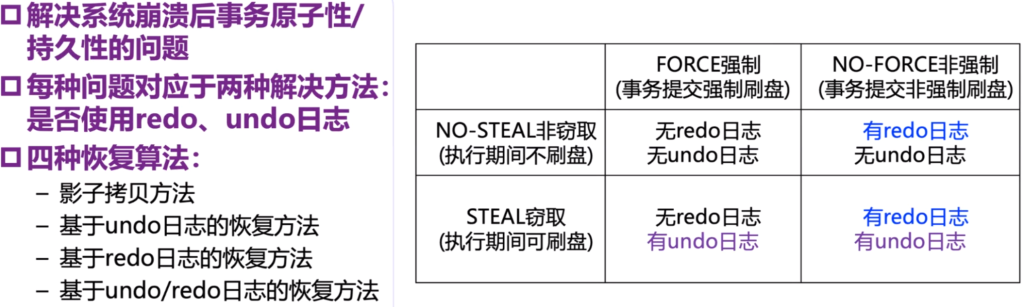

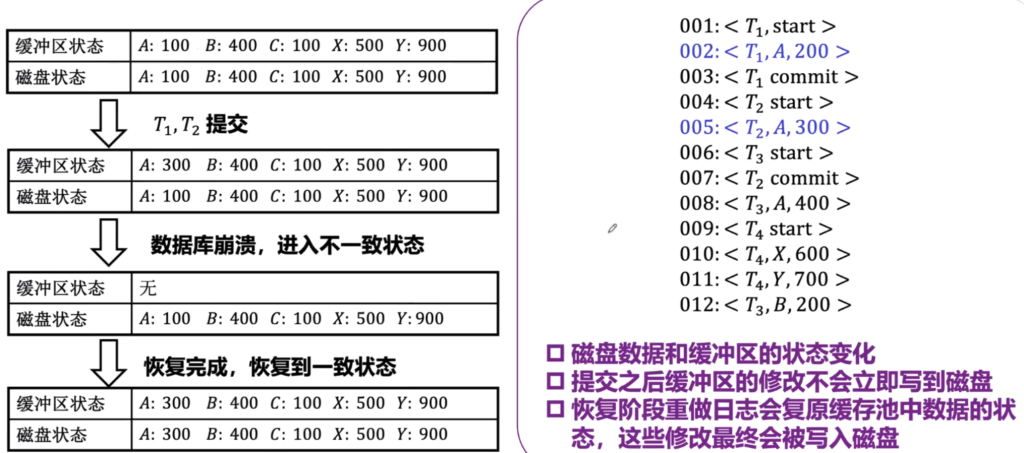

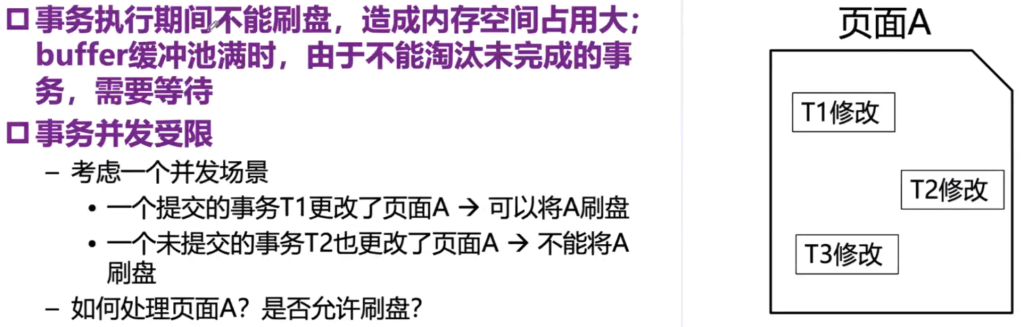

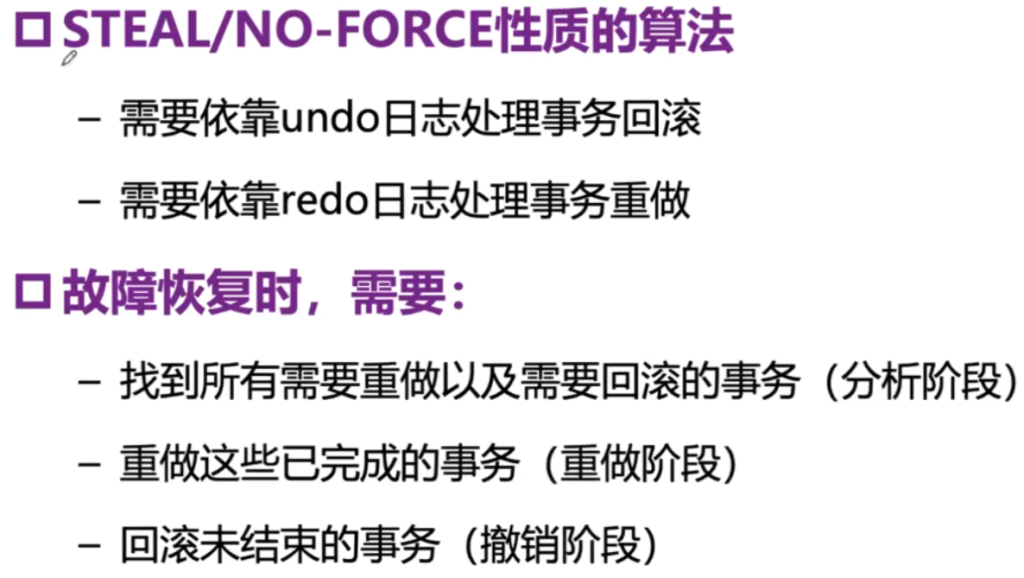

FORCEе’ҢNO-STEALж–№жЎҲйҖүжӢ©

| FORCE ејәеҲ¶ пјҲдәӢеҠЎжҸҗдәӨејәеҲ¶еҲ·зӣҳпјү | NO-FORCE ејәеҲ¶ пјҲдәӢеҠЎжҸҗдәӨдёҚејәеҲ¶еҲ·зӣҳпјү | |

| NO-STEALйқһзӘғеҸ– (жү§иЎҢжңҹй—ҙдёҚеҲ·зӣҳ) | ж— redoж—Ҙеҝ— | ж— undoж—Ҙеҝ— | жңүredoж—Ҙеҝ— | ж— undoж—Ҙеҝ— |

| STEALзӘғеҸ–(жү§иЎҢжңҹй—ҙеҸҜеҲ·зӣҳ) | ж— redoж—Ҙеҝ— | жңүundoж—Ҙеҝ— | жңүredoж—Ҙеҝ— | жңүundoж—Ҙеҝ— |

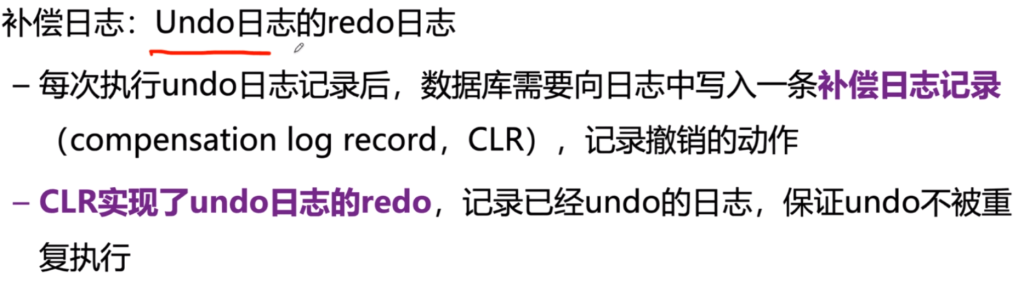

ж•°жҚ®еә“ж—Ҙеҝ—

- ж•°жҚ®еә“ж—Ҙеҝ—жҳҜж•°жҚ®еә“зі»з»ҹеҶ…дёҖзі»еҲ—жү§иЎҢдәӢ件зҡ„и®°еҪ•пјҢе®ғдёҺж•°жҚ®еә“дәӢеҠЎжҳҜеҜҶеҲҮзӣёе…ізҡ„пјҢдәӢеҠЎзҡ„жү§иЎҢиҝҮзЁӢдјҡеҸҚжҳ еңЁж—Ҙеҝ—дёӯпјҢж•°жҚ®еә“еҸҜд»ҘйҖҡиҝҮеҜ№ж—Ҙеҝ—зҡ„еҲҶжһҗе®һзҺ°еҜ№дәӢеҠЎзҡ„еӣһж»ҡ(еҺҹеӯҗжҖ§)жҲ–йҮҚеҒҡ(жҢҒд№…жҖ§)

- ж—Ҙеҝ—жҳҜж—Ҙеҝ—и®°еҪ•(log record)зҡ„еәҸеҲ—гҖӮж—Ҙеҝ—и®°еҪ•жҳҜж•°жҚ®еә“зі»з»ҹжҙ»еҠЁи®°еҪ•зҡ„жңҖе°ҸеҚ•дҪҚпјҢжҜҸдёҖжқЎи®°еҪ•еҸҚжҳ дәҶж•°жҚ®еә“зі»з»ҹзҡ„дёҖж¬Ўж“ҚдҪңгҖӮж—Ҙеҝ—и®°еҪ•дёҚд»…еҢ…еҗ«дәҶж•°жҚ®зҡ„жӣҙж–°пјҢиҝҳеҢ…еҗ«дәҶж•°жҚ®еә“дәӢеҠЎејҖе§Ӣ/з»“жқҹзҡ„йҖ»иҫ‘гҖӮ

- ж—Ҙеҝ—зҡ„еҶ…е®№еңЁеҶҷе…ҘзЈҒзӣҳд»ҘеҗҺжҳҜдёҚдјҡиў«дҝ®ж”№зҡ„пјҢеӣ жӯӨжүҖжңүзҡ„ж—Ҙеҝ—еҶ…е®№еҸҜд»ҘйЎәеәҸеҶҷе…ҘзЈҒзӣҳпјҢиҝҷдҝқиҜҒдәҶй«ҳж•Ҳзҡ„еҶҷе…ҘйҖҹеәҰгҖӮиҜҘзү№жҖ§д№ҹжҳҜе»әз«Ӣй«ҳеҸҜз”ЁжҒўеӨҚжңәеҲ¶зҡ„еүҚжҸҗеҚіж•°жҚ®зҡ„йҡҸжңәиҜ»еҶҷиҪ¬жҚўдёәж—Ҙеҝ—зҡ„иҝһз»ӯиҜ»еҶҷгҖӮ

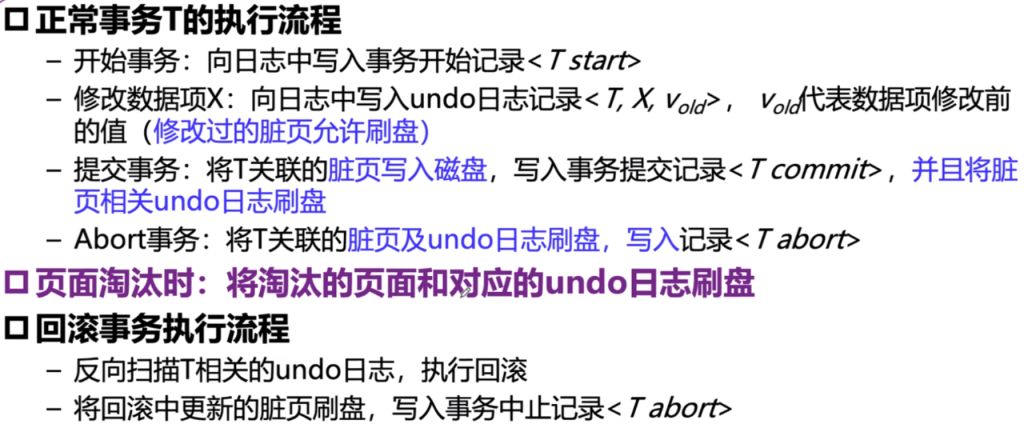

Undoеӣһж»ҡж—Ҙеҝ—

зү№зӮ№пјҡи®°еҪ•ж—§еҖј

- ж јејҸ < T , X , Vold >

- T : дәӢзү©е”ҜдёҖж ҮиҜҶз¬Ұ

- Xпјҡж•°жҚ®йЎ№

- Voldпјҡж•°жҚ®йЎ№дҝ®ж”№д»ҘеүҚзҡ„еҖј

- дә§з”ҹж—¶жңәпјҡеҪ“ж•°жҚ®Tдҝ®ж”№ж•°жҚ®йЎ№XпјҲWrite(X)пјүж—¶дә§з”ҹпјҢиҰҒеҜ№ж•°жҚ®ж“ҚдҪңж—¶еҖҷпјҢе…ҲеҶҷж—Ҙеҝ—пјҢж—Ҙеҝ—жҲҗеҠҹеҶҚж“ҚдҪңпјҢд№ҹеҸ«еҒҡ

WALпјҲWrite Ahead Logпјү - дҪңз”Ёпјҡе®һзҺ°дәӢзү©еӣһж»ҡ

- жіЁж„ҸпјҡдёҖиҲ¬иҝҳеҢ…жӢ¬дёҖдёӘж—Ҙеҝ—еәҸеҸ·log sequential number(LSN)пјҢдҫҝдәҺжӣҙеҝ«жүҫеҲ°дҪҚзҪ®

RedoйҮҚеҒҡж—Ҙеҝ—

- ж јејҸ < T , X , Vnew >

- T : дәӢзү©е”ҜдёҖж ҮиҜҶз¬Ұ

- Xпјҡж•°жҚ®йЎ№

- Vnewпјҡж•°жҚ®йЎ№дҝ®ж”№д»ҘеҗҺзҡ„еҖј

- дә§з”ҹж—¶жңәпјҡеҪ“ж•°жҚ®Tдҝ®ж”№ж•°жҚ®йЎ№XпјҲWrite(X)пјүж—¶дә§з”ҹпјҢеҗҢж ·д№ҹжҳҜ

WALпјҲWrite Ahead Logпјү - дҪңз”Ёпјҡе®һзҺ°дәӢзү©еӣһж»ҡ

- жіЁж„ҸпјҡдёҖиҲ¬иҝҳеҢ…жӢ¬дёҖдёӘж—Ҙеҝ—еәҸеҸ·log sequential number(LSN)пјҢдҫҝдәҺжӣҙеҝ«жүҫеҲ°дҪҚзҪ®

йҖ»иҫ‘ж—Ҙеҝ—

- и®°еҪ•дәӢеҠЎдёӯй«ҳеұӮжҠҪиұЎзҡ„йҖ»иҫ‘ж“ҚдҪң

- дёҫдҫӢпјҡи®°еҪ•ж—Ҙеҝ—дёӯUPDATEгҖҒDELETEе’ҢINSERTзҡ„ж–Үжң¬дҝЎжҒҜ

- дҫӢеҰӮе°ҸжҳҺзҡ„е№ҙйҫ„з”ұ20ж”№жҲҗ21гҖӮ

- еҘҪеӨ„пјҡж•°жҚ®еә“зүҲжң¬жӣҙж–°ж—¶еҖҷпјҢд№ҹе®№жҳ“жҒўеӨҚ

зү©зҗҶж—Ҙеҝ—

- и®°еҪ•ж•°жҚ®еә“е…·дҪ“зү©зҗҶеҸҳеҢ–

- дёҫдҫӢпјҡи®°еҪ•дёҖдёӘиў«жҹҘиҜўеҪұе“Қзҡ„ж•°жҚ®йЎ№еүҚеҗҺзҡ„еҖј

- дҫӢеҰӮ第10дёӘйЎөйқўз¬¬100еҒҸ移йҮҸзҡ„еҖјз”ұ20ж”№жҲҗ21гҖӮ

- еҘҪеӨ„пјҡ1. еҜ№дәҺInsertпјҢйҖ»иҫ‘ж—Ҙеҝ—дёҚиғҪжү§иЎҢ第дәҢж¬ЎпјҢиҖҢеҜ№дәҺзү©зҗҶж—Ҙеҝ—еҸҜд»ҘпјҲе№ӮзӯүжҖ§пјү 2. еҚ з”Ёе°Ҹ

зү©зҗҶйҖ»иҫ‘ж—Ҙеҝ—

- дёҖз§Қз»“еҗҲдәҶзү©зҗҶж—Ҙеҝ—е’ҢйҖ»иҫ‘ж—Ҙеҝ—ж··еҗҲж–№жі•

- ж—Ҙеҝ—и®°еҪ•дёӯеҢ…еҗ«дәҶж•°жҚ®йЎөйқўзҡ„зү©зҗҶдҝЎжҒҜпјҢдҪҶжҳҜйЎөйқўд»ҘеҶ…зӣ®ж Үж•°жҚ®йЎ№зҡ„дҝ®ж”№дҝЎжҒҜеҲҷжҳҜд»ҘйҖ»иҫ‘ж–№ејҸи®°еҪ•

- дҫӢеҰӮ第100дёӘйЎөйқў(зү©зҗҶ)зҡ„е°ҸжҳҺе№ҙйҫ„еҖјз”ұ20ж”№жҲҗ21(йҖ»иҫ‘)

ж•°жҚ®еә“ж—Ҙеҝ—жҖ§иҙЁ

- е№ӮзӯүжҖ§пјҡдёҖжқЎж—Ҙеҝ—и®°еҪ•ж— и®әжү§иЎҢдёҖж¬ЎжҲ–еӨҡж¬ЎпјҢеҫ—еҲ°зҡ„з»“жһңйғҪжҳҜдёҖиҮҙзҡ„гҖӮ

- дҫӢеҰӮ:x=x+1дёҚе№Ӯзӯүпјӣx=0е№Ӯзӯү

- зү©зҗҶж—Ҙеҝ—ж»Ўи¶іе№ӮзӯүжҖ§пјӣйҖ»иҫ‘ж—Ҙеҝ—дёҚж»Ўи¶і

- еӨұиҙҘеҸҜйҮҚеҒҡжҖ§пјҡдёҖжқЎж—Ҙеҝ—жү§иЎҢеӨұиҙҘеҗҺпјҢжҳҜеҗҰеҸҜдәәйҮҚеҒҡдёҖйҒҚиҫҫжҲҗжҒўеӨҚзӣ®зҡ„гҖӮ

- дҫӢеҰӮ:жҸ’е…ҘдёҖжқЎи®°еҪ•еӨұиҙҘпјҢеҶҚж¬ЎжҸ’е…ҘжҲҗеҠҹгҖӮ

- зү©зҗҶж—Ҙеҝ—ж»Ўи¶іеӨұиҙҘеҸҜйҮҚеҒҡжҖ§пјӣйҖ»иҫ‘ж—Ҙеҝ—дёҚж»Ўи¶іпјҡдҫӢеҰӮжҸ’е…Ҙж•°жҚ®йЎөйқўжҲҗеҠҹпјҢиҖҢжҸ’е…Ҙзҙўеј•еӨұиҙҘйҮҚеҒҡжҸ’е…ҘиҝҷдёӘйҖ»иҫ‘ж—Ҙеҝ—еӨұиҙҘгҖӮ

- ж“ҚдҪңеҸҜйҖҶжҖ§пјҡйҖҶеҗ‘жү§иЎҢж—Ҙеҝ—и®°еҪ•зҡ„ж“ҚдҪңпјҢеҸҜд»ҘеӨҚеҺҹжқҘзҠ¶жҖҒ(жңӘжү§иЎҢиҝҷжү№ж“ҚдҪңж—¶зҡ„зҠ¶жҖҒ)

- дҫӢеҰӮ第10дёӘйЎөйқўз¬¬100еҒҸ移йҮҸзҡ„еҖјз”ұ20ж”№жҲҗ21пјҢйҖҶж“ҚдҪңз”ұ21ж”№жҲҗ20

- зү©зҗҶж—Ҙеҝ—дёҚеҸҜйҖҶ(йЎөйқўеҒҸ移йҮҸдҪҚзҪ®еҸҜиғҪиў«еҗҺз»ӯи®°еҪ•дҝ®ж”№)пјҢйҖ»иҫ‘ж—Ҙеҝ—еҸҜйҖҶгҖӮ

йҖӮз”ЁжҖ§жҖ»з»“

| ж—Ҙеҝ—зұ»еһӢ | и§ЈжһҗйҖҹеәҰ | ж—Ҙеҝ—йҮҸ | еҸҜйҮҚеҒҡжҖ§ | е№ӮзӯүжҖ§ | еҸҜйҖҶжҖ§ | еә”з”ЁеңәжҷҜ |

|---|---|---|---|---|---|---|

| зү©зҗҶж—Ҙеҝ— | еҝ« | еӨ§ | жҳҜ | жҳҜ | еҗҰ | redoж—Ҙеҝ— |

| йҖ»иҫ‘ж—Ҙеҝ— | ж…ў | е°Ҹ | еҗҰ | еҗҰ | жҳҜ | undoж—Ҙеҝ— |

| зү©зҗҶйҖ»иҫ‘ж—Ҙеҝ— | иҫғеҝ« | дёӯ | жҳҜ | еҗҰ | еҗҰ | undoж—Ҙеҝ— |

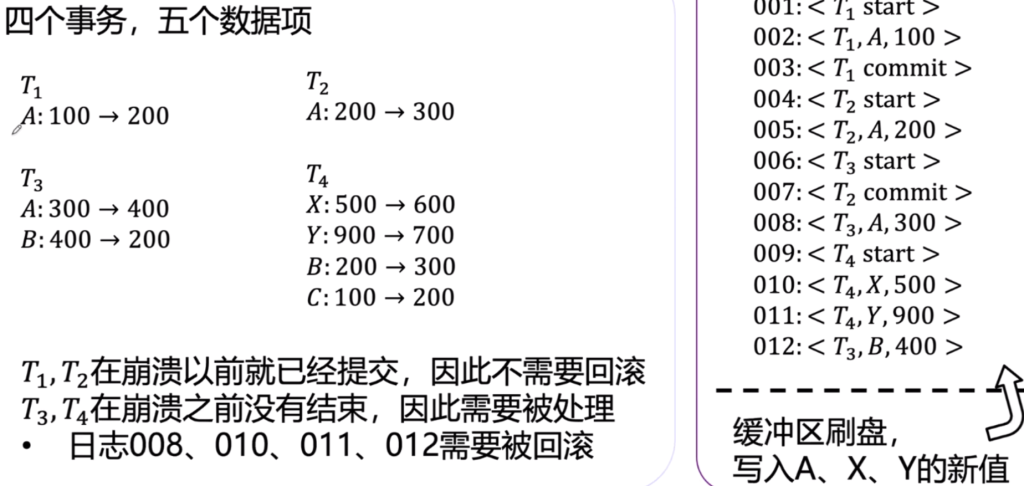

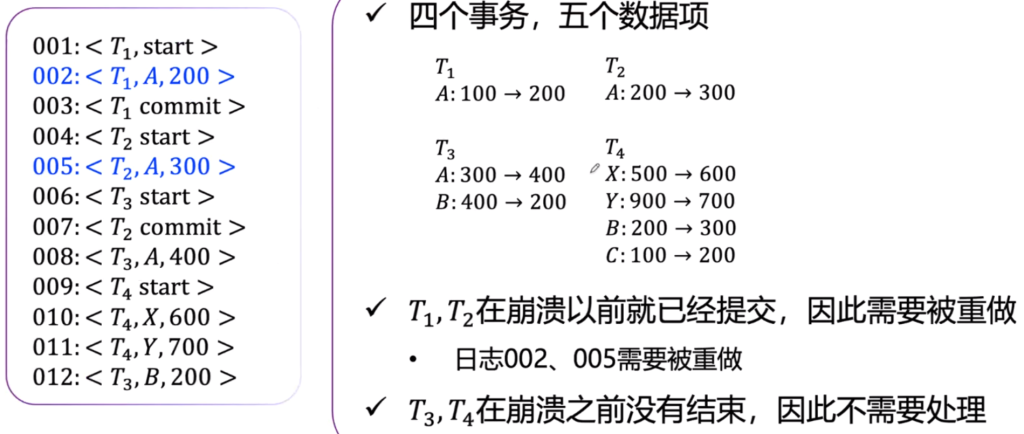

ж•°жҚ®еә“жҒўеӨҚз®—жі•жҰӮиҝ°

еҺҹеӯҗжҖ§дҝқиҜҒ

- NO-STEALпјҡжү§иЎҢжңҹй—ҙдёҚеҲ·зӣҳпјҢдёҚеӯҳеңЁеҺҹеӯҗжҖ§й—®йўҳ

- й—®йўҳпјҡеҪ“дәӢзү©еҫҲеӨ§ж—¶пјҢMemеҚ з”ЁиҝҮеӨ§

- STEALпјҡжү§иЎҢжңҹй—ҙеҲ·зӣҳ

- й—®йўҳпјҡеӯҳеңЁеҺҹеӯҗжҖ§й—®йўҳпјҢеҰӮдёҠеӣҫзҡ„T4еҰӮжһңдәӢеҠЎжү§иЎҢжңҹй—ҙеҲ·зӣҳдәҶпјҢжӯӨж—¶йңҖиҰҒundoеӣһж»ҡ

жҢҒд№…жҖ§дҝқиҜҒ

- FORCEпјҡдәӢеҠЎжҸҗдәӨеҗҺе°ұејәеҲ¶еҲ·зӣҳпјҢдёҚеӯҳеңЁжҢҒд№…жҖ§й—®йўҳ

- й—®йўҳпјҡж•°жҚ®еә“IOдәӨдә’йў‘з№ҒпјҢеҚ з”ЁIOиө„жәҗиҝҮеӨҡ

- NO-FORCEпјҡдәӢеҠЎжҸҗдәӨдёҚејәеҲ¶еҲ·зӣҳ

- й—®йўҳпјҡеӯҳеңЁжҢҒд№…жҖ§й—®йўҳпјҢеҰӮз§Ҝж”’дәҶеҫҲеӨҡе·Із»ҸжҸҗдәӨзҡ„дәӢзү©жІЎеҒҡпјҢжӯӨж—¶е°ұйңҖиҰҒredoйҮҚеҒҡ

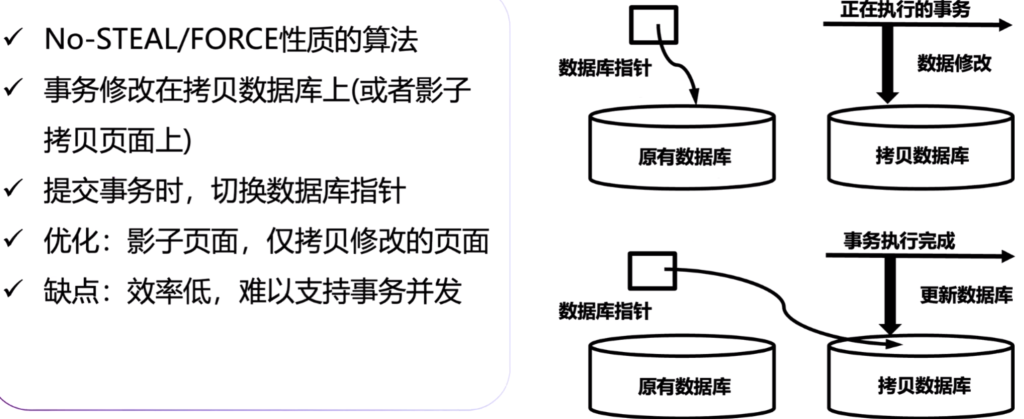

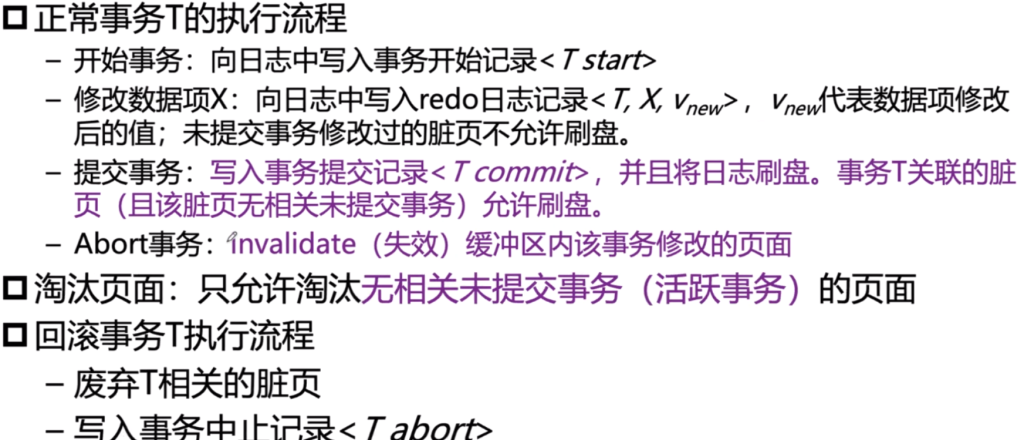

еҪұеӯҗжӢ·иҙқж–№жі•

еҺҹзҗҶпјҡдәӢзү©жү§иЎҢдёҚеҲ·зӣҳпјҢдәӢзү©дёҖжҸҗдәӨе°ұеҲ·зӣҳ

еҰӮжһңдәӢзү©AbortпјҢж•°жҚ®еә“жҢҮй’ҲдёҚеҸҳ

еҰӮжһңдәӢзү©жү§иЎҢе®ҢжҲҗпјҢж•°жҚ®еә“жҢҮй’Ҳе°ұеҲҮжҚўиҝҮжқҘ

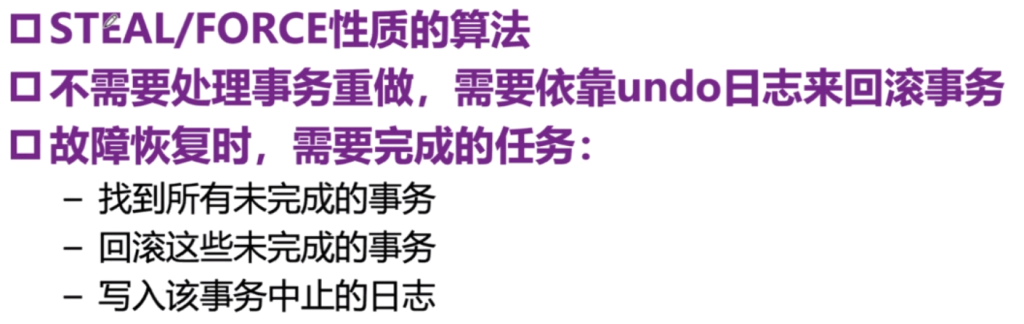

еҹәдәҺundoж—Ҙеҝ—зҡ„жҒўеӨҚж–№жі•

еҺҹзҗҶпјҡдәӢзү©жү§иЎҢжңҹй—ҙеҸҜд»ҘеҲ·зӣҳпјҲжҸҗдәӨйғЁеҲҶдәӢзү©пјүпјҢдё”дәӢзү©дёҖжҸҗдәӨе°ұеҲ·зӣҳ

жҒўеӨҚжөҒзЁӢ

дҫӢеӯҗ

й—®йўҳ

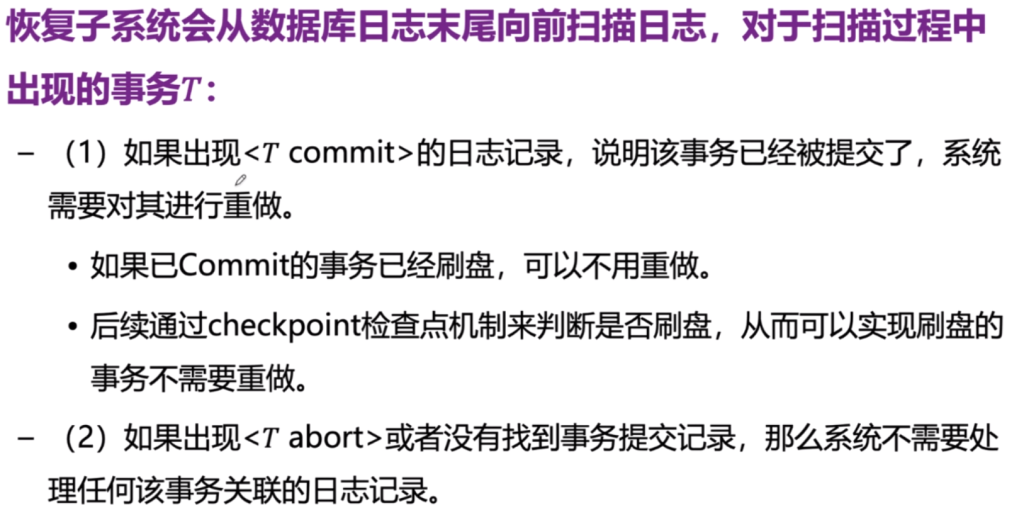

еҹәдәҺredoж—Ҙеҝ—зҡ„жҒўеӨҚж–№жі•

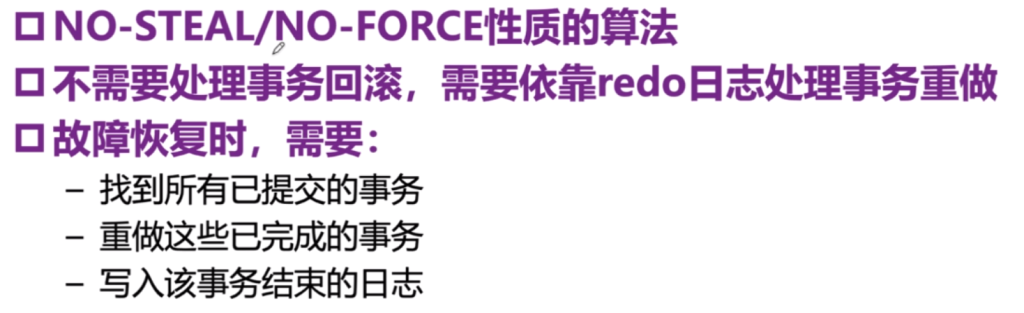

еҺҹзҗҶпјҡдәӢзү©жү§иЎҢдёҚеҲ·зӣҳпјҢжҸҗдәӨдәҶдәӢзү©еҸҜд»ҘдёҚеҲ·зӣҳгҖӮеӣ жӯӨеҜ№дәҺдёҖдәӣжІЎеҒҡзҡ„дәӢзү©redoжҒўеӨҚгҖӮ

й—®йўҳ

еҹәдәҺundo/redoж—Ҙеҝ—зҡ„жҒўеӨҚж–№жі•

еҺҹзҗҶпјҡдәӢзү©жү§иЎҢжңҹй—ҙеҲ·зӣҳпјҢдәӢзү©е®ҢжҲҗдёҚејәеҲ¶еҲ·зӣҳ

RedoжҳҜе№ӮзӯүжҖ§ж“ҚдҪңпјҢеӣ дёәredoжҳҜзү©зҗҶж—Ҙеҝ—пјҢе…·еӨҮзҡ„жҳҜе№ӮзӯүжҖ§пјҲи§ҒдёҠжңүд»Ӣз»Қпјү

иҖҢUndoдёҚжҳҜе№Ӯзӯүж“ҚдҪңпјҢеӣ дёәundoжҳҜйҖ»иҫ‘ж—Ҙеҝ—пјҢе…·еӨҮзҡ„жҳҜеҸҜйҖҶжҖ§

第е…ӯз«

Multithreading

еҹәжң¬зҹҘиҜҶ

иҝӣзЁӢ

иҝӣзЁӢжңүдёҖдёӘиҮӘеҢ…еҗ«зҡ„жү§иЎҢзҺҜеўғгҖӮиҝӣзЁӢйҖҡеёёе…·жңүдёҖз»„е®Ңж•ҙзҡ„гҖҒз§Ғжңүзҡ„еҹәжң¬иҝҗиЎҢж—¶иө„жәҗпјӣзү№еҲ«жҳҜпјҢжҜҸдёӘиҝӣзЁӢйғҪжңүиҮӘе·ұзҡ„еӯҳеӮЁз©әй—ҙгҖӮиҝӣзЁӢй—ҙйҖҡдҝЎпјҡRMI / HttpпјҢRMIйҖҡдҝЎж–№ејҸпјҡзұ»дјјдәҺServerе’ҢClientпјҢз”ЁSerializableпјҢжөҒзҡ„ж–№ејҸдј йҖ’

зәҝзЁӢ

зәҝзЁӢжңүж—¶иў«з§°дёәиҪ»йҮҸзә§иҝӣзЁӢгҖӮиҝӣзЁӢе’ҢзәҝзЁӢйғҪжҸҗдҫӣдәҶдёҖдёӘжү§иЎҢзҺҜеўғпјҢдҪҶеҲӣе»әж–°зәҝзЁӢжүҖйңҖзҡ„иө„жәҗжҜ”еҲӣе»әж–°иҝӣзЁӢе°‘гҖӮзәҝзЁӢеӯҳеңЁдәҺиҝӣзЁӢдёӯвҖ”вҖ”жҜҸдёӘиҝӣзЁӢиҮіе°‘жңүдёҖдёӘзәҝзЁӢгҖӮзәҝзЁӢе…ұдә«иҝӣзЁӢзҡ„иө„жәҗпјҢеҢ…жӢ¬еҶ…еӯҳе’Ңжү“ејҖзҡ„ж–Ү件гҖӮиҝҷжңүеҠ©дәҺй«ҳж•ҲдҪҶеҸҜиғҪеӯҳеңЁй—®йўҳзҡ„жІҹйҖҡгҖӮ

еӨҡзәҝзЁӢйҖҡдҝЎ

еҲӣе»әзәҝзЁӢ

ж–№жі•дёҖпјҡжүӢеҠЁеҲӣе»әдёҖдёӘзәҝзЁӢпјҢиҝҷдёӘзәҝзЁӢжү§иЎҢе®Ңе°ұз»“жқҹдәҶгҖӮпјҲдәәдёәзҡ„з®ЎзҗҶгҖҒжҺ§еҲ¶зәҝзЁӢпјү

- дёҖз§Қж–№жі•жҳҜ继жүҝThreadзұ»пјҲJavaжҳҜеҚ•ж №з»§жүҝпјҢе’ҢcppдёҚдёҖж ·пјҢжүҖд»Ҙиҝҷз§Қж–№жі•дёҚжҺЁиҚҗпјү

- дёҖз§Қж–№жі•жҳҜе®һзҺ°RunnableиҝҷдёӘжҺҘеҸЈпјҲжҺЁиҚҗдҪҝз”ЁиҝҷдёӘпјҢеӣ дёәJavaйҮҢйқўеҸӘиғҪ继жүҝдёҖдёӘзұ»пјҢдҪҶжҳҜе®һ зҺ°еҸҜд»Ҙе®һзҺ°еӨҡдёӘжҺҘеҸЈпјү

ж–№жі•дәҢпјҡйҖҡиҝҮзәҝзЁӢжұ пјҢеҰӮжһңжңүйңҖиҰҒиҺ·еҸ–зәҝзЁӢе°ұеңЁжұ еӯҗйҮҢйқўжүҫдёҖдёӘпјҢз”Ёе®Ңд№ӢеҗҺ收еӣһпјҢиҝҳжҳҜж”ҫеңЁеңЁзәҝзЁӢ жұ йҮҢйқўгҖӮиҠӮзәҰиө„жәҗпјҢеӣ дёәеҲӣе»әзәҝзЁӢзҡ„ж—¶еҖҷйңҖиҰҒж¶ҲиҖ—иө„жәҗгҖӮпјҲдёҚйңҖиҰҒиҖғиҷ‘зәҝзЁӢзҡ„з®ЎзҗҶпјҢзәҝзЁӢжҳҜж–°еҲӣе»ә зҡ„иҝҳжҳҜе·Іжңүзҡ„дҪҝз”ЁиҖ…дёҚйңҖиҰҒзҹҘйҒ“пјҢз”ұзәҝзЁӢжұ з®ЎзҗҶпјү

дёӯж–ӯдёҺеӯҳжҙ»еҮҪж•°

дёӯж–ӯдёҖдёӘзәҝзЁӢпјҢи°ғз”ЁThread.interruptпјҲпјүж–№жі•пјҢи®©е…¶жҠӣеҮәInterruptedExceptionејӮеёё

еҲӨж–ӯжҳҜеҗҰеӯҳжҙ»пјҢи°ғз”ЁThread.interrupted(пјү

join

joinж–№жі•е…Ғи®ёдёҖдёӘзәҝзЁӢзӯүеҫ…еҸҰдёҖдёӘзәҝзЁӢзҡ„е®ҢжҲҗгҖӮеҰӮжһңtжҳҜзәҝзЁӢеҪ“еүҚжӯЈеңЁжү§иЎҢзҡ„ThreadеҜ№иұЎпјҢt.joinпјҲпјү

дҪҝеҪ“еүҚзәҝзЁӢжҡӮеҒңжү§иЎҢпјҢзӣҙеҲ°tзҡ„зәҝзЁӢз»ҲжӯўгҖӮе’ҢsleepдёҖж ·пјҢjoinдҫқиө–дәҺж“ҚдҪңзі»з»ҹзҡ„ж—¶й—ҙпјҢи®ҫеӨҮеҘҪзҗҶи®әе°ұеҝ«пјҢжүҖд»ҘдҪ дёҚеә”иҜҘеҒҮи®ҫjoinдјҡзӯүеҫ…дҪ жҢҮе®ҡзҡ„ж—¶й—ҙгҖӮд№ҹе’ҢSleepзұ»дјјпјҢjoinйҖҡиҝҮеҸ‘еҮәInterruptedExceptionйҖҖеҮәжқҘе“Қеә”дёӯж–ӯгҖӮ

зәҝзЁӢй—ҙйҖҡдҝЎж–№жі•еҸҠй—®йўҳ

зәҝзЁӢд№Ӣй—ҙдё»иҰҒйҖҡиҝҮе…ұдә«еӯ—ж®өд»ҘеҸҠеӯ—ж®өеј•з”Ёзҡ„еҜ№иұЎжқҘиҝӣиЎҢйҖҡдҝЎгҖӮиҝҷз§ҚйҖҡдҝЎж–№ејҸйқһеёёй«ҳж•ҲпјҢдҪҶеҸҜиғҪдјҡеҜјиҮҙдёӨзұ»й”ҷиҜҜпјҡзәҝзЁӢе№Іжү°пјҲThread Interferenceпјүе’ҢеҶ…еӯҳдёҖиҮҙжҖ§й”ҷиҜҜпјҲMemory Consistency ErrorsпјүгҖӮйҳІжӯўиҝҷдәӣй”ҷиҜҜзҡ„е·Ҙе…·жҳҜеҗҢжӯҘжңәеҲ¶гҖӮ

然иҖҢпјҢдҪҝз”ЁеҗҢжӯҘжңәеҲ¶еҸҜиғҪдјҡеј•е…ҘзәҝзЁӢдәүз”ЁпјҢеҚіеҪ“дёӨдёӘжҲ–еӨҡдёӘзәҝзЁӢеҗҢж—¶е°қиҜ•и®ҝй—®еҗҢдёҖиө„жәҗж—¶пјҢдјҡеҜјиҮҙJavaиҝҗиЎҢж—¶д»Ҙжӣҙж…ўзҡ„йҖҹеәҰжү§иЎҢдёҖдёӘжҲ–еӨҡдёӘзәҝзЁӢпјҢз”ҡиҮіжҡӮеҒңе®ғ们зҡ„жү§иЎҢгҖӮзәҝзЁӢйҘҘйҘҝе’Ңжҙ»й”ҒжҳҜзәҝзЁӢдәүз”Ёзҡ„дёӨз§ҚеҪўејҸгҖӮ

дёҚеј•е…ҘеҗҢжӯҘжңәеҲ¶зҡ„й—®йўҳ

Thread InterferenceпјҲзәҝзЁӢе№Іжү°пјү

- If the initial value of c is 0, their interleaved actions might follow this sequence:

Thread A: Retrieve c.

Thread B: Retrieve c.

Thread A: Increment retrieved value; result is 1.

Thread B: Decrement retrieved value; result is -1.

Thread A: Store result in c; c is now 1.

Thread B: Store result in c; c is now -1.

зәҝзЁӢAзҡ„з»“жһңе°ұдёўеӨұдәҶ

Memory Consistency ErrorsпјҲеҶ…еӯҳдёҖиҮҙжҖ§й”ҷиҜҜпјү

еҒҮи®ҫе®ҡд№ү并еҲқе§ӢеҢ–дәҶдёҖдёӘз®ҖеҚ•зҡ„ int еӯ—ж®өпјҡ

int counter = 0;counter еӯ—ж®өиў«дёӨдёӘзәҝзЁӢ A е’Ң B е…ұдә«гҖӮеҒҮи®ҫзәҝзЁӢ A еҜ№ counter иҝӣиЎҢйҖ’еўһж“ҚдҪңпјҡ counter++;

йҡҸеҗҺдёҚд№…пјҢзәҝзЁӢ B жү“еҚ°еҮә counter зҡ„еҖјпјҡ System.out.println(counter);

еҰӮжһңиҝҷдёӨдёӘиҜӯеҸҘжҳҜеңЁеҗҢдёҖдёӘзәҝзЁӢдёӯжү§иЎҢзҡ„пјҢеҸҜд»Ҙе®үе…Ёең°еҒҮи®ҫиҫ“еҮәзҡ„еҖјжҳҜ “1”гҖӮдҪҶеҰӮжһңиҝҷдёӨдёӘиҜӯеҸҘжҳҜеңЁдёҚеҗҢзҡ„зәҝзЁӢдёӯжү§иЎҢпјҢжү“еҚ°еҮәжқҘзҡ„еҖјеҸҜиғҪд»Қ然жҳҜ “0”пјҢеӣ дёәзәҝзЁӢ A еҜ№ counter зҡ„дҝ®ж”№жңӘеҝ…еҜ№зәҝзЁӢ B еҸҜи§ҒвҖ”вҖ”йҷӨйқһзЁӢеәҸе‘ҳеңЁиҝҷдёӨдёӘиҜӯеҸҘд№Ӣй—ҙе»әз«ӢдәҶе…ҲиЎҢеҸ‘з”ҹе…ізі»пјҲhappens-beforeпјүгҖӮ

и§ЈеҶіж–№жі•

Synchronized

еҰӮжһң count жҳҜ SynchronizedCounter зҡ„дёҖдёӘе®һдҫӢпјҢйӮЈд№Ҳе°Ҷиҝҷдәӣж–№жі•и®ҫдёә synchronized дјҡжңүдёӨдёӘж•Ҳжһңпјҡ

- дә’ж–Ҙпјҡж— жі•и®©дёӨдёӘеҜ№еҗҢдёҖеҜ№иұЎзҡ„еҗҢжӯҘж–№жі•и°ғз”ЁдәӨй”ҷжү§иЎҢгҖӮеҪ“дёҖдёӘзәҝзЁӢжӯЈеңЁжү§иЎҢжҹҗдёӘеҜ№иұЎзҡ„еҗҢжӯҘж–№жі•ж—¶пјҢжүҖжңүе…¶д»–зәҝзЁӢи°ғз”ЁиҜҘеҜ№иұЎзҡ„еҗҢжӯҘж–№жі•йғҪдјҡиў«йҳ»еЎһпјҲжҡӮеҒңжү§иЎҢпјүпјҢзӣҙеҲ°з¬¬дёҖдёӘзәҝзЁӢжү§иЎҢе®ҢжҜ•гҖӮ

- е…ҲиЎҢеҸ‘з”ҹе…ізі»пјҡеҪ“дёҖдёӘеҗҢжӯҘж–№жі•йҖҖеҮәж—¶пјҢиҮӘеҠЁе»әз«ӢдёҖдёӘе…ҲиЎҢеҸ‘з”ҹе…ізі»пјҢдҝқиҜҒеҜ№еҜ№иұЎзҠ¶жҖҒзҡ„дҝ®ж”№еҜ№жүҖжңүзәҝзЁӢеҸҜи§ҒгҖӮ

еңЁ Java дёӯпјҢжҜҸдёӘеҜ№иұЎйғҪйҡҗеҗ«ең°жӢҘжңүдёҖдёӘеҶ…еңЁй”ҒпјҲд№ҹз§°дёәзӣ‘и§ҶеҷЁй”ҒпјүгҖӮеј•з”ЁеҸҳйҮҸе’ҢеӨ§еӨҡж•°еҺҹе§ӢеҸҳйҮҸпјҲйҷӨlongе’Ңdoubleд№ӢеӨ–зҡ„жүҖжңүзұ»еһӢпјүпјҢиҜ»еҸ–е’ҢеҶҷе…ҘйғҪжҳҜеҺҹеӯҗжҖ§зҡ„

еҜ№дәҺжүҖжңүеЈ°жҳҺдёәvolatileзҡ„еҸҳйҮҸпјҲеҢ…жӢ¬longе’ҢdoubleеҸҳйҮҸпјүпјҢиҜ»еҸ–е’ҢеҶҷе…ҘйғҪжҳҜеҺҹеӯҗжҖ§зҡ„гҖӮ

- жҢүз…§жғҜдҫӢпјҢдёҖдёӘзәҝзЁӢеңЁйңҖиҰҒеҜ№еҜ№иұЎзҡ„еӯ—ж®өиҝӣиЎҢзӢ¬еҚ дё”дёҖиҮҙзҡ„и®ҝй—®ж—¶пјҢеҝ…йЎ»иҺ·еҸ–иҜҘеҜ№иұЎзҡ„еҶ…еңЁй”ҒпјҢ并еңЁж“ҚдҪңе®ҢжҲҗеҗҺйҮҠж”ҫиҜҘеҶ…еңЁй”ҒгҖӮ

- дёҖдёӘзәҝзЁӢеңЁиҺ·еҸ–еҲ°й”ҒдёҺйҮҠж”ҫй”Ғд№Ӣй—ҙзҡ„ж—¶й—ҙж®өеҶ…иў«и®ӨдёәжӢҘжңүиҜҘеҶ…еңЁй”ҒгҖӮеҸӘиҰҒжҹҗдёӘзәҝзЁӢжӢҘжңүеҶ…еңЁй”ҒпјҢе…¶д»–д»»дҪ•зәҝзЁӢйғҪж— жі•иҺ·еҸ–зӣёеҗҢзҡ„й”ҒгҖӮеҪ“е…¶д»–зәҝзЁӢе°қиҜ•иҺ·еҸ–иҜҘй”Ғж—¶пјҢе®ғ们е°Ҷиў«йҳ»еЎһгҖӮ

еҪ“дёҖдёӘзәҝзЁӢйҮҠж”ҫеҶ…еңЁй”Ғж—¶пјҢйҮҠж”ҫеҠЁдҪңдёҺеҗҺз»ӯеҜ№иҜҘй”Ғзҡ„д»»дҪ•иҺ·еҸ–ж“ҚдҪңд№Ӣй—ҙдјҡиҮӘеҠЁе»әз«ӢдёҖдёӘе…ҲиЎҢеҸ‘з”ҹе…ізі»гҖӮ

еҰӮжһңи°ғз”Ёзҡ„жҳҜйқҷжҖҒеҗҢжӯҘж–№жі•

- йқҷжҖҒж–№жі•жҳҜдёҺзұ»зӣёе…ізҡ„пјҢиҖҢдёҚжҳҜдёҺеҜ№иұЎзӣёе…ізҡ„гҖӮstatic йқҷжҖҒж–№жі•иғҪдёҚиғҪдҪҝз”ЁеҗҢжӯҘж–№жі•е‘ўпјҹдёҚдјҡпјҢеӣ дёәжҜҸдёҖдёӘйқҷжҖҒж–№жі•е’Ңзұ»е…іиҒ”иҖҢдёҚжҳҜдёҖдёӘеҜ№иұЎ

- еңЁиҝҷз§Қжғ…еҶөдёӢпјҢзәҝзЁӢдјҡиҺ·еҸ–дёҺиҜҘзұ»е…іиҒ”зҡ„ Class еҜ№иұЎзҡ„еҶ…еңЁй”ҒгҖӮ

| ж–№жі•дёҖпјҡй’ҲеҜ№дәҺж•ҙдёӘеҮҪж•° | public class SynchronizedCounter { private int c = 0; public synchronized void increment() { c++; } public synchronized void decrement() { c–; } public synchronized int value() { return c;} } |

| ж–№жі•дәҢпјҡй’ҲеҜ№дәҺйғЁеҲҶ | public void addName(String name) { synchronized(this) { lastName = name; nameCount++; } nameList.add(name); } |

| ж–№жі•дёүпјҡеҜ№дәҺжҹҗдёҖдёӘйғЁеҲҶ иҝҷйҮҢй’ҲеҜ№дәҺ c1пјҢc2 еҠ ж“ҚдҪңеҲҶеҲ«дёҠй”ҒпјҢдёӨдёӘй”Ғд№Ӣй—ҙдёҚе№Іжү° | public class MsLunch { private long c1 = 0; private long c2 = 0; private Object lock1 = new Object(); private Object lock2 = new Object(); public void inc1() { synchronized(lock1) { c1++; } } public void inc2() { synchronized(lock2) { c2++; } } } |

еҸҜйҮҚе…Ҙзҡ„й”Ғпјҡ ReentrantLock

жҲ‘们жңүдёҖдёӘзұ» C пјҢе®ғжңүдёҖдёӘSynchronizedж–№жі• m пјҢ m йҮҢйқўи°ғз”ЁдәҶеҸҰеӨ–дёҖдёӘSynchronizedж–№жі• n пјҢ n д№ҹ еңЁ C йҮҢйқўпјӣ然иҖҢпјҢи°ғз”Ё n зҡ„ж—¶еҖҷпјҢеҸ‘зҺ°иҝҷдёӘеҜ№иұЎзҡ„й”Ғ еңЁ m жүӢйҮҢе‘ўпјҒ д№ҹжңүеҸҜиғҪ m жҳҜдёҖдёӘйҖ’еҪ’зҡ„ж–№жі•вҖҰвҖҰ

еј•е…ҘжҰӮеҝөпјҡеҸҜйҮҚе…Ҙзҡ„й”ҒгҖӮеҸҜйҮҚе…Ҙзҡ„й”Ғж„Ҹе‘ізқҖпјҡ дёҖдёӘзәҝзЁӢдёҚиғҪиҺ·еҫ—дёҖдёӘиў«е…¶д»–зәҝзЁӢеҚ жҚ®зҡ„lockпјӣдҪҶжҳҜе®ғиғҪеӨҹиҺ·еҫ—дёҖдёӘе®ғе·Із»ҸжӢҘжңүзҡ„й”ҒгҖӮ

еј•е…ҘеҗҢжӯҘжңәеҲ¶еёҰжқҘзҡ„й—®йўҳ

DeadlockпјҲжӯ»й”ҒпјүпјҡAзәҝзЁӢзӯүеҫ…BпјҢBзӯүеҫ…AпјҢиҝҷж ·е°ұдјҡйҷ·е…Ҙжӯ»й”Ғзҡ„еҫӘзҺҜгҖӮдёҖиҲ¬жҳҜз”ұдәҺиө„жәҗз«һдәүе’Ң并еҸ‘еӨ„зҗҶйЎәеәҸдёҚеҪ“еҜјиҮҙзҡ„гҖӮи§ЈеҶіж–№жі•пјҡи¶…ж—¶йҮҠж”ҫиө„жәҗ

StarvationпјҲйҘҝжӯ»пјүпјҡAжғіиҰҒи®ҝй—®дёҖдёӘе…ұдә«иө„жәҗпјҢдҪҶжҳҜдёҖзӣҙиҺ·еҸ–дёҚеҲ°пјҢе°ұеғҸиў«йҘҝжӯ»дәҶдёҖж ·гҖӮпјҲйңҖиҰҒж¶ҲйҷӨйӮЈдәӣиҙӘе©Әзҡ„ зәҝзЁӢпјҢйҒҝе…ҚдёҖдёӘзәҝзЁӢй•ҝжңҹиҙӘе©Әзҡ„еҚ з”Ёиө„жәҗпјӣжүҖд»ҘtomcatйҮҢйқўз”ЁдәҶиҝһжҺҘжұ пјҢйҒҝе…ҚдёҖдёӘиҝһжҺҘй•ҝжңҹеҚ з”Ёиө„ жәҗпјү

LivelockпјҲжҙ»й”Ғпјүпјҡжҙ»й”ҒжҳҜжҢҮдёҖдёӘзәҝзЁӢеҜ№еҸҰдёҖдёӘзәҝзЁӢзҡ„еҠЁдҪңеҒҡеҮәеҸҚеә”пјҢиҖҢеҰӮжһңеҸҰдёҖдёӘзәҝзЁӢзҡ„еҠЁдҪңд№ҹжҳҜеҜ№еүҚдёҖдёӘзәҝзЁӢеҠЁдҪңзҡ„еҸҚеә”пјҢйӮЈд№ҲеҸҜиғҪдјҡеҜјиҮҙжҙ»й”ҒгҖӮдёҺжӯ»й”Ғзұ»дјјпјҢжҙ»й”ҒзҠ¶жҖҒдёӢзҡ„зәҝзЁӢд№ҹж— жі•з»§з»ӯеҸ–еҫ—иҝӣеұ•гҖӮ然иҖҢпјҢзәҝзЁӢ并没жңүиў«йҳ»еЎһпјҢиҖҢжҳҜеҪјжӯӨдёҚеҒңең°е“Қеә”еҜ№ж–№пјҢеҜјиҮҙж— жі•жҒўеӨҚжӯЈеёёе·ҘдҪңгҖӮ

и§ЈеҶіж–№ејҸпјҡеҚҸи°ғиө„жәҗ

- еҸ—дҝқжҠӨзҡ„еқ—пјҲguarded blockпјүгҖӮ жңҖеёёи§Ғзҡ„ж–№ејҸпјҢwhile(!joy) {}з®ҖеҚ•зҡ„еҫӘзҺҜпјҢдҪҶжөӘиҙ№еӨ„зҗҶеҷЁж—¶й—ҙгҖӮдёҖиҲ¬дёҚжҺЁиҚҗиҝҷд№ҲеҒҡ

- и°ғз”Ё

waitж–№жі•дјҡжҡӮеҒңзәҝзЁӢпјҢзӣҙеҲ°еҸҰдёҖдёӘзәҝзЁӢеҸ‘еҮәйҖҡзҹҘпјҢиЎЁзӨәжҹҗдёӘзү№ж®ҠдәӢ件еҸ‘з”ҹпјҲдёҚдёҖе®ҡжҳҜеҪ“еүҚзәҝзЁӢжӯЈеңЁзӯүеҫ…зҡ„дәӢ件пјүгҖӮеңЁжңӘжқҘзҡ„жҹҗдёӘж—¶еҲ»пјҢеҸҰдёҖдёӘзәҝзЁӢе°ҶиҺ·еҸ–зӣёеҗҢзҡ„й”Ғ并и°ғз”ЁObject.notifyAllпјҢйҖҡзҹҘжүҖжңүзӯүеҫ…иҜҘй”Ғзҡ„зәҝзЁӢпјҢиЎЁзӨәжҹҗдёӘйҮҚиҰҒдәӢ件已з»ҸеҸ‘з”ҹгҖӮеңЁз¬¬дәҢдёӘзәҝзЁӢйҮҠж”ҫй”ҒеҗҺпјҢзӯүеҫ…зҡ„第дёҖдёӘзәҝзЁӢе°ҶйҮҚж–°иҺ·еҸ–й”Ғ并д»Һwaitж–№жі•зҡ„и°ғз”ЁдёӯжҒўеӨҚжү§иЎҢгҖӮ

дҪҝз”ЁеҸ—дҝқжҠӨеқ—еҲӣе»әз”ҹдә§иҖ…-ж¶Ҳиҙ№иҖ…еә”з”Ё

иҝҷз§Қеә”з”ЁеңЁдёӨдёӘзәҝзЁӢд№Ӣй—ҙе…ұдә«ж•°жҚ®пјҡ

- з”ҹдә§иҖ…пјҡеҲӣе»әж•°жҚ®гҖӮ

- ж¶Ҳиҙ№иҖ…пјҡдҪҝз”Ёж•°жҚ®гҖӮ

дёӨдёӘзәҝзЁӢйҖҡиҝҮдёҖдёӘе…ұдә«еҜ№иұЎиҝӣиЎҢйҖҡдҝЎгҖӮ

еҚҸи°ғжҳҜиҮіе…ійҮҚиҰҒзҡ„пјҡ

- ж¶Ҳиҙ№иҖ…зәҝзЁӢеҝ…йЎ»еңЁз”ҹдә§иҖ…зәҝзЁӢдәӨд»ҳж•°жҚ®д№ӢеҗҺжүҚиғҪжЈҖзҙўж•°жҚ®гҖӮ

- з”ҹдә§иҖ…зәҝзЁӢеҝ…йЎ»еңЁж¶Ҳиҙ№иҖ…зәҝзЁӢжЈҖзҙўе®Ңж—§ж•°жҚ®д№ӢеүҚпјҢдёҚиғҪдәӨд»ҳж–°ж•°жҚ®гҖӮ

дёҚеҸҜеҸҳеҜ№иұЎпјҲImmutable Objectпјү

- еҰӮжһңдёҖдёӘеҜ№иұЎзҡ„зҠ¶жҖҒеңЁжһ„йҖ д№ӢеҗҺдёҚиғҪжӣҙж”№пјҢйӮЈд№ҲиҜҘеҜ№иұЎиў«и®ӨдёәжҳҜдёҚеҸҜеҸҳзҡ„гҖӮ

- дҫқиө–дёҚеҸҜеҸҳеҜ№иұЎиў«е№ҝжіӣи®ӨдёәжҳҜзј–еҶҷз®ҖеҚ•гҖҒеҸҜйқ д»Јз Ғзҡ„дёҖз§Қжңүж•Ҳзӯ–з•ҘгҖӮ

- е·§еҰҷзҡ„йҒҝе…ҚдәҶзәҝзЁӢе№Іж¶үпјҲдёӨдёӘзәҝзЁӢйғҪеңЁеҶҷW/WпјүпјҢеҶ…еӯҳдёҚдёҖиҮҙпјҲдёҖдёӘеңЁеҶҷдёҖдёӘеңЁиҜ»W/Rпјү

дёҚеҸҜеҸҳеҜ№иұЎеңЁе№¶еҸ‘еә”з”Ёдёӯзү№еҲ«жңүз”ЁпјҡдёҚеҸҜеҸҳеҜ№иұЎзҡ„зҠ¶жҖҒдёҖж—ҰеҲӣе»әе°ұдёҚиғҪиў«ж”№еҸҳпјҢиҝҷдҪҝеҫ—е®ғ们йқһеёёйҖӮеҗҲеңЁе№¶еҸ‘зј–зЁӢдёӯдҪҝз”ЁпјҢеӣ дёәеӨҡдёӘзәҝзЁӢеҸҜд»Ҙе®үе…Ёең°и®ҝй—®дёҚеҸҜеҸҳеҜ№иұЎпјҢиҖҢдёҚеҝ…жӢ…еҝғж•°жҚ®з«һдәүжҲ–зҠ¶жҖҒдёҚдёҖиҮҙзҡ„й—®йўҳгҖӮиҝҷжңүеҠ©дәҺз®ҖеҢ–д»Јз Ғ并жҸҗй«ҳеҸҜйқ жҖ§гҖӮ

зЁӢеәҸе‘ҳеёёеёёдёҚж„ҝдҪҝз”ЁдёҚеҸҜеҸҳеҜ№иұЎпјҢеӣ дёә他们жӢ…еҝғеҲӣе»әж–°еҜ№иұЎзҡ„жҲҗжң¬пјҢиҖҢдёҚжҳҜзӣҙжҺҘеңЁеҺҹең°жӣҙж–°еҜ№иұЎгҖӮдҪҶеҜ№иұЎеҲӣе»әзҡ„еҪұе“Қеёёеёёиў«й«ҳдј°пјҢеӣ дёәеһғеңҫеӣһ收еёҰжқҘзҡ„ејҖй”ҖеҮҸе°‘е’Ңж— йңҖзј–еҶҷйўқеӨ–зҡ„д»Јз ҒжқҘдҝқжҠӨеҸҜеҸҳеҜ№иұЎдёҚеҸ—жҚҹеқҸпјҢдё”еҸҜд»ҘйҖҡиҝҮдёҚеҸҜеҸҳеҜ№иұЎеёҰжқҘзҡ„дёҖдәӣж•ҲзҺҮжқҘжҠөж¶ҲгҖӮ

й«ҳзә§е№¶еҸ‘зү№жҖ§

иҝҷдәӣзү№жҖ§еӨ§еӨҡж•°йғҪеңЁж–°зҡ„ java.util.concurrent еҢ…дёӯе®һзҺ°гҖӮ

Lock еҜ№иұЎпјҡ

LockеҜ№иұЎжҸҗдҫӣдәҶдёҖз§ҚжӣҙзҒөжҙ»зҡ„й”Ғе®ҡжңәеҲ¶гҖӮдёҺдј з»ҹзҡ„synchronizedж–№жі•жҲ–д»Јз Ғеқ—дёҚеҗҢпјҢLockжҸҗдҫӣдәҶжӣҙеӨҡеҠҹиғҪпјҢдҫӢеҰӮеҸҜйҮҚе…Ҙй”Ғе’ҢжқЎд»¶й”ҒпјҢе…Ғи®ёзЁӢеәҸеңЁдёҚеҗҢжқЎд»¶дёӢиҝӣиЎҢжӣҙз»ҶзІ’еәҰзҡ„жҺ§еҲ¶гҖӮдҪҝз”ЁLockпјҢејҖеҸ‘иҖ…еҸҜд»ҘжүӢеҠЁеҠ й”Ғе’Ңи§Јй”ҒпјҢиҝҷеңЁеӨҚжқӮзҡ„并еҸ‘еңәжҷҜдёӢе°Өе…¶жңүз”ЁгҖӮ- дҪңз”Ёпјҡ

LockжҸҗдҫӣдәҶеҜ№й”Ғзҡ„зІҫз»ҶжҺ§еҲ¶пјҢзү№еҲ«йҖӮз”ЁдәҺйңҖиҰҒеӨҚжқӮеҗҢжӯҘжҺ§еҲ¶зҡ„еңәжҷҜгҖӮ

Executorsпјҡ

Executorsзұ»жҸҗдҫӣдәҶзәҝзЁӢжұ з®ЎзҗҶзҡ„е®һзҺ°пјҢйҒҝе…ҚдәҶжүӢеҠЁеҲӣе»әе’Ңй”ҖжҜҒзәҝзЁӢзҡ„йә»зғҰпјҢе°Өе…¶йҖӮеҗҲйңҖиҰҒйў‘з№Ғи°ғеәҰд»»еҠЎзҡ„еә”з”ЁзЁӢеәҸгҖӮйҖҡиҝҮExecutorsпјҢеҸҜд»ҘеҲӣе»әеӣәе®ҡеӨ§е°Ҹзҡ„зәҝзЁӢжұ гҖҒзј“еӯҳзәҝзЁӢжұ жҲ–еҚ•зәҝзЁӢжү§иЎҢеҷЁгҖӮ- дҪңз”ЁпјҡзәҝзЁӢжұ еҸҜд»ҘеҮҸе°‘зі»з»ҹзҡ„ејҖй”ҖпјҢ并жҸҗй«ҳиө„жәҗеҲ©з”ЁзҺҮпјҢйҖӮеҗҲеӨ§и§„模并еҸ‘д»»еҠЎз®ЎзҗҶгҖӮ

并еҸ‘йӣҶеҗҲпјҡ

- 并еҸ‘йӣҶеҗҲзұ»пјҲеҰӮ

ConcurrentHashMapпјҡйҖҡиҝҮйҮҮз”ЁдәҶеҲҶж®өй”Ғзҡ„и®ҫи®ЎпјҢе…Ғи®ёеӨҡдёӘиҜ»зәҝзЁӢ并еҸ‘ең°и®ҝй—®mapпјҢ并且е…Ғи®ёеӨҡдёӘеҶҷзәҝзЁӢ并еҸ‘дҝ®ж”№дёҚеҗҢзҡ„ж®өгҖӮпјүе…Ғи®ёеӨҡдёӘзәҝзЁӢе®үе…Ёең°и®ҝй—®йӣҶеҗҲпјҢж— йңҖжүӢеҠЁж·»еҠ еҗҢжӯҘеқ—гҖӮйҖҡиҝҮеҲҶж®өй”Ғе®ҡжҠҖжңҜпјҢе®һзҺ°й«ҳж•Ҳзҡ„并еҸ‘ж“ҚдҪңпјҢеҮҸе°‘дәҶй”Ғз«һдәүгҖӮ - дҪңз”Ёпјҡ并еҸ‘йӣҶеҗҲйҖӮеҗҲиҜ»ж“ҚдҪңйў‘з№Ғзҡ„еңәжҷҜпјҢйҒҝе…ҚдәҶдј з»ҹеҗҢжӯҘйӣҶеҗҲдёӯзҡ„жҖ§иғҪ瓶йўҲгҖӮ

еҺҹеӯҗеҸҳйҮҸпјҡ

- еҺҹеӯҗеҸҳйҮҸпјҲеҰӮ

AtomicIntegerпјүе…Ғи®ёзәҝзЁӢе®үе…Ёзҡ„еҸҳйҮҸж“ҚдҪңпјҢж— йңҖжҳҫејҸдҪҝз”Ёй”ҒгҖӮйҖҡиҝҮ硬件ж”ҜжҢҒзҡ„еҺҹеӯҗж“ҚдҪңпјҲдҫӢеҰӮ CAS ж“ҚдҪңпјүжқҘдҝқиҜҒж•°жҚ®зҡ„е®үе…Ёдҝ®ж”№гҖӮ - дҪңз”ЁпјҡеҺҹеӯҗеҸҳйҮҸеңЁеӨҡзәҝзЁӢдёӢжҸҗдҫӣй«ҳж•ҲгҖҒж— й”Ғзҡ„ж“ҚдҪңпјҢеҮҸе°‘дәҶй”Ғзҡ„ејҖй”ҖпјҢйҖӮеҗҲз®ҖеҚ•зҡ„йҖ’еўһгҖҒйҖ’еҮҸж“ҚдҪңгҖӮ

ThreadLocalRandomпјҡ

ThreadLocalRandomжҸҗдҫӣдәҶдёҖз§ҚжҜҸдёӘзәҝзЁӢзӢ¬з«Ӣз”ҹжҲҗйҡҸжңәж•°зҡ„ж–№ејҸпјҢйҒҝе…ҚдәҶдј з»ҹRandomзұ»еңЁеӨҡзәҝзЁӢдёӢзҡ„з«һдәүй—®йўҳгҖӮ- дҪңз”Ёпјҡ

ThreadLocalRandomйҖҡиҝҮдёәжҜҸдёӘзәҝзЁӢеҚ•зӢ¬еҲҶй…ҚйҡҸжңәж•°з”ҹжҲҗеҷЁпјҢи§ЈеҶідәҶеӨҡзәҝзЁӢйҡҸжңәж•°з”ҹжҲҗдёӯзҡ„жҖ§иғҪ瓶йўҲй—®йўҳгҖӮ

Lock

- й”ҒеҜ№иұЎзҡ„е·ҘдҪңж–№ејҸдёҺеҗҢжӯҘд»Јз ҒдёӯдҪҝз”Ёзҡ„йҡҗејҸй”ҒйқһеёёзӣёдјјгҖӮ

- дёҺйҡҗејҸй”ҒдёҖж ·пјҢдёҖж¬ЎеҸӘжңүдёҖдёӘзәҝзЁӢеҸҜд»ҘжӢҘжңүдёҖдёӘй”ҒеҜ№иұЎгҖӮ

- й”ҒеҜ№иұЎиҝҳж”ҜжҢҒ

wait/notifyжңәеҲ¶пјҢйҖҡиҝҮе®ғ们关иҒ”зҡ„ConditionеҜ№иұЎжқҘе®һзҺ°гҖӮ

- й”ҒеҜ№иұЎзӣёеҜ№дәҺйҡҗејҸй”Ғзҡ„жңҖеӨ§дјҳеҠҝжҳҜиғҪеӨҹеңЁе°қиҜ•иҺ·еҸ–й”ҒеӨұиҙҘж—¶йҖҖеҮәгҖӮ

tryLockж–№жі•еңЁй”ҒдёҚеҸҜз”Ёж—¶з«ӢеҚійҖҖеҮәпјҢжҲ–иҖ…еңЁи¶…ж—¶д№ӢеүҚйҖҖеҮәпјҲеҰӮжһңжҢҮе®ҡдәҶи¶…ж—¶ж—¶й—ҙпјүгҖӮlockInterruptiblyж–№жі•еңЁеҸҰдёҖдёӘзәҝзЁӢеҸ‘йҖҒдёӯж–ӯдҝЎеҸ·ж—¶йҖҖеҮәпјҢеүҚжҸҗжҳҜй”Ғе°ҡжңӘиҺ·еҸ–гҖӮ

Executors

еҲҶзҰ»зәҝзЁӢз®ЎзҗҶдёҺд»»еҠЎжү§иЎҢпјҡеңЁе°Ҹ规模зЁӢеәҸдёӯпјҢд»»еҠЎе’ҢзәҝзЁӢд№Ӣй—ҙзҡ„зҙ§еҜҶиҖҰеҗҲжҳҜеёёи§Ғдё”еҸҜжҺҘеҸ—зҡ„гҖӮ然иҖҢпјҢеңЁеӨ§еһӢеә”з”ЁзЁӢеәҸдёӯпјҢе°ҶзәҝзЁӢзҡ„еҲӣе»әе’Ңз®ЎзҗҶзӢ¬з«ӢеҮәжқҘиғҪеӨҹжҸҗй«ҳд»Јз Ғзҡ„еҸҜз»ҙжҠӨжҖ§дёҺжү©еұ•жҖ§гҖӮ

жү§иЎҢеҷЁзҡ„дҪңз”Ёпјҡжү§иЎҢеҷЁжҳҜдёҖз§Қе·Ҙе…·пјҢеё®еҠ©ејҖеҸ‘иҖ…д»ҘжӣҙзҒөжҙ»зҡ„ж–№ејҸз®ЎзҗҶзәҝзЁӢпјҢйҒҝе…ҚжҳҫејҸеҲӣе»әе’ҢжҺ§еҲ¶зәҝзЁӢгҖӮйҖҡиҝҮдҪҝз”Ё Executor жҺҘеҸЈе’Ңе®һзҺ°пјҢжҜ”еҰӮзәҝзЁӢжұ пјҲThread PoolsпјүпјҢзі»з»ҹеҸҜд»Ҙжңүж•Ҳең°з®ЎзҗҶеӨҡдёӘзәҝзЁӢпјҢиҖҢ Fork/Join еҲҷеҸҜд»ҘеҲ©з”ЁеӨҡдёӘеӨ„зҗҶеҷЁжқҘеҠ йҖҹд»»еҠЎзҡ„并иЎҢеӨ„зҗҶгҖӮ

зәҝзЁӢжұ

е·ҘдҪңзәҝзЁӢпјҲWorker ThreadsпјүпјҡзәҝзЁӢжұ дёӯзҡ„зәҝзЁӢзӢ¬з«ӢдәҺд»»еҠЎпјҲRunnable жҲ– CallableпјүпјҢз”ЁдәҺжү§иЎҢеӨҡдёӘд»»еҠЎгҖӮдҪҝз”Ёе·ҘдҪңзәҝзЁӢеҸҜд»ҘеҮҸе°‘зәҝзЁӢйў‘з№ҒеҲӣе»әе’Ңй”ҖжҜҒеёҰжқҘзҡ„ејҖй”ҖпјҢжҸҗй«ҳзі»з»ҹжҖ§иғҪгҖӮ

еӣәе®ҡзәҝзЁӢжұ пјҲFixed Thread PoolпјүпјҡдёҖз§ҚзәҝзЁӢж•°йҮҸеӣәе®ҡзҡ„зәҝзЁӢжұ пјҢйҖҡиҝҮ Executors.newFixedThreadPool ж–№жі•еҲӣе»әгҖӮеӣәе®ҡзәҝзЁӢжұ зҡ„дјҳеҠҝжҳҜеҚідҪҝд»»еҠЎйҮҸеўһеҠ пјҢе®ғд№ҹиғҪйҖҡиҝҮеӣәе®ҡж•°йҮҸзҡ„зәҝзЁӢзЁіе®ҡиҝҗиЎҢпјҢйҒҝе…ҚжҖ§иғҪеӨ§е№…дёӢйҷҚпјҢзЎ®дҝқзі»з»ҹвҖңдјҳйӣ…йҖҖеҢ–вҖқгҖӮ

е…¶д»–зәҝзЁӢжұ зұ»еһӢпјҡ

- CachedThreadPoolпјҡеҠЁжҖҒжү©еұ•зҡ„зәҝзЁӢжұ пјҢйҖӮеҗҲеӨ§йҮҸзҹӯжңҹд»»еҠЎгҖӮ

- SingleThreadExecutorпјҡеҚ•зәҝзЁӢжү§иЎҢеҷЁпјҢдҝқиҜҒд»»еҠЎйҖҗдёӘжү§иЎҢпјҢйҖӮеҗҲдҫқж¬ЎеӨ„зҗҶд»»еҠЎзҡ„еңәжҷҜгҖӮ

еҲӣе»әдҪҝз”Ёеӣәе®ҡзәҝзЁӢжұ зҡ„жү§иЎҢеҷЁзҡ„з®ҖеҚ•ж–№жі•жҳҜи°ғз”Ё java.util.concurrent.Executors дёӯ зҡ„ newFixedThreadPool е·ҘеҺӮж–№жі•пјӣжӯӨзұ»иҝҳжҸҗдҫӣд»ҘдёӢе·ҘеҺӮж–№жі•пјҡ newCachedThreadPool ж–№жі•еҲӣе»әе…·жңү еҸҜжү©еұ•зәҝзЁӢжұ зҡ„жү§иЎҢеҷЁгҖӮжӯӨжү§иЎҢеҷЁйҖӮз”ЁдәҺеҗҜеҠЁи®ёеӨҡзҹӯжңҹд»»еҠЎзҡ„еә”з”ЁзЁӢ еәҸгҖӮ newSingleThreadExecutor ж–№жі•еҲӣе»әдёҖдёӘжү§иЎҢеҷЁпјҢдёҖж¬Ўжү§иЎҢдёҖдёӘд»»еҠЎгҖӮ

Fork/Join

- Fork/Join жҳҜдёҖз§Қ

ExecutorServiceзҡ„е®һзҺ°пјҢи®ҫи®Ўз”ЁдәҺеҸҜд»ҘйҖ’еҪ’жӢҶеҲҶдёәиҫғе°Ҹд»»еҠЎзҡ„е·ҘдҪңиҙҹиҪҪгҖӮ - зӣ®ж ҮжҳҜеҲ©з”Ёзі»з»ҹзҡ„жүҖжңүеӨ„зҗҶеҷЁпјҢжңҖеӨ§еҢ–зЁӢеәҸжҖ§иғҪгҖӮ

Fork/Join е·ҘдҪңж–№ејҸпјҡ

е·ҘдҪңжөҒзЁӢзұ»дјјдәҺпјҡеҰӮжһңд»»еҠЎи¶іеӨҹе°ҸпјҢзӣҙжҺҘжү§иЎҢпјҢеҗҰеҲҷе°Ҷд»»еҠЎжӢҶеҲҶдёәдёӨйғЁеҲҶпјҢеҲҶеҲ«жү§иЎҢ并зӯүеҫ…з»“жһңгҖӮиҝҷз§Қж–№ејҸйқһеёёйҖӮеҗҲ并иЎҢеӨ„зҗҶеӨҚжқӮд»»еҠЎпјҢе°Өе…¶еңЁеӨҡеӨ„зҗҶеҷЁзі»з»ҹдёӯеҸҜд»Ҙжҳҫи‘—жҸҗеҚҮжҖ§иғҪгҖӮ

if (my portion of the work is small enough)

do the work directly

else

split my work into two pieces

invoke the two pieces and wait for the results Fork/Join жЎҶжһ¶зҡ„д»Јз Ғе®һзҺ°пјҡ

- йҖҡиҝҮ ForkJoinTask зҡ„еӯҗзұ»е®һзҺ°пјҢйҖҡеёёдҪҝз”Ё RecursiveTaskпјҲеҸҜд»Ҙиҝ”еӣһз»“жһңпјүжҲ–иҖ… RecursiveActionпјҲж— иҝ”еӣһеҖјпјүжқҘеӨ„зҗҶд»»еҠЎгҖӮ

зӨәдҫӢ – еӣҫеғҸжЁЎзіҠеӨ„зҗҶпјҡ

- еӨ„зҗҶеӣҫеғҸж—¶пјҢжҜҸдёӘеғҸзҙ зҡ„йўңиүІеҖјйҖҡиҝҮе№іеқҮе‘ЁеӣҙеғҸзҙ еҖјжқҘжЁЎзіҠеҢ–гҖӮ

- з”ұдәҺеӣҫеғҸжҳҜдёҖз»ҙжҲ–дәҢз»ҙзҡ„еӨ§ж•°з»„пјҢиҝҷдёӘиҝҮзЁӢиҖ—ж—¶иҫғй•ҝгҖӮ

- дҪҝз”Ё Fork/Join жЎҶжһ¶еҸҜд»Ҙ并иЎҢеӨ„зҗҶжҜҸдёӘеғҸзҙ пјҢд»ҺиҖҢжҳҫи‘—еҮҸе°‘еӣҫеғҸеӨ„зҗҶзҡ„ж—¶й—ҙгҖӮ

иҷҡжӢҹзәҝзЁӢ

иҷҡжӢҹзәҝзЁӢжҳҜиҪ»йҮҸзә§зәҝзЁӢпјҢеҸҜд»ҘеҮҸе°‘зј–еҶҷгҖҒз»ҙжҠӨе’Ңи°ғиҜ•й«ҳеҗһеҗҗйҮҸ并еҸ‘еә”з”ЁзЁӢеәҸзҡ„е·ҘдҪңйҮҸгҖӮжӣҙеҠ иҪ»йҮҸеҢ–пјҢжҜ”еҰӮеңЁиў«IOйҳ»еЎһж—¶пјҢйӮЈд№Ҳе°ұжҠҠзәҝзЁӢи§Јз»‘пјӣзӯүIOз»“жқҹж—¶еҶҚз»‘е®ҡзәҝзЁӢпјҢдҪҶдёҚдёҖе®ҡжҳҜеҺҹе…Ҳзҡ„зәҝзЁӢгҖӮдҪҶеҜ№дәҺй•ҝж—¶й—ҙеҚ з”Ёcpuзҡ„д»»еҠЎдёҚеҸӢеҘҪгҖӮ

е№іеҸ°зәҝзЁӢпјҲPlatform Threadпјү

- е®ҡд№үпјҡе№іеҸ°зәҝзЁӢжҳҜдёҖдёӘеӣҙз»•ж“ҚдҪңзі»з»ҹпјҲOSпјүзәҝзЁӢзҡ„иҪ»йҮҸзә§е°ҒиЈ…зҡ„JavaзәҝзЁӢгҖӮ

- зү№зӮ№пјҡ

- е®ғеңЁеә•еұӮзҡ„ж“ҚдҪңзі»з»ҹзәҝзЁӢдёҠиҝҗиЎҢJavaд»Јз ҒгҖӮ

- еңЁе…¶ж•ҙдёӘз”ҹе‘Ҫе‘ЁжңҹдёӯпјҢе№іеҸ°зәҝзЁӢе§Ӣз»ҲеҚ з”ЁдёҖдёӘOSзәҝзЁӢгҖӮ

- еҸҜз”Ёзҡ„ж“ҚдҪңзі»з»ҹзәҝзЁӢж•°йҮҸеҶіе®ҡдәҶе№іеҸ°зәҝзЁӢзҡ„ж•°йҮҸйҷҗеҲ¶гҖӮ

- е№іеҸ°зәҝзЁӢйҖҡеёёе…·жңүиҫғеӨ§зҡ„зәҝзЁӢж ҲпјҲеӯҳеӮЁзәҝзЁӢжү§иЎҢзҠ¶жҖҒзҡ„еҶ…еӯҳпјүд»ҘеҸҠе…¶д»–з”ұж“ҚдҪңзі»з»ҹз®ЎзҗҶзҡ„иө„жәҗгҖӮ

- ж”ҜжҢҒзәҝзЁӢеұҖйғЁеҸҳйҮҸпјҲеҚізү№е®ҡдәҺжҹҗдёҖзәҝзЁӢзҡ„еҸҳйҮҸпјүгҖӮ

- дҪҝз”ЁеңәжҷҜпјҡйҖӮз”ЁдәҺиҝҗиЎҢжүҖжңүзұ»еһӢзҡ„д»»еҠЎпјҢдҪҶз”ұдәҺеҸ—йҷҗдәҺж“ҚдҪңзі»з»ҹзәҝзЁӢж•°йҮҸпјҢе№іеҸ°зәҝзЁӢжҳҜдёҖз§Қжңүйҷҗиө„жәҗгҖӮ

第дёғз«

еӣһйЎҫServletе’ҢTomcat

- ServletжҳҜJavaзј–еҶҷзҡ„жңҚеҠЎеҷЁз«ҜзЁӢеәҸпјҢз”ЁдәҺеӨ„зҗҶWebиҜ·жұӮе’Ңз”ҹжҲҗWebе“Қеә”гҖӮ

- TomcatжҳҜдёҖдёӘејҖжәҗзҡ„Java Servletе®№еҷЁпјҢд№ҹеҸҜд»Ҙз§°дёәWebжңҚеҠЎеҷЁпјҢз”ЁдәҺжүҳз®Ўе’ҢиҝҗиЎҢServletе’ҢJSPеә”з”ЁзЁӢеәҸгҖӮ

дёәд»Җд№ҲйңҖиҰҒзј“еӯҳ

Tomcatе’Ңж•°жҚ®еә“йғҪдёҚдёҖе®ҡжҳҜеңЁдёҖеҸ°жңәеҷЁдёҠйқўпјҢеҸҜиғҪжҳҜеҲҶеёғејҸзҡ„пјҢеҸҜиғҪжҳҜеӨҡеҸ°жңәеҷЁпјҢеҸҜиғҪжҳҜеӨҡдёӘ TomcatпјҢеҸҜиғҪжҳҜеӨҡдёӘж•°жҚ®еә“гҖӮеҰӮжһңз»қеӨ§еӨҡж•°жғ…еҶөйғҪжҳҜеҸӘиҜ»зҡ„пјҢеҗҺз«Ҝе’Ңж•°жҚ®еә“д№Ӣй—ҙзҡ„дәӨдә’пјҢзҪ‘з»ңејҖй”ҖеҫҲеӨ§пјҢжӯӨж—¶е°ұзӣҙжҺҘжҠҠж•°жҚ®зј“еӯҳеҲ°TomcatйӮЈйҮҢпјҢиҠӮзңҒдәҶеёҰе®ҪгҖӮ

- Qпјҡж•°жҚ®еә“йҮҢйқўжңүbufferгҖҒORMжҳ е°„йҮҢйқўд№ҹжңүbufferдҪңдёәзј“еҶІеҢәпјҢйӮЈдёәд»Җд№ҲиҰҒзј“еӯҳе‘ўпјҹ

- AпјҡдёҠйқўиҜҙзҡ„иҝҷдёӨдёӘзј“еӯҳйғҪдёҚжҳҜдҪ еҸҜд»ҘжҺ§еҲ¶зҡ„пјҢе®Ңе…ЁеҸ–еҶідәҺ他们иҮӘиә«пјҢжҲ‘们ејҖеҸ‘иҖ…з®ЎдёҚдәҶгҖӮиҖҢдҪҝз”Ё redisпјҢжҲ‘е°ұеҸҜд»ҘиҮӘе·ұзҡ„жҺ§еҲ¶зј“еӯҳпјҒ

дәӢе®һдёҠпјҢжҲ‘们еҗҺеҸ°зҡ„ж•°жҚ®еә“жңӘеҝ…жҳҜе…ізі»еһӢж•°жҚ®еә“пјҒжҲ‘们еҸҜиғҪиҝҳжҗһдәҶж–Ү件系з»ҹгҖҒmongoвҖҰвҖҰжңҖз»Ҳе®ғ们иҝҳжҳҜиЎЁзӨәдёәеҜ№иұЎпјҢзҗҶи®әдёҠжқҘиҜҙе®ғ们д№ҹеә”иҜҘиҝӣзј“еӯҳпјҒдҪҶжҳҜеғҸspring jpaйҮҢйқўзҡ„зј“еӯҳпјҢжҲ–иҖ…hanibatisйҮҢйқўзҡ„зј“еӯҳпјҢжҠҠж•°жҚ®еә“йҮҢйқўжҠ“еҸ–иҝҮжқҘзҡ„ж•°жҚ®е·Із»Ҹеј„жҲҗеҜ№иұЎзј“еӯҳдәҶпјҢе®ғд№ҹд»…д»…й’ҲеҜ№е…ізі»еһӢж•°жҚ®еә“пјҒпјҲиҝҳжңүпјҢжҲ‘жҠҠдёңиҘҝеҶҷеҲ°redisйҮҢйқўпјҢеҶҷе…Ҙзҡ„жҳҜе·Із»„иЈ…еҘҪзҡ„еҜ№иұЎпјӣеҺҹе§Ӣж•°жҚ®з»„иЈ…дёәеҜ№иұЎд№ҹйңҖиҰҒж¶ҲиҖ—е‘ўпјҒжүҖд»Ҙиҝҷд№ҹжҳҜredisиҠӮзңҒзҡ„ең°ж–№пјү

еҒҮеҰӮжҲ‘иҝҳжңүд»Һж–Ү件系з»ҹйҮҢйқўиҜ»еҸ–зҡ„пјҢnosqlж•°жҚ®еә“йҮҢйқўзҡ„иҜ»еҸ–зҡ„дёңиҘҝгҖҒеҠЁжҖҒз”ҹжҲҗзҡ„зҪ‘йЎөгҖҒеӣҫзүҮйғҪеҸҜд»Ҙ пјҢ жүҖд»ҘдҪҝз”Ёredisе°ұйғҪеҸҜд»ҘеӯҳеӮЁпјҢredisе®Ңе…ЁеңЁејҖеҸ‘иҖ…зҡ„жҺ§еҲ¶дёӢгҖӮжҜ”еҰӮеҸҢеҚҒдёҖзҡ„ж—¶еҖҷпјҢжҲ‘еҸҜд»Ҙи¶Ғз”ЁжҲ·и®ҝй—®йҮҸе°‘зҡ„ж—¶еҖҷжҸҗеүҚжҠҠеҸҜиғҪеҚ–зҲҶзҡ„зҪ‘йЎөзј“еӯҳеҮәжқҘпјҢиҝҷж ·жҸҗй«ҳи®ҝй—®зҡ„йҖҹеәҰгҖӮ redisз”ҡиҮіиҝҳеҸҜд»ҘдҪңдёәж¶ҲжҒҜдёӯй—ҙ件пјҢзұ»дјјkafkaзҡ„topicпјҢд»–е’ҢеҚЎеӨ«еҚЎзҡ„е·®еҲ«жҳҜredisйҮҢйқўзҡ„дёңиҘҝеңЁеҶ…еӯҳйҮҢйқўгҖӮ

ж•°жҚ®еә“жңҚеҠЎеҷЁеҜ№дәҺеҶ…еӯҳиҰҒжұӮжҜ”иҫғй«ҳпјҢиҖҢTomcatжңҚеҠЎеҷЁдё»иҰҒжҳҜCPUеҜҶйӣҶеһӢпјҲеӣ дёәиҰҒеӨ„зҗҶдёҖе ҶиҜ·жұӮпјүпјӣжүҖ д»ҘпјҢеҜ№дәҺдёҖдәӣеҸӘиҜ»зҡ„ж•°жҚ®пјҢжҲ‘д»Һж•°жҚ®еә“жӢҝеҲ°д№ӢеҗҺе°ұзј“еӯҳеңЁTomcatжң¬ең°пјҒ

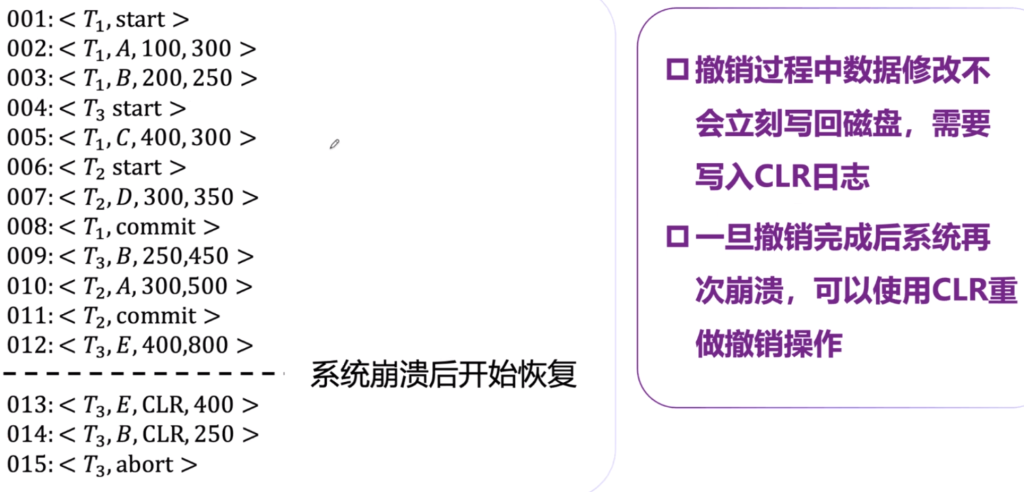

Memory Caching

Memcached

з®Җд»Ӣ

Memcached жҳҜдёҖдёӘй«ҳж•Ҳзҡ„зј“еӯҳзі»з»ҹпјҢеё®еҠ©жҸҗй«ҳзҪ‘з«ҷзҡ„жҖ§иғҪгҖӮе®ғеӯҳеӮЁдёҖдәӣж•°жҚ®еңЁеҶ…еӯҳдёӯпјҢд»ҘеҮҸиҪ»ж•°жҚ®еә“зҡ„иҙҹжӢ…гҖӮиҝҷдёӘзі»з»ҹжҳ“дәҺдҪҝз”ЁпјҢж”ҜжҢҒеӨҡз§Қзј–зЁӢиҜӯиЁҖгҖӮ

- й«ҳжҖ§иғҪпјҡMemcached иғҪеӨҹеҝ«йҖҹеӨ„зҗҶж•°жҚ®иҜ·жұӮпјҢйҖӮеҗҲй«ҳжөҒйҮҸзҡ„зҪ‘з«ҷгҖӮ

- еҲҶеёғејҸпјҡе®ғеҸҜд»ҘеңЁеӨҡеҸ°жңҚеҠЎеҷЁдёҠиҝҗиЎҢпјҢдҫҝдәҺжү©еұ•гҖӮ

- еҶ…еӯҳеӯҳеӮЁпјҡж•°жҚ®иў«еӯҳеӮЁеңЁеҶ…еӯҳдёӯпјҢиҜ»еҸ–йҖҹеәҰеҫҲеҝ«пјҢйҖӮеҗҲйў‘з№Ғи®ҝй—®зҡ„ж•°жҚ®гҖӮ

- з®ҖеҚ•зҡ„й”®еҖјеӯҳеӮЁпјҡж•°жҚ®д»Ҙй”®еҖјеҜ№зҡ„еҪўејҸеӯҳеӮЁпјҢж–№дҫҝеҝ«йҖҹжҹҘжүҫе’ҢдҪҝз”ЁгҖӮ

еҺҹзҗҶпјҡеӯҳеӮЁеңЁеҶ…еӯҳдёӯзҡ„KV

memcachedйҮҢйқўпјҢеә”иҜҘдё»иҰҒж”ҫзҪ®иҰҒз»ҸеёёиҜ»зҡ„ж•°жҚ®пјҢеҸҜд»Ҙжӣҙеҝ«иҜ»еҲ°пјҢеҶҷжқҘиҜҙж„Ҹд№үдёҚеӨ§

дҪҝз”ЁCachingе’ҢдёҚдҪҝз”ЁCachingж—¶й—ҙеҜ№жҜ”пјҢдҪҝз”ЁеҗҺ第дәҢж¬ЎеҸҠд»ҘеҗҺжҹҘиҜўжҳҫи‘—еҠ еҝ«

еҶ…еӯҳз®ЎзҗҶ

еңЁжІЎжңүдҪҝз”Ё Memcached зҡ„жғ…еҶөдёӢпјҢжҜҸдёӘ Web жңҚеҠЎеҷЁзҡ„зј“еӯҳеҶ…еӯҳжҳҜзӢ¬з«Ӣзҡ„пјҢеҲҶеҲ«дёә 64MBпјҢжҖ»зј“еӯҳдёә 64MBгҖӮ

дҪҝз”Ё Memcached еҗҺпјҢеҗ„дёӘжңҚеҠЎеҷЁзҡ„еҶ…еӯҳеҸҜд»Ҙз»„еҗҲеңЁдёҖиө·пјҢеҪўжҲҗдёҖдёӘ 128MB зҡ„жҖ»зј“еӯҳжұ гҖӮMemcached еҸҜд»ҘйҖҡиҝҮеҲҶеёғејҸзј“еӯҳдҪҝеҗ„дёӘиҠӮзӮ№е…ұдә«еҶ…еӯҳпјҢд»ҺиҖҢжӣҙеҘҪең°еҲ©з”ЁеҶ…еӯҳиө„жәҗгҖӮ

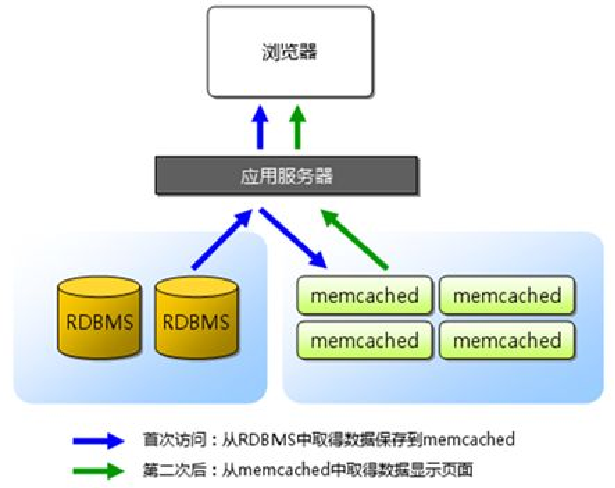

Memcached зҡ„ Slab еҲҶй…ҚжңәеҲ¶пјҢе®ғйҖҡиҝҮе°ҶеҶ…еӯҳеҲ’еҲҶжҲҗеӨҡдёӘвҖңSlab ClassвҖқжқҘз®ЎзҗҶдёҚеҗҢеӨ§е°Ҹзҡ„ж•°жҚ®гҖӮжҜҸдёӘ Slab Class еҢ…еҗ«еӨҡдёӘ ChunkпјҢжҜҸдёӘ Chunk зҡ„еӨ§е°ҸжҳҜзӣёеҗҢзҡ„гҖӮ

жҜҸдёӘ Slab Class еҜ№еә”дёҚеҗҢзҡ„ Chunk еӨ§е°ҸпјҢжҜ”еҰӮеӣҫзүҮдёӯзҡ„ Slab Class 1 зҡ„ Chunk еӨ§е°ҸжҳҜ 88 еӯ—иҠӮпјҢSlab Class 2 жҳҜ 112 еӯ—иҠӮпјҢдҫқж¬Ўзұ»жҺЁгҖӮ

дҫӢеҰӮеҪ“еӯҳеӮЁдёҖдёӘ 100 еӯ—иҠӮзҡ„йЎ№зӣ®ж—¶пјҢMemcached дјҡйҖүжӢ©дёҖдёӘжңҖйҖӮеҗҲзҡ„ Slab ClassпјҲжҜ”еҰӮеҢ…еҗ« 112 еӯ—иҠӮ Chunk зҡ„ Slab Class 2пјүжқҘеӯҳеӮЁиҜҘж•°жҚ®йЎ№гҖӮеҪ“然еҜ№дәҺvarcharиҝҳжҳҜдёӨз«Ҝж”ҫпјҢеӣ дёәдёҚзҹҘйҒ“ж•°жҚ®еӨҡй•ҝгҖӮ

еҪ“еӯҳж»Ўд№ӢеҗҺпјҢдјҡж”ҫеңЁзЎ¬зӣҳйҮҢйқўпјҲдёҖиҲ¬жҳҜеңЁжңҚеҠЎеҷЁзЎ¬зӣҳпјүпјҢзӣёжҜ”дәҺд»Һж•°жҚ®еә“иҜ»иҝҳжҳҜеҝ«дёҖдәӣгҖӮ

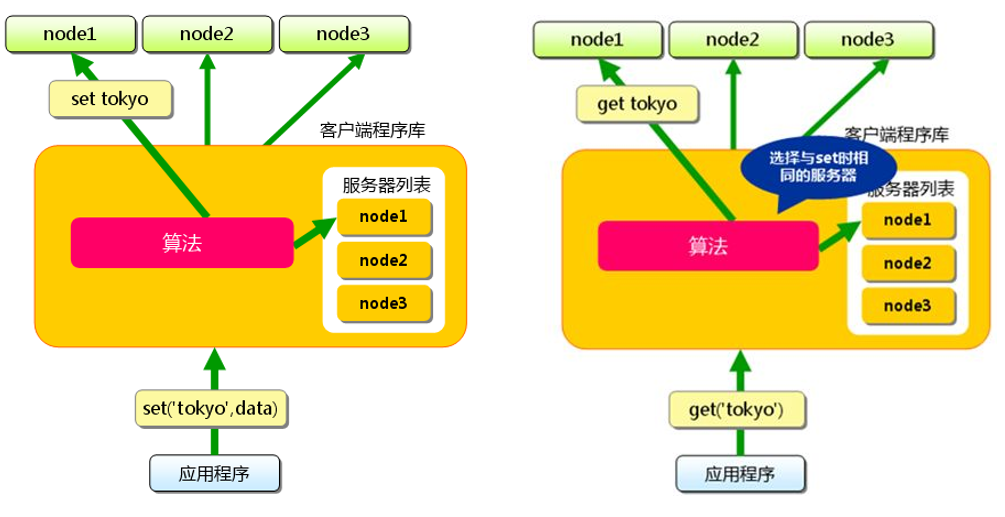

иҠӮзӮ№д№Ӣй—ҙдёҚйңҖиҰҒйҖҡдҝЎпјҢжү§иЎҢд»Јз Ғж—¶еҖҷдјҡиҮӘеҠЁеҸ–иҠӮзӮ№еҜ»жүҫпјҢи§ҒдёҖиҮҙжҖ§е“ҲеёҢ

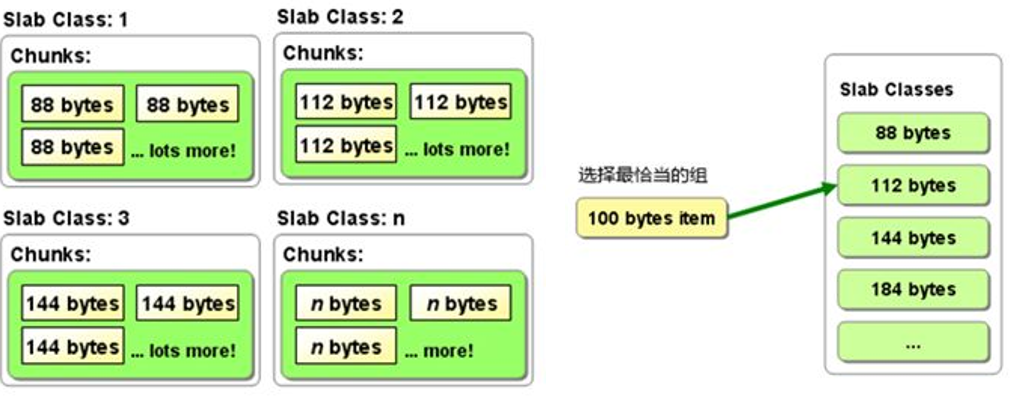

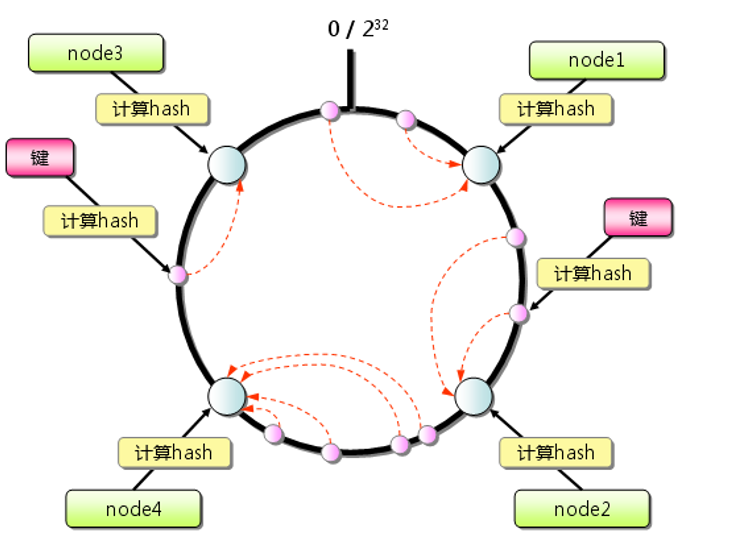

дёҖиҮҙжҖ§е“ҲеёҢпјҲConsistent Hashingпјү

дёҖиҮҙжҖ§е“ҲеёҢжҳҜдёҖз§Қз”ЁдәҺеҲҶеёғејҸзј“еӯҳзі»з»ҹзҡ„ж•°жҚ®еҲҶеёғз®—жі•гҖӮе®ғйҖҡиҝҮе°ҶиҠӮзӮ№е’Ңж•°жҚ®йЎ№жҳ е°„еҲ°дёҖдёӘе“ҲеёҢзҺҜдёҠпјҢдҪҝеҫ—еҪ“иҠӮзӮ№еҸ‘з”ҹеўһеҮҸж—¶пјҢд»…дјҡеҪұе“ҚдёҖе°ҸйғЁеҲҶзҡ„ж•°жҚ®пјҢд»ҺиҖҢе®һзҺ°й«ҳж•Ҳзҡ„ж•°жҚ®еҲҶй…ҚдёҺз®ЎзҗҶгҖӮ

е·ҘдҪңеҺҹзҗҶ

- е“ҲеёҢзҺҜпјҲHash RingпјүпјҡдёҖиҮҙжҖ§е“ҲеёҢе°ҶжүҖжңүзҡ„иҠӮзӮ№е’Ңж•°жҚ®йЎ№ж №жҚ®е…¶е“ҲеёҢеҖјжҳ е°„еҲ°дёҖдёӘе“ҲеёҢзҺҜдёҠгҖӮе“ҲеёҢеҖјзҡ„иҢғеӣҙйҖҡеёёжҳҜ

[0, 2^32)гҖӮ - иҠӮзӮ№жҳ е°„пјҡжҜҸдёӘиҠӮзӮ№пјҲеҰӮзј“еӯҳжңҚеҠЎеҷЁпјүеңЁе“ҲеёҢзҺҜдёҠеҚ жҚ®зү№е®ҡзҡ„дҪҚзҪ®пјҢдҪҚзҪ®з”ұиҠӮзӮ№зҡ„е“ҲеёҢеҖјеҶіе®ҡгҖӮ

- ж•°жҚ®йЎ№жҳ е°„пјҡжҜҸдёӘж•°жҚ®йЎ№пјҲKeyпјүйҖҡиҝҮе“ҲеёҢеҮҪж•°и®Ўз®—еҮәе“ҲеёҢеҖјпјҢд»ҺиҖҢзЎ®е®ҡеңЁе“ҲеёҢзҺҜдёҠзҡ„дҪҚзҪ®гҖӮ

- ж•°жҚ®еӯҳеӮЁи§„еҲҷпјҡдёҖдёӘж•°жҚ®йЎ№дјҡеӯҳеӮЁеңЁвҖңйЎәж—¶й’Ҳж–№еҗ‘дёҠзҡ„第дёҖдёӘиҠӮзӮ№вҖқдёҠгҖӮеҚіпјҢе“ҲеёҢеҖјеңЁзҺҜдёҠйЎәж—¶й’ҲйҒҮеҲ°зҡ„第дёҖдёӘиҠӮзӮ№еҚідёәзӣ®ж ҮиҠӮзӮ№гҖӮ

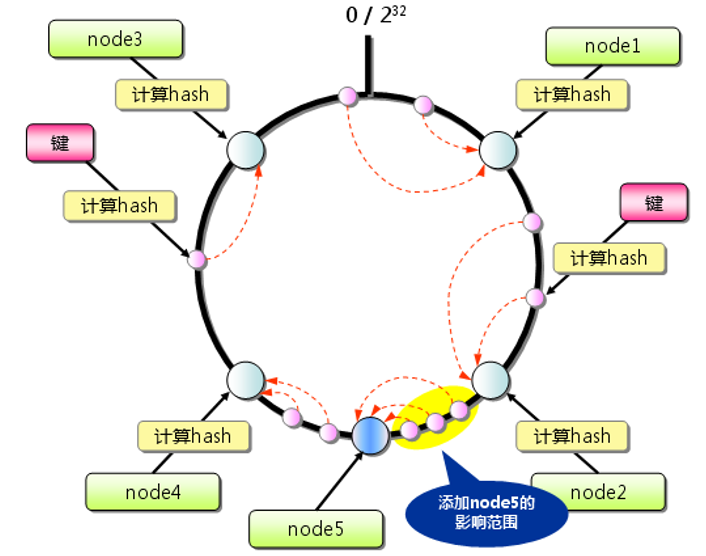

зү№зӮ№

- еҮҸе°‘ж•°жҚ®иҝҒ移пјҡеңЁиҠӮзӮ№еўһеҠ жҲ–移йҷӨж—¶пјҢд»…еҪұе“ҚзҺҜдёҠдёҺиҜҘиҠӮзӮ№зӣёйӮ»зҡ„ж•°жҚ®йЎ№пјҢе…¶д»–ж•°жҚ®дёҚдјҡйҮҚж–°еҲҶй…ҚпјҢйҒҝе…ҚдәҶеӨ§и§„жЁЎзҡ„ж•°жҚ®иҝҒ移гҖӮиҝҷеңЁе®һйҷ…еә”з”ЁдёӯиғҪеӨҹжҳҫи‘—жҸҗй«ҳзі»з»ҹзҡ„зЁіе®ҡжҖ§е’Ңжү©еұ•жҖ§гҖӮ

- иҙҹиҪҪеқҮиЎЎпјҡдёҖиҮҙжҖ§е“ҲеёҢиғҪеӨҹе°Ҷж•°жҚ®еқҮеҢҖең°еҲҶеёғеңЁеӨҡдёӘиҠӮзӮ№дёҠпјҢд»ҺиҖҢе®һзҺ°иҙҹиҪҪеқҮиЎЎгҖӮ

- жү©еұ•жҖ§ејәпјҡж”ҜжҢҒеҠЁжҖҒж·»еҠ жҲ–移йҷӨиҠӮзӮ№пјҢ并且еҪұе“ҚиҢғеӣҙе°ҸпјҢж–№дҫҝзі»з»ҹзҡ„жЁӘеҗ‘жү©еұ•гҖӮ

еӣҫи§ЈиҜҙжҳҺ

- еҲқе§ӢзҠ¶жҖҒпјҡе·Ұеӣҫеұ•зӨәдәҶдёҖдёӘеҢ…еҗ«

node1гҖҒnode2гҖҒnode3е’Ңnode4зҡ„е“ҲеёҢзҺҜгҖӮж•°жҚ®йЎ№ж №жҚ®е“ҲеёҢеҖјеңЁзҺҜдёҠжүҫеҲ°жңҖжҺҘиҝ‘зҡ„иҠӮзӮ№иҝӣиЎҢеӯҳеӮЁгҖӮ - иҠӮзӮ№ж·»еҠ пјҡеҸіеӣҫеұ•зӨәдәҶеўһеҠ

node5еҗҺзҡ„еҸҳеҢ–гҖӮж–°иҠӮзӮ№node5еҠ е…ҘеҗҺпјҢд»…еҪұе“ҚдәҶйғЁеҲҶж•°жҚ®йЎ№зҡ„еӯҳеӮЁдҪҚзҪ®пјҲдҪҚдәҺ node4 е’Ң node2 д№Ӣй—ҙзҡ„ж•°жҚ®йЎ№пјүпјҢиҖҢе…¶д»–ж•°жҚ®йЎ№зҡ„дҪҚзҪ®дҝқжҢҒдёҚеҸҳгҖӮеҲ йҷӨд№ҹеҗҢзҗҶ

Redis

Redis жҳҜдёҖз§Қиў«з§°дёәй”®еҖјеӯҳеӮЁпјҲKey-Value Storeпјүзҡ„ж•°жҚ®еә“зұ»еһӢпјҢйҖҡеёёеҪ’зұ»дёә NoSQL ж•°жҚ®еә“гҖӮй”®еҖјеӯҳеӮЁзҡ„ж ёеҝғеңЁдәҺе°Ҷж•°жҚ®пјҲз§°дёәеҖјпјүеӯҳеӮЁеңЁдёҖдёӘе”ҜдёҖзҡ„й”®дёӢгҖӮ

- ејҖжәҗдёҺи®ёеҸҜпјҡRedis жҳҜдёҖдёӘејҖжәҗйЎ№зӣ®пјҢеҹәдәҺ BSD и®ёеҸҜиҜҒеҸ‘еёғгҖӮ

- й«ҳзә§й”®еҖјеӯҳеӮЁпјҡдёҺе…¶д»–й”®еҖјеӯҳеӮЁдёҚеҗҢпјҢRedis дёҚд»…еҸҜд»ҘеӯҳеӮЁеӯ—з¬ҰдёІзұ»еһӢзҡ„еҖјпјҢиҝҳж”ҜжҢҒдё°еҜҢзҡ„ж•°жҚ®з»“жһ„пјҢеҢ…жӢ¬пјҡ

| ж•°жҚ®з»“жһ„зұ»еһӢ | еҢ…еҗ«зҡ„еҶ…е®№ | з»“жһ„иҜ»/еҶҷиғҪеҠӣ |

|---|---|---|

| STRING | еӯ—з¬ҰдёІгҖҒж•ҙж•°жҲ–жө®зӮ№ж•°еҖј | еҜ№ж•ҙдёӘеӯ—з¬ҰдёІжҲ–йғЁеҲҶеӯ—з¬ҰдёІиҝӣиЎҢж“ҚдҪңпјҢеўһеҠ /еҮҸе°‘ж•ҙж•°е’Ңжө®зӮ№ж•°еҖј |

| LIST | еӯ—з¬ҰдёІзҡ„й“ҫиЎЁ | д»ҺдёӨз«ҜжҺЁйҖҒжҲ–еј№еҮәе…ғзҙ пјҢж №жҚ®еҒҸ移йҮҸиҝӣиЎҢдҝ®еүӘпјҢиҜ»еҸ–еҚ•дёӘжҲ–еӨҡдёӘе…ғзҙ пјҢжҢүеҖјжҹҘжүҫжҲ–еҲ йҷӨе…ғзҙ пјҢиҢғеӣҙжҹҘжүҫиҫғж…ў |

| SET | ж— еәҸзҡ„е”ҜдёҖеӯ—з¬ҰдёІйӣҶеҗҲ | ж·»еҠ гҖҒиҺ·еҸ–жҲ–еҲ йҷӨеҚ•дёӘе…ғзҙ пјҢжЈҖжҹҘжҲҗе‘ҳе…ізі»пјҢиҝӣиЎҢдәӨйӣҶгҖҒ并йӣҶгҖҒе·®йӣҶиҝҗз®—пјҢиҺ·еҸ–йҡҸжңәе…ғзҙ |

| HASH | ж— еәҸзҡ„й”®еҖјеҜ№е“ҲеёҢиЎЁ | ж·»еҠ гҖҒиҺ·еҸ–жҲ–еҲ йҷӨеҚ•дёӘе…ғзҙ пјҢиҺ·еҸ–ж•ҙдёӘе“ҲеёҢиЎЁ |

| ZSET (Sorted Set) | жңүеәҸзҡ„еӯ—з¬ҰдёІжҲҗе‘ҳеҲ°жө®зӮ№ж•°еҲҶж•°зҡ„жҳ е°„пјҢжҢүеҲҶж•°жҺ’еәҸ | ж·»еҠ гҖҒиҺ·еҸ–жҲ–еҲ йҷӨеҚ•дёӘе…ғзҙ пјҢж №жҚ®еҲҶж•°иҢғеӣҙжҲ–жҲҗе‘ҳеҖјиҺ·еҸ–е…ғзҙ |

еҶ…еӯҳдёҺжҢҒд№…еҢ–

Redis дё»иҰҒеңЁеҶ…еӯҳдёӯе·ҘдҪңпјҢд»ҘжӯӨжқҘе®һзҺ°еҮәиүІзҡ„жҖ§иғҪгҖӮиҝҷж„Ҹе‘ізқҖж•°жҚ®зҡ„и®ҝй—®йҖҹеәҰйқһеёёеҝ«гҖӮж №жҚ®дёҚеҗҢзҡ„еә”з”ЁйңҖжұӮпјҢRedis жҸҗдҫӣдәҶеӨҡз§ҚжҢҒд№…еҢ–ж–№ејҸпјҡ

- еҝ«з…§пјҲSnapshottingпјүпјҡе®ҡжңҹе°Ҷж•°жҚ®йӣҶеҝ«з…§пјҲdumpпјүдҝқеӯҳеҲ°зЈҒзӣҳдёӯгҖӮ

- AOF ж—Ҙеҝ—пјҲAppend-Only FileпјүпјҡжҜҸж¬Ўжү§иЎҢе‘Ҫд»Өж—¶пјҢе°Ҷе…¶йҷ„еҠ еҲ°ж—Ҙеҝ—ж–Ү件дёӯгҖӮ

Redis ж”ҜжҢҒз®ҖеҚ•й…ҚзҪ®зҡ„дё»д»ҺеӨҚеҲ¶пјҲMaster-Slave ReplicationпјүпјҲзј“еӯҳжҖҺд№Ҳдјҡжңүдё»д»ҺеӨҮд»Ҫпјҹеӣ дёәжңүдәәжҠҠе®ғеҪ“NoSQLж•°жҚ®еә“з”ЁвҖҰвҖҰпјүпјҢе…¶зү№жҖ§еҢ…жӢ¬пјҡ

- еҝ«йҖҹйқһйҳ»еЎһзҡ„еҲқж¬ЎеҗҢжӯҘпјҡдё»иҠӮзӮ№дёҺд»ҺиҠӮзӮ№зҡ„еҲқж¬Ўж•°жҚ®еҗҢжӯҘйқһеёёеҝ«йҖҹдё”дёҚйҳ»еЎһгҖӮ

- иҮӘеҠЁйҮҚиҝһпјҡеңЁзҪ‘з»ңеҲҶиЈӮпјҲеҰӮзҪ‘з»ңж•…йҡңпјүеҗҺпјҢRedis еҸҜд»ҘиҮӘеҠЁйҮҚиҝһ并继з»ӯеҗҢжӯҘгҖӮ

Redisдёӯеә”иҜҘж”ҫзҡ„жңүпјҡ1. з»Ҹеёёз”ЁеҲ°зҡ„дёңиҘҝ 2. з»Ҹеёёж¶үеҸҠеҲ°иҜ»еҸ–ж“ҚдҪңзҡ„пјҢиҖҢеҫҲе°‘ж¶үеҸҠеҲ°еҶҷзҡ„ж“ҚдҪңзҡ„ 3. дёӯй—ҙи®Ўз®—зҡ„з»“жһң 4. з»ҸеёёиҰҒеҶҷзҡ„дёңиҘҝдёҚиҰҒж”ҫе…Ҙзј“еӯҳ

еәҸеҲ—еҢ–пјҡдёӨдёӘиҝӣзЁӢд№Ӣй—ҙйҖҡдҝЎеҫҲйә»зғҰпјҢеҜ№дәҺTomcatе’ҢredisжҳҜдёӨдёӘиҝӣзЁӢгҖӮиҝӣзЁӢй—ҙжүҖи°“зҡ„йҖҡдҝЎе°ұжҳҜ дј иҫ“ж•°жҚ®пјӣжҜ”еҰӮжҲ‘иҰҒдј иҫ“дёҖдёӘobjectпјҢжҲ‘жҠҠе®ғиҪ¬еҢ–дёәдёҖдёӘеӯ—иҠӮж•°з»„ byte[] пјҢиҝҷе°ұжҳҜеәҸеҲ—еҢ–пјӣ然еҗҺдҪ 收еҲ°дәҶиҝҷдёӘеӯ—иҠӮж•°з»„пјҢдҪ е°ұжҠҠе®ғеҸҚеәҸеҲ—еҢ–пјҢе°ұеҸҳжҲҗдәҶдёҖдёӘobjectгҖӮ

еә”з”ЁеңәжҷҜпјҡRedis з”ұдәҺе…¶дё°еҜҢзҡ„ж•°жҚ®з»“жһ„гҖҒеҶ…еӯҳдёӯж“ҚдҪңзҡ„й«ҳжҖ§иғҪе’ҢжҢҒд№…еҢ–зү№жҖ§пјҢиў«е№ҝжіӣз”ЁдәҺзј“еӯҳгҖҒе®һж—¶еҲҶжһҗгҖҒж¶ҲжҒҜйҳҹеҲ—зӯүеңәжҷҜгҖӮ

| еҗҚз§° | зұ»еһӢ | ж•°жҚ®еӯҳеӮЁйҖүйЎ№ | жҹҘиҜўзұ»еһӢ | йҷ„еҠ еҠҹиғҪ |

|---|---|---|---|---|

| Redis | еҶ…еӯҳдёӯзҡ„йқһе…ізі»еһӢж•°жҚ®еә“ | еӯ—з¬ҰдёІгҖҒеҲ—иЎЁгҖҒйӣҶеҗҲгҖҒе“ҲеёҢгҖҒжңүеәҸйӣҶеҗҲ | й’ҲеҜ№жҜҸз§Қж•°жҚ®зұ»еһӢзҡ„еёёз”Ёи®ҝй—®жЁЎејҸе‘Ҫд»ӨгҖҒжү№йҮҸж“ҚдҪңе’ҢйғЁеҲҶдәӢеҠЎж”ҜжҢҒ | еҸ‘еёғ/и®ўйҳ…гҖҒдё»/д»ҺеӨҚеҲ¶гҖҒзЈҒзӣҳжҢҒд№…еҢ–гҖҒи„ҡжң¬пјҲеӯҳеӮЁиҝҮзЁӢпјү |

| Memcached | еҶ…еӯҳдёӯзҡ„й”®еҖјзј“еӯҳ | й”®еҲ°еҖјзҡ„жҳ е°„ | еҲӣе»әгҖҒиҜ»еҸ–гҖҒжӣҙж–°гҖҒеҲ йҷӨе‘Ҫд»Өд»ҘеҸҠе°‘ж•°е…¶д»–е‘Ҫд»Ө | еӨҡзәҝзЁӢжңҚеҠЎеҷЁд»ҘеўһејәжҖ§иғҪ |

| MySQL | е…ізі»еһӢж•°жҚ®еә“ | иЎҢиЎЁгҖҒиЎЁи§ҶеӣҫгҖҒз©әй—ҙж•°жҚ®е’Ң第дёүж–№жү©еұ•зҡ„ж•°жҚ®еә“ | SELECTгҖҒINSERTгҖҒUPDATEгҖҒDELETEгҖҒеҮҪж•°гҖҒеӯҳеӮЁиҝҮзЁӢ | з¬ҰеҗҲ ACIDпјҲдҪҝз”Ё InnoDBпјүгҖҒдё»/д»ҺеӨҚеҲ¶е’Ңдё»/дё»еӨҚеҲ¶ |

| PostgreSQL | е…ізі»еһӢж•°жҚ®еә“ | иЎҢиЎЁгҖҒиЎЁи§ҶеӣҫгҖҒз©әй—ҙж•°жҚ®гҖҒ第дёүж–№жү©еұ•гҖҒиҮӘе®ҡд№үзұ»еһӢзҡ„ж•°жҚ®еә“ | SELECTгҖҒINSERTгҖҒUPDATEгҖҒDELETEгҖҒеҶ…зҪ®еҮҪж•°гҖҒиҮӘе®ҡд№үеӯҳеӮЁиҝҮзЁӢ | з¬ҰеҗҲ ACIDпјҢдё»/д»ҺеӨҚеҲ¶пјҢеӨҡдё»еӨҚеҲ¶пјҲ第дёүж–№пјү |

| MongoDB | еҹәдәҺзЈҒзӣҳзҡ„йқһе…ізі»еһӢж–ҮжЎЈеӯҳеӮЁ | ж— жЁЎејҸ BSON ж–ҮжЎЈзҡ„иЎЁ | еҲӣе»әгҖҒиҜ»еҸ–гҖҒжӣҙж–°гҖҒеҲ йҷӨгҖҒжқЎд»¶жҹҘиҜўзӯүе‘Ҫд»Ө | ж”ҜжҢҒ Map-Reduce ж“ҚдҪңгҖҒдё»/д»ҺеӨҚеҲ¶гҖҒеҲҶзүҮгҖҒз©әй—ҙзҙўеј• |

жҹҘжүҫиҝҮзЁӢпјҡе…ҲеҺ»еҶ…еӯҳйҮҢйқўжҹҘжүҫпјҢжҹҘиҜўеӨұиҙҘеҗҺе°ұд»Һж•°жҚ®еә“йҮҢйқўиҜ»пјҢиҜ»еҮәжқҘеҗҺж”ҫеҲ°еҶ…еӯҳйҮҢйқўгҖӮдёӢж¬ЎиҜ»еҸ–зӣҙжҺҘд»ҺеҶ…еӯҳдёӯиҺ·еҸ–гҖӮеҪ“жӣҙж”№еҸҜд»ҘеңЁеҶ…еӯҳйҮҢйқўжӣҙж”№еҖјпјҢдҝқиҜҒжҹҘиҜўж—¶дёҖиҮҙжҖ§гҖӮ

еҲҶеёғејҸзј“еӯҳ

дёәд»Җд№ҲйңҖиҰҒеҲҶеёғејҸзј“еӯҳпјҡеӣ дёәдёҖдёӘжңәеҷЁзҡ„зј“еӯҳеҸҜиғҪдёҚеӨҹпјҢзү©зҗҶдёҠеӨҡдёӘжңәеҷЁпјҢе®һйҷ…йҖ»иҫ‘дёҠжҳҜдёҖдёӘеӨ§зҡ„ зј“еӯҳпјҢеҸҜд»Ҙе……еҲҶеҲ©з”ЁеӨҡдёӘжңәеҷЁзҡ„еҶ…еӯҳпјӣ зЁіе®ҡеҸҜд»ҘеӨҮд»ҪпјҢеҸҜйқ жҖ§еўһеҠ гҖӮ

第八з«

еҸҚеҗ‘зҙўеј•е’ҢжӯЈеҗ‘зҙўеј•

еҸҚеҗ‘зҙўеј•пјҢд№ҹз§°дёәвҖҢеҖ’жҺ’зҙўеј•пјҲInverted IndexпјүпјҢжҳҜдёҖз§Қзҙўеј•ж–№жі•пјҢз”ЁдәҺеӯҳеӮЁжҜҸдёӘиҜҚжҲ–зҹӯиҜӯеңЁж–ҮжЎЈдёӯзҡ„дҪҚзҪ®дҝЎжҒҜгҖӮеҖ’жҺ’зҙўеј•йҖҡиҝҮи®°еҪ•жҜҸдёӘиҜҚеҮәзҺ°зҡ„ж–ҮжЎЈеҲ—иЎЁжқҘе·ҘдҪңпјҢдҪҝеҫ—еңЁжҹҘиҜўж—¶еҸҜд»Ҙеҝ«йҖҹжүҫеҲ°еҢ…еҗ«зү№е®ҡиҜҚжұҮзҡ„жүҖжңүж–ҮжЎЈгҖӮиҝҷз§Қзҙўеј•ж–№жі•еңЁе…Ёж–Үжҗңзҙўдёӯйқһеёёжңүж•ҲпјҢеӣ дёәе®ғе…Ғи®ёз”ЁжҲ·еҝ«йҖҹжүҫеҲ°еҢ…еҗ«жҹҗдёӘе…ій”®иҜҚзҡ„жүҖжңүзӣёе…іж–ҮжЎЈгҖӮвҖҢ

Luceneзҡ„termsзҙўеј•еұһдәҺиў«з§°дёәеҸҚеҗ‘зҙўеј•пјҢиҝҷжҳҜеӣ дёәе®ғеҸҜд»ҘеҲ—еҮәдёҖдёӘitemдёӯеҢ…еҗ«е®ғзҡ„ж–ҮжЎЈпјҢиҝҷдёҺж–ҮжЎЈеҲ—еҮәжңҜиҜӯзҡ„иҮӘ然关系зӣёеҸҚ

жӯЈеҗ‘зҙўеј•пјҲForward Indexпјүпјҡ жӯЈеҗ‘зҙўеј•жҳҜдёҖз§ҚжҢүж–ҮжЎЈжқҘз»„з»Үе’ҢеӯҳеӮЁж–Үжң¬ж•°жҚ®зҡ„зҙўеј•ж–№ејҸгҖӮжҜҸдёӘж–ҮжЎЈйғҪжңүдёҖдёӘеҜ№еә”зҡ„зҙўеј•йЎ№пјҢ иҝҷдёӘзҙўеј•йЎ№еҢ…еҗ«дәҶж–ҮжЎЈдёӯзҡ„жүҖжңүдҝЎжҒҜпјҢйҖҡеёёд»Ҙж–ҮжЎЈзҡ„ж ҮиҜҶз¬ҰпјҲеҰӮж–ҮжЎЈIDпјүдёәзҙўеј•зҡ„й”®гҖӮ жӯЈеҗ‘зҙўеј•йҖӮеҗҲдәҺйңҖиҰҒжҢүж–ҮжЎЈиҝӣиЎҢжЈҖзҙўзҡ„еңәжҷҜпјҢдҫӢеҰӮеңЁж–ҮжЎЈз®ЎзҗҶзі»з»ҹдёӯжҹҘжүҫзү№е®ҡж–ҮжЎЈжҲ–ж №жҚ®ж–ҮжЎЈеұһжҖ§иҝӣиЎҢиҝҮж»Өе’ҢжҺ’еәҸгҖӮ зјәзӮ№жҳҜеңЁеӨ„зҗҶеӨ§йҮҸж–Үжң¬ж•°жҚ®ж—¶пјҢжӯЈеҗ‘зҙўеј•еҸҜиғҪйңҖиҰҒеӨ§йҮҸзҡ„еӯҳеӮЁз©әй—ҙпјҢеӣ дёәжҜҸдёӘж–ҮжЎЈйғҪйңҖиҰҒдёҖдёӘ е®Ңж•ҙзҡ„зҙўеј•йЎ№гҖӮ

- жӯЈеҗ‘зҙўеј•йҖӮз”ЁдәҺйңҖиҰҒжҢүж–ҮжЎЈжЈҖзҙўзҡ„еә”з”ЁпјҢдҫӢеҰӮж–ҮжЎЈз®ЎзҗҶзі»з»ҹжҲ–еҶ…е®№еұ•зӨәгҖӮ

- еҸҚеҗ‘зҙўеј•йҖӮз”ЁдәҺйңҖиҰҒе…Ёж–Үжҗңзҙўе’Ңе…ій”®иҜҚжЈҖзҙўзҡ„еә”з”ЁпјҢдҫӢеҰӮжҗңзҙўеј•ж“Һе’ҢдҝЎжҒҜжЈҖзҙўзі»з»ҹгҖӮ

- жӯЈеҗ‘зҙўеј•йңҖиҰҒжӣҙеӨҡзҡ„еӯҳеӮЁз©әй—ҙпјҢдҪҶеңЁи®ҝй—®зү№е®ҡж–ҮжЎЈж—¶йҖҹеәҰиҫғеҝ«гҖӮ

- еҸҚеҗ‘зҙўеј•еҚ з”Ёиҫғе°‘зҡ„еӯҳеӮЁз©әй—ҙпјҢдҪҶеңЁе…Ёж–Үжҗңзҙўе’Ңе…ій”®иҜҚжЈҖзҙўж—¶йҖҹеәҰжӣҙеҝ«гҖӮ

йҖҡеёёпјҢжҗңзҙўеј•ж“Һдјҡз»“еҗҲдҪҝз”ЁжӯЈеҗ‘зҙўеј•е’ҢеҸҚеҗ‘зҙўеј•пјҢд»Ҙж»Ўи¶ідёҚеҗҢзҡ„жЈҖзҙўйңҖжұӮпјҢ并жҸҗдҫӣй«ҳж•Ҳзҡ„жҗңзҙўдҪ“ йӘҢгҖӮжӯЈеҗ‘зҙўеј•з”ЁдәҺеҝ«йҖҹиҺ·еҸ–ж–ҮжЎЈзҡ„иҜҰз»ҶдҝЎжҒҜпјҢиҖҢеҸҚеҗ‘зҙўеј•з”ЁдәҺй«ҳж•Ҳең°жүҫеҲ°еҢ…еҗ«жҹҘиҜўе…ій”®иҜҚзҡ„ж–ҮжЎЈгҖӮ

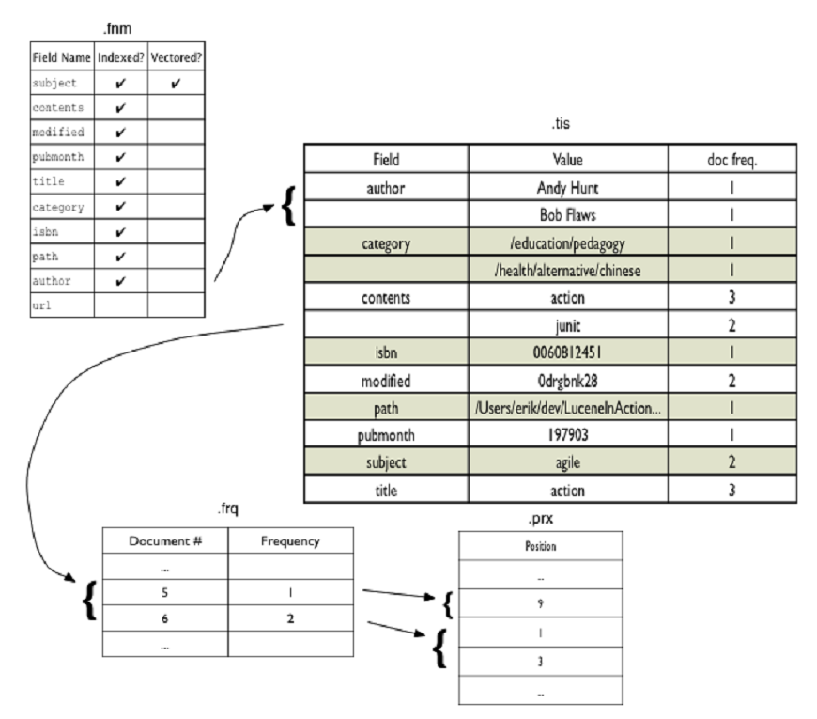

Lucene

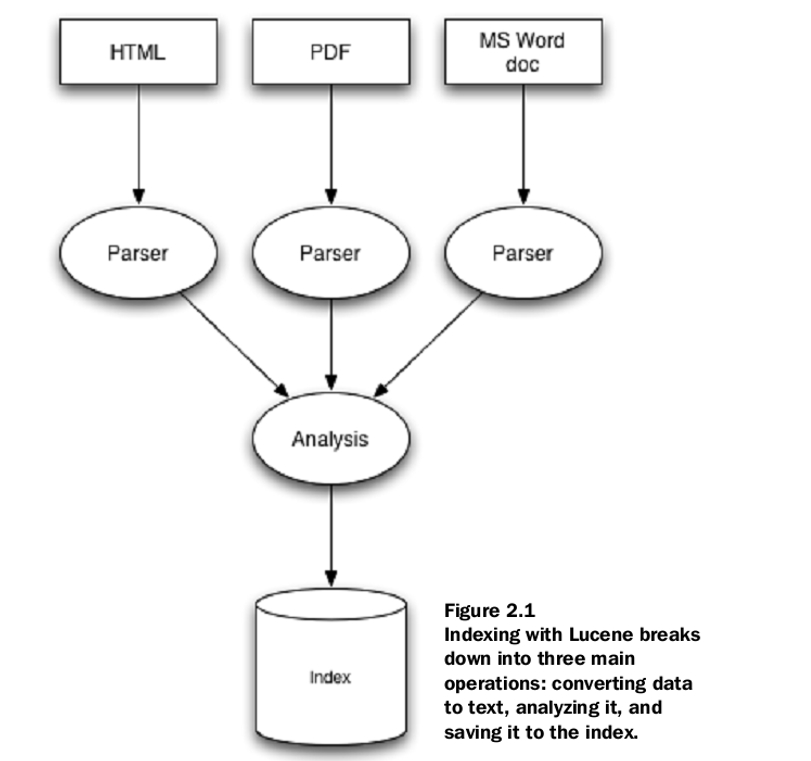

LuceneжҳҜдёҖдёӘй«ҳжҖ§иғҪгҖҒеҸҜжү©еұ•зҡ„дҝЎжҒҜжЈҖзҙўпјҲIRпјүеә“гҖӮз”ЁжқҘе»әз«Ӣзҙўеј•пјҲеҰӮжһңдёҚе»әз«Ӣзҙўеј•пјҢжҜҸж¬ЎйғҪиҰҒжү«жҸҸжүҖжңүзҡ„ж–Ү件пјҢж•ҲзҺҮеӨӘдҪҺпјүе’ҢжҗңзҙўгҖӮ

йҖӮй…ҚиҢғеӣҙпјҡеӨ§йҮҸйқһз»“жһ„еҢ–зҡ„ж–Үжң¬пјҢдҫӢеҰӮжҗңзҙўеј•ж“ҺгҖӮ

еҒҮи®ҫйңҖиҰҒжҗңзҙўеӨ§йҮҸж–Ү件пјҢ并且еёҢжңӣиғҪеӨҹжүҫеҲ°еҢ…еҗ«жҹҗдёӘеҚ•иҜҚжҲ–зҹӯиҜӯзҡ„ж–Ү件пјҢи§ЈеҶіж–№жі•пјҡ

еҜ№иҜҘж–Үжң¬иҝӣиЎҢзҙўеј•пјҢ并е°Ҷе…¶иҪ¬жҚўдёәдёҖз§ҚеҸҜд»Ҙеҝ«йҖҹжҗңзҙўзҡ„ж јејҸпјҢд»ҺиҖҢж¶ҲйҷӨзј“ж…ўзҡ„йЎәеәҸжү«жҸҸиҝҮзЁӢгҖӮ

иҝҷз§ҚиҪ¬жҚўиҝҮзЁӢз§°дёәзҙўеј•пјҢе…¶иҫ“еҮәз§°дёәзҙўеј•гҖӮ

жҗңзҙўеҚіеңЁзҙўеј•дёӯжҹҘжүҫеҚ•иҜҚд»ҘжүҫеҲ°е®ғ们еҮәзҺ°зҡ„ж–ҮжЎЈзҡ„иҝҮзЁӢгҖӮ

жҗңзҙўзҡ„иҙЁйҮҸйҖҡеёёдҪҝз”ЁзІҫзЎ®еәҰе’ҢеҸ¬еӣһзҺҮжҢҮж ҮжқҘжҸҸиҝ°гҖӮеҪ“然д№ҹеҢ…жӢ¬йҖҹеәҰе’Ңеҝ«йҖҹжҗңзҙўеӨ§йҮҸж–Үжң¬зҡ„иғҪеҠӣпјҢж”ҜжҢҒеҚ•иҜҚе’ҢеӨҡиҜҚжҹҘиҜўгҖҒзҹӯиҜӯжҹҘиҜўгҖҒйҖҡй…Қз¬ҰгҖҒз»“жһңжҺ’еҗҚе’ҢжҺ’еәҸд№ҹеҫҲйҮҚиҰҒпјҢиҫ“е…ҘиҝҷдәӣжҹҘиҜўзҡ„еҸӢеҘҪиҜӯжі•д№ҹеҫҲйҮҚиҰҒгҖӮ

е…Ёж–Үжҗңзҙў

зұ»дјјзҷҫеәҰзҡ„зҪ‘з«ҷпјҢз”ЁжҲ·жҗңзҙўдёҖдёӘе…ій”®иҜҚпјҢж №жҚ®е»әз«Ӣзҡ„зҙўеј•пјҢжҹҘжүҫеҢ…жӢ¬е…ій”®иҜҚзҡ„зӣёе…ізҡ„йқһз»“жһ„еҢ–зҡ„ж•°жҚ®йҮҢйқўжңүе“ӘдәӣеҢ…еҗ«зӣ®ж Үе…ій”®иҜҚгҖӮ

з»“жһ„еҢ–пјҡеҰӮж•°жҚ®еә“пјҢжүҖжңүж•°жҚ®жҳҜschemaзҡ„пјҢж•°жҚ®жңүеӯ—ж®өпјҢеғҸиЎЁж јпјҢжҳҜжңүз»“жһ„зҡ„пјӣдҪҶиҝҷйҮҢ жҜ”еҰӮжҲ‘з»ҷдҪ дёҖдёӘhtmlпјҢжҲ–иҖ…дёҖж®өtxtпјҢиҝҷз§ҚдёңиҘҝжҳҜжІЎжңүз»“жһ„еҸҜеҜ»зҡ„гҖӮ

- з»“жһ„еҢ–ж•°жҚ®е»әз«Ӣзҙўеј•зҡ„ж–№ејҸпјҡB+ж ‘е°ұеҸҜд»Ҙ

- йӮЈйқһз»“жһ„еҢ–ж•°жҚ®жҖҺд№ҲеҠһе‘ўпјҹжҜ”еҰӮжңүдёҖдёӘdirзӣ®еҪ•пјҢйҮҢйқўжңүдёҖеӨ§е Ҷ.txtпјҢе’Ңhtmlж–Ү件пјҢжҲ‘иҰҒй—®иҝҷдёӘзӣ®еҪ•йҮҢйқўеҢ…еҗ«е…ій”®иҜҚjavaзҡ„ж–Ү件жңүе“Әдәӣпјҹ

е»әз«Ӣзҙўеј•

еҰӮжһңжҲ‘жҗңзҙўjavaпјҢдҪ иҰҒе‘ҠиҜүжҲ‘javaеҮәзҺ°еңЁе“ӘдәӣиЎҢпјҢд»ҘеҸҠе…·дҪ“зҡ„дҪҚзҪ®пјҹ

- 1. з”ЁжҹҗдёҖз§ҚtokenizerеӨ„зҗҶжәҗж–Ү件

- 2. preprocessпјҢжҜ”еҰӮжҠҠжүҖжңүзҡ„еӨ§еҶҷеӯ—жҜҚйғҪеҸҳжҲҗе°ҸеҶҷпјҢзӣёеҗҢзҡ„еҚ•иҜҚйғҪеҗҲ并еҲ°дёҖиө·пјҲжҜ”еҰӮжңүдәӣеҚ•иҜҚжҳҜ takeгҖҒtookгҖҒtakenйғҪжҳҜtakeзҡ„дёҚеҗҢеҪўејҸпјү

- 3. еҸҚеҗ‘зҙўеј•пјҡдёәд»Җд№ҲеҸ«еҸҚеҗ‘зҙўеј•е‘ўпјҢеӣ дёәдёҚжҳҜжҜҸдёҖиЎҢжҳ е°„еҲ°еҮ дёӘеҚ•иҜҚпјҢиҖҢжҳҜжҹҗдёҖдёӘе…ій”®иҜҚжҳ е°„еҲ°е“ӘеҮ иЎҢзҡ„е“ӘеҮ дёӘдҪҚзҪ®гҖӮ

Core Indexing Classes ж ёеҝғзҙўеј•зұ»

- IndexWriterпјҡ IndexWriter жҳҜзҙўеј•еҲӣе»әе’Ңз»ҙжҠӨзҡ„ж ёеҝғзұ»гҖӮе®ғиҙҹиҙЈе°Ҷж–ҮжЎЈж·»еҠ еҲ°зҙўеј•гҖҒжӣҙж–°зҙўеј•гҖҒеҲ йҷӨж–ҮжЎЈд»Ҙ еҸҠдјҳеҢ–зҙўеј•зӯүж“ҚдҪңгҖӮ IndexWriter жҳҜеңЁзҙўеј•е»әз«Ӣе’Ңжӣҙж–°иҝҮзЁӢдёӯзҡ„дё»иҰҒжҺҘеҸЈд№ӢдёҖгҖӮ

- Directoryпјҡ Directory жҳҜзҙўеј•ж–Ү件зҡ„еӯҳеӮЁе’Ңз®ЎзҗҶжҠҪиұЎгҖӮе®ғе®ҡд№үдәҶзҙўеј•ж–Ү件зҡ„дҪҚзҪ®е’Ңи®ҝй—®ж–№ејҸпјҢеҸҜд»ҘжҳҜеҹәдәҺ ж–Ү件系з»ҹзҡ„зӣ®еҪ•пјҢд№ҹеҸҜд»ҘжҳҜеҶ…еӯҳдёӯзҡ„ж•°жҚ®з»“жһ„гҖӮ Directory жҸҗдҫӣдәҶеҜ№зҙўеј•ж–Ү件зҡ„иҜ»еҶҷж“ҚдҪңпјҢдҪҝ еҫ—зҙўеј•еҸҜд»Ҙиў«жҢҒд№…еҢ–еӯҳеӮЁе’ҢжЈҖзҙўгҖӮ

- Analyzerпјҡ Analyzer жҳҜж–Үжң¬еҲҶжһҗзҡ„关键组件гҖӮе®ғе®ҡд№үдәҶеҰӮдҪ•е°Ҷж–Үжң¬ж•°жҚ®еҲҶеүІжҲҗеҚ•иҜҚжҲ–иҜҚз»„пјҢиҝӣиЎҢиҜҚе№І еҢ–гҖҒеҺ»йҷӨеҒңз”ЁиҜҚзӯүж–Үжң¬еӨ„зҗҶж“ҚдҪңгҖӮжӯЈзЎ®йҖүжӢ©е’Ңй…ҚзҪ®йҖӮеҪ“зҡ„еҲҶжһҗеҷЁеҜ№дәҺзҙўеј•зҡ„иҙЁйҮҸе’ҢжҖ§иғҪиҮіе…ійҮҚиҰҒгҖӮ

- Documentпјҡ Document иЎЁзӨәзҙўеј•дёӯзҡ„дёҖдёӘж–ҮжЎЈгҖӮж–ҮжЎЈйҖҡеёёз”ұдёҖз»„еӯ—ж®өпјҲ Field пјүз»„жҲҗпјҢжҜҸдёӘеӯ—ж®өеҢ…еҗ«дәҶж–Ү жЎЈзҡ„дёҖйғЁеҲҶдҝЎжҒҜпјҢеҰӮж ҮйўҳгҖҒжӯЈж–ҮгҖҒдҪңиҖ…зӯүгҖӮ Document з”ЁдәҺе°Ҷж–Үжң¬ж•°жҚ®ж·»еҠ еҲ°зҙўеј•гҖӮ

- Fieldпјҡ Field жҳҜж–ҮжЎЈдёӯзҡ„дёҖдёӘеӯ—ж®өжҲ–еұһжҖ§гҖӮе®ғеҢ…еҗ«дәҶеӯ—ж®өзҡ„еҗҚз§°гҖҒеҖјд»ҘеҸҠз”ЁдәҺжҢҮе®ҡеҰӮдҪ•еӨ„зҗҶиҜҘеӯ—ж®өзҡ„ й…ҚзҪ®йҖүйЎ№гҖӮеӯ—ж®өеҸҜд»ҘжҳҜж–Үжң¬гҖҒж•°еӯ—гҖҒж—ҘжңҹзӯүдёҚеҗҢзұ»еһӢзҡ„ж•°жҚ®пјҢж №жҚ®йңҖиҰҒиҝӣиЎҢзҙўеј•е’ҢжЈҖзҙўгҖӮ

FieldжҜҸдёӘеӯ—ж®өеҜ№еә”дәҺеңЁжҗңзҙўжңҹй—ҙж №жҚ®зҙўеј•жҹҘиҜўжҲ–д»Һзҙўеј•жЈҖзҙўзҡ„дёҖж®өж•°жҚ®гҖӮ

public abstract class BaseIndexTestCase extends TestCase {

protected String[] keywords = {"1","2"};

protected String[] unindexed = {"Netherlands","Italy"};

protected String[] unstored = {

"Amsterdam has lots of bridges",

"Venice has lots of canals"

};

protected String[] text = {"Amsterdam","Venice"};

protected Directory dir; ... }- Keyword пјҡе…ій”®еӯ—дёҚиў«еҲҶжһҗпјҲе°ұжҳҜдёҚдјҡиў«жӢҶејҖпјүпјҢиҖҢжҳҜиў«зҙўеј•е№¶йҖҗеӯ—еӯҳеӮЁеңЁзҙўеј•дёӯгҖӮ

- UnIndexed пјҡж—ўдёҚеҲҶжһҗд№ҹдёҚзҙўеј•пјҢдҪҶе…¶еҖјжҢүеҺҹж ·еӯҳеӮЁеңЁзҙўеј•дёӯгҖӮд№ҹе°ұжҳҜиҜҙдёҖж—ҰеҒҮеҰӮйҖҡиҝҮkeywordжҹҘ иҜўеҲ°дәҶпјҢиҰҒжҠҠunindexзҡ„йғЁеҲҶзҡ„еҶ…е®№иҰҒеёҰеҮәжқҘпјҢдҪҶжҳҜиҝҷйғЁеҲҶдёҚзҙўеј•гҖӮпјҲдҪ дёҚйңҖиҰҒжҠҠиҚ·е…°е’Ңж„ҸеӨ§еҲ©еҒҡ зҙўеј•пјҢжҲ‘еёҢжңӣзҡ„жҳҜжҲ‘жҹҘеҮәжқҘ1е’Ң2пјҢдҪ жҠҠиҚ·е…°е’Ңж„ҸеӨ§еҲ©зҡ„еҶ…е®№еёҰеҮәжқҘпјү

- UnStored пјҡжӯӨеӯ—ж®өзұ»еһӢиў«еҲҶжһҗе’Ңзҙўеј•пјҢиҰҒж”ҫеҲ°зҙўеј•йҮҢеҺ»е»әпјҢдҪҶдёҚеӯҳеӮЁеңЁзҙўеј•дёӯгҖӮеҪ“然жңүдёҖдәӣеҒңз”ЁиҜҚ еҲ—иЎЁпјҢжҜ”еҰӮдёҖдәӣйқһеёёеёёз”Ёзҡ„иҜҚпјҢиҝҷдәӣдёңиҘҝе°ұиў«еҝҪз•ҘгҖӮдёҖиҲ¬жҳҜжӯЈж–ҮпјҢйқһеёёй•ҝдёҚеә”иҜҘеӯҳеңЁзҙўеј•йҮҢйқўпјҢйқһ еёёжөӘиҙ№гҖӮпјҲжҜ”еҰӮиҝҷйҮҢжҲ‘们жҠҠAmsterdam,bridge,Venice,canalжқҘж”ҫе…Ҙзҙўеј•пјҢдҪ жҢүз…§bridgeжҹҘжҳҜеҸҜд»ҘжҹҘ еҲ°иҝҷдёӘж–Ү件зҡ„пјҢдҪҶжҳҜдҪ зҙўеј•йҮҢйқўжІЎжңүеӯҳеӮЁж•ҙдёӘе®Ңж•ҙзҡ„еҶ…е®№пјҢеӣ дёәе®Ңж•ҙзҡ„еҶ…е®№еҸҜиғҪеҫҲеӨ§пјҢжүҖд»ҘжҲ‘们зңҹ зҡ„иҰҒеҸ–иҰҒиҜ»зЎ¬зӣҳпјү

- Text пјҡиў«еҲҶжһҗ并被зҙўеј•пјҢеӯҳеӮЁеҲ°зҙўеј•йҮҢйқўгҖӮиҝҷж„Ҹе‘ізқҖеҸҜд»Ҙй’ҲеҜ№иҝҷз§Қзұ»еһӢзҡ„еӯ—ж®өиҝӣиЎҢжҗңзҙўпјҢдҪҶиҰҒжіЁ ж„Ҹеӯ—ж®өеӨ§е°ҸгҖӮеҸҜд»Ҙзұ»жҜ”keywordпјҢеҢәеҲ«жҳҜиҝҷдёӘtextдјҡиў«еҲҶжһҗдёҖдёӢпјҢиҖҢkeywordдёҚдјҡпјҲд№ҹе°ұжҳҜtextдјҡиў« ж–ӯејҖпјү

еӯ—ж®өзұ»еһӢ

еңЁLuceneдёӯпјҢеӯ—ж®өеҸҜд»Ҙиў«еӯҳеӮЁпјҢеңЁиҝҷз§Қжғ…еҶөдёӢпјҢе®ғ们зҡ„ж–Үжң¬д»ҘйқһеҸҚиҪ¬зҡ„ж–№ејҸжҢүеӯ—йқўж„ҸжҖқеӯҳеӮЁеңЁзҙўеј•дёӯгҖӮеҸҚиҪ¬зҡ„еӯ—ж®өз§°дёәзҙўеј•гҖӮ

дёҖдёӘеӯ—ж®өж—ўеҸҜд»Ҙиў«еӯҳеӮЁпјҢд№ҹеҸҜд»Ҙиў«зҙўеј•гҖӮ

еӯ—ж®өзҡ„ж–Үжң¬еҸҜд»Ҙиў«ж Үи®°дёәиҰҒзҙўеј•зҡ„жңҜиҜӯпјҢжҲ–иҖ…еӯ—ж®өзҡ„ж–Үжң¬д№ҹеҸҜд»ҘзӣҙжҺҘз”ЁдҪңиҰҒзҙўеј•зҡ„иҜҚжұҮгҖӮ

еӨ§еӨҡж•°еӯ—ж®өйғҪжҳҜж Үи®°еҢ–зҡ„пјҢдҪҶжңүж—¶еҜ№жҹҗдәӣж ҮиҜҶз¬Ұеӯ—ж®өиҝӣиЎҢеӯ—йқўзҙўеј•жҳҜжңүз”Ёзҡ„гҖӮ

еӯ—ж®өжҳҜж–ҮжЎЈзҡ„дёҖдёӘйғЁеҲҶпјҢжҜҸдёӘеӯ—ж®өжңүдёүдёӘз»„жҲҗйғЁеҲҶпјҡ

- еҗҚз§°пјҡеӯ—ж®өзҡ„ж ҮиҜҶз¬ҰгҖӮ

- зұ»еһӢпјҡеӯ—ж®өзҡ„ж•°жҚ®зұ»еһӢгҖӮ

- еҖјпјҡеӯ—ж®өзҡ„е®һйҷ…ж•°жҚ®пјҢеҸҜд»ҘжҳҜж–Үжң¬пјҲеҰӮ

StringгҖҒReaderжҲ–йў„еҲҶжһҗзҡ„TokenStreamпјүгҖҒдәҢиҝӣеҲ¶ж•°жҚ®пјҲеҰӮbyte[]пјүжҲ–ж•°еӯ—пјҲеҰӮNumberпјүгҖӮ

ж®өпјҲSegmentsпјү

Lucene зҙўеј•еҸҜд»Ҙз”ұеӨҡдёӘеӯҗзҙўеј•пјҲжҲ–з§°дёәж®өпјүз»„жҲҗгҖӮжҜҸдёӘж®өйғҪжҳҜдёҖдёӘе®Ңе…ЁзӢ¬з«Ӣзҡ„зҙўеј•пјҢеҸҜд»ҘеҚ•зӢ¬иҝӣиЎҢжҗңзҙўгҖӮзҙўеј•зҡ„жј”еҸҳж–№ејҸеҢ…жӢ¬пјҡ

- дёәж–°ж·»еҠ зҡ„ж–ҮжЎЈеҲӣе»әж–°зҡ„ж®өгҖӮ

- еҗҲ并зҺ°жңүзҡ„ж®өгҖӮ

- жҗңзҙўж“ҚдҪңеҸҜиғҪж¶үеҸҠеӨҡдёӘж®өе’Ң/жҲ–еӨҡдёӘзҙўеј•пјҢжҜҸдёӘзҙўеј•еҸҜиғҪз”ұдёҖз»„ж®өз»„жҲҗгҖӮ

ж–ҮжЎЈзј–еҸ·

еңЁеҶ…йғЁпјҢLucene дҪҝз”Ёж•ҙж•°ж–ҮжЎЈзј–еҸ·жқҘеј•з”Ёж–ҮжЎЈгҖӮ第дёҖдёӘж·»еҠ еҲ°зҙўеј•зҡ„ж–ҮжЎЈзј–еҸ·дёәйӣ¶пјҢйҡҸеҗҺзҡ„жҜҸдёӘж–ҮжЎЈзј–еҸ·дҫқж¬ЎеўһеҠ дёҖгҖӮ

еңЁLuceneдёӯеҜ»жүҫе’Ңжү“еҲҶ

Lucene жҸҗдҫӣдәҶеӨҡз§ҚдёҚеҗҢзҡ„ Query е®һзҺ°пјҢе…Ғи®ёжү§иЎҢеҗ„з§Қзұ»еһӢзҡ„жҹҘиҜўгҖӮ

жү§иЎҢжҗңзҙў

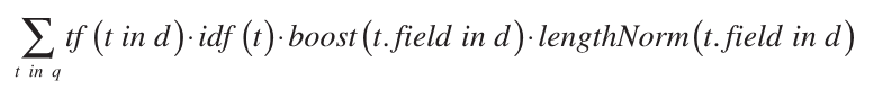

еә”з”ЁзЁӢеәҸйҖҡеёёдјҡи°ғз”Ё IndexSearcher.search(Query, int) жқҘжү§иЎҢжҗңзҙўж“ҚдҪңгҖӮдёҖж—Ұ Query еҲӣе»ә并жҸҗдәӨз»ҷ IndexSearcherпјҢLucene ејҖе§ӢиҝӣиЎҢиҜ„еҲҶиҝҮзЁӢгҖӮеңЁдёҖдәӣеҹәзЎҖи®ҫж–Ҫзҡ„и®ҫзҪ®е®ҢжҲҗеҗҺпјҢжҺ§еҲ¶жқғжңҖз»ҲдәӨз»ҷ Weight е®һзҺ°зұ»еҸҠе…¶ Scorer жҲ– BulkScorer е®һдҫӢгҖӮ

жҹҘиҜўзұ»

TermQuery

TermQuery жҳҜжңҖе®№жҳ“зҗҶи§Јдё”еә”з”ЁжңҖе№ҝжіӣзҡ„жҹҘиҜўзұ»гҖӮе®ғеҢ№й…ҚжүҖжңүеҢ…еҗ«жҢҮе®ҡжңҜиҜӯпјҲTermпјүзҡ„ж–ҮжЎЈпјҢTerm жҳҜеҮәзҺ°еңЁжҹҗдёӘзү№е®ҡеӯ—ж®өпјҲFieldпјүдёӯзҡ„дёҖдёӘеҚ•иҜҚгҖӮ

дҫӢеҰӮпјҢжһ„йҖ дёҖдёӘ TermQuery еҰӮдёӢпјҡ

TermQuery tq = new TermQuery(new Term("fieldName", "term"));жӯӨжҹҘиҜўдјҡиҜҶеҲ«жүҖжңү Field дёә "fieldName" 并еҢ…еҗ«жңҜиҜӯ "term" зҡ„ж–ҮжЎЈгҖӮ

BooleanQuery